背景介绍

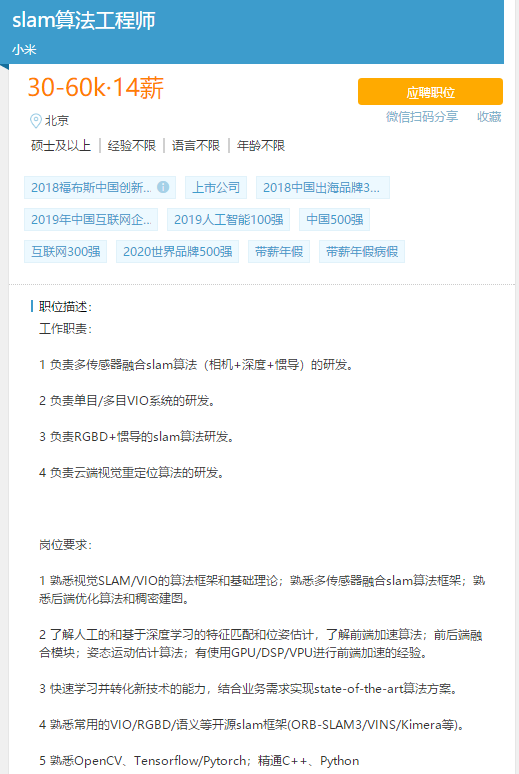

自动驾驶和服务机器人行业增速明显,自2021年以来,多家公司开始逐步落地自己的L2~L4级别的辅助/自动驾驶产品(无人出租车或者配送机器人),如百度、滴滴、美团、华为、特斯拉、Waymo等。其中,基于视觉传感器和惯性传感器的同时定位与建图技术(SLAM)是该领域的核心技术之一,各大公司均有相关在招岗位。由于视觉-惯性SLAM对从业者的理论和代码要求都很高,导致行业人才供小于求,许多公司更是不惜重金招聘一个合格的SLAM算法工程师,并且薪资待遇极其丰厚。以下是某照片网站对SLAM相关职位的要求和待遇:

视觉SLAM由于成本低,单目/双目结合多传感器的方案越来越受青睐,而视觉惯性里程计更是多传感融合方案的佼佼者;其中,最著名的方案当属VINS-Fusion(VINS-Mono的扩展版)。VINS-Fusion是香港科技大学于2019年开源的视觉-惯性SLAM系统,KITTI Visual Odometry 榜单中排名最靠前的开源双目 VO 方案,主要支持:单目+IMU、纯双目、双目+IMU、双目+IMU+GPS,是一个可以用于室外场景中无人车辆/机器人自主定位的优秀方案,以下是官方测试效果展示:

视觉SLAM由于成本低,单目/双目结合多传感器的方案越来越受青睐,而视觉惯性里程计更是多传感融合方案的佼佼者;其中,最著名的方案当属VINS-Fusion(VINS-Mono的扩展版)。VINS-Fusion是香港科技大学于2019年开源的视觉-惯性SLAM系统,KITTI Visual Odometry 榜单中排名最靠前的开源双目 VO 方案,主要支持:单目+IMU、纯双目、双目+IMU、双目+IMU+GPS,是一个可以用于室外场景中无人车辆/机器人自主定位的优秀方案,以下是官方测试效果展示:

几种方案效果对比

KITTI测试场景

如何学习

?

视觉-惯性SLAM所涉及的理论深度较深、覆盖面广,并对工程实践能力要求也较高,新手自学时相对比较困难。当下虽然有很多丰富的理论资料和优秀的相关开源项目,但是许多童鞋面对海量的理论资料、复杂的开源项目时可能无从下手,前期学习曲线过于陡峭,不得不放弃继续深入。为此,3D视觉工坊推出了《视觉-惯性SLAM的入门与实践》课程,结合VINS-Fusion源码,系统地对视觉-惯性SLAM的基础理论知识进行梳理。整套课程由一线算法工程师教授,从基础理论到代码剖析,保姆级教学,助力学员一步步从小白成长为大牛。

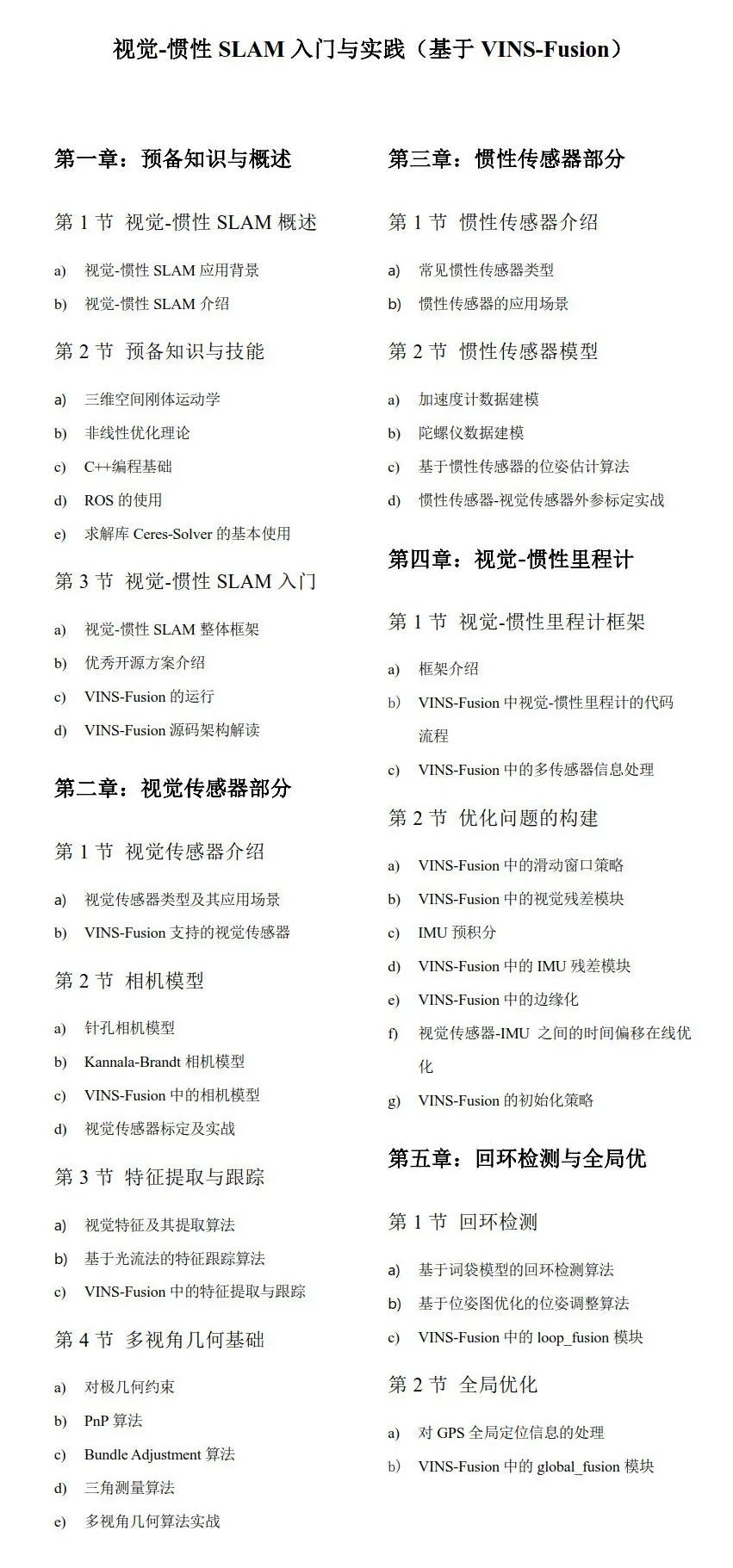

课程大纲

讲师介绍

毕业于西北工业大学,国内某机器人创业公司技术总监,具有多年SLAM和机器人领域产品、实战经验, 曾获国内外多个机器人大赛一等奖和冠军。

面向对象

1. 具备线性代数、概率论和优化理论等基础数学知识;

2. 掌握C++编程语言,熟悉ROS机器人操作系统的使用;

3. SLAM相关研究方向的在校生,需要进阶的一线算法和工程人员,以及非常想要转入SLAM领域的从业者;

学后收获

1. 扎实掌握视觉-惯性SLAM的基础理论;

2. 掌握著名开源方案VINS-Fusion,并具备独立阅读其他开源SLAM代码的能力;

3. 具备独立开发视觉-惯性SLAM系统的编程与实践能力;

4. 对标企业级要求,能够胜任相关岗位;

课程优势

1. 国内首个面向VINS-Fusion框架的课程;

2. 授课讲师在学术界和工业界具有丰富的理论研究和工程落地经验;

3.算法理论和实践相结合,保姆级教学,讲师数年经验倾情奉献,数据、代码开源帮助学员更好地理解每一个细节,能够真正将所学应用到实际项目中;

4. 教授结束后布置练习项目,答疑群内,讲师面对面和学员一起交流遇到的难题;

5.优质的学习圈子,可以和国内外高校学子一起讨论学习,你踩过的坑他们大概率踩过;

开课时间

2021年8月29日正式开课,历时三个月,每两周更新一次,具体时间以学习群内公告为主。

课程咨询

点击购买与咨询

▲微信扫码可查看、购买、学习课程

▲长按加客服微信,咨询更多

群号:910070197

▲课程咨询QQ群,了解更多

点击“阅读原文”也可直接购买课程

254

254

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?