来源丨新机器视觉

点击进入—>3D视觉工坊学习交流群

先介绍几个概念:

1、焦点(focus)

与光轴平行的光线射入凸透镜时,理想的镜头应该是所有的光线聚集在一点后,再以锥状的扩散开来,这个聚集所有光线的一点,就叫做焦点。

|

2、弥散圆(circle of confusion)

在焦点前后,光线开始聚集和扩散,点的影象变成模糊的,形成一个扩大的圆,这个圆就叫做弥散圆。

在现实当中,观赏拍摄的影象是以某种方式(比如投影、放大成照片等等)来观察的,人的肉眼所感受到的影象与放大倍率、投影距离及观看距离有很大的关系,如果弥散圆的直径小于人眼的鉴别能力,在一定范围内实际影象产生的模糊是不能辨认的。这个不能辨认的弥散圆就称为容许弥散圆(permissible circle of confusion)。

|

不同的厂家、不同的胶片面积都有不同的容许弥散圆直径的数值定义。一般常用的是:

画幅 | 24mm x 36mm | 6cm x 9cm | 4" x 5" |

弥散圆直径 | 0.035mm | 0.0817mm | 0.146mm |

35mm照相镜头的容许弥散圆,大约是底片对角线长度的1/1000~1/1500左右。前提是画面放大为5x7英寸的照片,观察距离为25~30cm。

3、景深(depth of field)

在焦点前后各有一个容许弥散圆,这两个弥散圆之间的距离就叫景深,即:在被摄主体(对焦点)前后,其影像仍然有一段清晰范围的,就是景深。换言之,被摄体的前后纵深,呈现在底片面的影象模糊度,都在容许弥散圆的限定范围内。

|

景深随镜头的焦距、光圈值、拍摄距离而变化。对于固定焦距和拍摄距离,使用光圈越小,景深越大。

示意图1 |

示意图2 |

以持照相机拍摄者为基准,从焦点到近处容许弥散圆的的距离叫前景深,从焦点到远方容许弥散圆的距离叫后景深。

4、景深的计算

下面是景深的计算公式。其中:

δ | ―― | 容许弥散圆直径 |

f | ―― | 镜头焦距 |

F | ―― | 镜头的拍摄光圈值 |

L | ―― | 对焦距离 |

ΔL1 | ―― | 前景深 |

ΔL2 | ―― | 后景深 |

ΔL | ―― | 景深 |

| |||||||||

| |||||||||

|

从公式(1)和(2)可以看出,后景深 > 前景深。

由景深计算公式可以看出,景深与镜头使用光圈、镜头焦距、拍摄距离以及对像质的要求(表现为对容许弥散圆的大小)有关。这些主要因素对景深的影响如下(假定其他的条件都不改变):

(1)、镜头光圈:

光圈越大,景深越小;光圈越小,景深越大;

(2)、镜头焦距

镜头焦距越长,景深越小;焦距越短,景深越大;

(3)、拍摄距离

距离越远,景深越大;距离越近,景深越小。

5、一些计算实例

网上有些在线计算器,有兴趣的网友可以参考:

摄影光学计算器

Windows版本的可下载的计数器在

f/Calc

(1)、200/2.8对焦在5m时,f/2.8的景深:

δ | = | 0.035mm |

f | = | 200mm |

F | = | 2.8 |

L | = | 5000mm |

ΔL1 | = | 60mm |

ΔL2 | = | 62mm |

ΔL | = | 122mm |

结论 | : | 该镜头在用f/2.8拍摄时,清晰范围是从4.94m~5.062m,景深很浅。 |

(2)、200/2.8+2X=400/5.6对焦在5m时,f/5.6的景深:

δ | = | 0.035mm |

f | = | 400mm |

F | = | 5.6 |

L | = | 5000mm |

ΔL1 | = | 30mm |

ΔL2 | = | 31mm |

ΔL | = | 61mm |

结论 | : | 该镜头在配合2X增距镜后,主镜头用f/2.8拍摄时,景深是(1)的一半。 |

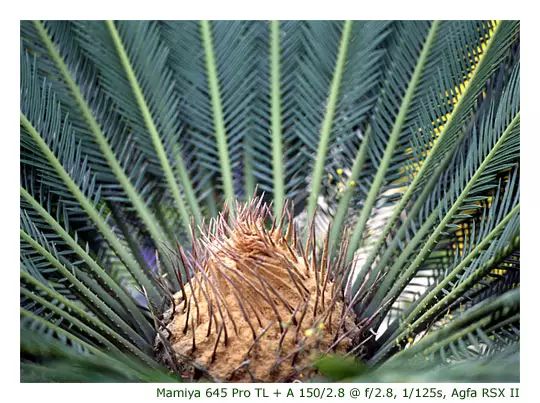

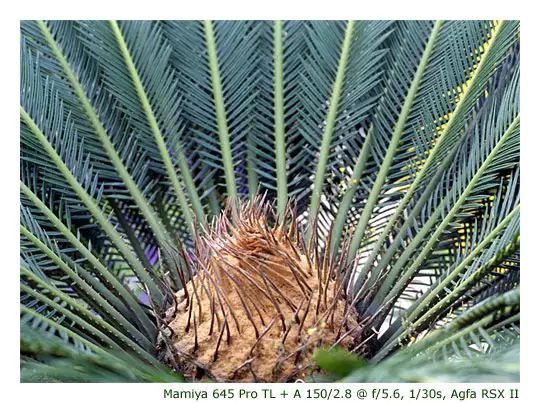

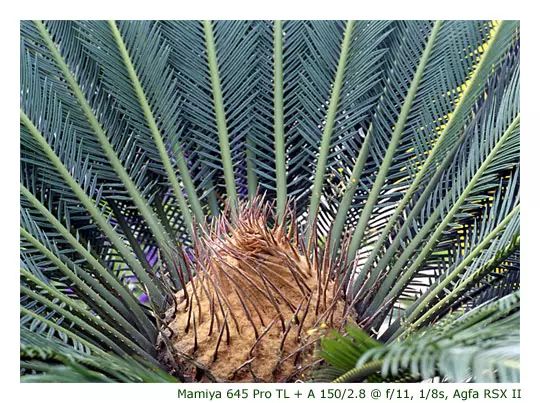

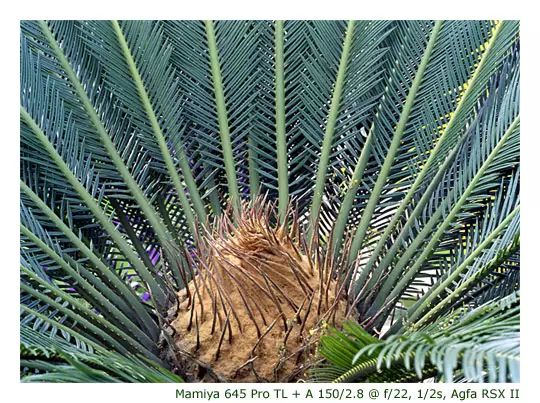

景深的实际拍摄照片

|

|

|

|

来源:光学人生

本文仅做学术分享,如有侵权,请联系删文。

点击进入—>3D视觉工坊学习交流群

干货下载与学习

后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件

后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf

后台回复:3D视觉课程,即可学习3D视觉领域精品课程

3D视觉工坊精品课程官网:3dcver.com

1.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

2.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

3.国内首个面向工业级实战的点云处理课程

4.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

5.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

6.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

7.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

16.透彻理解视觉ORB-SLAM3:理论基础+代码解析+算法改进

重磅!粉丝学习交流群已成立

交流群主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、ORB-SLAM系列源码交流、深度估计、TOF、求职交流等方向。

扫描以下二维码,添加小助理微信(dddvisiona),一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,微信号:dddvisiona

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、源码分享、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答等进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,6000+星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看,3天内无条件退款

高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

2549

2549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?