作者丨紫川科技@知乎

来源丨https://zhuanlan.zhihu.com/p/653556292

编辑丨 计算机视觉life

紫川科技

VIOBOT-PRO开发平台近期有相当不错的出货量,一直忙测试也没好好做更新,感谢所有的用户和伙伴,认真写一下这一篇。我写东西总体是很枯燥,容易沉浸在自己的世界里,正在尝试作出改变。

为了避免阅读障碍,先做一些简单的解释:

三相性:开销/鲁棒/精度

世界观:三维建图,可实时可离线

向量机:非抽象的有限向量机,是更具像的硬件表述,泛指GPU/DSP或以其他形式构建的针对向量和实时运算的硬件核心或装置。

NPU:神经网络单元,在SOC侧用于构建AI相关功能,亦可用于SLAM中部分功能模块的分解。

VIO/IVO:IVO也是自己瞎编的,主要区别一下以视觉和以imu为主导的系统的区别,而事实确实是有区别存在。

RTOS:裸机环境,使系统的运行具备更优的实时性,开发较为困难

Part1市场部分

目前VIO/SLAM主要市场,高度集中在自动驾驶/XR领域/机器人。

自动驾驶。。。好Q难

玩出梦想炫酷又高速的YVR

目前一堆VIOBOT在努力的场景。。。

前两个垂类市场最大的特点就是:难

其中XR领域要求极强实时性的同时(如针对Body系50fps以上的响应),还需要主SOC进行大量的应用类计算,留给VIO的算力相当有限,同时XR设备涉及的传感部分很多,标定也较复杂。XR领域大部分定位依赖VIO,好的地方就是不涉及太多回环和地图管理,

自动驾驶。。。这个有多难其实大家也有数了。严肃行业,海量的标定数据和目标识别,HD地图,大量的语义分割,BEV,6个以上的CAM/Lidar和多源融合带来了最难的标定,要么对激光雷达极度依赖,要么对算力无尽饥渴。尤其是L4,难上加难。

机器人是其中最有趣的领域,但也有如下的困难和问题:

(1)大空间固定范围作业AGV类(如机场,港口)

这个是刚需,本质和自动驾驶很像,简单的部分是目标对象和行驶区域不再那么复杂,困难的部分是行进路线非常固定和严格,对精度和地图管理的要求极高。这一类业务雷达和高精度先验地图是必备项。

不能超出地上左右两边的线哦。。。麻烦的场景,mmp

(2)小空间固定范围作业机器人(如仓储物流机器人,商业清洁,割草机,巡检机器人等)

这些业务各有特性,仓储物流机器人感知和规划更加接近第一类,控制会更加复杂一些。

海柔冲啊,小心隔壁海康~~

商业清洁机器人最大的难点是要达到或接近人清洁的效果和效率(较难),同时客户需求容易发散。

高仙这个小车车挺靓仔~~

总体还是更加看好割草机器人,虽然现在在低谷,但是场景上具备一系列的优点,只要不过度发散,更容易主动引导用户需求,参与行业标准。

其实好想放张国产。。。还是算了,以免引战

总体来讲,业务2是有很大机会在多个场景中以VIO作为主传感单元即可闭环的,就像我们人类一样,不是吗?

(3)UAV

这块虽然有龙头DJI,但我觉得还是前途无量的,顶上视图赋予人类更加广阔的想象空间,赋予我们更多的作业可能!

但是VIOBOT/PRO在设计和与用户伙伴交流时,我们会更加倾向于能用眼睛与前端算力能在近距离/室内闭环的事项,如果涉及空中二次作业,如检修,喷射甚至直接运送货物类的事项,建议先看看自己账上是不是有花不完的资金。。。同时也不需要局限于2B还是2C,空中大把世界。

TANGO and UAV, so cool!

(4)小机器人

这是我们组长期最看好的业务,类似Astro/Loona/Ring等业务都是充满想象力的落地。未来类似WALLE类的机器人会在生产生活中扮演各种各样的角色。

沙雕Astro。。。看着2比兮兮的

好可爱的Loona

其实有大湾区版本,原版也很拉跨,都吐槽无力,快来颠覆他们!

WALLE,我的最爱,EVA真丑

需要认真思考的,到底它是宠物Pet,玩具Toy,还是工具Tool, 还是机器人Robot。它们之间的属性又如何进行变化与融合呢?它们并不需要cm mm级精度,它们更需要的是自身基础位姿的确认,以及对周边世界的基础认知。

近期很多从事这个方向的小伙伴都想用极低的成本或者直接在本端SOC闭环SLAM,不是说不可能哈。只是如果随便套个ORB-SLAM3或者原厂方案就能轻松闭环的话,未必有点太轻视了技术难度。。。现在阶段并没有到,当然会到的,这就需要大家(科学家/工程师,行业上中下游)共同努力了。通用泛化对行业和业者来说,从来都不是坏事情,只是我国莫名的内卷环境给大家赋予的焦虑情绪过多。另外不需要世界观和观察方向的话随便上个扫地机方案会更符合要求,既又且还是难以实现的。

“无知并不是生存的障碍,傲慢才是”

另外还有一个更重要的原因,就是如果在一开始就锁死和界定了成本,其实相当于锁死了开销,也相当于锁死了发展的可能性。VIOBOT-PRO虽然已经有了完整的VIO-SLAM,但设计上还是给了大量的冗余异构算力空间,作为开发平台才有深化开发的可能性与价值。双核A55和4核A7其实同样可以闭环VIO,但只能一定程度地保障三相性。

从另外一面看,如果一众科学家与科研人员一直把VIO/SLAM往更加阳春白雪的方向去使劲卷,也会成为行业的发展障碍(纯VIO难以完全达到雷达的绝对精度,完全不计开销的堆是错误方向)。百花齐放百家争鸣,VIO/SLAM以及其对应的行业发展,才会是更加有意义和炫酷的事情。

也许未来也会出现新的华为/海康/大疆类别的企业,但这应该是10年后的后话了。现在科学与工程之间的GAP太大,我们应该努力在市场和科技成果转化中不断去弥合和拉通它,一步一步地打开新世界。也不要老觉得自己能形成新的垄断,世界这么大,你算个DER儿?这也是说给我们这个小中游小组自己听的。

另外关于近期非常流行的具身智能(人型/情感陪护类宠物)和人型机器人,我想说的是大模型和未来更加轻量的Edge Transformer确实会和将会给行业带来巨大的变化,但科研与工程从来都是两码事,跨阶段进行是不是真的可以弯道超车表示存疑,但确实过去我们大力出奇迹的事情做成的不少,希望大家顺利。

Part2工程部分

行文主要基于逻辑与事实,以及我们进行过的实验与交流,这篇的目的主要是为了将问题展开探讨,并不代表我们组已经全部闭环了相关问题,实质上其中部分问题是极难解决的。

主要困难围绕着三相性和世界观,这4个东西来回反复叭叭很多遍就不赘述了,今天主要讲具体的:

泛化困难

(1)VIO中特征点法/直接法的基础问题

特征点法的第一个问题就是稀疏,稀疏无法带来有效世界观,如果需要带来有效世界观只能上手段(如Mesh,但本身基于特征点的Mesh就存在着难以弥合的问题,除非上更强的语义类手段- 知识点来源:贺一家博士 徐浩博士)。

总拿ORB做反例是不是有点不妥。。。

特征点法的第二个问题是低纹理区的弱响应,导致对imu的高度依赖。

可怜的ORB2

特征点法的第三个问题是提点和匹配本身的高开销,但这个部分已经可以比较轻松地通过向量机/NPU异构来完成了。

直接法的第一个问题是假设1(光度不变假设)带来的光度问题,光度几乎是无法被有效管理的,虽然已经有对应的主动曝光手段。

直接法的第二个问题是假设2(数量压倒质量)带来的Outlier,同样是难以被有效处理的,是算法基础的留影。

直接法的第三个问题是imu在其中难以扮演太合适的角色,虽然已经有了DM-VIO这个标准例。

完美的相机才有完美滴直接法展现,Outlier最小化却不能泛化

(2)AI在SLAM中的问题

首先是NERF/Mobile NERF:主要问题是重,但必然是未来主体方向,在更长一段时间里会广泛地被科学家们关注,在大规模三维重建中会成为占主导作用的部分,但真正落到机器人/XR类SLAM中还有较长的一段路。

炫酷图源:好友 沉默的坤哥

然后是superpoint/unsuperpoint, superglue/lightglue。单纯从提点/描述子(分值)来说前者已经相当优秀,同时也可以在较小占用的情况下使用NPU异构闭环,后者又给予了更加强力的匹配手段。在SLAM中能起到相当重要的作用

无比炫酷的Lightglue

但同样存在问题:Quote by阿达:“前端的提点,不管是几何法还是网络法。都是不够准的 而且 误差的引入甚至不只是在提点与匹配。图像光度是很复杂的 准确提点完全不可能”即Outlier仍将长期存在,本质还只是一个超强的ORB,能起到的主要作用是异构(ORB提点也能轻松异构)。真正能起更好作用的是回环。同时还需要独特的训练和模型,这也是泛化障碍。

另外本身提点和匹配也只是完成了工作的一小部分,还存在着IMU如何耦合的问题,后端优化的问题。其依然高度依赖CPU本身的算力,问题并没有被有效解决。

在这个章节的尾段,专门讲一下向量机与NPU的差别,这也是未来SOC向后发展的主要分叉,目前仅Nvidia和AMD可以同时满足,NV生态更佳。

向量机:使用GPU/DSP或专门针对Vectors处理的FPGA,乃至ASIC(参考前文Navion),甚至特异化过的CPU来进行SLAM中向量的运算与加速,属于传统方法的衍申。难度很高,会大量涉及RTOS和C语言,GPU略好一些,CUDA生态就相当友善了。

NPU:通过神经网络完成SLAM,存在的问题上面已经提过了

未来VIO-SLAM主要流派和承载的硬件之间的竞争,就会发生在二者之间。但是。。。

老东家是我的精神港湾

任何一块芯片的面积都是有限的,向量机与NPU难以两全,首先中低端SOC(3-20美金)的工艺12-28nm不等,当承载了NPU(一般这个价位段2-4T)时,就只能收缩主核CPU和其他向量机如DSP/GPU,当主核强力时只能收缩NPU面积。有部分供应商直接阉割L2/L3缓存来闭环成本与面积。

目前我国主SOC如果具备强劲的NPU,如20-90T,则其主核和向量机一定是非常糟糕的,并有可能阉割缓存。

于是SLAM在端侧NPU主线上产生了2个悖论:

1.想在中低端SOC侧的NPU侧闭环SLAM的大部分工作,则剩余的NPU算力不足以闭环其他AI应用,同时后端将挤占有限的CPU资源。

2.想在高端强NPU主核上闭环SLAM,会出现主核算力不足,以导致高度的原厂依赖(部分强大原厂绝大部分工作在端侧NPU闭环,如特斯拉,国内也有)。中小微企业没有长期发育空间。

同时国内大部分供应商NPU用的是公版,功耗和性能很糟糕,只有少部分厂家闭环了自主NPU。

最后说结论:“这条主线,较长一段时间内工程不足以闭环VIO-SLAM”

盗图~~啦啦

(3)尺度问题

三相性和世界观,是建立在有效的尺度/重力与光的控制基础上,而这三者也是VIO在通用泛化中最大的障碍。

关于尺度,首先单目VIO是难以管理好尺度的,存在4自由度不可观问题(这个不解释了,大量说明,我们的知乎也有写过)。

双目VIO的尺度会在户外等更大尺度的场景发生剧烈的退化,在不同的场景中。比如VIOBOT-PRO双目基线大概能管理的尺度半径在16米,如果16米内特征稀薄,机器人又在长直线运动时,尺度会发生退化的可能。对应的解决手段是回到单目深度滤波+imu,这样纯VIO能在无第三方传感器辅助和回环的情况下,在大量的室内外普通场景顺畅准确的运行:

我拍照水平真shi,办公室这么大拍着和个作坊一样

我们办公室大概就是这个结构,羡慕吧,能看出多么巨大吗?

我们办公室旁边风景就是好!

里程端点间428米,实际621米

6次不同天候情况下的运行,均完全符合机器人实际运行轨迹,RPE/ATE均<0.3%

但是要注意,无论多大的基线(40mm-300mm)都有发生尺度退化的可能,接下来上个示例图:

凤凰大桥。。。救命啊啊啊

这是一个长达10公里的跨海大桥,ODOM在这长直线工作的时候,实际在一个非常大的尺度上,双目和单目VIO都将发生不可逆的尺度退化,形成误差。在这种极端情况下,GNSS和RTK是必要项,当然通常在这类场景上会有雷达。

(4)重力问题

重力问题发展到最后,就会收敛成Z-drift (Z轴漂移)问题。

其实这个问题我真的不想多扯,但是它客观存在。。。即使我们收敛得还不错。

尤其是在AGV长直线上,比如楼下这张不能忍的图。。。

这个点云真tnnd难看

这张是和楼上端点间实际距离428米(里程621米)的户外运行对应的,可以看到353²+243²+8.7²=183733,开根是完美的428.64米,无论是轨迹(体现旋转)还是x/y平面的误差都收敛到了极致(ATE/RPE均<0.3%, 达到激光水准)。但是Z却是一个该死的8.7米!!!虽然两个端点实际的海拔差有约5米,仍然产生了难以忍受的约4米(RPE0.7%)的Z-Drift。

成因其实很简单:一共有3个部分,在大尺度长直线运行时:

图像的Y轴激励有限导致 + 远处天空中的云 +光度变化

第二个问题很化学也很好规避,第三个问题马上会详细讲。

第一个问题其实就是VIO的死穴问题:在大尺度长距离直线运动上,视觉的输入在Y轴的激励_>部分对应到三维世界Z轴,本身就是非常有限的!严格来说一个类能观性问题,但是它客观存在着且一定会对你们的系统造成影响。

怎么解决?加GNSS或RTK控Z啊!要么把三维压成二维,忽略Z。

我二维了,Z-Drift你咬我啊

开玩笑的哈,我们也在做一系列的努力。。。希望大家有更好的方法。

其实只要不追求完美和超高精度,这个问题对AGV的运行影响很小了。一上充分激励的UAV这个问题就可以忽略了,当然飞高了又会有新的共面问题。

(5)光度问题

先看我2023SLAM论坛帅照~yeah,这个是当时给偶像Cremers教授提问的时候拍的:

怎么忘了剃胡子。。。shit

把结论告诉大家:

首先Cremers老师回答的就是全局快门,不是就别深入折腾直接法了。。。这个和我认知一致。

能部分解决光度影响的就是主动曝光算法,进一步的话就是熵或梯度的曝光控制(面对太暗或过曝),或融入运动要素(林一成博士),或从粗到细的策略,实时调整相机曝光时间,并引入新的光度补偿算法(王煜博士)

这个问题专门请教了华科林一成博士和哈工深王煜博士,感谢两位的指点,以后还少不了麻烦二位~~

我最后一个问题是光度剧变应该如何处理,得到的回复是只能传感器切换或者凉拌了。。。这个回答解开了我心中困惑已久的纠结。凉拌不如不办~哈哈,还是主动消灭权重跳去IMU吧,反正一定会不准的。

我说一下什么叫光度剧变:一个隧道的出入,相机关键指标流明数lux,可以发生从30到12000这种跳3个级数乘4倍的恐怖变化!还有同学们不要再问我为啥不用HDR了。。。实在不想解释,我很快就要去和某核心传感器原厂聊单拐HDR的细节了。。。

(6)VIO/IVO问题与可怕的IMU

简单说说我心中VIO/IVO的区别,两者都是CAM和IMU的耦合,以视觉为主的喊VIO,以IMU为主的喊IVO

VIO: ORB-SLAM3 DMVIO

IVO: VINS-MONO

还有不知道该怎么定义的BASALT。。。

原因我也不想太详细的解释,有兴趣的同学可以去看其各自图优化的方式。

总体来说VIO更加依赖视觉的准确度,尤其DM-VIO这种延迟边缘化的更加明显。而IVO更加依赖IMU自身。

就像VINS-MONO,主要位姿输入是p,q,v,Ba,Bg,视觉重投影误差紧耦(VINS前端很一般才体现了后端算法的优秀,还有个关键点是基于四元数的预积分),天生是为了无人机而诞生,其在手持和无人机上表现非常地优异,但是并不适合地面AGV,原因很多,随便举一个:

假设IMU量程12g,遭遇到激烈撞击>30g,IMU在反作用力方向释放了冲击,但作用力方向的作用力远超量程,一个imu加速度巨量进入系统,动力积分不平衡问题发生,无论如何进行滤波,VIO系统将进入崩溃。

这类情况在轮式AGV和地面机器人上比比皆是。

VIO/IVO都不容易,但是做VIO系统,要求的是视觉更加专业(比如我们组),而IVO系统,要求的是更加专精于imu与导航本身。另外还有个点是VIO建图更方便些,即使是ORB,如果不计算力疯狂堆点,那么算出来的东西也算有那么一点意思。

为什么说IMU可怕呢?不就Alan方差?椭球标定,再对个外参吗?

哪有那么简单啊。。。具体就不细致展开了,有些事,高德导航能做,DJI能做,你有没有真正的能力做,你自己得好好评估。

说一个结论(知识和亲测来源:好基友吴荩博士):“很低BOM的IMU,通过优化能到数千元IMU的效果”但我觉得如果这里如果忽略了他的工程和知识水平来评估成本是不对的~哈哈。另外目前有些专门做导航的企业也能做到,但是实际工程量还是比较大,泛化并不容易。

阿荩好犀利,mmp,不带我还让我带他,我呸

一些比较弱智的干货知识点(首先声明我们imu水平比较菜):

*IMU的角速度更加可以信任,加速度bias/noise更加难以控制,信任度低,对应的速度亦不可信

*各种imu前进向上角速度会有随机向上的Pitch小量输出,静止时不太会

*当系统误差出现时,严格区分旋转与平移

然后重点说明下VIO和IVO的区别,各种影响的因素:快门,多目,V标定I标定与联合标定,温度,曝光

(7)同步与标定问题

严格点说标定和同步应该算VIO SLAM中最麻烦的工程问题。

首先讲同步吧,以前就叭叭过很多次硬件同步,如果不能硬件同步,建议就不要搞了,这个在工程上是比较容易实现的。

相机内参标定:这是一件很严肃的事情,涉及的部分很精细,比如畸变,光轴,光度等,不展开了。没有足够好的标定能力就做不好VIO-SLAM,但是也不用太卷,到3个以内的像素级就可以了。

相机双目外参标定:也是一件很严肃的事情,反正要标准(感觉纯废话)。。。

最后是相机与IMU的联合标定。一台VIOBOT-PRO需要经过7个严格的标定步骤,相机内部也有其标定修复的程序。后续进一步优化和简化标定,也是核心工作之一。

大家平时看到的那些很炫酷的带5-6个摄像头和IMU的无人机(比如Skydio),其标定过程要更加复杂。

SKYDIO飞机真叼,再叼消费者业务还是打不过DJI吧,哈哈

(8)双目点云与世界观问题

双目原生深度图是非常糟糕的!通过简单的视差匹配, 不但需要大量的重复运算,运算效果还奇差无比,吃掉一大堆开销送你个垃圾,拿垃圾做出来的点云还是会很垃圾。但是如果结合NPU的话就会有很不错的效果,就还是有点重,如下图:

来自鉴智科技结合NN的优质双目点云

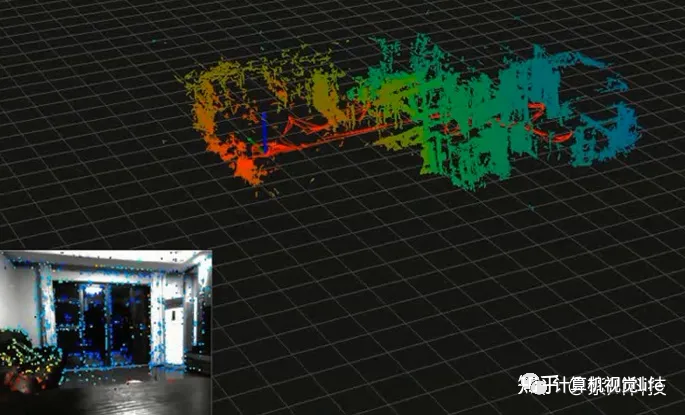

还有一种是i-TOF点云,可以同步完成三维建图,VIOBOT-iTof版本提供如下:

来自VIOBOT的优质i-TOF点云

但这个东西也有2个毛病,一个是手短(只有5米),第二个是对黑色的东西没办法响应(i-TOF天生的缺点)

VIOBOT-PRO的RDF(Realtime Dense Filter)点云是工程攻关的过程中发现的一个非常优质的副产品,有了它VIOBOT才算是真正有了完整的世界观,它虽然不是那么好看,但是极其的实用。可以跟着系统高速的关键帧输出来输出,实时完成避障的同时构建机器人基本工作的世界观。不考虑美观问题的话非常接近线扫雷达的工作能力。

原生点云(可以看出有大量的Outlier,且稀疏):

好多Outlier啊啊啊啊啊啊啊

RDF点云(相对原生点云更加地干净,稠密,虽然难看):

丑丑丑!除了丑没别的毛病

看着真tmd丑,还好够干净稠密

这种点云就可以非常轻松地用于地面与空中的三维避障了,同时它也可以构建真正的机器人世界观:

你缩小这个图会觉得是激光建的哦

其实一些更小的工作区可以离线或通过其他工具做更加致密的三维重建,这些就是后话了。

机器人运行中实时稠密和准确的点云,重要性仅次于位姿可信度。不然我们要激光雷达干嘛?

(9)温度与冲击

其他问题高度集中在2件事:工作温度与冲撞击

我们的标定会锚定在开机3-5分钟后,系统热机进入稳定的工作温度如表面温度32-35℃,传感器面板温度40℃,这样的话无论旋转还是平移,都是在其最佳工作状态。但是(以下图像由紫川热成像仪完成,精度±2℃):

我们家热像仪就是吊

右边第三台机器因为是测试机,上面特意安装了一个接近55℃的电源不断向其传导热量,使其表面温度达到40℃,传感板温度接近50℃,此时和正常标定温度相差近10℃,就造成了如下的问题:

下面这台变挫了。。。

下面这台对应50℃运行的VIOBOT-PRO,大家会发现,误差扩散了。测试路径33米,约12个旋转

回归原点后,上面2台设备的误差仍保持在了0.3%和更低的水平,而第3台设备误差上升至近1.6%。

这就是温度带来的负面效应,其将同时影响IMU MEMS与相机本身的标定数据。

同样,类似VIOBOT-PRO类的相机,在经历剧烈冲击撞击后也将产生同样的误差扩展现象:

以下引用好基友吴荩博士的专业解释:“mems的原理是通过硅微机械结构转动或者震动来得到反馈力 放大测量得到的科里奥利力 所以振动和冲击会改变硅微结构的机械特性 从而改变输出”

解决方法:机体如果经过剧烈撞击无法恢复建议重新标定(并不会经常发生,偶尔的撞击会对精度产生一定影响),设备常态的工作温度是很稳定的,注意散热,不要使其他热源向其导热。

(10)尾声-回环/地图管理,ODOM可信度与规划

回环和地图管理,本质是重定位,是机器人SLAM一直不太闭环的问题,他们还存在着一系列的局限性。

要么就只适合小场景,要么就依赖HD地图和第三方传感器。

无论是ORB-SLAM3中的Localmapping,还是高翔博士在这次SLAM论坛讲到的动静态地图管理,都是为了解决这类问题的优秀输出。这个东西我们目前也没有什么特别的思路和方法,之前尝试过以ICP来进行视觉回环,但实际走了很多弯路以失败告终,也算是给大家趟了坑吧。希望后续有高手能打通。

回环和地图管理主要是通用计算,比较依赖CPU,改起来也很麻烦,简单做做CPU并行即可,它毕竟是个低频操作。但是一定要注意触发时对系统的冲击,避免产生新的问题。

因为我们组地图管理和规划开发水平比较差,只能把精力高度集中到了ODOM本身可信度的工作上,这又回到三相性和世界观了,因为今天主题是讲问题,就不赘述了。

ODOM可信度测试:是指使用你的装置,在各种各样不同的环境和场景上均可以获得上佳的旋转和平移精度,不出现严重尺度退化,可以容忍一定误差(也必然会有一点的),但注意2个关键点:随机场景 可大量重复。这2个点Hold不住则你的ODOM没有可信度。

这个测试一共进行了6次,高可信度ODOM的代言~啦啦啦

好的ODOM可信度能减少大量重定位工作,比如户外本来需要RTK的,在很多场景用GNSS即可。

规划:点到点/最优路径/自由路径三种方式,我们还是更加倾向于第三种自由路径方式,一个好的VIO-SLAM,我们应该告诉机器人的就是你在哪/要去哪,其他的你自己来吧~~~更加接近人的思考和行动方式。至于到那里去做什么?那就是规划软件或者AI的任务了。VIO-SLAM的落地,一定要尽量地去避免卷cm mm级的场景,与诸君共勉。

—END—高效学习3D视觉三部曲

第一步 加入行业交流群,保持技术的先进性

目前工坊已经建立了3D视觉方向多个社群,包括SLAM、工业3D视觉、自动驾驶方向,细分群包括:[工业方向]三维点云、结构光、机械臂、缺陷检测、三维测量、TOF、相机标定、综合群;[SLAM方向]多传感器融合、ORB-SLAM、激光SLAM、机器人导航、RTK|GPS|UWB等传感器交流群、SLAM综合讨论群;[自动驾驶方向]深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器讨论群、多传感器标定、自动驾驶综合群等。[三维重建方向]NeRF、colmap、OpenMVS等。除了这些,还有求职、硬件选型、视觉产品落地等交流群。大家可以添加小助理微信: dddvisiona,备注:加群+方向+学校|公司, 小助理会拉你入群。

第二步 加入知识星球,问题及时得到解答

针对3D视觉领域的视频课程(三维重建、三维点云、结构光、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、源码分享、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答等进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业、项目对接为一体的铁杆粉丝聚集区,6000+星球成员为创造更好的AI世界共同进步,知识星球入口:「3D视觉从入门到精通」

学习3D视觉核心技术,扫描查看,3天内无条件退款

第三步 系统学习3D视觉,对模块知识体系,深刻理解并运行

如果大家对3D视觉某一个细分方向想系统学习[从理论、代码到实战],推荐3D视觉精品课程学习网址:www.3dcver.com

科研论文写作:

基础课程:

[1]面向三维视觉算法的C++重要模块精讲:从零基础入门到进阶

[2]面向三维视觉的Linux嵌入式系统教程[理论+代码+实战]

工业3D视觉方向课程:

[1](第二期)从零搭建一套结构光3D重建系统[理论+源码+实践]

SLAM方向课程:

[1]深度剖析面向机器人领域的3D激光SLAM技术原理、代码与实战

[1]彻底剖析激光-视觉-IMU-GPS融合SLAM算法:理论推导、代码讲解和实战

[2](第二期)彻底搞懂基于LOAM框架的3D激光SLAM:源码剖析到算法优化

[3]彻底搞懂视觉-惯性SLAM:VINS-Fusion原理精讲与源码剖析

[4]彻底剖析室内、室外激光SLAM关键算法和实战(cartographer+LOAM+LIO-SAM)

视觉三维重建

[1]彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进)

自动驾驶方向课程:

[1] 深度剖析面向自动驾驶领域的车载传感器空间同步(标定)

[2] 国内首个面向自动驾驶目标检测领域的Transformer原理与实战课程

[4]面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

[5]如何将深度学习模型部署到实际工程中?(分类+检测+分割)

4464

4464

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?