论文地址:https://arxiv.org/pdf/2409.12191

公开时间:2024年10月3日

项目地址:https://github.com/QwenLM/Qwen2-VL

Qwen2-VL是对之前的Qwen-VL模型的高级升级,重新定义了视觉处理中传统的预定分辨率方法。Qwen2-VL引入了朴素的动态分辨率机制,使模型能够动态地将不同分辨率的图像处理成不同数量的视觉标记。这种方法允许模型生成更有效和更准确的视觉表征,与人类的感知过程密切一致。该模型还集成了多模态旋转位置嵌入(M-RoPE),促进了在文本、图像和视频之间的位置信息的有效融合。我们采用了一个统一的范式来处理图像和视频,增强了模型的视觉感知能力。为了探索大型多模态模型的潜力,Qwen2-VL研究了大型视觉语言模型(LVLMs)的缩放定律。通过扩展模型的大小-2B、8B和72B参数的版本和训练数据的量,Qwen2-VL系列实现了具有高度竞争力的性能。值得注意的是,Qwen2-VL-72B模型在各种多模态基准上取得了可与GPT-4o和Claude3.5等领先模型相媲美的结果,优于其他多模型。

1 Introduction

在人工智能领域,大型视觉语言模型(LVLMs)代表了一个重大的飞跃,建立在强大的传统大型语言模型的文本处理能力之上。这些先进的模型现在包括了解释和分析更广泛的数据的能力,包括图像、音频和视频。这种能力的扩展已经将lvlm转变为应对各种现实世界挑战的不可或缺的工具。lvlm以其独特的能力将广泛和复杂的知识浓缩成功能表征,它正在为更全面的认知系统铺平道路。通过整合不同的数据形式,lvlm的目标是更接近地模仿人类感知和与环境互动的微妙方式。这使得这些模型能够更准确地表示我们如何参与和感知我们的环境。

大型视觉语言模型(LVLMs)在短时间内取得了显著的改善,这些模型一般采用视觉编码器→跨模态连接器→LLM的常见方法。这种设置,结合下一个标记预测作为主要的训练方法和高质量数据集的可用性。推动了很大程度上的进展。其他因素,如更大的模型架构(Alayrac等人,2022)、高分辨率图像(Li等人,2023a,d),以及混合专家模型(MoE)(Wang等人,2023b;Ye等人,2023b)、模型集成(Lin等人,2023)以及更复杂的视觉和文本模式之间的连接器(Ye等人,2023a),也在增强LVLMs更有效地处理复杂视觉和文本信息的能力方面发挥了关键作用。

然而,目前的大型视觉语言模型(lvlm)通常受到固定的图像输入大小的限制。标准LVLMs将输入图像编码为固定分辨率(例如,224×224),通常通过对图像进行降采样或上采样(Zhu等人,2023;Huang等人,2023a),或采用比例填充方法(Liu等人,2023b,a)。虽然这种一刀切的策略能够以一致的分辨率处理图像,但它也限制了模型在不同尺度上捕获信息的能力,特别是导致高分辨率图像中详细信息的严重丢失。因此,这种模型不能像人类视觉那样以对尺度和细节的敏感性感知视觉信息。

此外,大多数lvlm依赖于静态的、冻结的clip式(Radford et al.,2021)视觉编码器,人们开始担心,这种预训练模型产生的视觉表示是否足够,特别是对于复杂的推理任务和处理图像中复杂的细节。最近的工作(Bai等人,2023b;Ye等人,2023a)试图通过在LVLM训练过程中微调ViT来解决这些限制,这已显示出可以产生更好的结果。为了进一步增强模型对不同分辨率的适应性,我们在LVLM训练过程中引入了动态分辨率训练。具体来说,我们在ViT中使用了一个二维旋转位置嵌入(RoPE),从而允许模型更好地捕获不同空间尺度上的信息。

当涉及到视频内容时,这本质上是一系列的帧,许多现有的模型继续将其视为一个独立的模式。然而,理解现实的动态本质,如在视频中所体现的那样,对于模型旨在掌握现实世界的复杂性是至关重要的。与文本本质上是一维的不同,现实世界的环境存在于三维空间中。在当前的模型中使用一维位置嵌入显著地限制了它们有效地建模三维空间和时间动力学的能力。为了弥补这一差距,我们开发了多模态旋转位置嵌入(MRoPE),它使用单独的组件来表示时间和空间信息。这使得模型能够自然地理解动态内容,如视频或流媒体数据,提高了其理解和与世界交互的能力

此外,与大型语言模型(llm)的缩放相比,当前的lvlm仍处于探索在训练数据和模型参数方面的缩放影响的早期阶段。对lvlm的扩展定律的探索——模型和数据大小的增加如何影响性能——仍然是一个开放和有前途的研究领域。

- 在这项工作中,我们引入了Qwen家族的大型视觉语言模型的最新添加: Qwen2-VL系列,它包括三个开放权重模型,总参数计数分别为20亿、80亿和720亿。如图1所示,Qwen2-VL的关键进展包括:

对各种分辨率和长宽比的最先进的理解: Qwen2-VL在视觉基准测试上取得了领先的性能,包括DocVQA、InfoVQA、RealWorldQA、MTVQA、MathVista等。 - 长时间视频理解(20分钟+):Qwen2-VL能够理解超过20分钟的视频,增强其执行高质量视频问答、对话、内容创建等的能力。

- 设备操作的强大代理能力:Qwen2具有高级推理和决策能力,Qwen2-VL可以与移动电话、机器人等设备集成,实现基于视觉输入和文本指令的自主操作。

- 多语言支持:为了服务全球观众,除了英语和中文,Qwen2-VL现在支持图像中的多语言上下文理解,包括大多数欧洲语言、日语、韩语、阿拉伯语、越南语和其他语言。

2 Approach

Qwen2-VL系列由3种尺寸的模型组成,即Qwen2-VL-2B、Qwen2-VL-7B和Qwen2-VL- 72B。表1列出了超参数和重要信息。值得注意的是,Qwen2-VL在不同大小的LLM上使用了一个675M的参数的ViT,以确保无论LLM的规模如何,ViT的计算负载都保持不变。

2.1 Model Architecture

图2展示了Qwen2-VL的综合结构。我们保留了Qwen-VL(Bai et al.,2023b)框架,该框架集成了视觉编码器和语言模型。

对于各种规模的适应,我们已经实现了一个ViT(Dosovitskiy等人,2021年),具有大约6.75亿个参数,擅长处理图像和视频输入。在语言处理方面,我们选择了更强大的Qwen2(Yang et al.,2024)一系列语言模型。为了进一步提高模型有效感知和理解视频中视觉信息的能力,我们引入了几个关键的升级:

Naive Dynamic Resolution Qwen2-VL的一个关键架构改进是引入了简单的动态分辨率支持(Dehghani等人,2024)。与Qwen-VL不同,Qwen2-VL现在可以处理任何分辨率的图像,动态地将它们转换为可变数量的视觉令牌。为了支持这一特性,我们修改了ViT,删除了原始的绝对位置嵌入,引入2D-RoPE(Su et al.,2024;Su,2021)来捕获图像的二维位置信息。在推理阶段,不同分辨率的图像被打包成一个单一的序列,并控制打包的长度以限制GPU内存的使用。此外,减少每个图像的视觉标记,一个简单的MLP层使用后对2×2的token下采样为1个token,与特殊<|vision_star|><|vision_end|>标记放置在开始和结束的压缩视觉标记。因此,一个分辨率为224×224的图像,使用patch_size=14用ViT编码,在进入LLM之前将被压缩到66个令牌。224x224 /14(patch size) /2 (2x2下采样)=64 ;64+开始与结束token=66

Multimodal Rotary Position Embedding (M-RoPE) 另一个关键的架构改进是多模态旋转位置嵌入(M-RoPE)的创新。与传统的llm中的1D-RoPE仅限于编码一维位置信息不同,M-RoPE可以有效地对位置进行了建模多模态输入的信息。这是通过将原来的旋转嵌入分解为三个组成部分:时间、高度和宽度。对于文本输入,这些组件使用相同的位置id,使M-RoPE在功能上等效于1D-RoPE(Su,2024)。在处理图像时,每个视觉标记的时间id保持不变,而根据标记在图像中的位置分配给高度和宽度组件。对于被视为帧序列的视频,每一帧的时间ID都为增量,而高度和宽度组件遵循与图像相同的ID分配模式。在模型的输入包含多个模态的情况下,每个模态的位置编号通过增加前一个模态的最大位置ID来初始化。M-RoPE的说明如图3所示。M-RoPE不仅增强了位置信息的建模,而且降低了图像和视频的位置id的值,使模型在推理过程中能够推断出更长的序列。

Unified Image and Video Understanding Qwen2-VL采用了一种结合图像和视频数据的混合训练方案,确保了熟练的图像理解和视频理解。为了尽可能完整地保存视频信息,我们以每秒两帧的速度采样每个视频。此外,我们集成了3D卷积(Carrerira和Zisserman,2017)的两个深度来处理视频输入,允许模型处理3D切片而不是2D patch,从而使其能够在不增加序列长度的情况下处理更多的视频帧(Arnab et al.,2021)。为了保持一致性,每幅图像都被视为两个相同的帧。为了平衡长视频处理的计算需求和整体训练效率,我们动态调整每个视频帧的分辨率,将每个视频的token总数限制在16384个。这种训练方法在模型理解长视频的能力和训练效率之间取得了平衡

2.2 Training

遵循Qwen-VL(Bai et al.,2023b),我们采用了一种三阶段的训练方法:

- 在第一阶段,我们专门关注于

训练视觉转换器(ViT)组件的对齐能力,利用大量的图像-文本对语料库来增强大型语言模型(LLM)中的语义理解。 Qwen2-VL暴露在大约6000亿个token的语料库中。Qwen2-VL的LLM组件使用Qwen2的参数初始化(Yang et al.,2024),而Qwen2-VL的视觉编码器使用DFN导出的ViT初始化。然而,在原始DFN的ViT(Fang et al.,2023)中的固定位置嵌入被RoPE-2D所取代。这个训练前阶段主要集中于学习图像-文本关系,通过OCR识别图像中的文本内容,以及图像分类任务。这种基础训练有助于使模型发展对核心视觉-文本相关性和对齐的稳健理解。 - 在第二阶段,我们解冻所有参数,并训练更广泛的数据,以进行更全面的学习。 涉及额外的8000亿个图像相关数据的令牌。这一阶段引入了更多数量的混合图像-文本内容,促进了对视觉和文本信息之间的相互作用的更微妙的理解。视觉问题回答数据集的结合改进了模型对图像相关查询的响应能力。此外,包含多任务数据集对于开发模型同时导航不同任务的能力至关重要,这在处理复杂的真实数据集时是一种至关重要的技能。与此同时,纯文本数据继续在维护和提高模型的语言熟练程度方面发挥关键作用。

- 在最后一个阶段,我们锁定ViT参数,并使用教学数据集对LLM进行独占微调。 使用了ChatML(Openai,2024)格式来构造指令跟踪数据。该数据集不仅包含纯基于文本的对话数据,还包括多模态对话数据。多模态组件包括图像问答、文档解析、多图像比较、视频理解、视频流对话和基于代理的交互。我们对数据构建的全面方法旨在增强模型理解和执行跨各种模式的各种指令的能力。通过合并不同的数据类型,我们寻求开发一个更通用和更健壮的语言模型,除了传统的基于文本的交互之外,还能够处理复杂的、多模态的任务。

该模型在不同的数据集上进行了预训练,包括图像-文本对、OCR数据、交错的图像-文本文章、视觉问题回答数据集、视频对话和图像知识数据集。我们的数据源主要包括清理过的网页、开源数据集和合成数据。我们的数据知识的截止日期是2023年6月。这种多样化的数据组合有助于开发一个健壮的多模态理解能力。

在整个训练前阶段,Qwen2-VL累计处理了1.4万亿个代币。具体来说,这些标记不仅包含文本标记,还包含图像标记。然而,在培训过程中,我们只对文本标记提供监督。这种对广泛和多样的语言和视觉场景的暴露确保了模型对视觉和文本信息之间复杂关系的深刻理解,从而为各种多模态任务奠定了坚实的基础。

2.2.1 Data Format

与Qwen-VL相一致,Qwen2-VL还使用了特殊的token来区分视觉和文本输入。在图像特征序列的开始和结尾插入<|vision_start|>和<|vision_end|>,以划分图像内容。

Dialogue Data. 在对话格式方面,我们使用ChatML格式构建指令调优数据集,其中每个交互的语句都用两个特殊的标记(<|im_start|>和<|im_end|>)标记,以促进对话终止。用蓝色标记的部分表示被监督的部分。

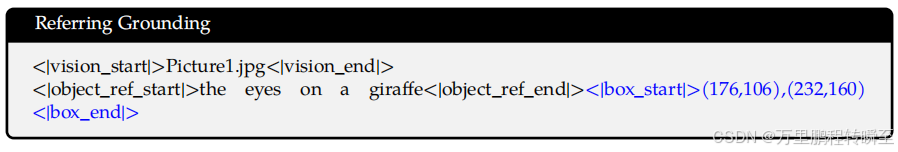

Visual Grounding. 为了赋予模型视觉Grounding能力,边界框坐标在[0,1000)内被归一化,并表示为"

(

X

t

o

p

−

l

e

f

t

,

Y

t

o

p

−

l

e

f

t

)

,

(

X

b

o

t

t

o

m

−

r

i

g

h

t

,

Y

b

o

t

t

o

m

−

r

i

g

h

t

)

(X_{top-left}, Y_{top-left}),(X_{bottom-right}, Y_{bottom-right})

(Xtop−left,Ytop−left),(Xbottom−right,Ybottom−right)"。使用token <|box_start|>和<|box_end|>来划分边界框文本。为了准确地将边界框与其文本描述链接起来,我们引入了标记<|object_ref_start|>和<|object_ref_end|>来表示边界框所引用的内容,从而允许模型有效地解释和生成对特定区域的精确描述。

Visual Agent. 为了将Qwen2-VL开发为一种通用的VL-Agent,我们将各种代理任务,如UI操作、机器人控制、游戏和导航,视为顺序决策问题,使Qwen2-VL能够通过多步骤的动作执行来完成任务。对于每个任务,我们首先为函数调用定义一组允许的操作和关键字模式(下划线)(QwenTeam,2024)。然后,Qwen2-VL分析观察结果,执行推理和计划,执行所选的动作,并与环境进行交互,以获得新的观察结果。这个循环反复重复,直到任务成功完成。通过集成各种工具并利用大型视觉语言模型(LVLMs)的视觉感知能力,Qwen2-VL能够迭代地执行涉及现实世界视觉交互的越来越复杂的任务。

2.3 Multimodal Model Infrastructure

Qwen2-VL模型在阿里云的PAI-Lingjun智能计算服务(Alibaba云,2024c)上进行训练,具有可伸缩计算、自动恢复和分离检测。

Storage 使用阿里巴巴云的超高速CPFS(云并行文件存储)构建了Qwen2-VL的存储系统。我们解耦了文本数据和视觉数据存储。我们只需在CPFS上存储文本数据,并使用mmap进行高效访问。对于视觉数据,我们使用阿里巴巴云的OSS(对象存储服务)进行持久存储。在训练期间,我们通过OSS的python客户端并发访问视觉数据,并调整并发性和重试参数,以避免达到QPS(每秒查询)限制。我们还发现,视频数据解码是一个主要的瓶颈,特别是对于长视频。在对开源软件(ffmpeg-开发人员,2024)和内部软件的几次尝试失败后,我们选择了一种缓存解码技术。检查点可在CPFS上保存每个GPU的优化器和模型状态。

Parallelism 我们使用三维并行性,它结合了数据并行性(DP)(Li等人,2020)、张量并行性(TP)(Krizhe斯基等人,2012;Shoeybi等人,2019年)和管道并行性(PP)(Huang et al.,2019年;Narayanan等人,2021年;拉米-波里耶,2023年)来扩展Qwen2-VL模型训练。我们还利用deepspeed的 zero-1 零冗余优化器(Rajbhandari等人,2020年)来分割状态以保存内存。利用选择性检查点激活(Chietal.,2016)(Korthikantati等人,2023)来减少内存使用。当启用TP训练时,我们总是将视觉编码器和大型语言模型分割在一起,但不分割视觉编码器,因为其参数相对较少。我们发现,由于卷积算子的非确定性行为,TP训练会导致不同的模型共享权值。我们通过离线减少共享权重来解决这个问题,从而避免了额外的全减少通信步骤。这种方法对性能的影响很小。我们利用1F1B PP(Narayanan et al.,2021)进行Qwen2-VL 72B训练。我们将视觉编码器、视觉适配器和几个LLM的解码器层合并到一个阶段中,并均匀地分割剩余的解码器层。请注意,每个数据点的视觉长度和文本序列长度都是动态的。我们在启动1F1B过程之前广播动态序列长度,并使用批处理索引访问形状信息。我们还实现了一个交错的1F1B PP(Narayanan et al.,2021),但发现它比标准的1F1B设置要慢。

Software 我们使用PyTorch(Paszke等人,2019年;Ansel等人,2024年)版本2.1.2和CUDA 11.8(Nvidia,2024b)进行训练。此外,我们利用flash-attention(Dao等人,2022年;Dao,2024年;Shah等人,2024年)来对视觉编码器和LLM进行有效的训练。我们还使用了融合运算符(Nvidia,2024a),如LayerNorm (Ba et al.,2016年)、RMSNorm(张和森里希,2019年)和Adam(洛什奇洛夫和Hutter,2019年)。除此之外,我们在训练过程中利用了矩阵乘法过程中通信和计算的重叠。

3 Experiments

在本节中,我们首先通过对各种可视化基准测试进行比较分析来评估模型的性能,从而展示了我们的方法的优点。随后,我们对具体的能力进行了详细的检查,包括一般的视觉感知、文档理解、图像中的多语言识别、视频理解和代理能力。最后,我们提出了一项消融研究来研究我们的方法的几个关键组成部分。

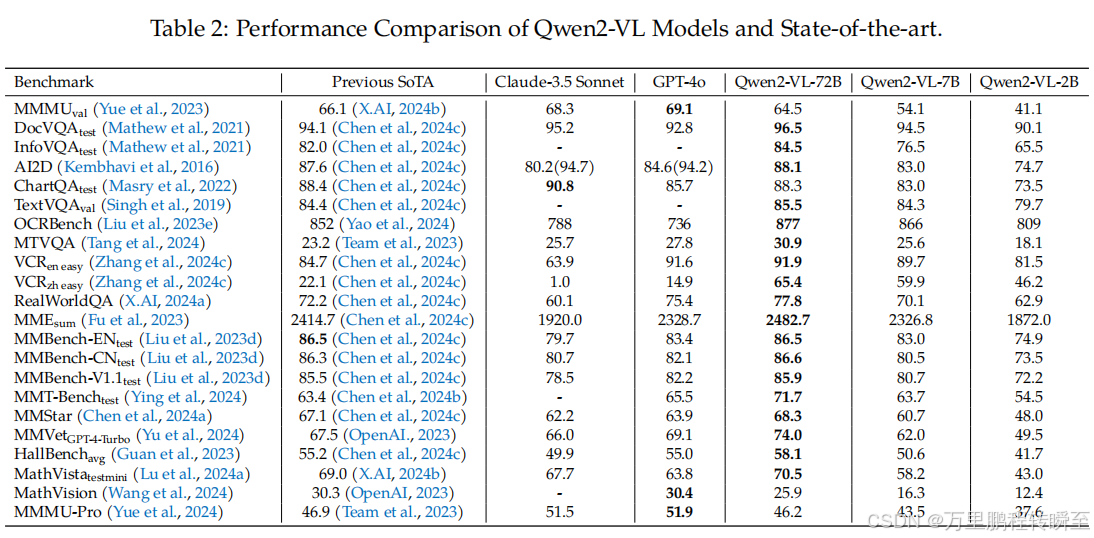

3.1 Compare to SOTAs

我们通过各种视觉基准、视频任务和基于代理的评估来评估我们的模型的视觉能力。Qwen2-VL在相同的规模上展示了高度竞争的性能,实现了新的最先进的(SoTA)结果。总的来说,我们的72B模型在大多数评估指标上始终提供顶级性能,经常超过闭源模型,如GPT-4o(OpenAI,2024)和Claude3.5-Sonnet(人类学,2024)。值得注意的是,它在文档理解任务中显示出了一个显著的优势。然而,在MMMU(Yue et al.,2023)基准测试中,我们的模型在一定程度上仍然落后于GPT-4o,这表明Qwen2-VL-72B在处理更复杂和具有挑战性的问题集时还有改进的空间。

3.2 Quantitative Results

在本节中,我们将跨一系列数据集对Qwen2-VL系列进行广泛的评估,并提供了对模型在各个方面的能力的全面理解。

3.2.1 General Visual Question Answering

为了严格评估我们的模型在一般视觉问题回答任务中的能力,我们对不同的基准进行广泛评估:RealWorldQA、MMStar、MMVet、MMT-Benc、MMBench、MMbench-1.1、MME和HallusionBench。Qwen2-VL系列在这些基准测试中表现出了卓越的性能,72B模型持续地达到或超过了最先进的结果,而7B和2B版本也显示出了强大的能力。

在评估现实世界空间理解的RealWorldQA上,Qwen2-VL-72B得分为77.8分,超过了之前的最先进水平(72.2)和强大的基线,如GPT-4o(75.4),从而显示了对物理环境的优越理解。

MMStar是一个通过视觉上不可缺少的样本来评估真正的多模态能力的基准,Qwen2-VL-72B达到了68.3,优于之前的67.1,并突出了其在集成视觉和文本信息方面的熟练程度。

在MMVet上,Qwen2了16个复杂多模态任务的核心视觉语言能力集成,Qwen2-VL-72B实现了显著的74.0,显著超过了包括GPT-4V(67.5)在内的强大竞争对手,并展示了其在应对多种多模态挑战方面的多功能性。

在MMT-Bench评估中,评估了32个核心元任务和162个子任务的高级推理和指令,Qwen2-VL-72B达到了71.7,显著超过了之前的最佳水平(63.4),并展示了其在应用专家知识和执行故意视觉识别、定位、推理和规划方面的能力。

在评估20个维度细粒度能力的MMBench上,Qwen2-VL-72B表现出强大的性能,在英语测试集达到86.5,与最先进的匹配,在中国测试集达到86.6,建立了一个新的基准。

MME测量了14个子任务的广泛感知和认知能力,Qwen2-VL-72B的累积得分为2482.7,显著优于之前的最佳水平(2414.7),强调了其在视觉感知和高级认知任务方面的先进能力。

这些综合的结果强调了Qwen2-VL系列在一般视觉问题回答任务方面的异常熟练程度。这些模型展示了在现实世界的空间理解、真实的多模态整合、复杂的推理、指令遵循以及广泛的感知和认知任务方面的先进能力。在不同的基准测试中持续的卓越性能,特别是72B模型的卓越结果,使Qwen2-VL系列成为视觉问题回答领域的领先解决方案。我们的模型擅长于处理视觉上不可或缺的任务,集成核心视觉语言能力,并在不同的多模态场景中演示专业知识,从基本的感知任务到复杂的推理和规划。这一详尽的评估强调了Qwen2-VL系列在解决由最先进的多模态基准所带来的多方面挑战方面的多功能性和有效性,从而为大型视觉语言模型设置了一个新的标准。

3.2.2 Document and Diagrams Reading

我们在DocVQA、ChartQA、InfoVQA、TextVQA、AI2D数据集上测试了我们的模型的OCR、文档和图表的理解。

- DocVQA/InfoVQA/ChartQA数据集关注模型理解文档/高分辨率信息图形/图表中的文本的能力,

- TextVQA数据集则检查在自然图像中理解文本的能力。

- OCRBench数据集是一个包含混合任务的数据集,除了基于文本的VQA外,它还主要关注数学公式的解析和信息提取。

- AI2D数据集主要关注于包含文本的科学图表上的多项选择题。

- 此外,还在OCRBench(Liu等人,2023e)上测试了我们的模型的OCR和公式识别能力,以及我们的模型在MTVQA(Tang等人,2024)数据集上的多语言OCR能力。

实验结果表明,我们的模型在DocVQA、InfoVQA、TextVQA和OCRBench等多个指标上都达到了SoTA水平,这表明我们的模型对多个领域图像中的文本内容具有很好的理解能力。

3.2.3 Multilingual Text Recognition and Understanding

特别是,我们的模型超越了多语言OCR中所有现有的通用lvlm。我们的模型不仅优于现有的lvlm(包括专有模型,如GPT-4o,Claude 3.5等)。在公开可用的MTVQA数据集上,它在除阿拉伯语外的所有外语的内部内部基准测试上也优于GPT-4o(表3)。

3.2.4 Mathematical Reasoning

我们已经在MathVista(Lu等人,2024a)和MatsVision(Wang等人,2024)数据集上进行了实验,以评估数学推理能力。MathVista是一个全面的基准,有6141个不同的数学和视觉任务的例子。数学视觉数据集包括3040个嵌入在实际数学竞赛中的数学问题,涵盖了16个数学学科,在5个层次上难度不同。这些挑战强调了lvlm表现出强大的视觉理解、对数学的深刻理解和健全的逻辑推理能力的必要性。Qwen2-VL系列在MathVista上表现出了卓越的性能,比其他车型高出70.5倍。此外,它还在MathVision上设置了一个新的开源基准。

3.2.5 Referring Expression Comprehension

关于视觉定位任务,我们在RefCOCO、RefCoCOCO+和RefCOCOg数据集上评估Qwen2-VL(Kazemzadeh等人,2014;Mao等人,2016)。结果,如表6所示,表明Qwen2-VL在通用模型中获得了顶级的结果。得益于更合理的结构设计,Qwen2-VL能够感知高分辨率图像中的细节,导致了比Qwen-VL的显著改进。与多面手模型和专业模型相比,这些模型的优越性突出了它们在推进视觉定位领域方面的潜力,以及它们在需要精确视觉理解的任务中实现现实世界的能力。

3.2.6 Video Understanding

我们在各种视频理解任务上评估我们的模型,相关的基准包括几秒钟的短视频到长达一小时的长视频。表4显示了Qwen2-VL和基线模型的性能。总体而言,Qwen2-VL在2B、7B和72B尺寸上都表现出了强大的结果,Qwen2-VL-72B在MVBench(Li等人,2024)、感知测试(Patraucean等人,2024)和自我模式(Mangalam等人,2023)上表现最好。这展示了Qwen2-VL在视频理解任务,并扩大Qwen2-VL产生了显著的改进。对于具有挑战性的Video-MME基准测试(Fu等人,2024年),其中包括最长1小时的视频,值得注意的是,在评估期间,我们将每个视频提取的最大帧数限制为768帧,这可能会影响较长视频的性能。未来的工作将集中于扩展Qwen2-VL,以支持更长的序列,从而容纳更长的视频。

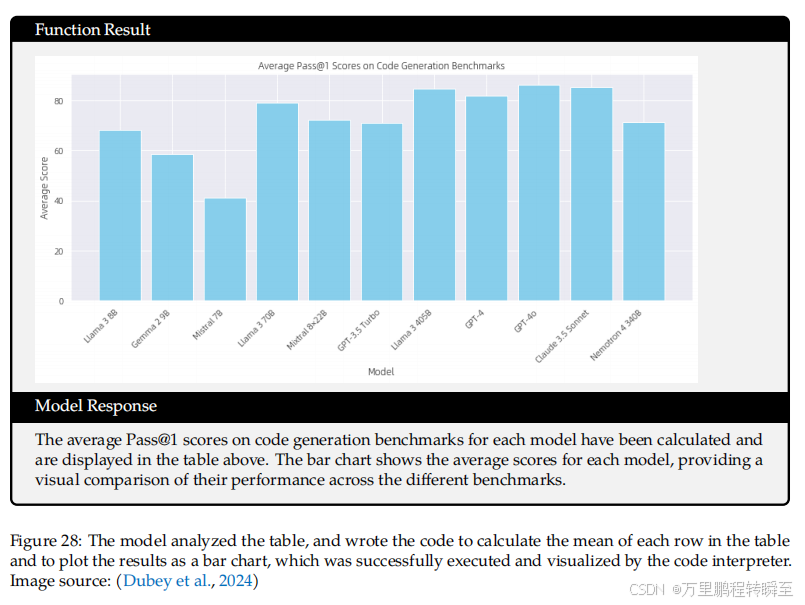

3.2.7 Visual Agent

Qwen2-VL首先评估其通过函数调用与环境交互的能力,然后评估其通过多轮交互完成复杂的顺序决策任务的能力。该实现是基于Qwen-Agent框架(Qwen Team,2024)。

Function Calling 与LLMs中的函数调用不同(Yan等人,2024;Srinivasan等人,2023;Chen等人,2023c),LVLMs中的函数调用通常涉及从视觉线索中提取信息。由于缺乏评估函数调用中lvlm功能的公共基准测试,我们构建了内部评估数据集。为了构建评估数据集,我们进行了以下步骤(Chen et al.,2023c):场景分类、图像收集、图像内容提取和问题/函数/参数生成。首先,我们根据不同的视觉应用程序对场景进行了分类。随后,我们从互联网上为每个类别下载并精心挑选了高质量的、具有代表性的图片。然后,我们利用先进的LVLM(Bai et al.,2023b),分析每幅图像,提取关键的视觉元素和文本信息。最后,基于图像中的内容信息,我们使用了高级LLM(Yang et al.,2024)生成了一系列需要特定函数来回答的问题,并指定了这些函数调用所需的输入参数。

类似于llm中的函数调用评估方法(Yan et al.,2024),我们设计了两个度量标准来评估函数选择的准确性和参数输入的正确性。具体来说,类型匹配(TM)计算为模型成功调用正确函数与尝试调用总数的次数之比。精确匹配(EM),对于每个函数调用,我们检查传递给函数的参数是否与图像内容信息中记录的参数完全匹配,并计算这个正确率。

如表5所示,Qwen2-VL在类型匹配(93.1比90.2)和精确匹配(53.2 vs. 50.0)上的性能证实了Qwen2-VL在函数调用方面的有效性,从而强调了通过外部工具集成扩展应用程序的显著潜力。

评估结果表明,GPT-4o表现不佳,主要是由于两个因素:在出现不确定性的情况下,GPT-4o展示了一种保守的方法。GPT-4o的光学字符识别(OCR)能力优于Qwen2-VL,特别是在汉字语境中。

UI Operations/Games/Robotics/Navigation 为了评估Qwen2-VL一般处理复杂任务的能力,我们对多个VL代理任务进行评估,包括手机操作\机器人控制、纸牌游戏和视觉语言导航。由于这些任务需要多个动作来完成任务,我们通过Qwen2-VL保持历史(观察、动作)支持32K的上下文长度,然后在每个动作之后添加每个新的观察图像,从而能够对后续步骤进行连续推理。

UI Operations: 我们使用AITZ任务(Zhang等人,2024b)来评估Qwen2-VL,该任务构建了一个从AITW派生的核心干净测试集(Rawles等人,2024b)。基于手机的常见操作模式,我们定义了诸如点击、输入和滑动(Rawles et al.,2024b)等动作,以便Qwen2-VL与屏幕上的图标交互以完成任务。例如,当Qwen2-VL的任务是通过谷歌地图找到附近的披萨餐厅时,它应该在搜索词中输入“披萨”,滑动选择合适的餐厅,然后点击相应的链接。在AITZ设置之后,我们将报告类型匹配(轻敲、输入或滑动的正确性)和精确匹配(轻敲位置、输入文本或滑动方向的正确性)。通过UI接地能力支持,Qwen2-VL超过GPT-4和之前的SoTA(Zhang et al.,2024b;Zhan和Zhang,2023)。

Robotic Control: 我们评估了AI2THOR中的ALFRED任务(Shridhar等人,2020a)(Kolve等人,2017)。这项任务要求代理人执行复杂的家务,比如烤面包和切苹果来准备饭菜。为了在虚拟环境中工作,我们将高级动作(目标位置、拾取、向下、下推、打开、关闭、清洁、加热、冷却、切片)(Shridhar等人,2020b)定义为动作集。此外,代理需要本地化对象以进行操作(例如,只有当苹果被识别时,它才能选择一个苹果)。为了提高操作的准确性,我们整合了SAM(Kirillov等人,2023)。ALFRED任务报告任务成功率(SR)(例如,准备晚餐)和子目标完成指标(GC)(例如,是烤面包还是切苹果)。Qwen2-VL在有效-不可见集上略优于之前的专门化模型ThinkBot(Lu et al.,2023)。

**Card Games: ** 我们利用RL4VLM(Zhai et al.,2024)来评估Qwen2-VL在一系列基于纸牌的游戏中的表现:数字线、21点、EZPoint和Point24。每个游戏都有不同的挑战: (1)使用+1或-1操作达到一个目标数字,(2)绘制或持有纸牌与发牌者竞争,(3)应用基本的算术运算,总共达到12个,(4)使用算术运算,总共达到24个。我们报告了这些任务的成功率。他们不仅评估代理的能力,还需要强大的OCR技能来识别这些牌并了解游戏的进程。Qwen2-VL在所有任务中都展示了卓越的性能。

**Vision-Language Navigation: ** 我们使用R2R(Anderson等人,2018年)和幻想梦(Qi等人,2020年)来评估Qwen2-VL在视觉和语言导航(VLN)任务上的作用。在VLN中,模型必须根据指令、当前的观测结果自动确定下一个位置。我们报告了VLM到达该任务的预定目的地的成功率(SR)。Qwen2-VL的性能与GPT-4o相当,但两种模型都明显落后于目前的专门VLN模型(Chen等,2022;西格德森等,2023)。我们将这一差距归因于模型从多个图像中生成的不完整和非结构化的地图信息。在3D环境中精确地建模地图和位置仍然是多模态模型面临的一个主要挑战。

3.3 Ablation Study

在本节中,我们介绍了在图像动态分辨率、M-RoPE和模型尺度上的消融研究。这些实验旨在深入了解这些关键组件对我们的模型性能的影响。

3.3.1 Dynamic Resolution

如表7所示,我们比较了动态分辨率和固定分辨率之间的性能。对于固定的分辨率,我们调整图像的大小,以确保输入到模型的图像标记数量不变,而不是调整到特定的高度和宽度,因为这将扭曲原始的长宽比。对于动态分辨率,我们只设置了min_pixels= 100×28×28和max_pixels= 16384×28×28,允许图像令牌的数量主要取决于图像的原生分辨率。可以观察到,调整图像大小只会导致性能上的小扰动,证明了模型对不同图像大小的鲁棒性。此外,动态分辨率方法更有效。我们可以观察到,没有一个固定分辨率能在所有基准测试中达到最佳性能。相比之下,动态分辨率方法始终能达到顶级性能,同时平均消耗更少的令牌。

此外,我们观察到,仅仅增加图像大小并不总是能提高性能。更重要的是要为不同的图像选择合适的分辨率。如图4所示,我们将小图像放大,以超过指定的min_pixels阈值。对升级图像的评估显示,在InfoVQA、HallusionBench和OCRBench等感知任务上的表现有所增强。我们将这些增益归因于增加的计算负荷。然而,对于OCRBench来说,min_pixels值过高会导致严重的性能下降。这可能是因为OCRBench包含大量非常小的图像,而过度放大导致这些图像偏离训练数据分布,使它们变成分布外的样本。相比之下,增加min_pixels对MMMU基准测试的影响可以忽略不计。我们假设MMMU中的性能瓶颈与模型的性能瓶颈更相关推理能力,而不是图像分辨率。

3.3.2 M-RoPE

在本小节中,我们将演示M-RoPE的有效性。首先,我们验证了它在各种下游任务上的能力。我们采用Qwen2-1.5B和ViT-L为骨干,并报告了预训练模型的结果。如表8所示,与1D-RoPE相比,使用M-RoPE在下游任务中取得了更好的性能,特别是在视频基准测试中。此外,我们还评估了M-RoPE在Video-MME中长度视频上的长度外推能力。图5展示了Qwen2- VL-72B在不同推理长度下的性能。利用M-RoPE,该模型演示了跨不同推理长度的鲁棒结果。值得注意的是,尽管在训练期间将每个视频的最大标记限制为16K,但该模型在最大推理长度为80K标记下仍然表现出非凡的性能。

3.3.3 Model Scaling

我们评估了跨多个能力维度的不同尺度的模型的性能。具体来说,我们将这些维度分为复杂的大学水平的问题解决能力、数学能力、文档和表理解能力、一般场景问答能力和视频理解能力。一个模型的整体能力是通过在与每个维度相关的不同基准上平均其得分来评估的。

特别是,我们使用MMMU(2023)基准来表示大学水平的问题解决能力,而MathVista(2024a)和MathVision(2024)的平均分数作为数学能力的指标。对于一般场景的问题回答,我们计算RealWorldQA(2024a)、MMBench-V1.1(2023d)、MMT-Bench(2024)、HallBench(2023)、MMVet(2024)和MMStar的平均得分。文档和表理解能力通过DocVQA(2021年)、InfoVQA(2021年)、ChartQA(2022年)、TextVQA(2019年)、OCRBench(2023年)和MTVQA(2024年)来反映。最后,视频理解能力是通过对MVBench(2024)、Perception-Test(2024)、EgoSchema(2023)和Video-MME(2024)的平均得分来衡量的。

如图6(a)所示,随着模型大小的增加,性能有了一致的改善,特别是在数学能力方面,这与模型参数的数量呈正相关。另一方面,对于光学字符识别(OCR)相关的任务,即使是小尺度模型也表现出较强的性能。如图6(b)所示,我们可视化了Qwen2-VL-7B在预训练第二阶段的模型性能与训练令牌数量之间的关系。随着训练标记数量的增加,模型性能的提高;然而,对视觉问题回答(VQA)任务的表现表现出一定的波动。相比之下,对于AI2D(Kembhavi等人,2016)和InfoVQA(Mathew等人,2021)等任务——这两种任务都涉及到理解图像中的文本和图形信息——随着训练数据的增强,模型的性能表现出了稳定的改善。

4 Conclusion

我们展示了Qwen2-VL系列,这是一种通用的大型视觉语言模型,包括三个总参数计数为2、8亿和720亿。Qwen2-VL在一系列多模态场景中与GPT-4o和Claude3.5-Sonnet等顶级模型的性能相匹配,超过了所有其他开放重量的LVLM模型。Qwen2-VL系列引入了简单的动态分辨率和多模态旋转位置嵌入(M-RoPE),有效地融合跨模态的信息,能够理解超过20分钟的视频。Qwen2-VL具有先进的推理和决策能力,可以与手机、机器人等设备集成。此外,Qwen2-VL现在支持理解图像中的多语言文本,包括大多数欧洲语言、日语、韩语、阿拉伯语、越南语等。

我们已经使Qwen2-VL模型的权重可以公开访问,这使研究人员和开发人员能够在各种应用程序和研究项目中充分利用其潜力。我们的目标是通过致力于这些努力,推进人工智能技术,增强它们对社会的有益影响。

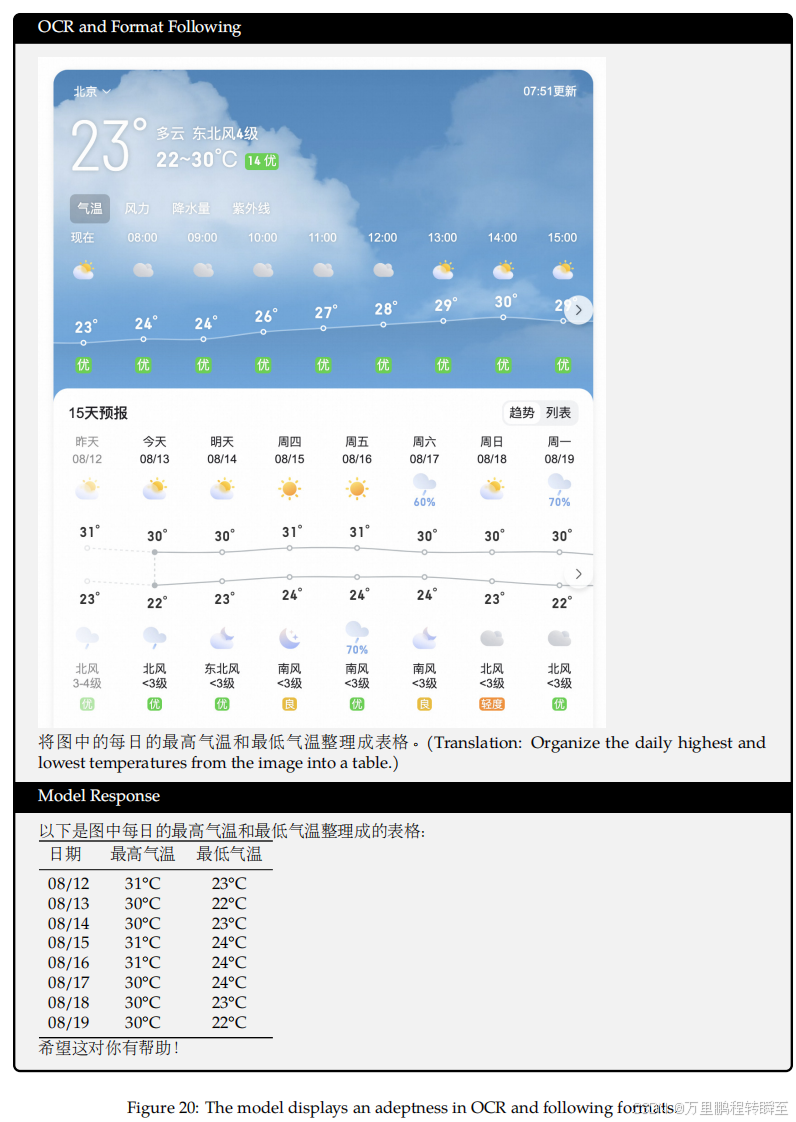

5、效果演示

922

922

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?