来源:

视频教程:茴香豆:搭建你的 RAG 智能助理

文字教程:茴香豆:搭建你的 RAG 智能助理

作业来源:第三课作业

茴香豆web链接:茴香豆web-零编程接入飞书微信(更新了高精度 LLM!)

1. 笔记

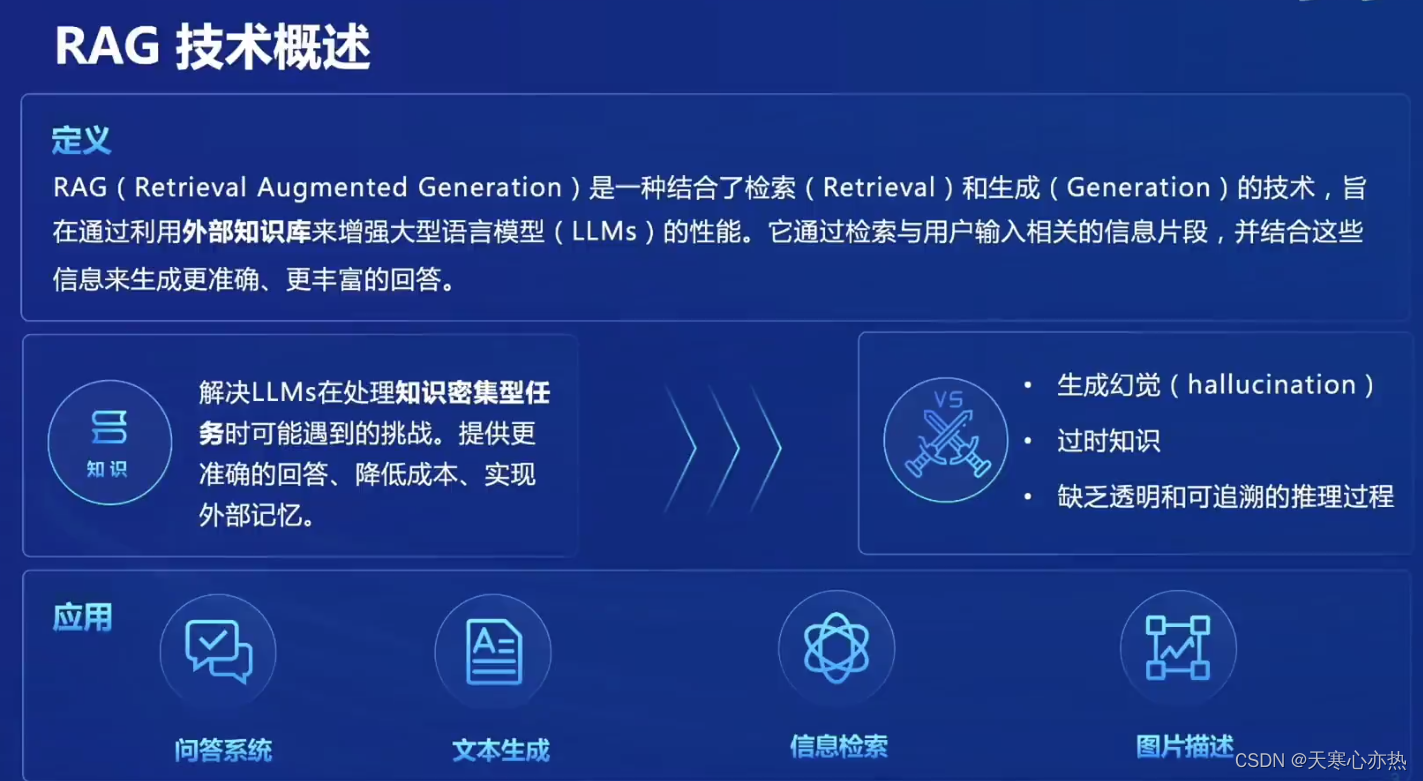

1.1 RAG技术概述

RAG(Retrieval Augmented Generation)是一种结合了检索(Retrieval)和生成(Generation)的技术,旨 在通过利用外部知识库来增强大型语言模型(LLMs)的性能。它通过检索与用户输入相关的信息片段,并结合这些 信息来生成更准确、更丰富的回答。解决LLMs在处理知识密集型任 务时可能遇到的挑战。提供更 准确的回答、降低成本、实现 外部记忆。

不足:生成幻觉;过时知识;缺乏透明和可追溯的推理过程

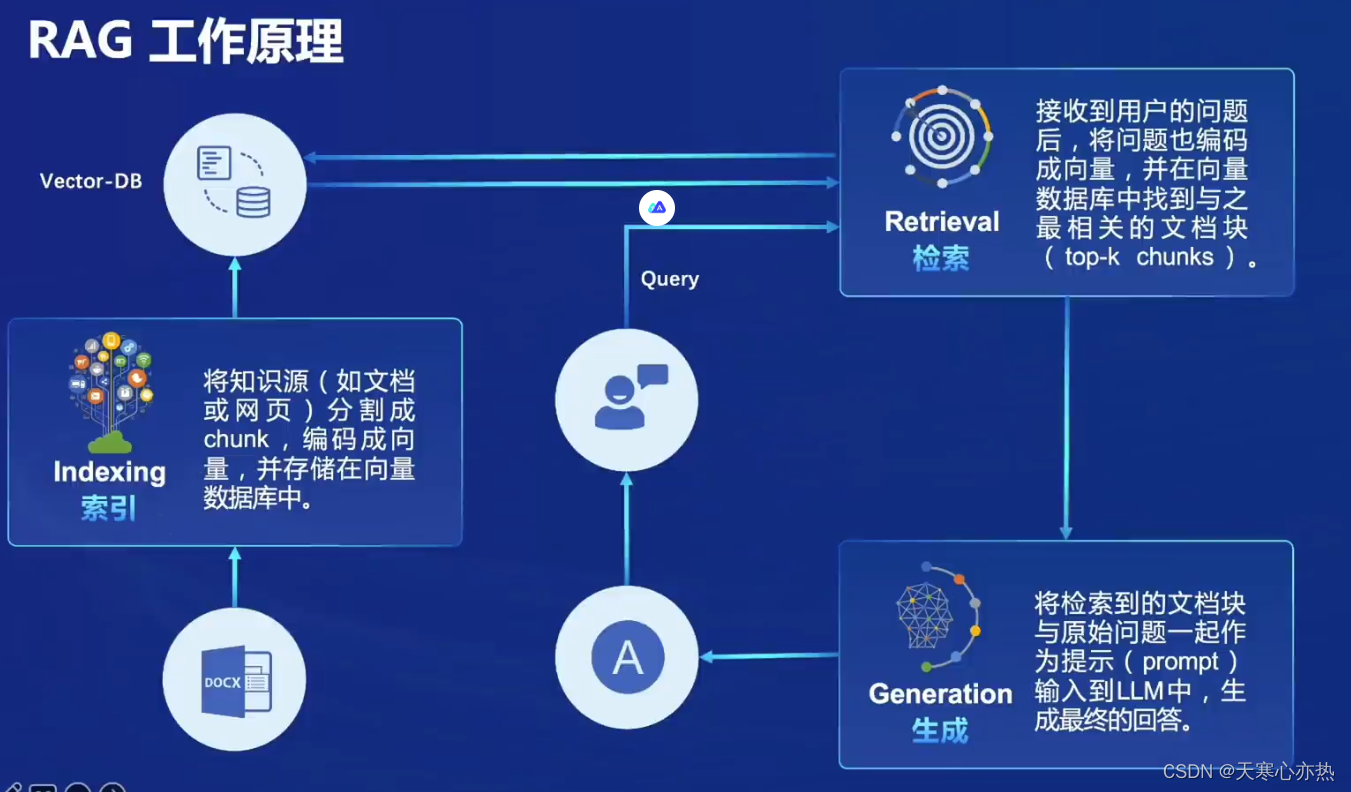

1.2 RAG工作原理

数据存储:将文本及其他数据通过其他预训 练的模型转换为固定长度的向量 表示,这些向量能够捕捉文本的 语义信息。

相似性检索:根据用户的查询向量,使用向量数 据库快速找出最相关的向量的过程。 通常通过计算余弦相似度或其他相 似性度量来完成。检索结果根据相似度得分进行排序, 最相关的文档将被用于后续的文本生成。

向量表示的优化:包括使用更高级的文本编码技术 如句子嵌入或段落嵌入,以及对 数据库进行优化以支持大规模向 量搜索。

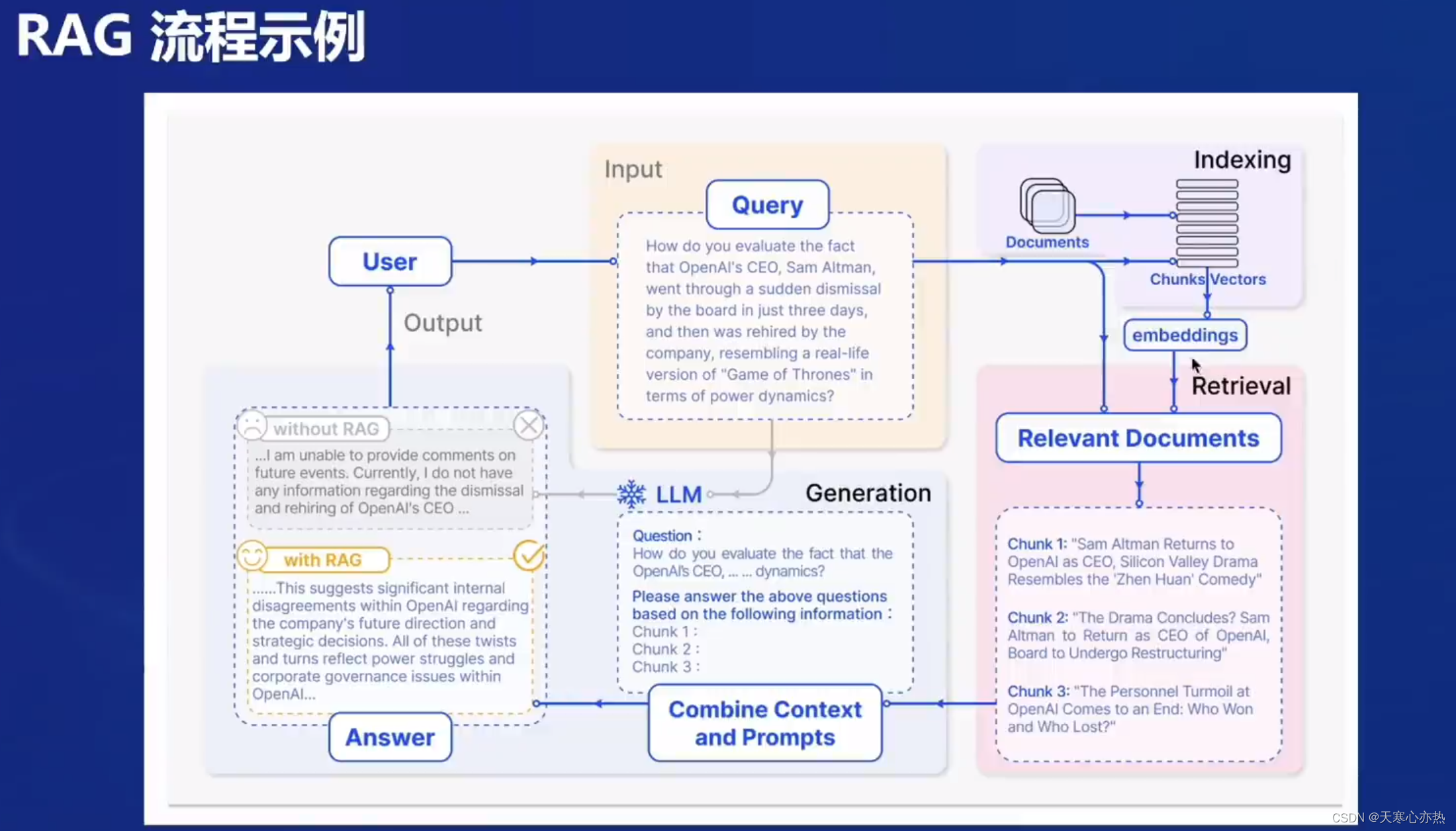

1.3 RAG流程示例

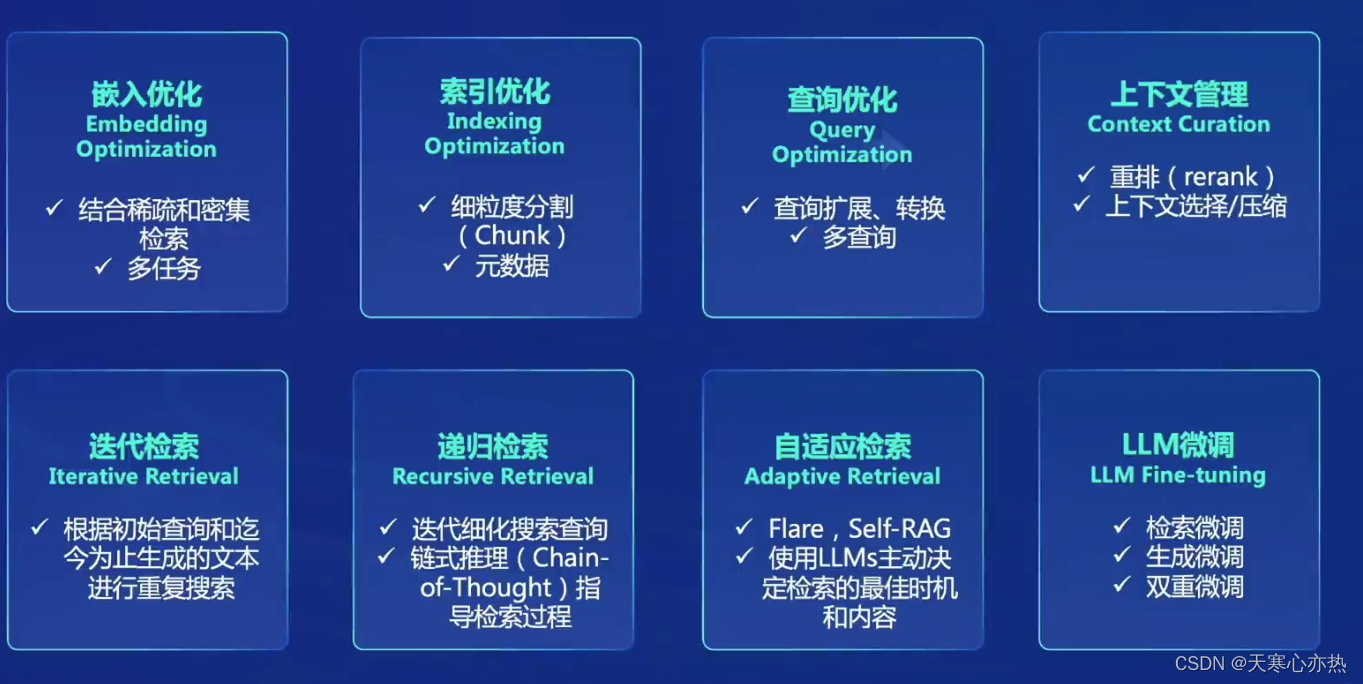

1.4 RAG常见优化方法

嵌入优化 索引优化 查询优化 上下文管理 迭代检索 递归检索 自适应检索 LLM微调

自适应检索:Flare , Self-RAG;使用LLMs主动决定检索的最佳时机

递归检索:迭代细化搜索查询 ;链式推理(Chain-of-Thought)指导检索过程和内容。

LLM微调:LLM Fine-tuning:检索微调;生成微调;双重微调

选代检索:根据初始查询和迄今为止生成的文本进行重复搜索

上下文管理:Context Curation 重排(rerank) 上下文选择/压缩

嵌入优化:结合稀疏和密集检索 多任务

素引优化:细粒度分割 元数据

查询优化:查询扩展、转换 多查询

1.5 评估框架和基准测试

经典评估指标:准确率 召回率 F1分数 BLEU分数 RouGE分数

RAG评测框架:基准测试-RGB,RECALL,CRUD

评测工具

2. 茴香豆作业

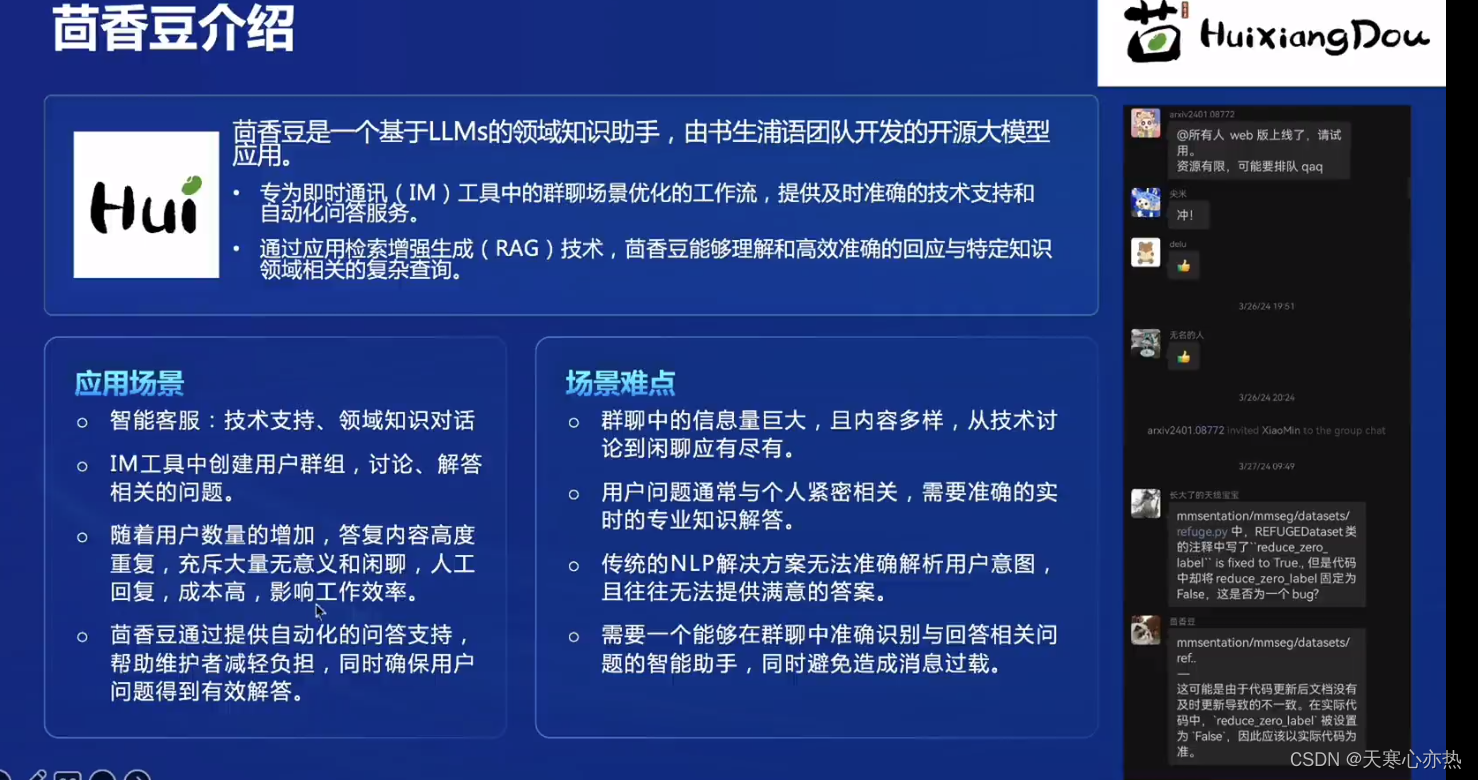

茴香豆是一个基于LLMs的领域知识助手,由书生浦语团队开发的开源大模型应用。专为即时通讯(IM)工具中的群聊场景优化的工作流,提供及时准确的技术支持和 自动化问答服务。通过应用检素增强生成(RAG)技术,茴香豆能够理解和高效准确的回应与特定知识领域相关的复杂查询。

应用场景:

智能客服:技术支持、领域知识对话 。

IM工具中创建用户群组,讨论、解答 相关的问题。

随着用户数量的增加,答复内容高度 重复,充斥大量无意义和闲聊,人工 回复,成本高,影响工作效率。通过提供自动化的问答支持, 帮助维护者减轻负担,同时确保用户 问题得到有效解答。

场景难点:

群聊中的信息量巨大,且内容多样,从技术讨 论到闲聊应有尽有。

用户问题通常与个人紧密相关,需要准确的实 时的专业知识解答。

传统的NLP解决方案无法准确解析用户意图, 且往往无法提供满意的答案。

需要一个能够在群聊中准确识别与回答相关问 题的智能助手,同时避免造成消息过载。

2.1.实践一:在

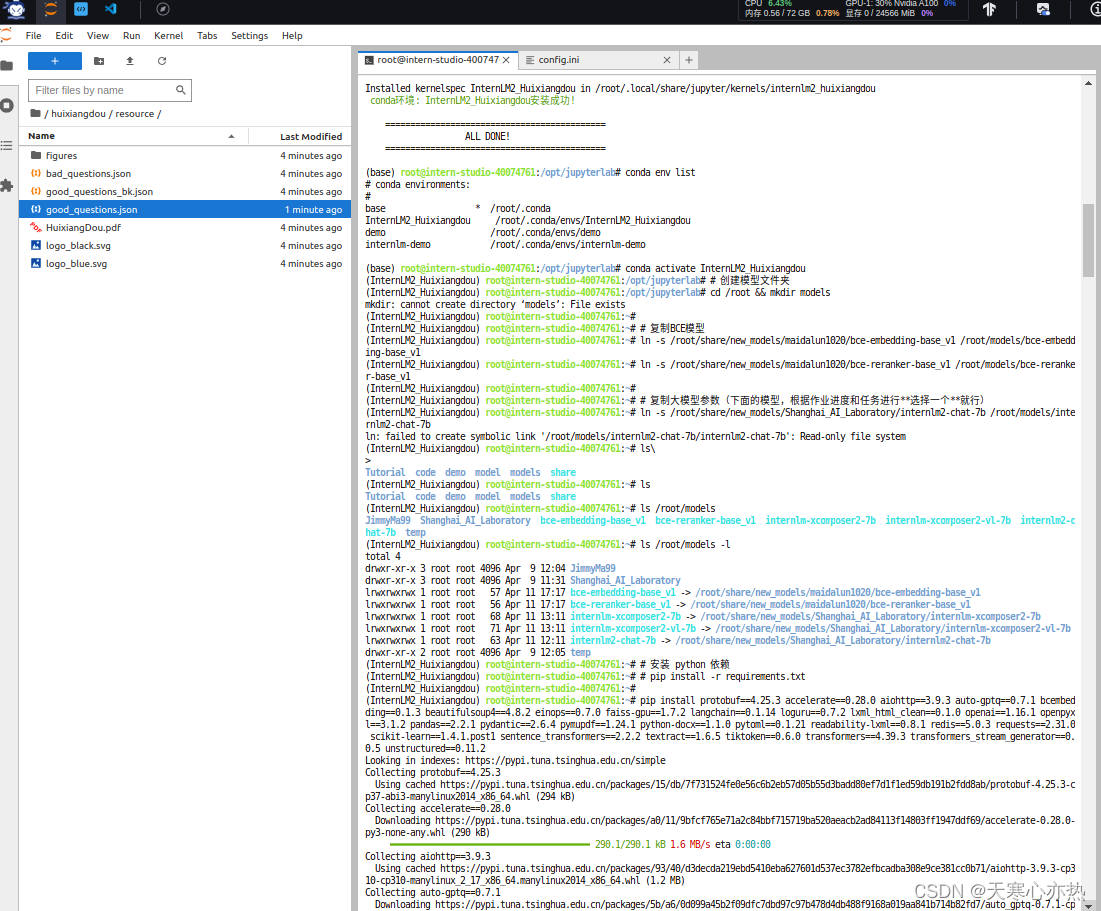

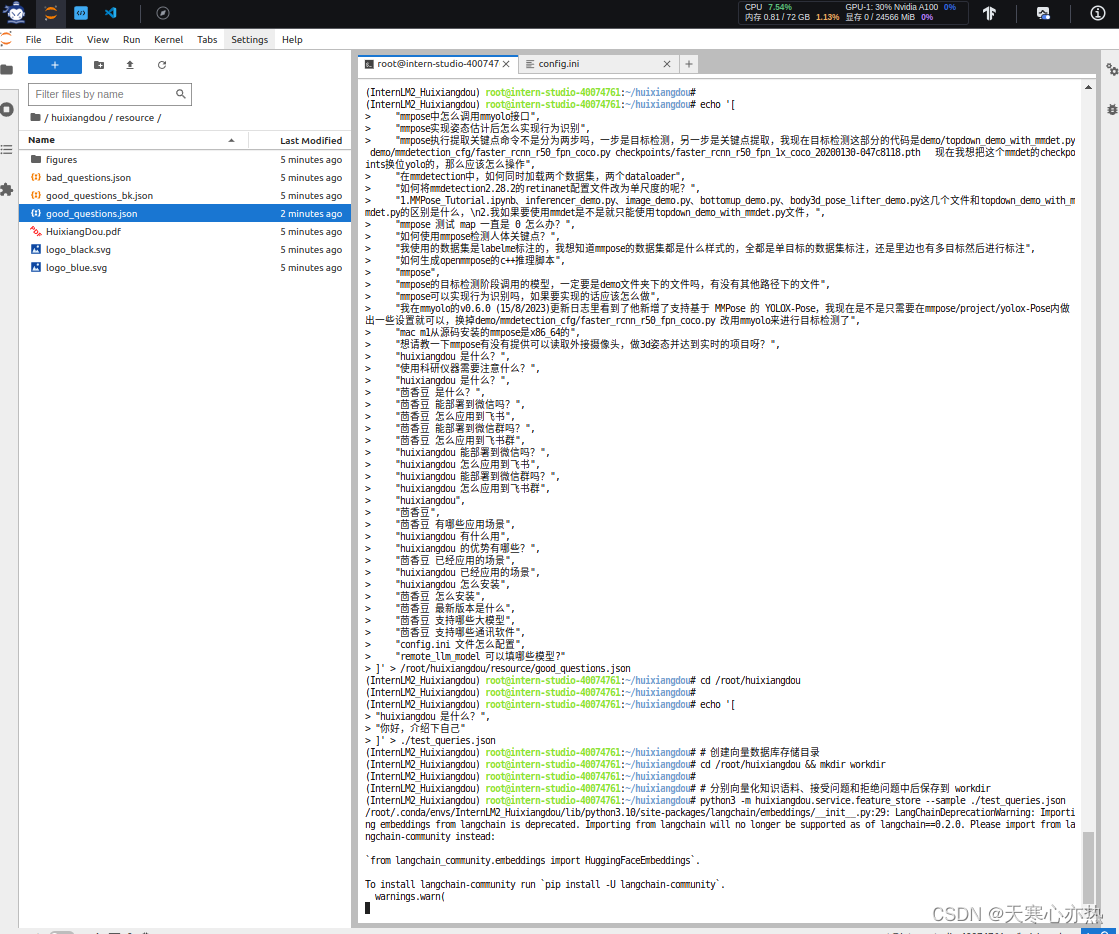

2.1.实践一:在 InternLM Studio 上部署茴香豆技术助手

对话截图

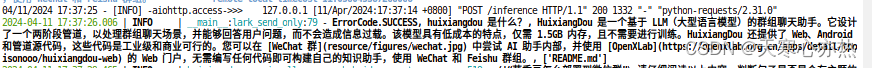

对话截图

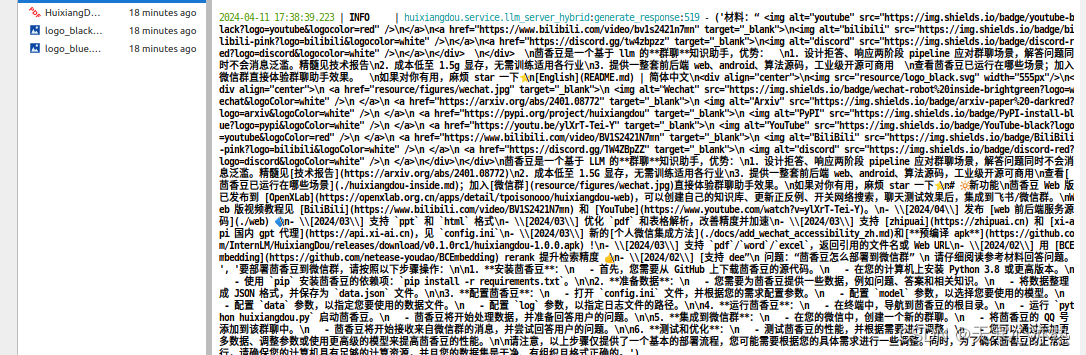

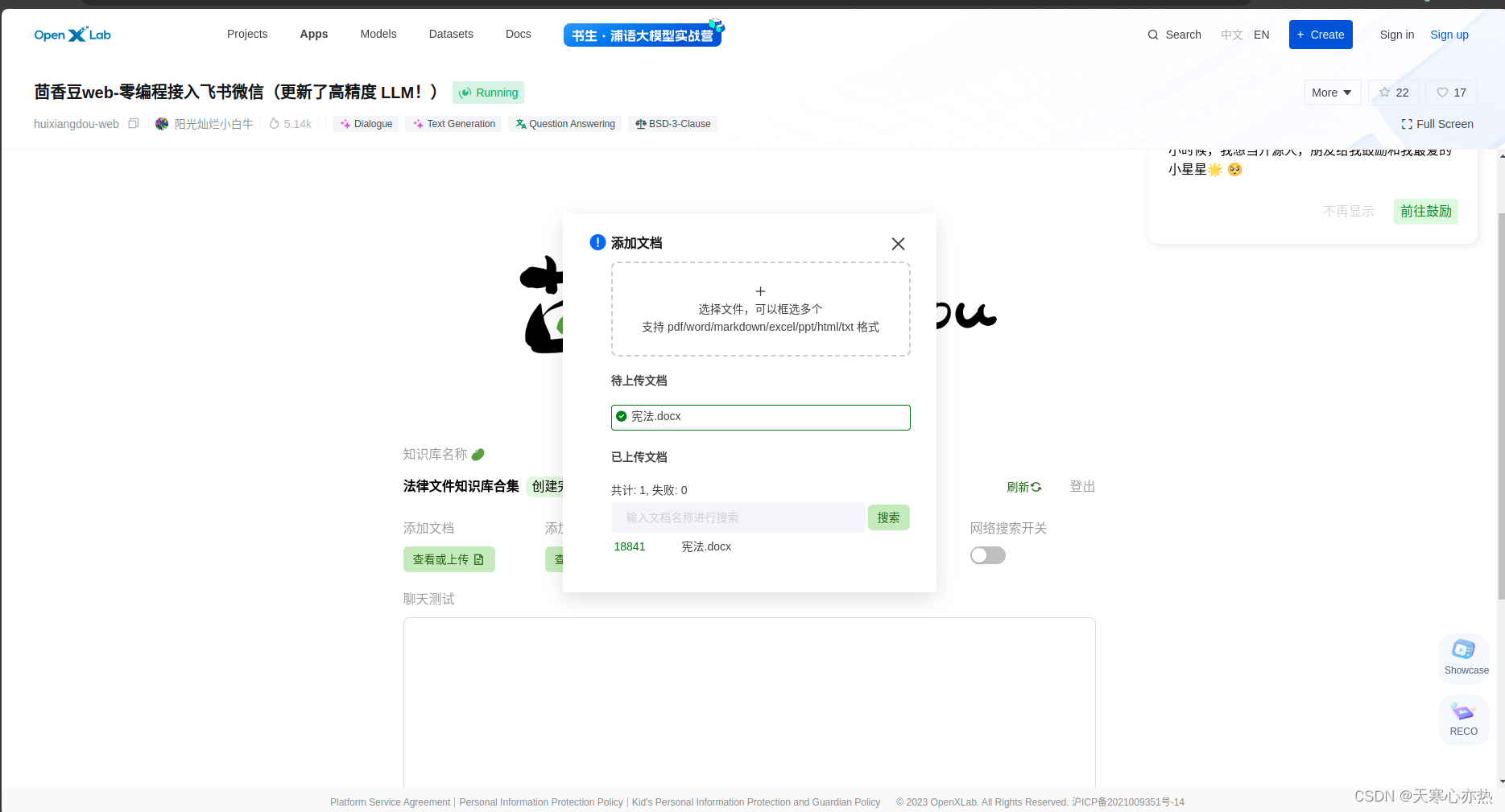

2.2 茴香豆Web版演示

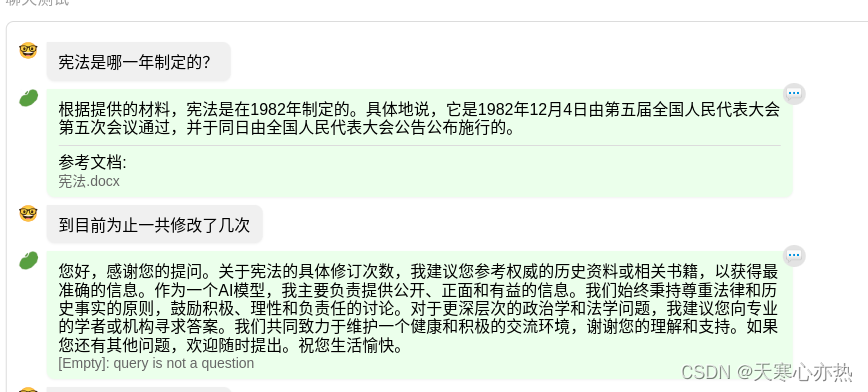

第1-2轮对话

第3-4轮对话

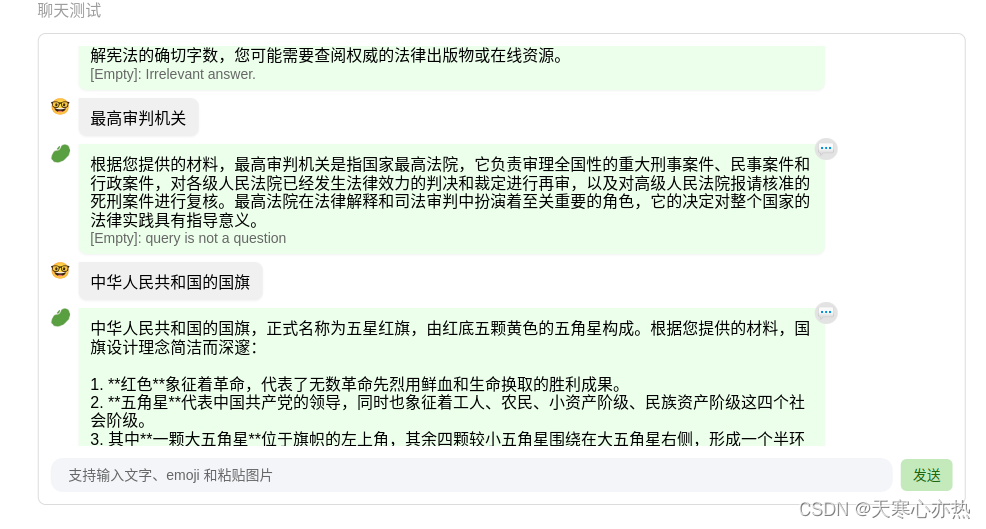

第5-6轮对话

第5-6轮对话

939

939

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?