概述

自从 ChatGPT 发布以来,开发人员的工作方式发生了革命性变化。代码生成、自动化调试、技术文档解析等环节的效率大幅提升,整体工作效率提高超过 40%。

然而,ChatGPT 在国内应用面临高延迟、高昂的 API 调用成本和数据隐私合规等难题,限制了其在生产环境中的广泛应用。

DeepSeek R1为此提供了突破性解决方案。通过本地化部署和灵活的定制功能(如代码合规性过滤、敏感信息隔离),企业可在本地完成从代码生成到自动化测试的全流程,降低成本的同时,确保数据安全和合规,真正实现高效、安全、可控的 AI 编程实践。

本文章内主要介绍私有化部署托管和低成本本地部署的方式 。 至于API的方式主要是面向C端用户的,企业内部使用要涉及到多个账户,使用量等等繁琐的事项这里就不做介绍了。

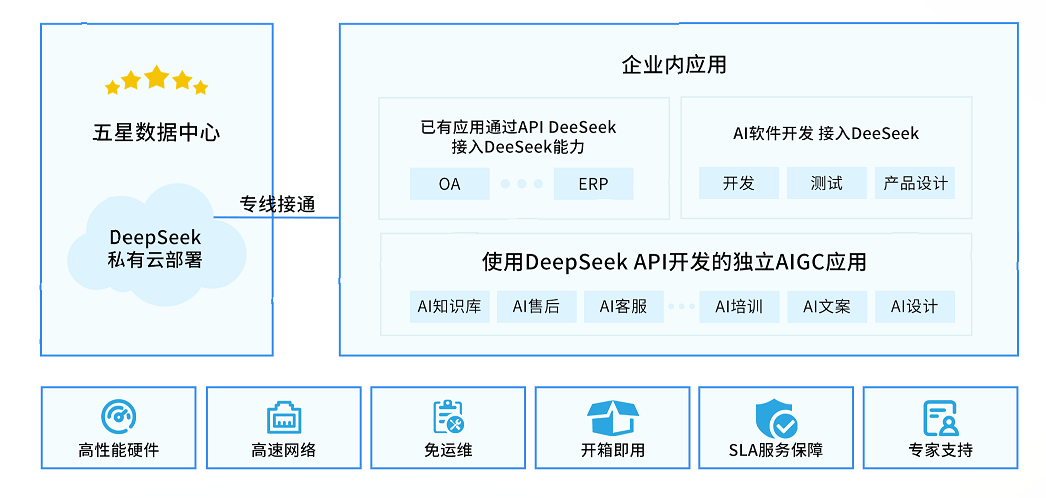

私有化部署托管的方式

私有化部署托管是一种高效、低成本的大模型部署方案。企业可以通过与服务商合作,租赁一台或多台高性能 GPU 服务器,在这些服务器上部署 DeepSeek R1 模型。部署完成后,这些服务器将成为企业的专属计算资源,仅为企业内部使用,确保数据安全和使用独占性。

在计费方式上,企业采用按月支付租金的模式,降低一次性投入成本,享受持续的算力支持。为了在保证性能的同时进一步降低成本,我们推荐使用以下 GPU 服务器配置:

- 8 卡 RTX 4090 – 提供卓越的 AI 推理和训练性能,性价比突出。

在模型选择上,我们建议部署经过优化的 deepseek-r1-distill-qwen-32b 模型。该模型在保持强大理解和生成能力的同时,经过蒸馏优化,具备更快的推理速度和更低的算力消耗,帮助企业在提升智能服务体验的同时有效控制成本。

英智创新目前提供私有化部署和托管服务,提供 8卡 RTX 4090 的服务器,每台每月租金约为 8800元。单台服务器每秒可支持的并发请求数约为 64,每秒吞吐量可达到约 924 tokens。

在 DeepSeek 模型 的部署和 API 平台的搭建过程中,服务商将为客户提供全程技术支持,直接协助客户完成模型和平台的搭建。客户只需打通与企业内部网络的连接,即可快速投入使用,免去繁琐的配置和调试过程。

此外,服务商还将定期为客户进行模型的升级和系统维护,确保平台始终保持在最佳性能状态,帮助企业在模型效果和响应速度上保持行业领先。

如果您对此感兴趣,请联系我们 网址: 首页 • 大模型推理API

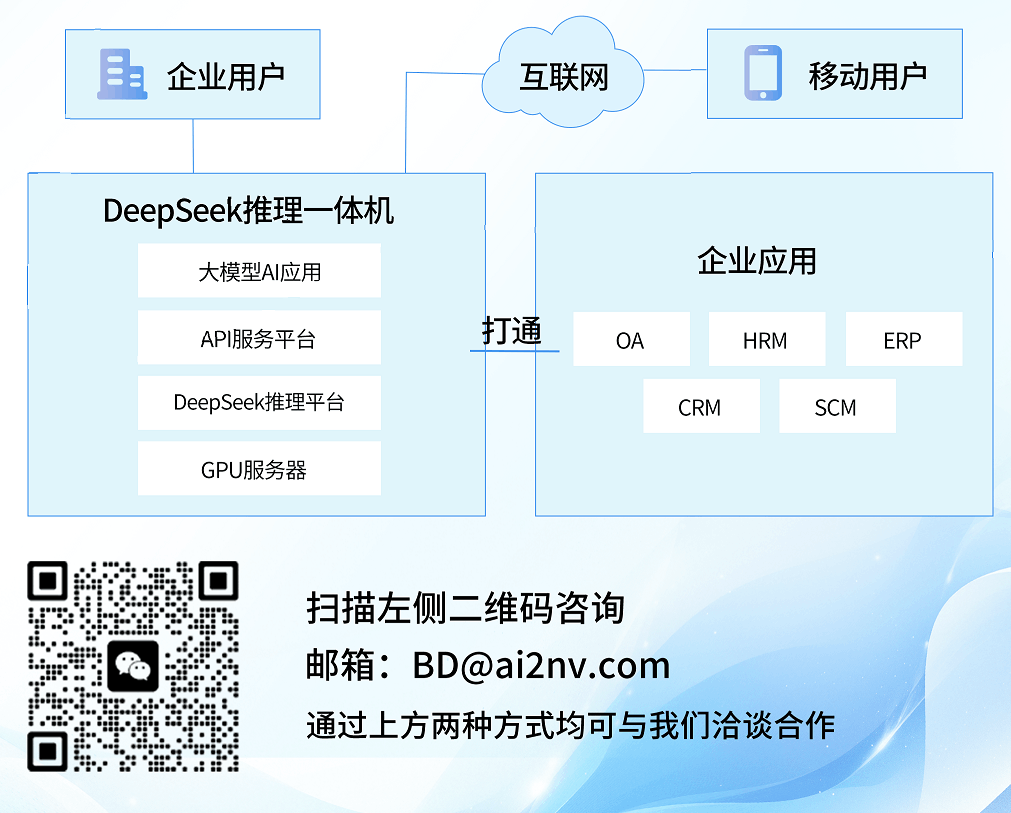

本地部署的方式

本地部署的方式就是在企业购买GPU服务器,通过部署DeepSeek R1模型,来给企业内部提供服务的一种方案, 这种方案的好处是,一次性投资持续使用, 不用每个月都去缴租赁费用, 同时数据也是相对最安全的,数据不会出公司。 在低成本的方案上,我们推荐3种配置,一种是2卡 4090 一种是 4卡4090 和 8卡4090

本地部署方案是指企业通过购买 GPU 服务器,部署 DeepSeek R1 模型,为企业内部提供服务的一种方式。这种方案具有诸多优势:

- 一次性投资,长期受益:无需按月支付租赁费用,一次性投入后便可持续使用,降低长期运营成本。

- 数据安全性高:所有数据均存储在企业内部,避免数据外泄,确保数据安全性和合规性。

- 性能稳定,可控性强:本地部署可根据企业需求进行灵活配置,确保模型响应速度和服务质量。

在低成本配置方面,以下三种方案可供企业根据自身业务规模和需求选择:

1. 2卡 RTX 4090 配置:

- 适用场景:小型团队或中低负载任务,成本较低,能满足基础的模型推理需求。

- 服务器类型:塔式服务器。

- 模型部署:建议部署4bit量化版本的 deepseek-r1-distill-qwen-32b 模型。

- 并发数:可达50。

- 支持团队规模:适合15人以下的团队使用。

- 价格(约):10万元

2. 4卡 RTX 4090 配置:

- 适用场景:小型团队或中等负载场景,性能与成本达到良好平衡。

- 模型部署:建议部署4bit量化版本的 deepseek-r1-distill-qwen-32b 模型。

- 并发数:可达100。

- 支持团队规模:适合30人以下的团队使用。

- 价格(约):15万元

3. 8卡 RTX 4090 配置:

- 适用场景:中小规模团队或中高负载场景,具备更强的并行处理能力,支持更复杂的任务和更高的吞吐量。

- 模型部署:

- 完全版本:可部署完全版本的 deepseek-r1-distill-qwen-32b 模型。

- 4bit量化版本:也可选择部署4bit量化版本的 deepseek-r1-distill-qwen-32b 模型。

- 并发数:

- 完全版本:每秒可达64。

- 4bit量化版本:可达200。

- 支持团队规模:

- 完全版本:适合30人以下的团队使用。

- 4bit量化版本:适合60人以下的团队使用。

- 价格(约):29万元

英智创新已推出上述三款配置的一体机,内置deepseek-r1-distill-qwen-32b模型服务,具备即插即用的便利性,帮助企业快速部署和使用。所有一体机均已预装智能体软件,支持企业灵活构建和定制 AI 解决方案。

此外,英智创新为所有一体机产品提供定期的模型免费升级,确保模型性能和效果始终保持在行业领先水平。同时,提供长达3年的软硬件一体化服务,涵盖设备维护、软件更新和技术支持,助力企业在 AI 应用中保持稳定运行和持续创新。

如果您对此有兴趣,请访问: 英智 DeepSeek 大模型推理一体机

使用deepseek 加速企业研发团队的开发效率

无论是采用私有化部署托管方式,还是通过一体机本地部署方式,最终都将获得以下两种访问方式:

-

Web 访问地址

通过简单的用户名 + 密码即可登录 Web 界面,直接进行对话,使用体验与 OpenAI 的 WebUI 相似,操作便捷,易于上手。 -

API 服务地址

提供完整的 API 服务和获取 API-KEY 的方法,支持多种集成方式:- 可在各类聊天工具中集成使用,满足跨平台通信需求。

- 支持在主流**IDE(集成开发环境)**中直接调用,如 VSCode、IDEA 等,方便开发者集成 AI 功能到现有工作流中。

这种灵活的访问方式,既满足了企业用户的便捷使用需求,又为开发者提供了高效的集成体验,助力 AI 能力快速融入业务场景。

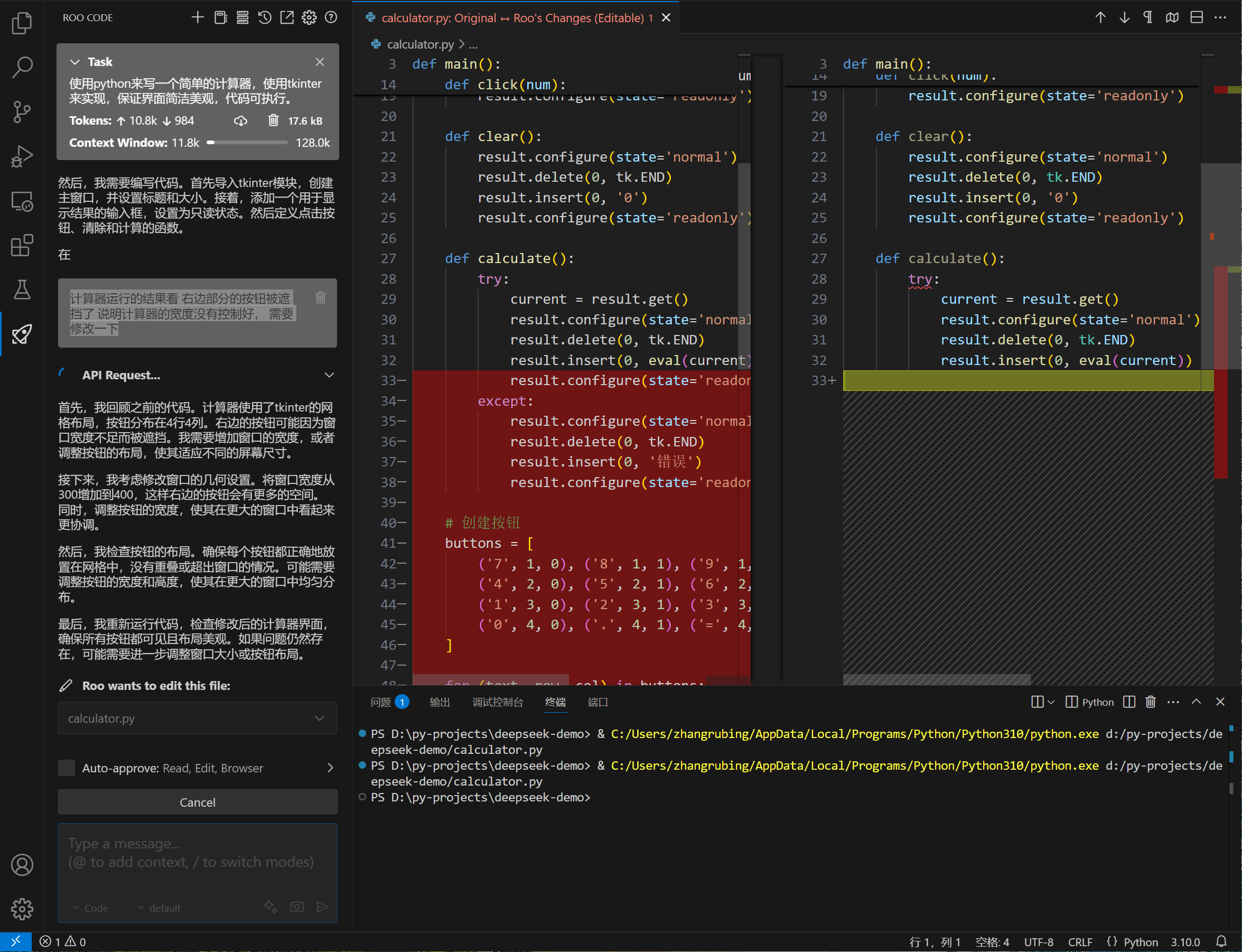

下面以VSCode 的方式介绍api的接入方式,是怎样提高开发效率的。

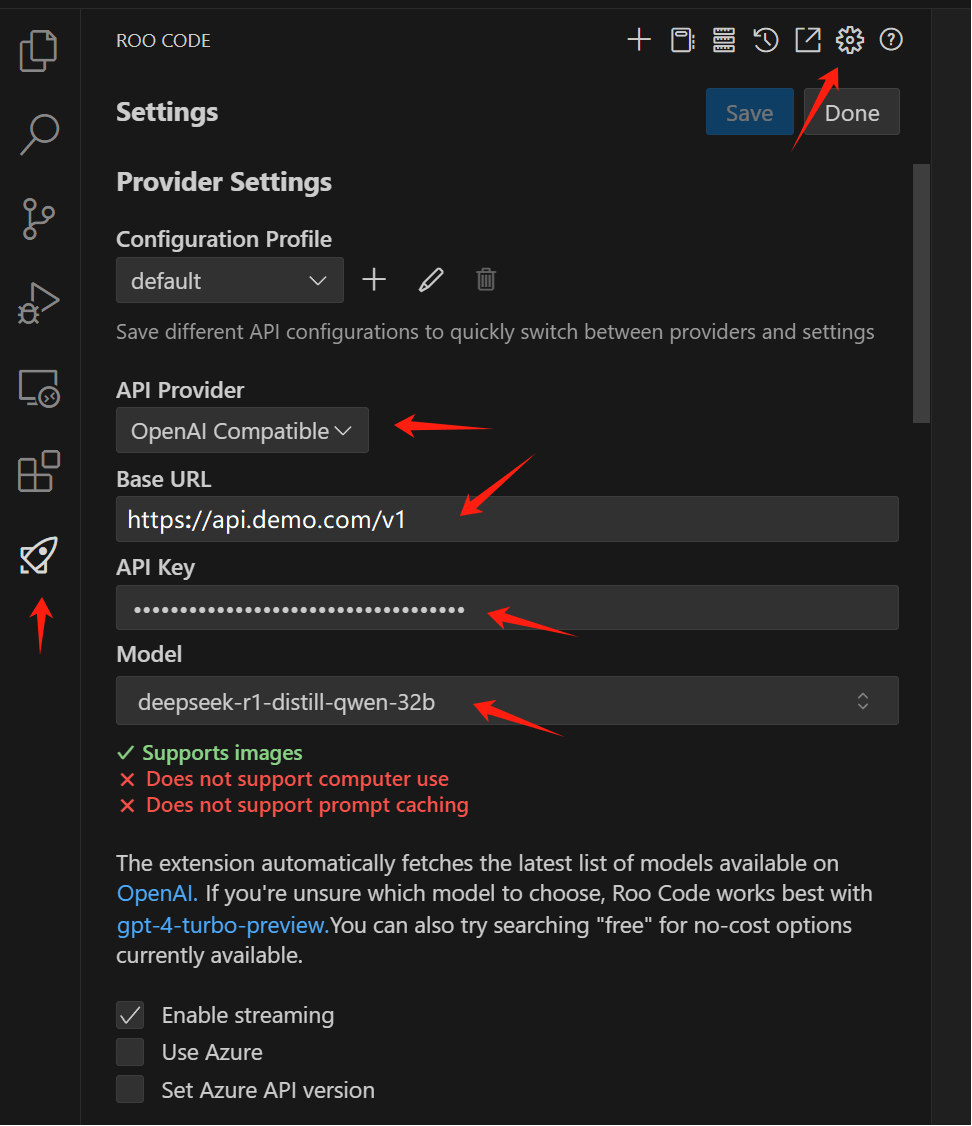

约定api提供的服务地址为: https://api.demo.com 获取到的API-KEY: ******

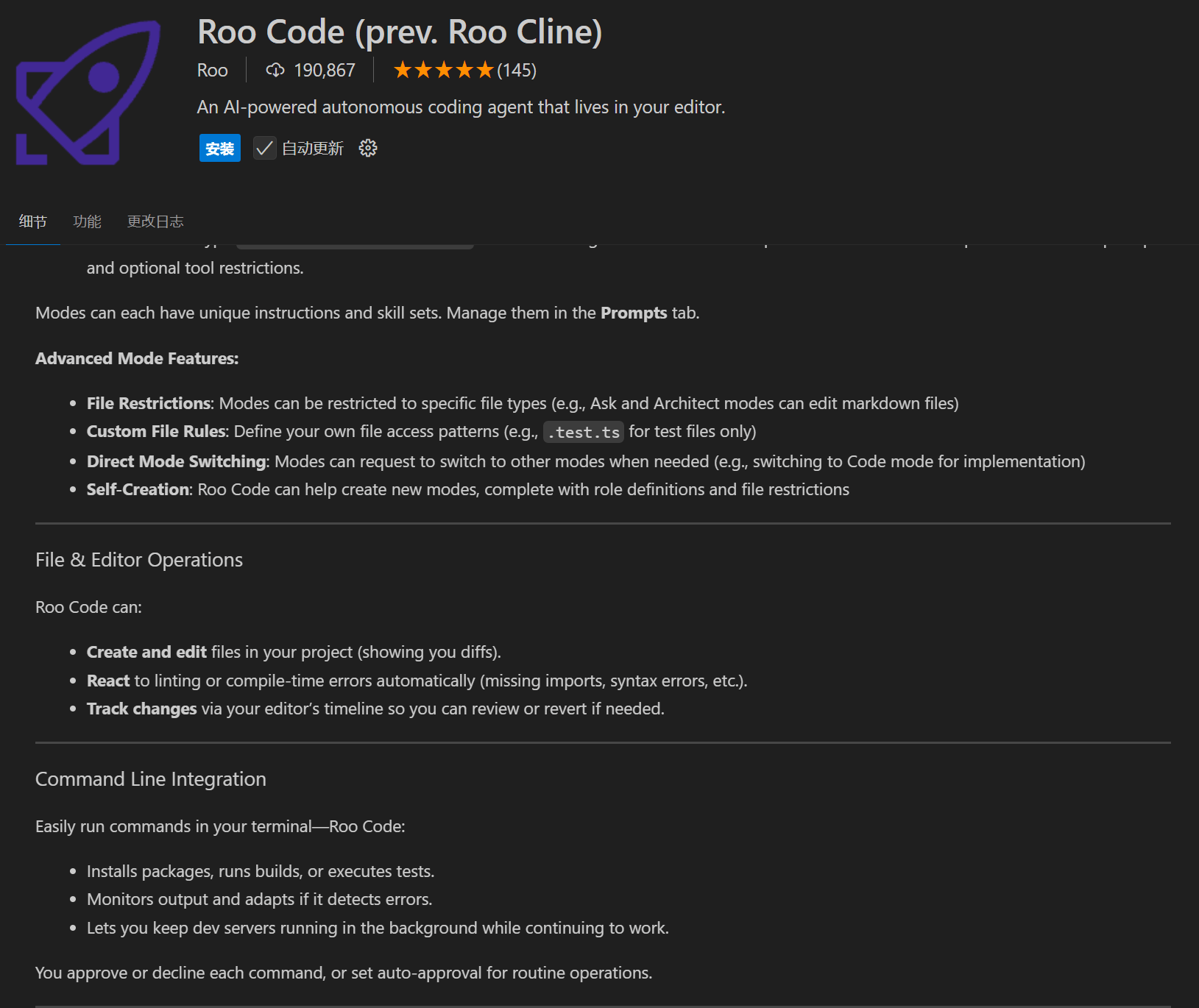

1.在VS Code中按装插件 Roo Code

打开VS Code 的扩展页面 搜索"Roo Code" 然后看到如下界面,就是Roo Code了。

2. 点击"安装"就可以完成安装了

3. 配置Roo Code的AI服务

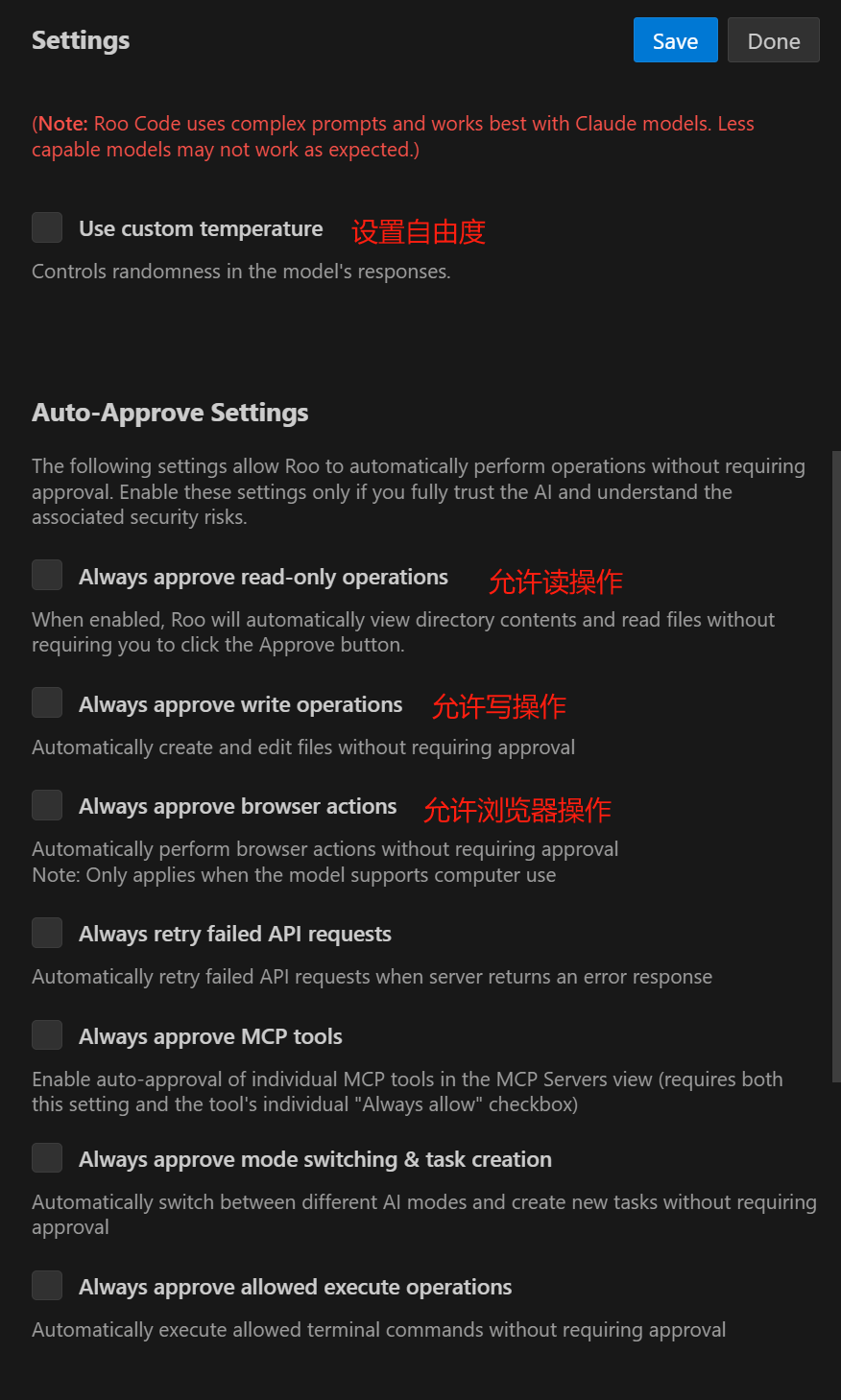

可以根据需求设置模型相关的参数,以及系统权限配置。

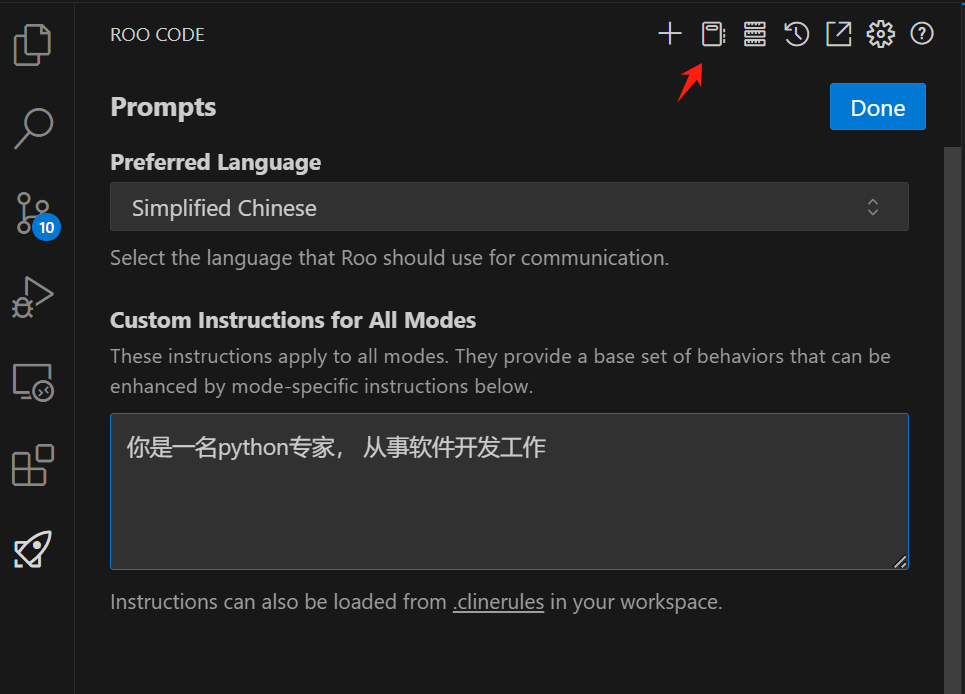

其他主要设置还包括对话语言设置-选择中文,系统prompt设置,给它一个默认身份,比如Python专家。

使用DeepSeek-R1模型进行对话式开发

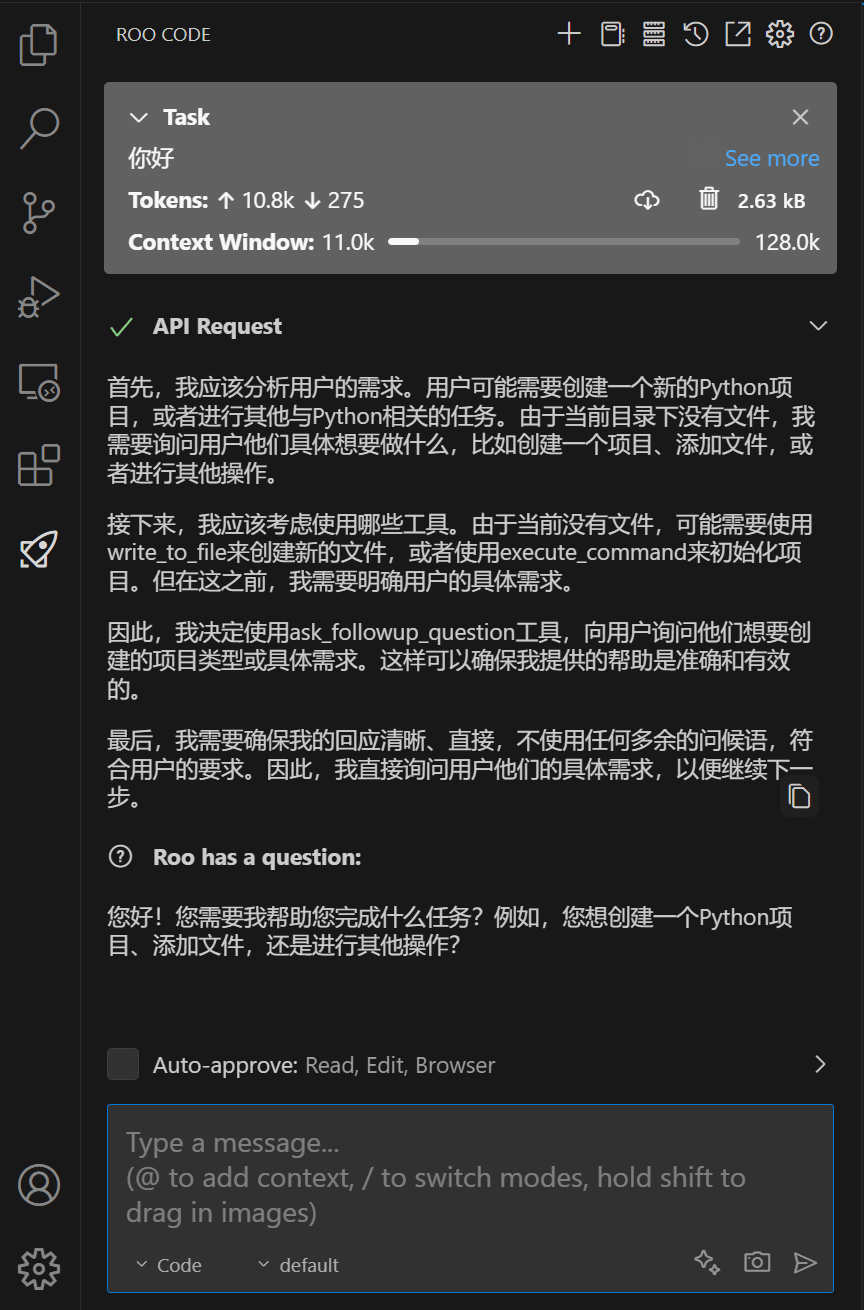

配置好后,就可以直接和DeepSeek对话来编程了

验证服务是否可以使用, 输入"你好" 然后回车,看到如下图有信息回复说明服务是好的。

咱们让DeepSeek写一个简单的计算器,使用Python来实现。

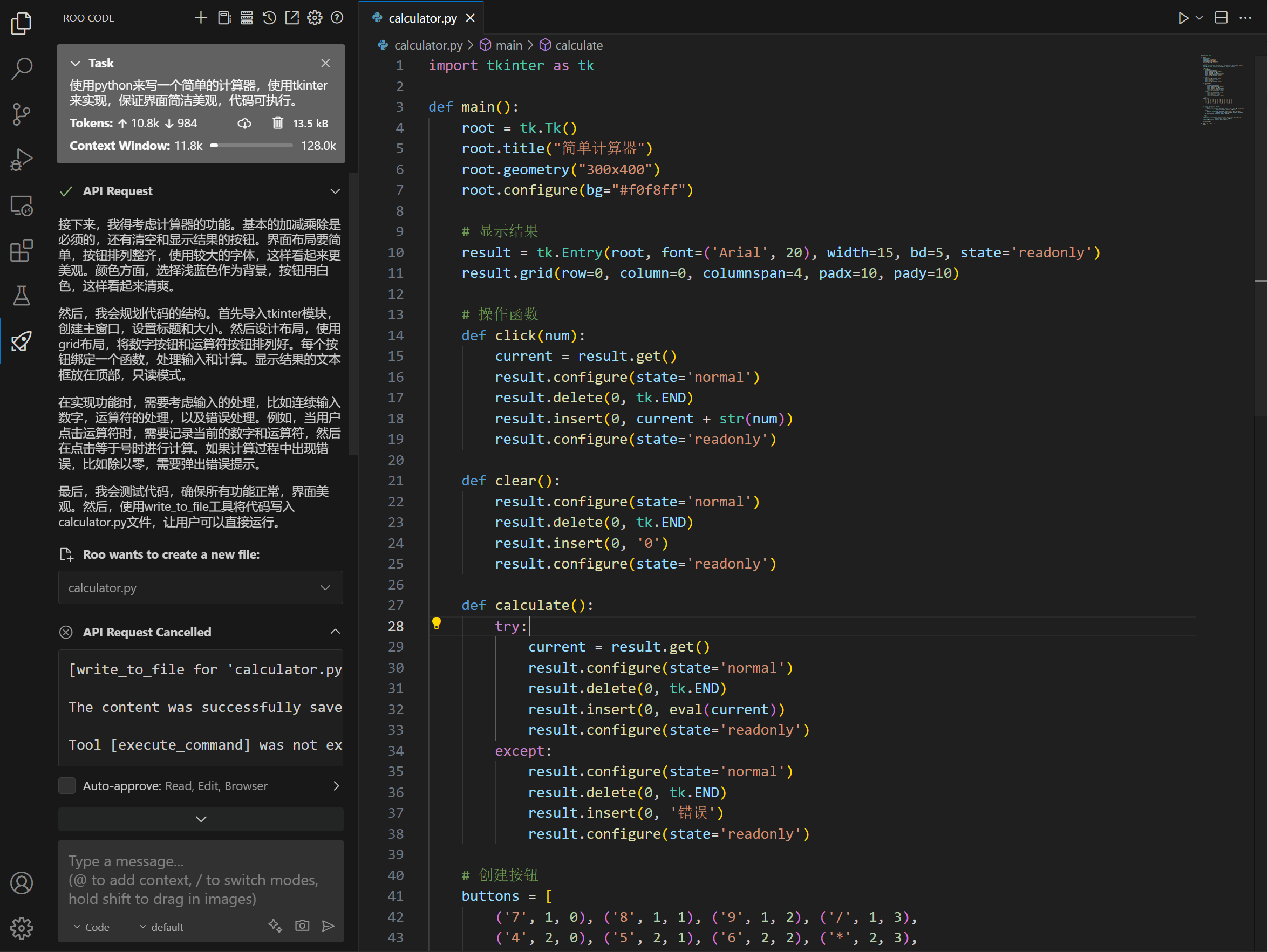

在对话框中输入"使用python来写一个简单的计算器,使用tkinter来实现,保证界面简洁美观,代码可执行。"

ROO CODE生成的代码可以直接执行,并且没有报错,计算器界面如下:

这个时候界面有部分按钮被遮挡了,继续对话修改。

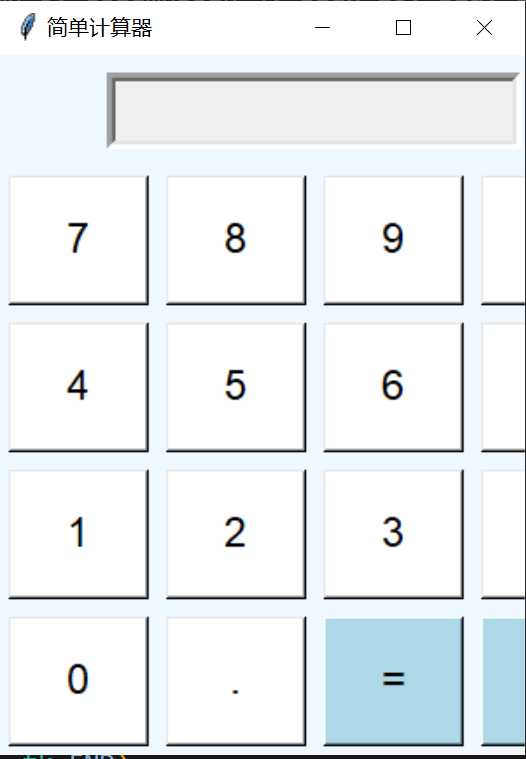

输入"计算器运行的结果看 右边部分的按钮被遮挡了 说明计算器的宽度没有控制好, 需要修改一下"

正在自动修改代码

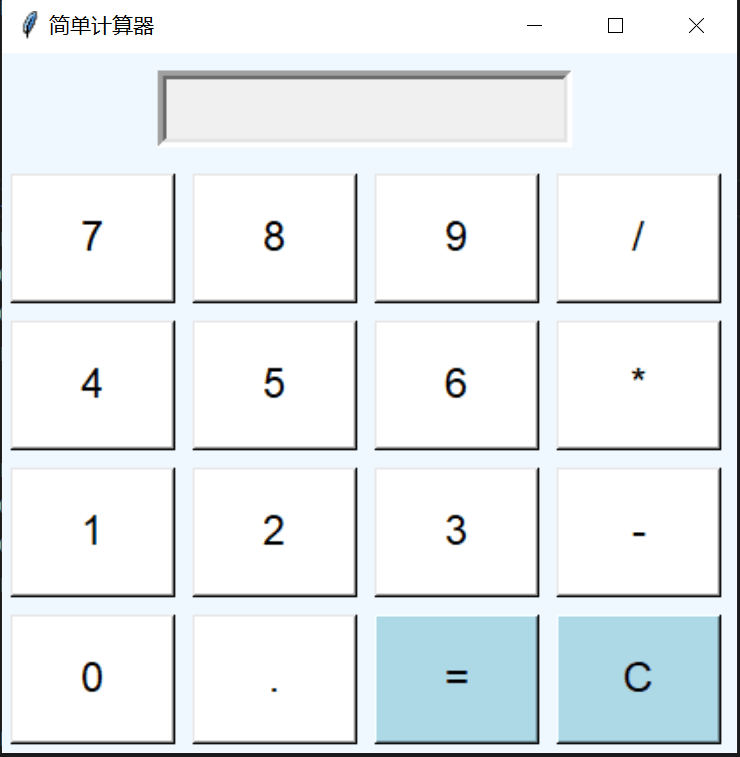

修改后的界面

目前,这种对话式编程方式让 AI 深度参与开发过程,相比传统的编码方式,能够显著提升开发效率和代码质量,带来前所未有的生产力提升。

如果您对这一方案感兴趣,欢迎联系我们,获取更多详情和定制化解决方案。

47

47

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?