点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

丰色 发自 凹非寺

转载自:量子位(QbitAI)

“现在引用最多的几个神经网络都是建立在我的实验室成果之上的!”

能说出此话的不是别人,正是在深度学习领域作出了巨大贡献的LSTM之父——Jürgen Schmidhube。

但这也不是他第一次为“自己的开创性工作没得到足够的尊重”而公开发声。

在这篇“直抒胸臆”的推文里,他还专门链出了个博客,里面历数了他和他的团队在LSTM、ResNet、AlexNet和VGG、GAN以及Transformer变体——这五个赫赫有名的神经网络上的早期贡献。

来看看他是怎么说的。

“五大神经网络都是建立在我的实验室成果之上”

首先是LSTM (Long Short-Term Memory)。这是Jürgen和他的学生们在1997年提出的一种新的RNN,解决了神经网络长短期记忆的难题。

根据谷歌学术,这是20世纪被引用次数最多的神经网络。

现在已经“渗透”进医疗保健、学习机器人(learning robot)、游戏、语音处理、机器翻译等领域,每天被无数人使用数十亿次。

其厉害之处不用多说,大家对Jürgen的这项成就也没啥异议。主要看另外四个:

ResNet

作为21世纪被引用次数最多的神经网络,Jürgen说它引用了他们的Highway Net、然后把它做成了另一个版本。

Highway Net,是他的学生们发明的第一个具有100多层的真正的深度前馈神经网络。

它用跳层连接解决了非常深度的神经网络的训练,其性能也与ImageNet上的ResNet差不多。

这俩的争议很多人都有分析过,虽然两者都用了跳层连接技术,但选择的机制不同;多数人认为ResNet应该只是受到了Highway Net的启发。

但Jürgen不这么认为,他还专门强调了一下,Highway Net也是基于LSTM的思想才得以解决深度训练的问题的。意思是ResNet“一脉相承”了他两个成果。

AlexNet和VGG Net

对于这俩在引用次数排第二、第三的神经网络,Jürgen表示:都类似DanNet——他们在2011年提出的第一个赢得图像识别比赛的深度卷积神经网络,并且DanNet在AlexNet出现之前赢了4场。

因为2012年出生的AlexNet论文中引用了DanNet,用到了Jürgen团队提出的摒弃无监督预训练为纯监督学习的DNN思想。

而VGG则是同样采用了DanNet使用小卷积滤波器增加神经网络深度的track。

GAN

博文中写道,大名鼎鼎的GAN也是Jürgen本人在1990年提出的Adversarial Curiosity原则的应用,它们都由两个神经网络进行“对抗”(Adversarial Curiosity则是一个叫生成器,一个叫预测器)。

“炮轰”GAN可不是第一次了,Jürgen甚至还公开和GAN的提出者battle过,但很多学者分析,GAN并不能视为Adversarial Curiosity的一个简单变种。

Transformer

最后一个是Transformer,如今风靡的Transformer又和Jürgen有什么关系呢?

Jürgen说,Transformer的变体-线性Transformer,在形式上相当与他于1991年提出的快速权重存储系统(Fast Weight Programmers)的延伸(除了标准化部分)。

真的是这样的吗?

不得不说,Jürgen的某些思想非常超前,但其实上面的这些内容都不是Jürgen第一次公开说明了。

一如既往,网友们的回应褒贬不一。

追捧他的表示:

“这是Schmidhuber的世界,我们凡人只是居住在其中!”

“Schmidhuber is all you need.”

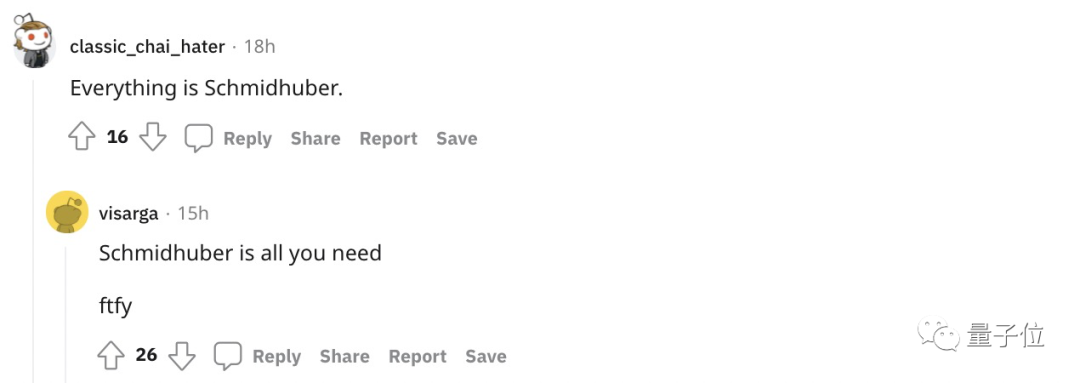

但更多的人都是在承认他巨大贡献的同时,指出他过于美化自己的贡献,想把这二三十年所有相关的进步都归功于他。

就像博文中提到的ResNets,许多人的观点认为它只是HighwayNets中一个非常微不足道的延伸;

而Transformer则是在发展壮大了三年之后才被Jürgen联系到了Fast Weight Programmers身上;(如果真的那么相关,怎么一开始不指出来)

上面提到的种种几乎和他的团队成就没啥关系,没有他的那些论文,那些模型照样会被提出来。

而他最重要的两个贡献是:用LSTM思想解决RNN训练难题以及梯度消失难题的理论分析。但这都还主要是他的学生Hochreiter领导的。

因此有人觉得Jürgen这种行为简直就像个孩子一直在说“看我,我是最棒的”一样:

甚有直言:“他的自负大于他的引用次数”。

你觉得呢?

参考链接:[1]https://www.reddit.com/r/MachineLearning/comments/pk69xy/d_schmidhuber_the_most_cited_neural_networks_all/

[2]https://twitter.com/SchmidhuberAI/status/1435499479306809346

[3]https://people.idsia.ch/~juergen/most-cited-neural-nets.html

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的两篇Transformer综述PDF

重磅!Transformer交流群成立

扫码添加CVer助手,可申请加入CVer-Transformer微信交流群,方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加小助手微信,进交流群

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看![]()

989

989

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?