点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信:CVer5555,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

论文名:Unveiling Parts Beyond Objects: Towards Finer-Granularity Referring Expression Segmentation

论文链接:https://arxiv.org/pdf/2312.08007.pdf

开源代码:https://github.com/Rubics-Xuan/MRES

引言

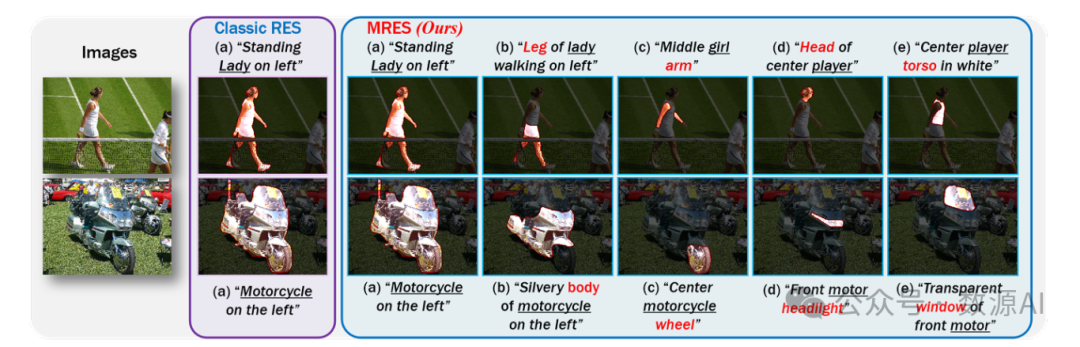

作为视觉-语言理解中最具挑战性的任务之一,指 代表达分割(ReferringExpression Segmentation,RES) 旨在基于描述性语言表达在像素级别上定位特定区 域。与传统的仅关注图像或视频的视觉分割任务相比, RES由于需要跨模态进行强大的理解而面临更大的困 难和挑战,但它可以同时缓解传统对象检测或分割中 预定义类别的问题。由于现实世界场景通常需要多样 性的目标识别,RES任务在应用方面具有巨大潜力,例 如基于语言的人-物互动和交互式图像编辑。

简介

在本文中,我们进一步迈向更精细 的部分级RES任务。为了促进面向更精细视觉-语言理 解的对象级RES任务,我们提出了一个新的多粒度指 代表达分割(MRES)任务,并通过手动注释构建了 一个名为RefCOCOm的评估基准。通过利用我们的自动模型辅助数据引擎,我们构建了最大的视觉定位数据集,即MRES-32M,其中包括超过32.2M个高质量的蒙版和标题,涵盖了提供的1M张图像。此外,设计了 一个简单但强大的模型UniRES来完成统一的对象级和部分级定位任务。对我们的RefCOCOm进行的大量实 验,以及对经典RES任务的三个数据集(即,RefCOCO (+/g))的实验表明,我们的方法优于先前的最先进方法。

Multi-Granularity Grounding Dataset

01

Data Collection Engine

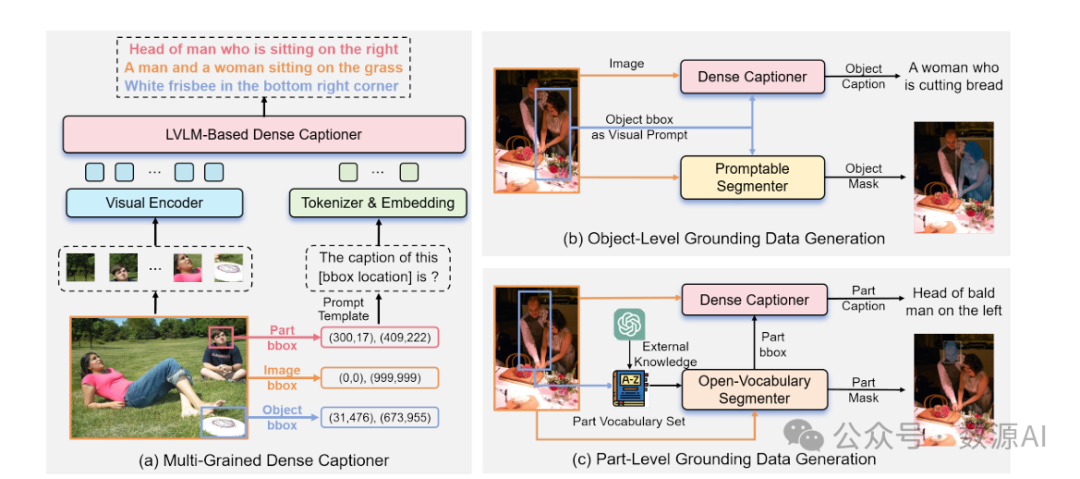

考虑到经典的指代表达分割任务的内在复杂性, 相关的训练数据需要在文本和视觉领域进行广泛的注 释成本。当粒度提升到部分级别时,注释的复杂性进 一步加剧。我们认为,阻碍开放世界基础的主要瓶颈 是当前数据可扩展性所施加的限制。通过利用强大的 基础模型进行协同增强,我们引入了一个先进的数据 引擎,能够自动生成可靠的视觉基础数据。

(1)多粒度密集字幕生成器。

对 于图像粒度,我们使用COCO数据集,其中所有 边界框都统一表示为(0,0),(999,999)。对于对象粒 度,我们利用Visual Genome数据集。对于部分粒 度,我们利用单模态语义分割数据,并采 用PartNameX of ObjectNameY形式的模板构建密 集字幕。这种统一的多任务训练方法可以在不同粒度 之间协同增强:它允许LVLMs融合更全面和详细的信 息以增强部分粒度描述。同时,部分粒度的知识有助 于LVLMs在对象内部推广知识。

(2)模型辅助数据生成。

为了生成基于对象级别的视觉 定位数据,我们利用大规模对象检测数据集Object365提供高度可靠的边界框。此外,其中丰富的类别标签确保了全面的知识覆盖。如图(b)所示,这些 边界框将作为视觉提示,分别被发送到可提示分割器 (即segment anything model)和我们的密集字幕生 成器中,以获取分割掩模和详细的语义描述。

(3)数据过滤。

在完成所有图像的多粒度注释后,我们进 一步引入CLIP 进行过滤。从原始图像中裁剪出边 界框,然后将其与密集字幕一起发送到编码器中以测 量相似度。为了在很大程度上确保视觉和语言注释的 一致性,我们保留相似度大于0.5的框-字幕对作为最终 的注释结果。

02

MRES-32M Dataset Details

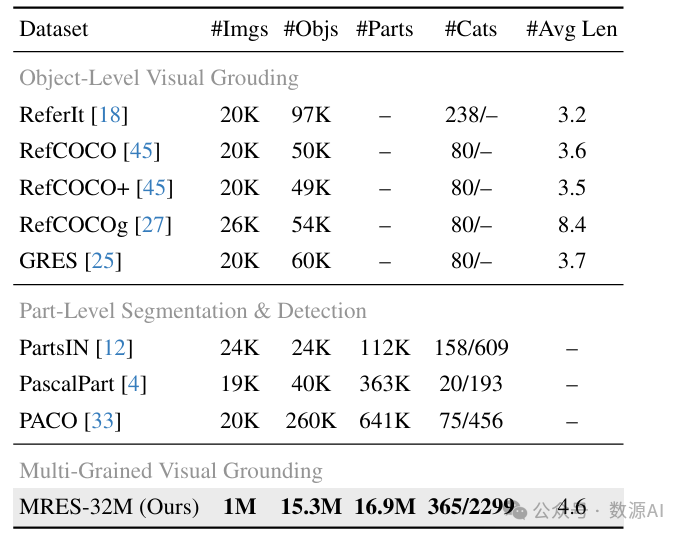

总的来说,我们将提出的MRES-32M与现有数据 集进行比较,并在表2中列出我们数据集的一些独特 和显著属性。

(1)统一的多粒度。与接地对应物相比,我们的MRES 32M是第一个涵盖部分和对象粒度的视觉接地数据集。与部分级别分割对应物相比,我们的MRES-32M为每 个部分掩模提供了信息丰富且独特的细粒度描述。

(2)更多样化的类别。我们的MRES-32M由365个对象类别 和相关的2,299个部分类别组成。与现有数据集相比, 它涵盖了更广泛的多模态知识范围,是朝着开放世界 理解的重要一步。

(3)可拆分的数据规模。据我们所知,MRES-32M是当前 接地研究社区中最大的数据集。就图像数量和对象实 例数量而言,它分别超过了最大的现有视觉接地数据 集RefCOCOg [27] 38倍和283倍。同时,它包含的部分 实例计数超过了最大的现有部分语义分割数据集[33] 的58倍。

(4) 更复杂的指代。受益于我们基于LVLM的密集描述生 成器,MRES-32M的指代可以更充分地与视觉上下文 相结合,用于实体(即部分和对象)描述。不拘泥于 特定模板,实体的关系和属性可以在自由自然语言表 达中突出显示。

方法与模型

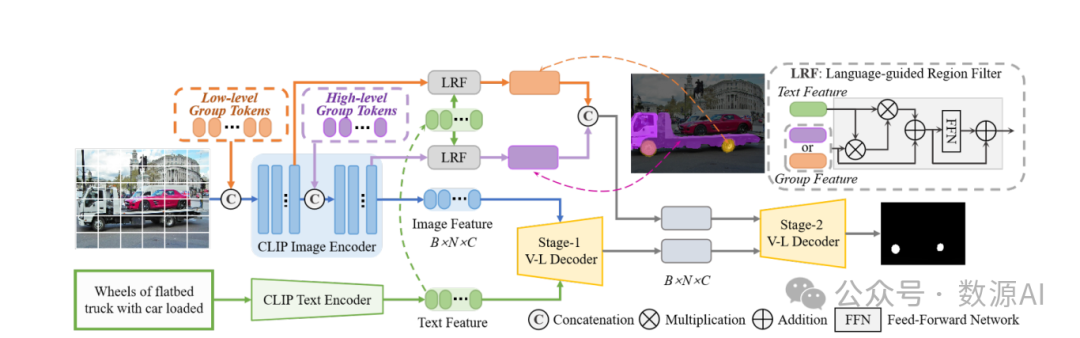

多粒度RES模 型UniRES,用于统一的MRES任务,其中涉及到对象 和部分粒度的参考目标。由于我们最初的意图是为提 出的多粒度RES任务建立一个简单易懂的基准模型,我 们的UniRES模型的结构被设计为简单清晰。

UniRES有三个主要组件:

(1)视觉-语言骨干网络。

考虑到捕捉视觉-语言特征表 示的强大能力和可扩展性的要求,我们利用CLIP模 型[32]的CLIP预训练权重,该模型从大量的图像-文本 对中学习可转移的视觉和语言概念,并将其作为我们 的参考分割框架的骨干。我们利用CLIP中的图像和文 本编码器(即VisionTransformer (ViT) [8]和Transformer [39])来有效提取视觉和语言特征。

(2)基于查询的分组设计。

为了有效完成提出的MRES任 务,必须利用低级局部和高级全局视觉特征。为了增 强CLIP骨干的局部-全局视觉表示,而不引入太多额外 的参数或改变模型的结构,我们在CLIP视觉骨干的第 一层和中间层中分别加入了64个和8个可学习的标记 (经验设置)。这些可学习的标记遍布视觉骨干的前半 部分和后半部分。我们期望ViT的内部自注意机制隐式 地执行视觉分组的方式,同时获取捕捉低级局部和高 级全局特征的代表性分组标记。基于局部特征更加分 散的事实,附加的低级分组标记的数量大于高级分组标记的数量。然后,来自两个级别的分组标记被输入 到一个语言引导的区域过滤器(LRF)中,通过交叉注 意机制选择与语言相关的视觉特征,然后进行串联以 融合这些与表达相关的视觉分组标记,用于后续的视 觉-语言解码。

(3)两阶段V-L解码器。

现在,从骨干网络中获取了视觉和 文本特征表示,以及具有两个不同级别的与表达相关 的分组标记,我们使用由堆叠的Transformer层组成的 两阶段掩码解码器来生成分割掩码。具体而言,第一 阶段的V-L解码器将提取的视觉和文本特征作为输入, 并生成第一阶段融合的多模态表示。随后,这些多模 态特征进一步与两个语义级别(即低级和高级)的分 组表达相关区域特征进行集成,以实现进一步的特征 增强,然后通过线性投影层获得最终的分割掩码。

实验与结果

为了评估我们方法的有效性,我们在三 个经典的RES数据集(即RefCOCO, RefCOCO+, RefCOCOg)以及我们的多粒度RES基准RefCOCOm上 进行了全面的实验。

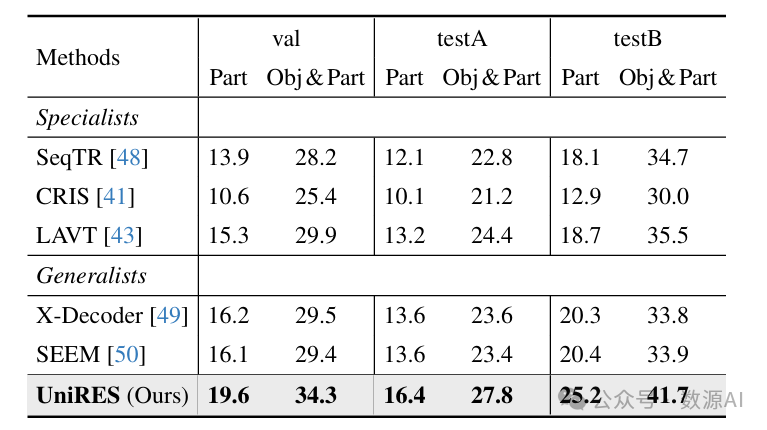

在我们的RefCOCOm基准测试中,以mIoU为指标与 之前的最佳方法进行比较。

与先进方法在之前三个经典的RES基准数据集上进行比较

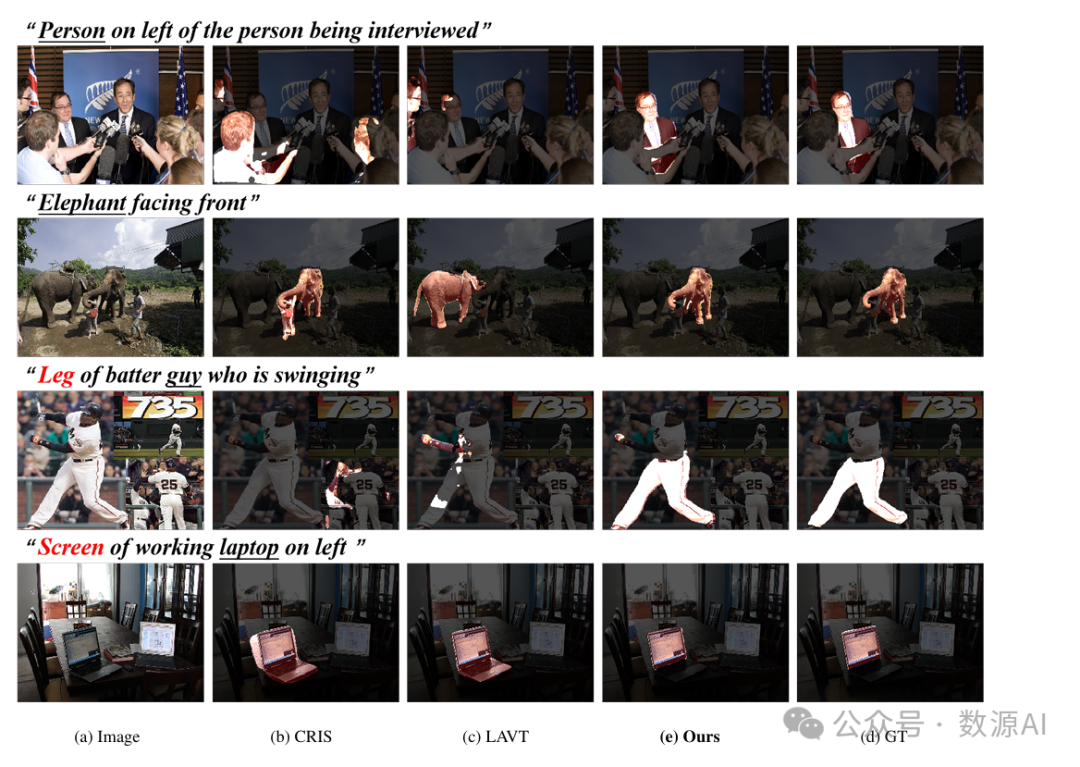

我们在RefCOCOm验证集上进行的分割结果的视觉比较

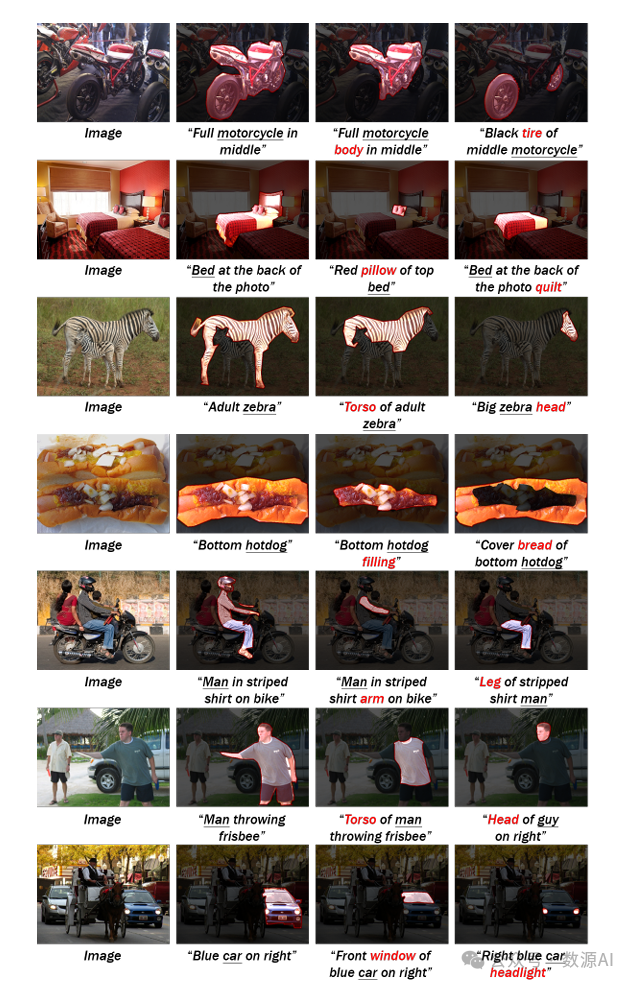

多粒度RES任务的RefCOCOm基准的更多选定样本

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba和图像分割交流群成立

扫描下方二维码,或者添加微信:CVer5555,即可添加CVer小助手微信,便可申请加入CVer-Mamba和图像分割微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba或者图像分割+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer5555,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集近万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看

5191

5191

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?