点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信:CVer5555,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

白交 发自 凹非寺

转载自:量子位(QbitAI)

目标检测领域,迎来了新进展——

Grounding DINO 1.5,IDEA研究院团队出品,在端侧就可实现实时识别。

这一进展获得AI大佬沈向洋转发,他一般都是一年一转的节奏。

此次发布主要有两个版本:Pro和Edge。Pro版更强,Edge版更快。

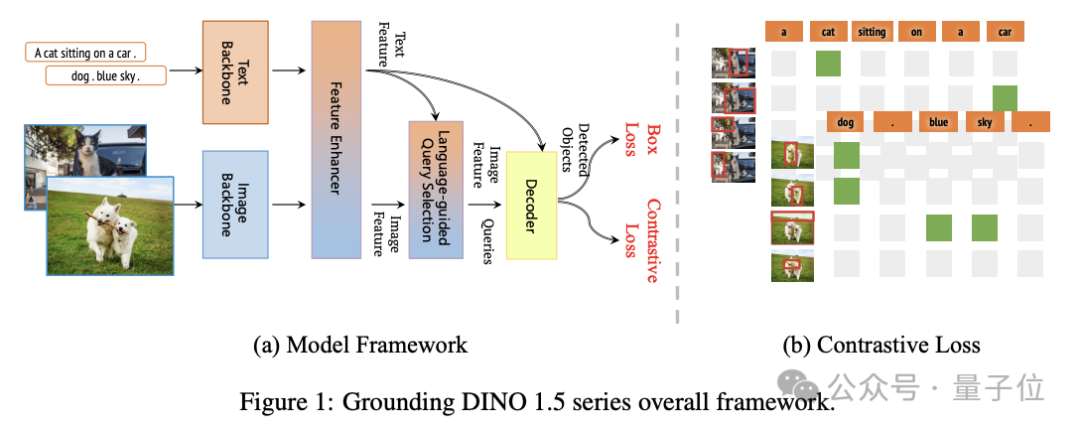

它仍然保留了上一个版本Grounding DINO双编码器-单解码器结构,在此基础上通过结合更大的视觉 backbone 扩大模型尺寸,并使用超过2000万的Grounding 数据获得了丰富的语料,大幅提升了检测精度和速度,且通过Pro和Edge版本分别针对不同应用场景进行了优化。

Pro版本在大规模数据集构建和高精度需求场景中表现卓越,而Edge版本则在端侧部署中展示了其独特的优势。

这就来分别看一看。

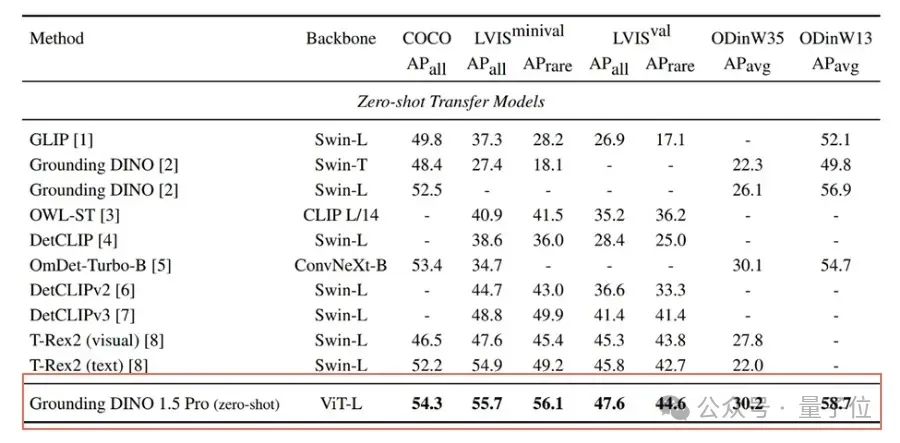

Pro版目标检测新SOTA

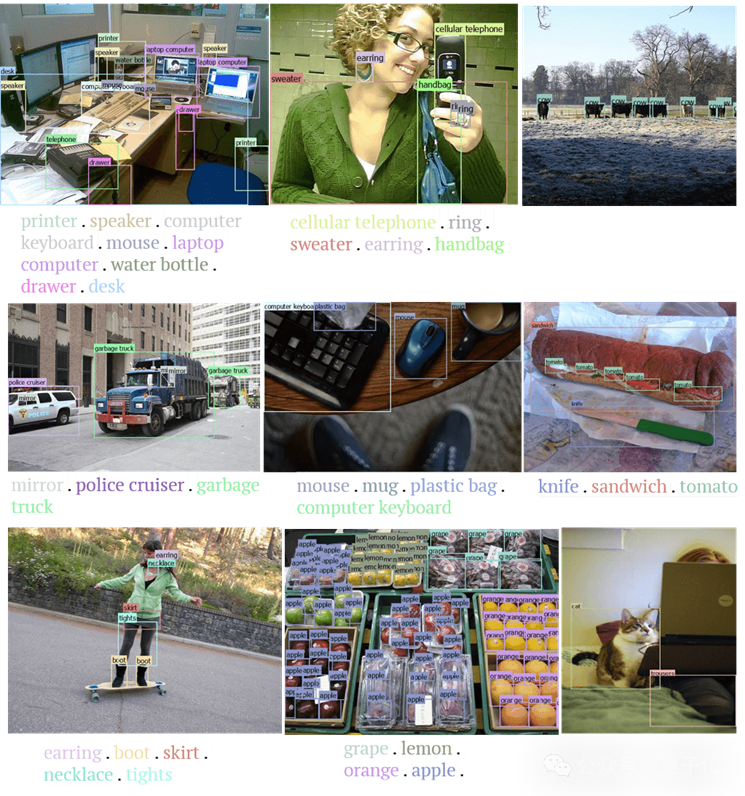

Grounding DINO 1.5 Pro版本实现了当前开集目标检测SOTA水平,在图像和文本的语义理解上表现出色,能够快速、准确地根据语言提示检测和识别图像中的目标对象。

△在COCO、LVIS、ODinW35和ODinW13基准测试中的零样本迁移性能对比

物体级别理解是机器和物理世界交互的感知基础,也是解决多模态大模型(VLM)幻觉问题绕不过去的基础问题。

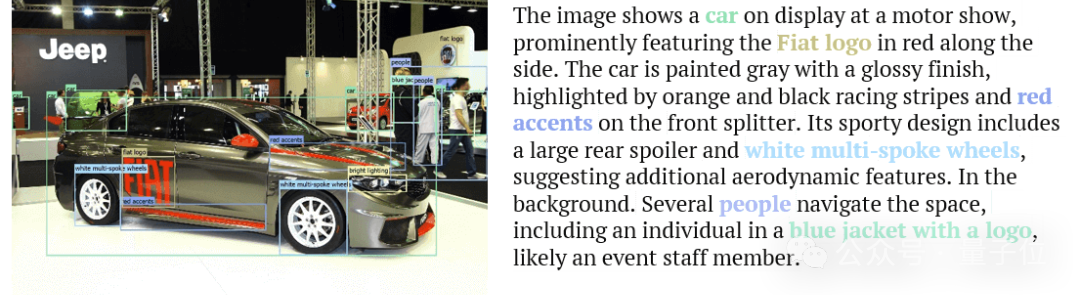

作为当前性能最好的开集检测模型,Grounding DINO 1.5 Pro 可以帮助构建海量的具有物体级别语义信息的多模态数据,从而有效地助力多模态大模型的训练。

它可以将长文本描述中的短语与图像中的具体对象或场景精确匹配,以增强AI对视觉内容和文本之间关系的理解

另外,在其他需要处理大量复杂数据的领域,如电商、社交媒体和自动驾驶等,Grounding DINO 1.5 Pro 也具有强大应用价值。

例如,在电商领域,该模型可以帮助快速标注商品图像,优化搜索和推荐系统。在社交媒体中,该模型能自动标注用户上传的图片,提升内容审核和分类的效率。

支持行业数据微调

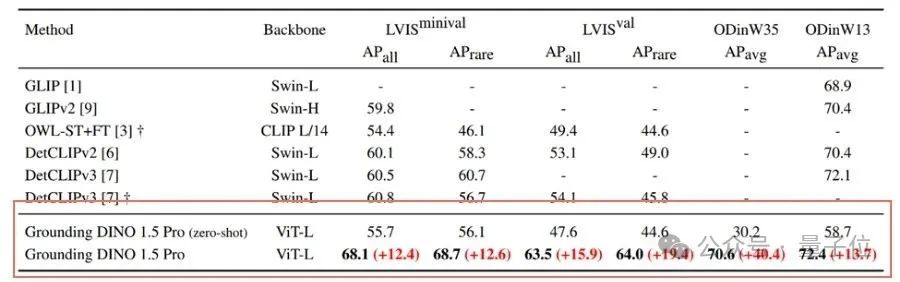

除此之外,Pro版还支持通过行业数据进行微调(fine tuning),以满足各行业的特定需求,从而达到更加精准的识别效果。

为了验证微调带来的提升,CVR团队在视觉领域通用的LVIS等公开数据集上进行了对比实验。

从最后两行可看出,Grounding DINO 1.5 Pro经过微调,在多个数据集上都展现出大幅的性能提升。

而在多个实际场景,也十分适配。

像在医疗领域,通过微调后的Grounding DINO 1.5 Pro可以更准确地识别医疗影像中的病灶,辅助医生进行诊断,提高诊疗效率。

在零售行业,微调后的模型能更精准地识别和分类商品,有助于库存管理和销售分析。

Edge版端侧可部署

在端侧部署方面,Grounding DINO 1.5 Edge版本通过模型结构优化,成功部署在NVIDIA Orin NX卡上,并实现了10FPS的推理速度。

再者,它可以让机器人和开放环境进行交互。

在自动驾驶领域,Grounding DINO 1.5 Edge未来可以在车辆上实时运行,实现高效的目标检测和环境感知,提高驾驶安全性。在智能安防中,该模型能快速处理视频监控数据,实时检测异常行为,提升安全监控的响应速度。

未来,Grounding DINO 1.5 Edge的运行速度有望提升至20到30FPS,进一步扩大其在边缘计算领域的应用范围。

论文链接:

https://arxiv.org/abs/2405.10300

项目试玩链接:

https://deepdataspace.com/playground/grounding_dino

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba和目标检测交流群成立

扫描下方二维码,或者添加微信:CVer5555,即可添加CVer小助手微信,便可申请加入CVer-Mamba和目标检测微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba和目标检测+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer5555,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集近万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看

342

342

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?