点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer2233,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

转载自:机器之心

本文的通讯作者是北京大学计算机学院长聘教授李戈。第一作者:董益宏,北京大学计算机学院 22 级博士生,曾在 ISSTA、FSE、ACL、NeurIPS、TOSEM 等 CCF-A 类 / SCI 一区国际顶级会议和期刊上发表 11 篇学术论文。

周期性现象广泛存在,深刻影响着人类社会和自然科学。作为最重要的基本特性之一,许多规律都显式或隐式地包含周期性,例如天文学中的行星运动、气象学中的季节变化、生物学中的昼夜节律、经济学中的商业周期、物理学中的电磁波以及数学运算和逻辑推理等。因此,在许多任务和场景中,人们希望对周期进行建模,以便根据以往的经验进行推理。

尽管以 MLP 和 Transformer 为代表的基础模型已经取得了显著的成功,但是它们却在周期性建模方面存在潜在的缺陷。即使面对简单的正弦函数,现有基础模型也难以理解其中的周期性规律,在外推时表现出完全失控的状态,未能有效捕捉到周期性现象的本质。

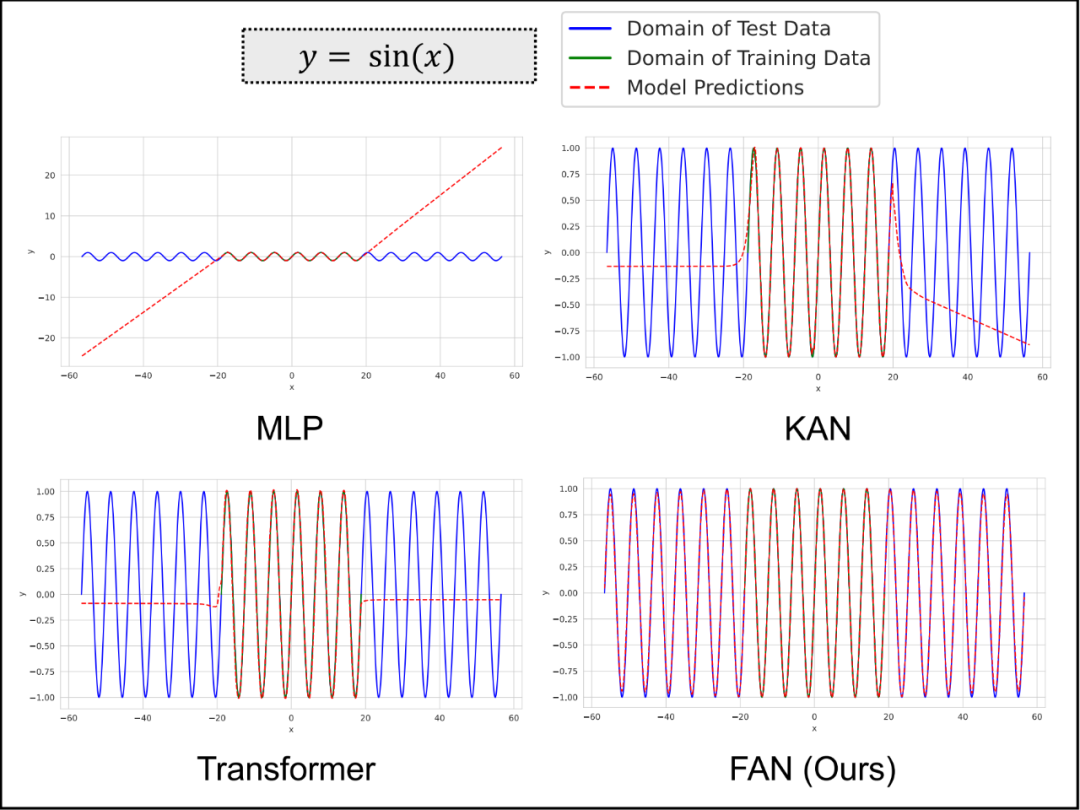

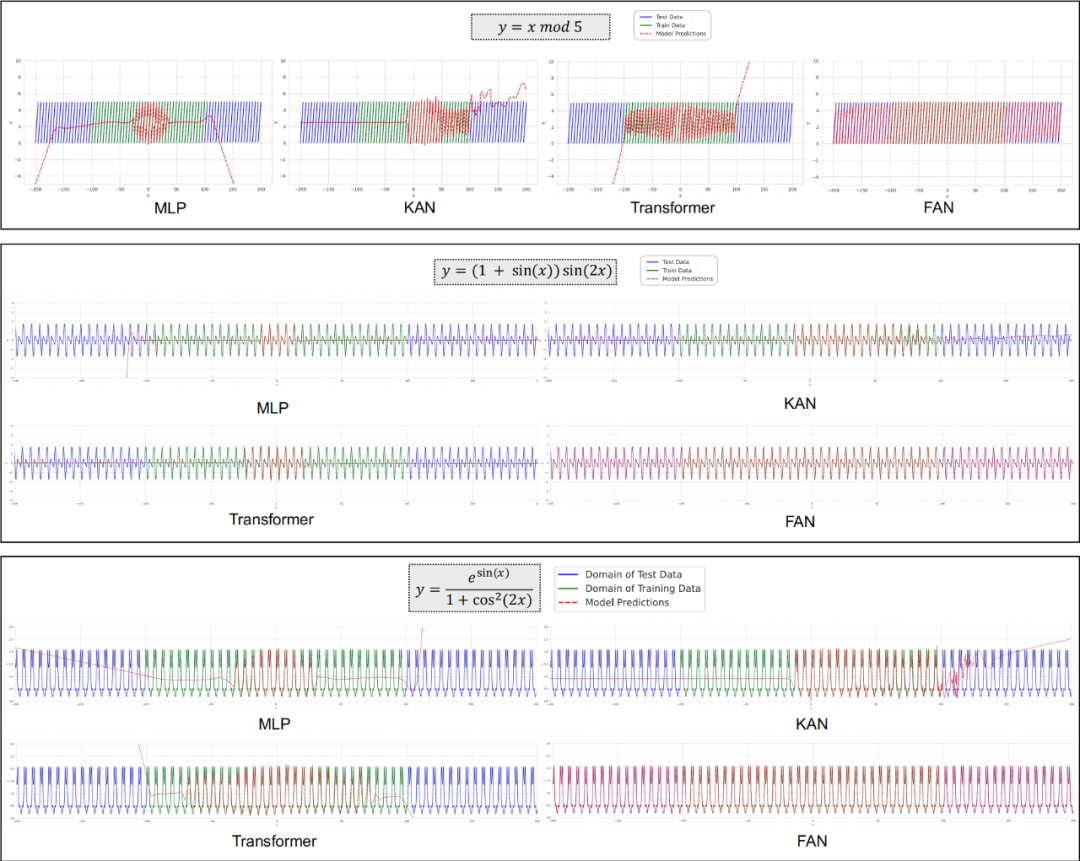

图 1:不同基础模型在其训练数据域内外对正弦函数的表现,其中 x 为标量。

为此,北京大学李戈教授的团队提出了一种新型网络架构 FAN(Fourier Analysis Networks)。通过引入傅里叶级数的思想,FAN 能够将周期性信息直接嵌入网络的结构中,使模型更自然地捕捉和理解数据中的周期性模式。

论文链接:https://arxiv.org/pdf/2410.02675.pdf

代码链接:https://github.com/YihongDong/FAN

论文标题:FAN: Fourier Analysis Networks

实验表明,FAN 不仅在周期性建模上的表现显著优于现有模型,而且在符号公式表示、时间序列预测和语言建模等实际任务中也同样表现出色,超过了 Transformer 等主流模型。

研究者认为,许多实际任务都显式或者隐式地包含潜在的周期性特征,良好的周期性建模对于提升模型在这些任务上的表现是必要的,而现有基础模型严重依赖数据驱动的优化方式,缺少明确的机制来理解数据中的根本原理。

FAN 的意义在于,它提供了一种全新的范式来有效地建模周期性,能够无缝替换传统 MLP,同时减少参数量和计算量,填补了当前基础模型在周期性建模上的缺陷,并展示出广泛的应用潜力。

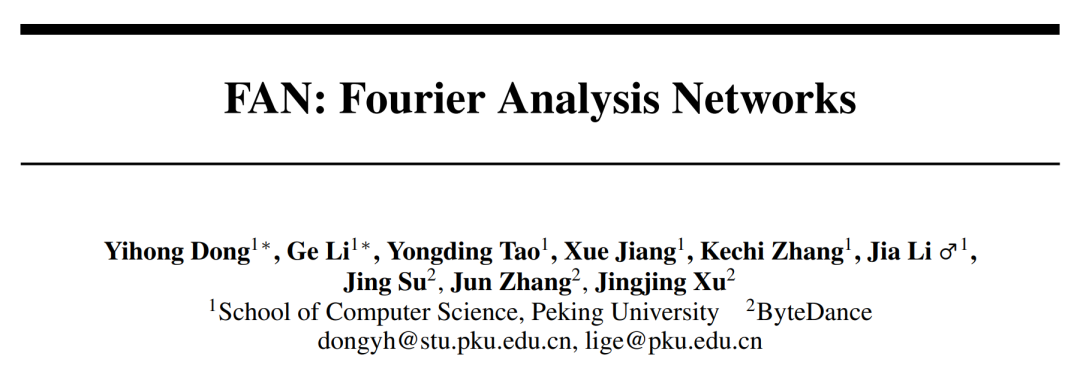

图 2:MLP Layer 和 FAN Layer 的示例。

FAN 的实现细节

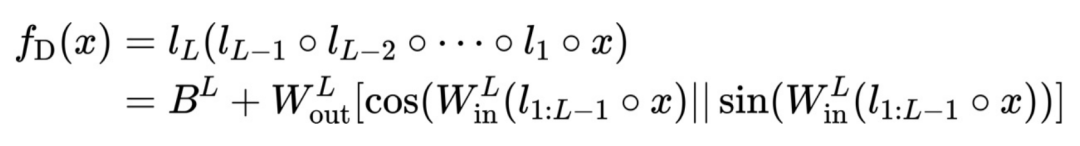

北大研究团队首先构建一个简单神经网络来建模傅里叶级数,然后在此基础上设计了 FAN 网络架构。

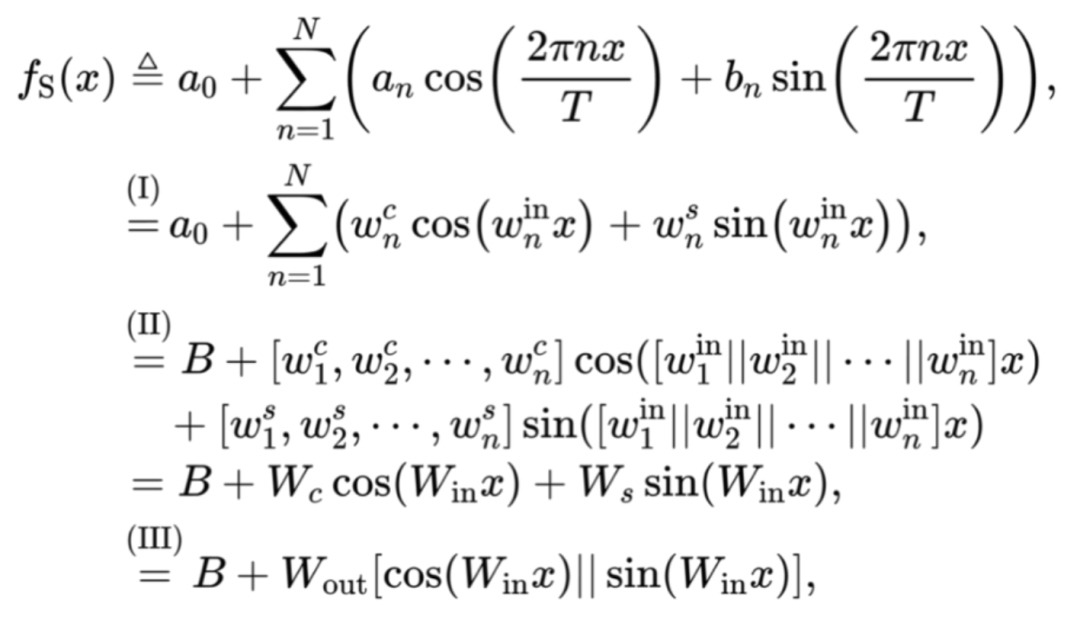

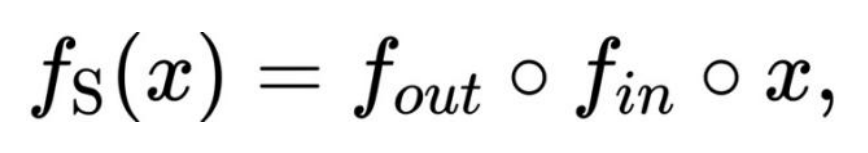

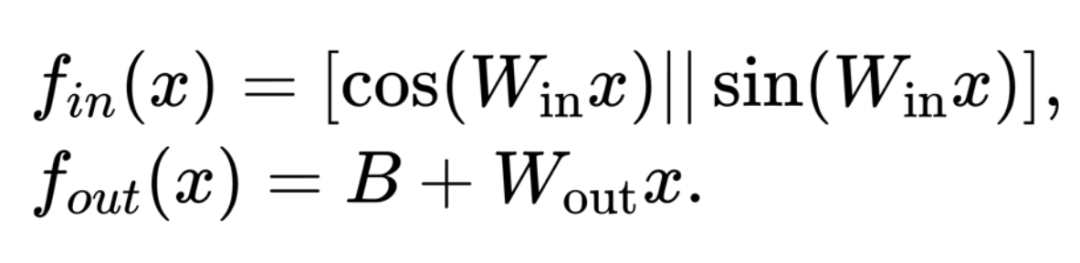

为构建一个简单的神经网络 表示函数的傅里叶级数展开,我们可以将

表示函数的傅里叶级数展开,我们可以将 表示为:

表示为:

其中 是可学习参数,(I) 根据

是可学习参数,(I) 根据 和

和 通过定积分计算,(II) 和 (III) 是矩阵运算的等价形式,[・||・] 和 [・,・] 分别表示沿第一维度和第二维度的连接。为了充分利用深度学习的优势,我们可以堆叠上述网络

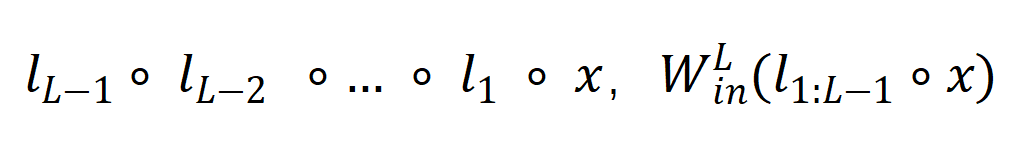

通过定积分计算,(II) 和 (III) 是矩阵运算的等价形式,[・||・] 和 [・,・] 分别表示沿第一维度和第二维度的连接。为了充分利用深度学习的优势,我们可以堆叠上述网络 形成深度神经网络

形成深度神经网络 ,其中第 i 层表示为

,其中第 i 层表示为 。因此,

。因此,  可以表示为:

可以表示为:

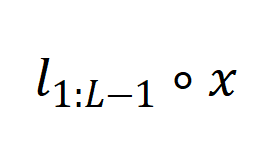

其中 表示左侧函数

表示左侧函数 作用于右侧输入

作用于右侧输入 ,即

,即 。然而,我们发现直接堆叠

。然而,我们发现直接堆叠 会导致模型

会导致模型 的主要参数集中于学习角频率 (

的主要参数集中于学习角频率 ( ),从而忽略了傅里叶系数 (

),从而忽略了傅里叶系数 ( 和

和 ) 的学习,如下所示:

) 的学习,如下所示:

其中 定义为

定义为 ,

, 用于近似角频率,

用于近似角频率, 用于近似傅里叶系数。因此,拟合傅里叶系数的能力与的深度无关,这是一个不理想的结果。

用于近似傅里叶系数。因此,拟合傅里叶系数的能力与的深度无关,这是一个不理想的结果。

为了应对这一问题,研究团队根据以下原则设计了 FAN:1) FAN 表示傅里叶系数的能力应与其深度正相关;2) 任何隐藏层的输出都可以通过后续层使用傅里叶级数来建模周期性。第一个原则通过利用 FAN 的深度增强了其周期性建模的表现力,而第二个原则确保 FAN 中间层的特征可用于执行周期性建模。

假设我们将 解耦为:

解耦为:

其中

为了满足这两个原则,FAN 的中间层输入需要同时使用 和

和 而不是依次应用它们。

而不是依次应用它们。

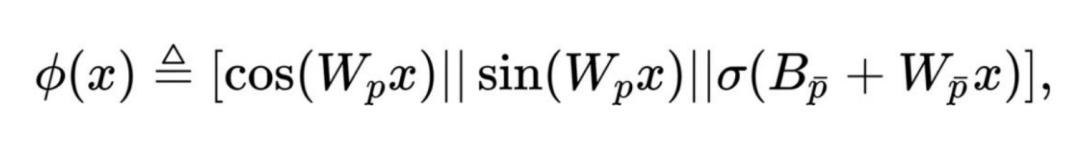

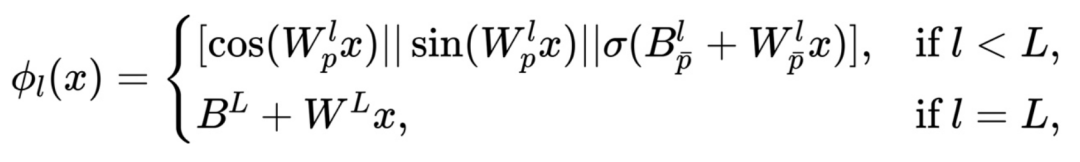

最终,FAN 基于此设计,其 FAN 层 定义如下:

定义如下:

其中 是可学习参数,

是可学习参数, 表示激活函数。

表示激活函数。

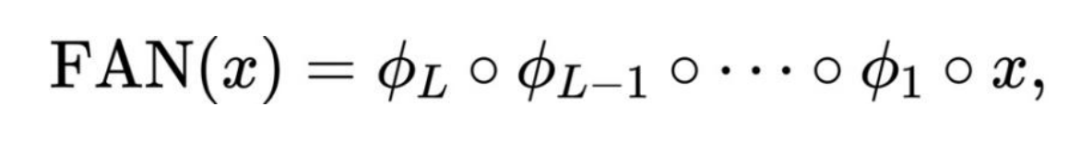

整个 FAN 定义为 FAN Layer 的堆叠:

的堆叠:

其中

FAN 的性能表现

1. 周期建模

下图 3 展示了 FAN 和其他模型在周期性建模中的表现。结果表明,现有的神经网络(包括 MLP、KAN 和 Transformers)在建模周期性方面表现出明显的不足。尽管它们试图拟合这些周期函数,但其内在能力限制了它们在大范围周期性上的性能表现。相比之下,FAN 在所有这些周期性建模任务中都明显优于基线。更值得一提的是,FAN 在训练数据域内和域外的测试数据上都表现得非常出色,表明它能够真正理解周期性的深刻原理并对其进行精准建模,而不仅仅是记住训练数据。

图 3 FAN 在周期性建模中的表现与 MLP、KAN 和 Transformer 相比,其中绿线表示训练数据域内的测试数据,而蓝线表示训练数据域外的测试数据。

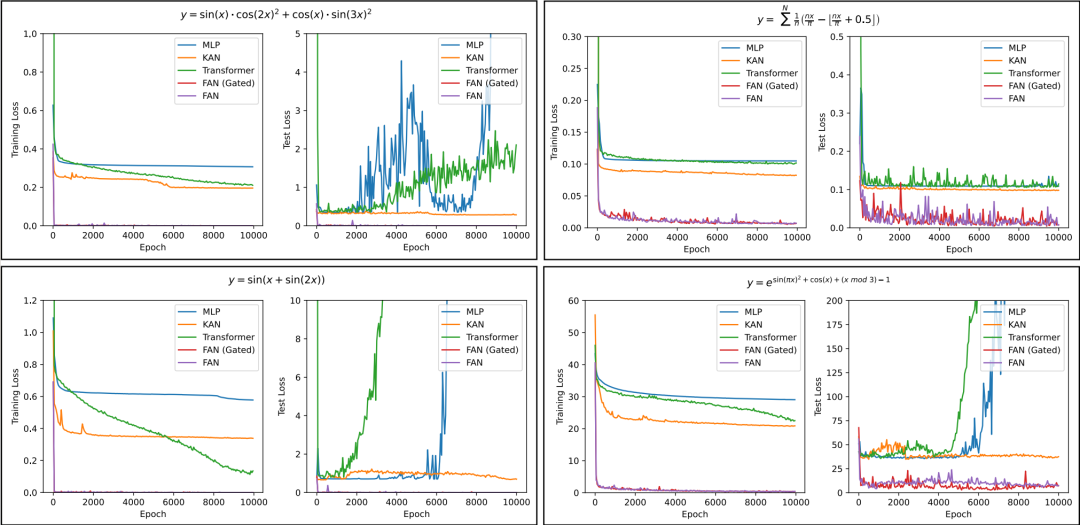

研究团队还分析了不同模型在学习复杂周期函数任务上的训练过程,如下图 4 所示,结果如下:1)FAN 在收敛速度和最终效果方面都远远超过其他模型。2)与 FAN 相比,FAN (Gated) 通常可以实现更快的收敛,但最终性能仍然相当。3)随着训练轮数的增加,虽然其他模型的训练损失变得稳定或逐渐减少,但它们的建模可能与测试数据的分布有很大差异,导致测试损失急剧增加。这一现象进一步证明了这些模型在捕捉周期性方面的缺陷。

图 4 不同模型在学习复杂周期函数任务上的训练和测试损失比较

2. 符号公式表示

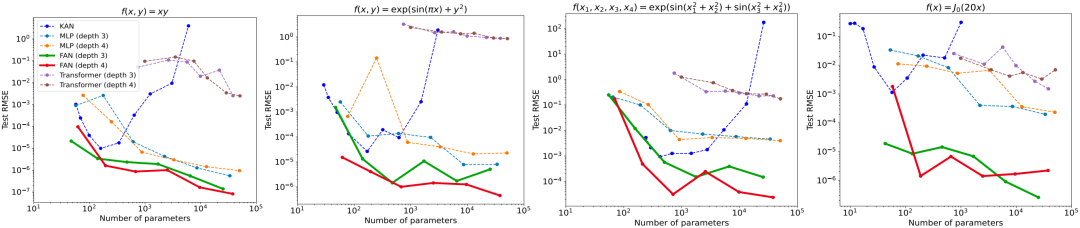

从不同模型应用于数学和物理学中四个常见函数的表现中可以观察到,虽然 KAN 在参数数量较少时能与 FAN 相媲美,但随着参数数量的增加,其性能会显著下降。相反,随着参数数量的增加,FAN 拟合这些函数始终优于其他基线,包括 MLP、KAN 和 Transformer,尽管这些函数中的许多只是部分周期性的或完全非周期性的。这些结果表明,FAN 不仅增强了对周期性的建模能力,同时也没有损害拟合非周期性函数的能力。

图 5 不同模型在符号公式表示任务中不同参数量的表现

3. 时间序列预测

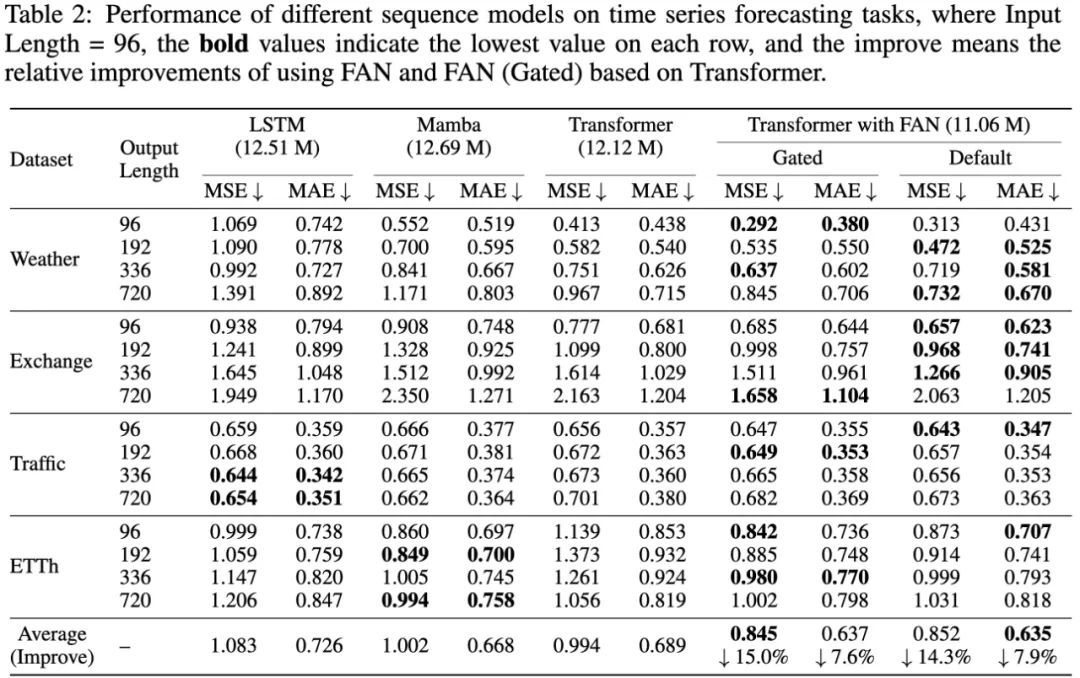

如下表 2 所示,研究团队在四个公共数据集上比较了结合 FAN 的 Transformer 和其他序列模型在时间序列预测任务上的表现。

在大多数情况下,与 LSTM、Mamba 和标准 Transformer 相比,结合 FAN 和 FAN(Gated)的 Transformer 在这些任务上取得了最佳性能。它们相对于标准 Transformer 的改进是显著的,平均相对改进范围为 14.3%-15.0% 的 MSE 和 7.6%-7.9% 的 MAE。这些结果表明,在神经网络中加入显式周期模式编码可以提高实际应用中的时间序列预测性能。

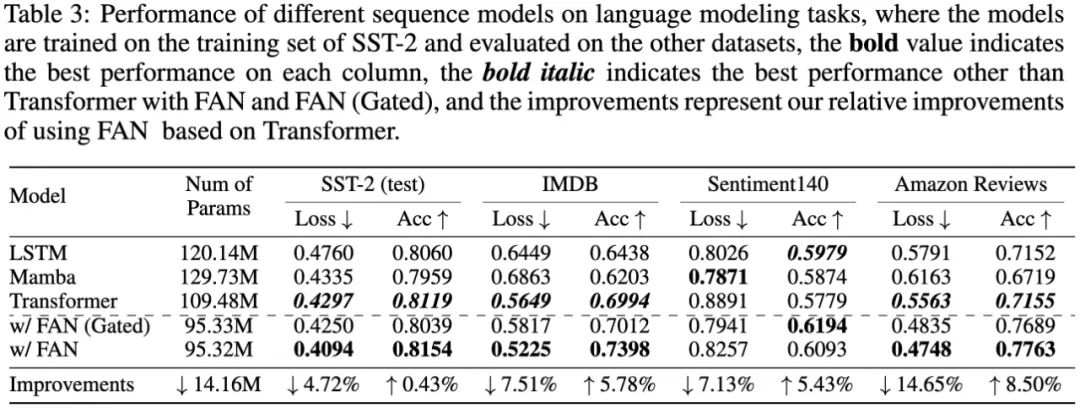

4. 语言建模

研究者报告了不同序列模型在四种情绪分析数据集上的性能比较,如表 3 所示。可以发现,结合 FAN 和 FAN(Gated)的 Transformer 与标准 Transformer 和其他序列模型(例如 LSTM 和 Mamba)相比表现出明显优越的性能,尤其是在 IMDB、Sentiment140 和 Amazon Reviewers 数据集上的零样本跨领域表现。结合 FAN 的 Transformer 在损失和准确度方面分别实现了最 14.65% 和 8.50% 的相对改进,同时将参数数量减少了约 14.16M。结果表明周期性建模在跨领域语言建模和情绪分析任务上具有提高有效性和泛化的潜力。

FAN 的表达能力和应用范围

FAN 在理论上具有与 MLP 相同的表达能力,因为它也遵循通用近似定理,这确保了其函数近似能力。不同的是,FAN 通过明确纳入周期性,引入了重要的功能增强,这是传统 MLP 所不具备的。FAN 的这一设计,不仅全面继承了 MLP 的既有优势,还增强了其捕获数据周期性特征的能力。因此,FAN 可以作为 MLP 的有力替代品。

当然,FAN 的实用性不仅限于明确需要周期性建模的任务,在更广泛的应用中也展现出强大的适用性。研究团队通过一系列现实世界任务的实验证明,如符号公式表示、时间序列预测和语言建模等,FAN 的表现明显优于 MLP 和其他基线模型。

事实上,许多看似与周期性无直接关联的机器学习任务,如数学运算和逻辑推理,实际上也可能隐藏着周期性。如果神经网络缺乏针对周期性特征进行建模的能力,则可能会损害其学习效率。从更深层次的角度来看,周期性不仅仅是一种数据特征,还反映了一种规律或知识,即允许抽象的规则和原理在不同上下文之间转移和重用。

总结来看,FAN 与 MLP 相比,不仅增强了周期性建模能力,且参数量和计算量更少,有望成为基础模型的关键组成部分。未来,北大研究团队将进一步扩大 FAN 的应用范围,增强其作为基础模型组件的表现,持续推动基础模型的技术进步与创新发展。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer2233,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer2233,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?