开源是推动人工智能技术进步的重要力量。

近年来,AI 开发者们也一直在享受着开源带来的技术红利:前沿算法、数据、AI框架、甚至算力。这些开源资源为开发者们带来了极大的便利,而反过来,通过汇聚开发者们的力量,这些开源项目也得到了极大的发展。

在意识到开源的力量之后,国内高校、企业也纷纷加入到开源社区。

7 月 8 日,在 2021 世界人工智能大会上,上海人工智能实验室就做出了开源新动作:开源决策智能平台 OpenDILab。

2021WAIC大会科学前沿全体会议上,上海人工智能实验室青年科学家刘宇博士发布OpenDILab开源决策AI平台

据介绍,它是首个覆盖最全学术界算法和工业级规模的决策 AI 平台。也就是说,OpenDILab 不仅实现了最全面的算法覆盖,例如强化学习,还提供了丰富的工业级应用环境,可应用于自动驾驶、游戏竞技等领域。

如今,OpenDILab 已经被放到 Github 上。就让我们对此项目一探究竟。

GitHub:

https://github.com/opendilab/

为什么要开源OpenDILab?

首先,为什么要做这样一个平台?

我们知道,过去 10 年,感知 AI 已经让机器具备了从「看清」到「看懂」的能力,例如,给定一张猫的图片,机器能够判别出这是一只猫。

然而相较于这种感知层面的人工智能,决策 AI 问题是一项更加复杂的任务,它需要进行推理、决策、规划等。

因此,决策 AI 是下一代 AI 的重要方向已经是业界共识。

目前决策 AI 主要存在两大难题:

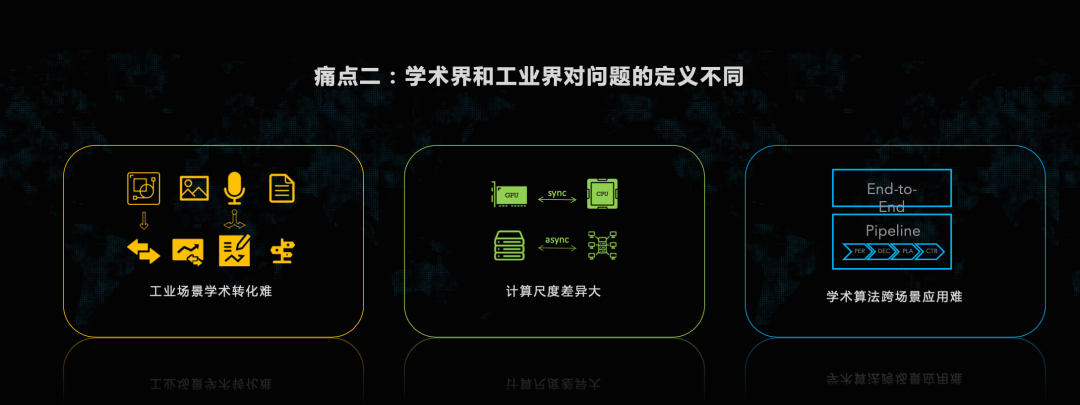

一是决策类问题因涉及多模态数据空间、跨尺度计算逻辑、多领域算法融合,这些问题很难标准化。与感知类 AI 单纯的视觉信息不同,决策类 AI 通常需要同时处理诸如图像、语音、结构化数据等多种复杂模态的数据类型。此外,单机单卡与多机多卡甚至跨集群计算的决策 AI 计算逻辑也完全不同。不同任务间的最优算法配置也差别较大。

二是作为一个前沿领域,决策 AI 的问题定义和研究视角在学术界和工业界之间存在巨大差距,诸多新奇的学术算法缺少环境和计算 pipeline 上的通用性,很多情况下只能局限于 toy model 级别的实验环境,无法转化到真正的工业场景上去,而从工业界本身来看,如何将实际问题抽象为适合现有的决策 AI 算法解决的环境,仍是阻碍决策 AI 技术应用实践的核心门槛。

针对决策 AI 的技术难题,以及产学研协同创新过程中的困难,上海人工智能实验室开源了 OpenDILab 平台。它首次将产业应用中对于训练系统、环境接口、算法设计的需求与学术界进行了有效连接。

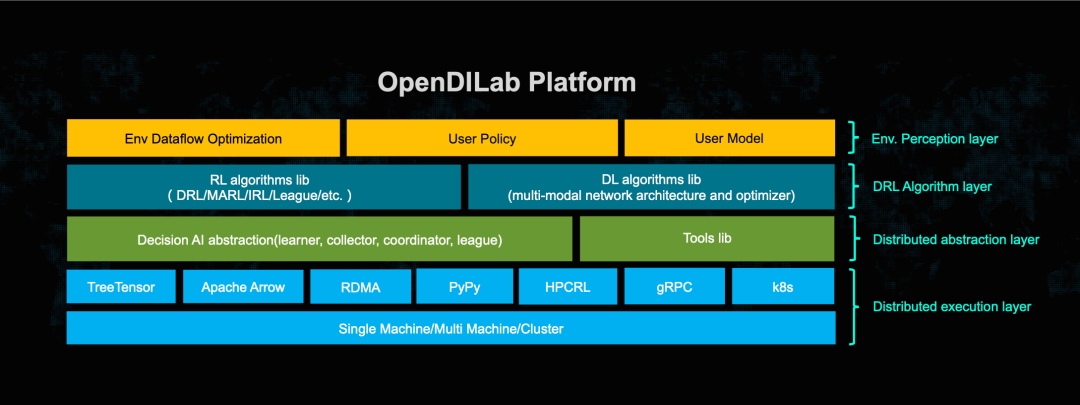

作为一套完备的决策 AI 训练与组织框架,OpenDILab 平台自顶而下覆盖了应用层、算法层、训练层和支持层,适配了从单机到服务器集群规模的全尺度高效训练 pipeline。

OpenDILab平台概览

· 应用层:涵盖多种决策场景,支持多模态数据空间的表示和变换,并提供大量性能优异的算子,助力 AI 做出最优决策;

· 算法层:提供多种常用模块化组件,可在此基础上构建不同的算法模型,支持用户多维度的扩展和定制,完成决策 AI 算法的大统一;

· 训练层:内置多种类型的执行计算图,并深度优化了相应数据吞吐和资源利用率,可为小到学术研究,大到工业级应用的多种规模问题提供支持;

· 支持层:尝试了 CUDA 异构计算和决策 AI 算法的结合,而在资源调度方面,OpenDILab 可依据算法和资源,动态管理整个训练过程,提供异常自动化维护等多种微服务。作为一个系统工程,OpenDILab 为 AI+SYSTEM 带来了全新形态。

一键实现决策算法与应用

OpenDILab (beta) 开源后,研究者和开发者们可以访问 github,获取最强最全的决策 AI 算法 Zoo,查看自动驾驶、游戏 AI 等工业问题在 OpenDILab 平台加持下的具体实践,以及诸多决策 AI 系统设计和优化的相关组件。

在 OpenDILab(beta)的开源版本里,我们可以看到它已经开放了四个核心代码库,最底层的 DI-engine,致力于解决决策 AI 环境算力标准化的训练问题;中层的算法抽象层 DI-zoo,提供了目前最全最强的决策 AI 算法集合。还有顶部应用生态层,开源了基于 DI-engine 的自动驾驶决策平台 DI-drive 和面向策略游戏《星际争霸II》的大规模分布式训练平台 DI-star。

DI-engine 是一个通用的决策智能引擎,不仅支持 DQN、PPO、SAC 等大多数基础的深度强化学习(DRL)算法,而且支持诸多特定研究领域的算法,如多智能体 RL 中的 QMIX、逆向 RL 中的 GAIL 和探索和稀疏奖励问题中的 HER,RND 等等。对于每种算法,可以从多种环境和多种训练 pipeline 的角度探索决策 AI 技术的不同形态。

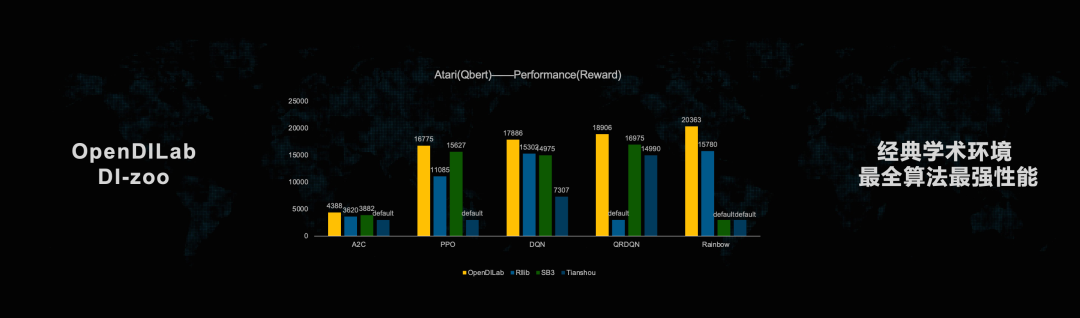

DI-zoo 则可以为开发者提供当前最全、最强的决策 AI 算法集,拥有包括强化学习、MARL、MCTS 等 20 多种跨领域决策 AI 算法,支持 10 多个决策 AI 环境,并原生集成了大量研究员的算法调优经验。这为开发者省去了调参困扰,方便在统一平台对比性能。

而说到应用层的两个代码库:DI-star、DI-drive,可以说是研究决策 AI 最合适的场景。

从国际象棋、围棋到麻将、斗地主,各类游戏一直都是 AI 挑战的对象,而这些复杂的游戏也成为了研究 AI 技术的绝佳场景。星际争霸 2 作为目前难度最高的游戏之一,为检验人工智能决策能力提供了合适的舞台。

基于 DI-engine 的底层支持和大规模分布式深度强化学习训练技术,DI-star 打造出了人类大师分段水平星际争霸 2 智能体,并把完整的技术实现细节和与人机对战测试(仅需 Windows 系统 + 1060 以上显卡)开放给所有人,希望借此促进通用人工智能的研究。

同时 OpenDILab 团队也希望借助 DI-star,汇聚更多社区开发者的力量优化大规模深度强化学习训练效率等方面的问题,将 AlphaStar 级别的智能体设计简化到原来的 1/20~1/30。

自动驾驶同样也是当前人工智能的热门研究方向。决策、规划与控制是自动驾驶任务的大脑,被各大公司视作高度保密技术。DI-drive 是自动驾驶领域第一个开源的,人人可以参与的研究平台。

DI-drive 支持各种模仿学习、强化学习等决策算法,支持多模态类型的输入输出,支持高度定制的可视化模块,为自动驾驶和决策 AI 搭建了至关重要的桥梁。DI-drive 还自主研发设计了 Casezoo 这一从实车采集数据转化而成的测试场景,在及贴近真实的驾驶环境中训练和测试决策模型,促进自动驾驶领域仿真研究在实车环境中的推广和应用。

未来,OpenDILab 还将提供诸如 AutoML、信控等更多的工业级生态应用,加速下一代人工智能的重大技术突破和创新应用的落地。

而对我们开发者来说,一个开源平台是否有意义在于能为我们带来哪些方面的增益,OpenDILab 平台的开源也不例外。

无论你是想入门决策 AI 的技术萌新,还是志在探索算法真理的研究员,又或是想应用决策 AI 技术到各类实际应用中的工程师,都可以通过 OpenDILab 平台获得在算法,系统,工程等方面的经验和工具支持。而现今开源的 OpenDILab (beta) ,也正在期待更多的开发者使用、反馈并逐渐完善它,整个社区一起共同构建最强最好用的决策 AI 平台。

Exploration and Exploitation,就从现在开始!

????

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

1513

1513

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?