©PaperWeekly 原创 · 作者 | 金克丝

单位 | 南京理工大学

论文标题:

Multi-Modal Answer Validation for Knowledge-Based VQA

论文链接:

https://arxiv.org/abs/2103.12248

代码链接:

https://github.com/jialinwu17/mavex

简介

1.1 问题

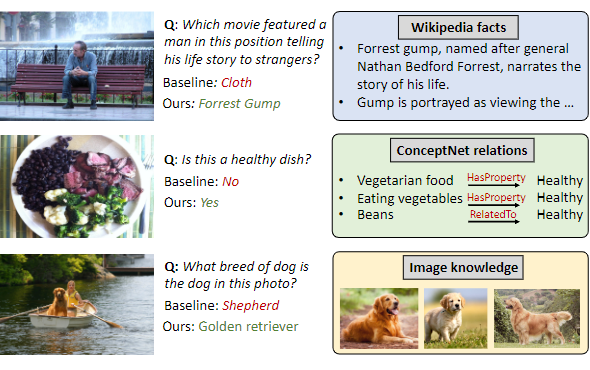

knowledge-based visual question answering 是指模型不仅需要图像的视觉信息和问题的语义信息,还需要图像中的对象所蕴含的外部知识才能够正确的回答问题。这些知识通常以各种形式出现,包括视觉知识、文本知识和常识知识,也可以从各种来源获得,如图像搜索引擎、百科全书文章和概念关系知识库,如图 1,每个问题都需要不同类型的外部知识。

当前大多数 knowledge-based VQA 方法遵循两阶段框架,模型首先检索与问题和图像相关的知识,再由一个单独的融合理解模型预测答案。然而,使用更多的知识来源来检索知识增加了检索到无关或噪声事实的机会,即检索到的知识往往是有噪声的。

1.2 方案

作者提出了 Multi-modal Answer Validation using External knowledge(MAVEx),其思想是基于特定答案的知识检索来验证一组候选答案,进而输出最匹配的答案。MAVEx 的关键直觉是:使用检索到的知识来验证候选答案的有效性比在开放的外部知识里检索来寻找答案更可靠。

因此,作者设计一个模型,根据检索到的知识事实来评估每个候选答案的有效性。现有的方法是在大量检索到的可能不相关的知识事实中寻找答案,MAVEx 旨在了解每个候选答案应该信任哪个知识来源,以及如何使用该来源验证候选答案。作者考虑了文本和视觉的多模态知识,包括使用谷歌搜索的图像、来自维基百科文章的句子和来自 ConceptNet 的概念关系。

相关工作

2.1 Visual Question Answering

视觉问答(VQA)需要模型根据给定的图像和问题来回答这个问题。传统的方法通常基于 Transformer 融合图像和问题以进行推理,随着多模态图文预训练领域的兴起,也使得视觉问答成为了评估多模态预训练

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1419

1419

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?