上周,一个名为“im-also-a-good-gpt2-chatbot”的神秘模型突然现身大模型竞技场 Chatbot Arena,排名直接超过 GPT-4-Turbo、Gemini 1 .5 Pro、Claude 3 0pus、Llama-3-70b 等各家国际大厂的当家基座模型。随后 OpenAI 揭开“im-also-a-good-gpt2-chatbot”神秘面纱——正是 GPT-4o 的测试版本,OpenAI CEO Sam Altman 也在 Gpt-4o 发布后亲自转帖引用 LMSYS arena 盲测擂台的测试结果。

由开放研究组织 LMSYS Org(Large Model Systems Organization)发布的Chatbot Arena已经成为OpenAI、Anthropic、Google、Meta等国际大厂“龙争虎斗”的当红擂台,以最开放与科学的评测方法,在大模型进入第二年之际开放群众投票。

时隔一周,在最新更新的排名中,类“im-also-a-good-gpt2-chatbot”的黑马故事再次上演,这次排名飞速上涨的模型正是由李开复博士带队的中国大模型公司零一万物提交的“Yi-Large”千亿参数闭源大模型。

在 LMSYS 盲测竞技场最新排名中,零一万物的最新千亿参数模型 Yi-Large 总榜排名世界模型第 7,中国大模型中第一,已经超过 Llama-3-70B、Claude 3 Sonnet;其中文榜更是与 GPT4o 并列世界第一。

零一万物也由此成为了总榜上唯一一个自家模型进入排名前十的中国大模型企业。在总榜上,GPT 系列占了前 10 的 4 个,以机构排序,零一万物 01.AI 仅次于 OpenAI, Google, Anthropic 之后,以开放金标准正式进击国际顶级大模型企业阵营。

全球千万级用户盲测,让“刷分刷榜”彻底无效

美国时间 2024 年 5 月 20 日刚刷新的 LMSYS Chatboat Arena 盲测结果,来自至今积累超过 1170 万的全球用户真实投票数:

值得一提的是,为了提高 Chatbot Arena 查询的整体质量,LMSYS 还实施了重复数据删除机制,并出具了去除冗余查询后的榜单。这个新机制旨在消除过度冗余的用户提示,如过度重复的“你好”。这类冗余提示可能会影响排行榜的准确性。LMSYS 公开表示,去除冗余查询后的榜单将在后续成为默认榜单。

在去除冗余查询后的总榜中,Yi-Large 的 Elo 得分更进一步,与 Claude 3 Opus、GPT-4-0125-preview 并列第四。

如何为大模型给出客观公正的评测一直是业内广泛关注的话题。为了在固定题库中取得一份亮眼的评测分数,业内出现了各式各样的“刷榜”方法:将各种各样的评测基准训练集直接混入模型训练集中、用未对齐的模型跟已经对齐的模型做对比等等,对尝试了解大模型真实能力的人,的确呈现“众说纷纭”的现场,更让大模型的投资人摸不着北。

LMSYS Org 发布的 Chatbot Arena 凭借其新颖的“竞技场”形式、测试团队的严谨性,成为目前全球业界公认的基准标杆,连 OpenAI 在 GPT-4o 正式发布前,都在 LMSYS 上匿名预发布和预测试。

在海外大厂高管中,不只 Sam Altman,Google DeepMind 首席科学家 Jeff Dean 也曾引用 LMSYS Chatbot Arena 的排名数据,来佐证 Bard 产品的性能。

OpenAI 创始团队成员 Andrej Karpathy 甚至公开表示,Chatbot Arena is “awesome”。

自身的旗舰模型发布后第一时间提交给 LMSYS,这一行为本身就展现了海外头部大厂对于 Chatbot Arena 的极大尊重。这份尊重既来自于 LMSYS 作为研究组织的权威背书,也来自于其新颖的排名机制。

公开资料显示,LMSYS Org 是一个开放的研究组织,由加州大学伯克利分校的学生和教师、加州大学圣地亚哥分校、卡耐基梅隆大学合作创立。虽然主要人员出自高校,但 LMSYS 的研究项目却十分贴近产业,他们不仅自己开发大语言模型,还向业内输出多种数据集(其推出的 MT-Bench 已是指令遵循方向的权威评测集)、评估工具,此外还开发分布式系统以加速大模型训练和推理,提供线上 live 大模型打擂台测试所需的算力。

在形式上,Chatbot Arena 借鉴了搜索引擎时代的横向对比评测思路。它首先将所有上传评测的“参赛”模型随机两两配对,以匿名模型的形式呈现在用户面前。随后号召真实用户输入自己的提示词,在不知道模型型号名称的前提下,由真实用户对两个模型产品的作答给出评价,在盲测平台 https://arena.lmsys.org/ 上,大模型们两两相比,用户自主输入对大模型的提问,模型 A、模型 B 两侧分别生成两 PK 模型的真实结果,用户在结果下方做出投票四选一:A 模型较佳、B 模型较佳,两者平手,或是两者都不好。提交后,可进行下一轮 PK。

通过众筹真实用户来进行线上实时盲测和匿名投票,Chatbot Arena 一方面减少偏见的影响,另一方面也最大概率避免基于测试集进行刷榜的可能性,以此增加最终成绩的客观性。在经过清洗和匿名化处理后,Chatbot Arena 还会公开所有用户投票数据。得益于“真实用户盲测投票”这一机制,Chatbot Arena 被称为大模型业内最有用户体感的奥林匹克。

在收集真实用户投票数据之后,LMSYS Chatbot Arena 还使用 Elo 评分系统来量化模型的表现,进一步优化评分机制,力求公平反应参与者的实力。

在 Elo 评分系统中,每个参与者都会获得基准评分。每场比赛结束后,参与者的评分会基于比赛结果进行调整。系统会根据参与者评分来计算其赢得比赛的概率,一旦低分选手击败高分选手,那么低分选手就会获得较多的分数,反之则较少。通过引入 Elo 评分系统,LMSYS Chatbot Arena 在最大程度上保证了排名的客观公正。

Chatbot Arena 的评测过程涵盖了从用户直接参与投票到盲测,再到大规模的投票和动态更新的评分机制等多个方面,这些因素共同作用,确保了评测的客观性、权威性和专业性。毫无疑问,这样的评测方式能够更准确地反映出大模型在实际应用中的表现,为行业提供了一个可靠的参考标准。

Yi-Large千亿参数紧追万亿参数顶尖模型,登顶国内大模型盲测

此次 Chatbot Arena 共有 44 款模型参赛,既包含了顶尖开源模型 Llama3-70B,也包含了各家大厂的闭源模型。

以最新公布的 Elo 评分来看,GPT-4o 以 1287 分高居榜首,GPT-4-Turbo、Gemini 1 5 Pro、Claude 3 0pus、Yi-Large 等模型则以 1240左 右的评分位居第二梯队;其后的 Bard (Gemini Pro)、Llama-3-70b-Instruct、Claude 3 sonnet 的成绩则断崖式下滑至 1200 分左右。

值得一提的是,排名前 6 的模型分别归属于海外巨头 OpenAI、Google、Anthropic,零一万物位列全球第四机构,且 GPT-4、Gemini 1.5 Pro 等模型均为万亿级别超大参数规模的旗舰模型,其他模型也都在大几千亿参数级别。Yi-Large “以小搏大” 以仅仅千亿参数量级紧追其后,5 月 13 日一经发布便冲上世界排名第七大模型,与海外大厂的旗舰模型处于同一梯队。在 LMSYS Chatbot Arena 截至 5 月 21 日的总榜上,阿里巴巴的 Qwen-Max 大模型 Elo分数为 1186,排名第 12;智谱 AI 的 GLM-4 大模型 Elo 分数为 1175,排名第 15。

LMSYS中文榜:GPT-4o和Yi-Large并列第一

值得国人关注的是,国内大模型厂商中,智谱 GLM4、阿里 Qwen Max、Qwen 1.5、零一万物 Yi-Large、Yi-34B-chat 此次都有参与盲测,在总榜之外,LMSYS 的语言类别上新增了英语、中文、法文三种语言评测,开始注重全球大模型的多样性。Yi-Large 的中文语言分榜上拔得头筹,与 OpenAI 官宣才一周的地表最强 GPT4o 并列第一,Qwen-Max 和 GLM-4 在中文榜上也都表现不凡。

“最烧脑” 公开评测:Yi-Large位居全球第二

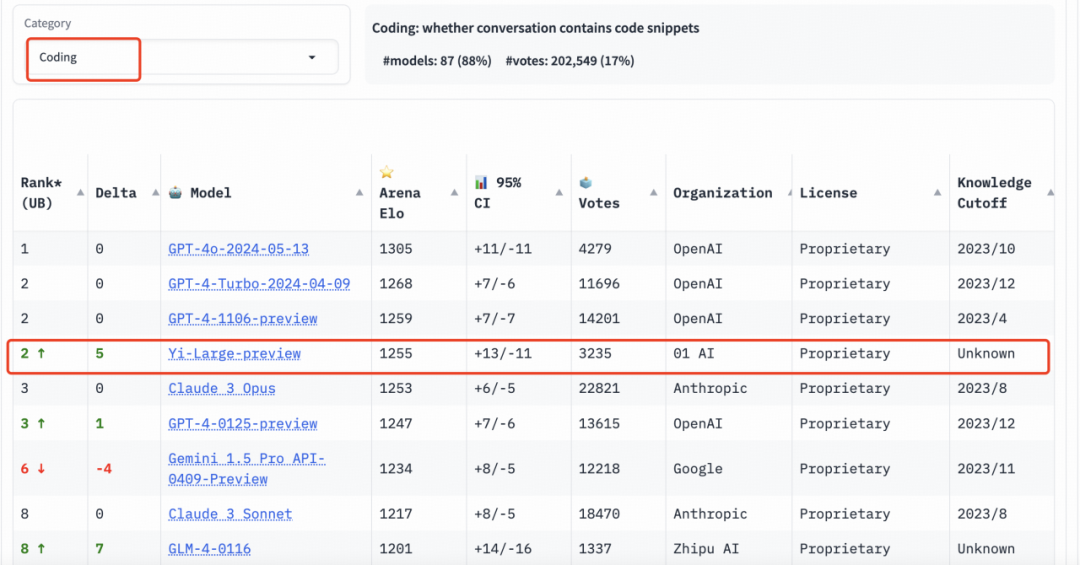

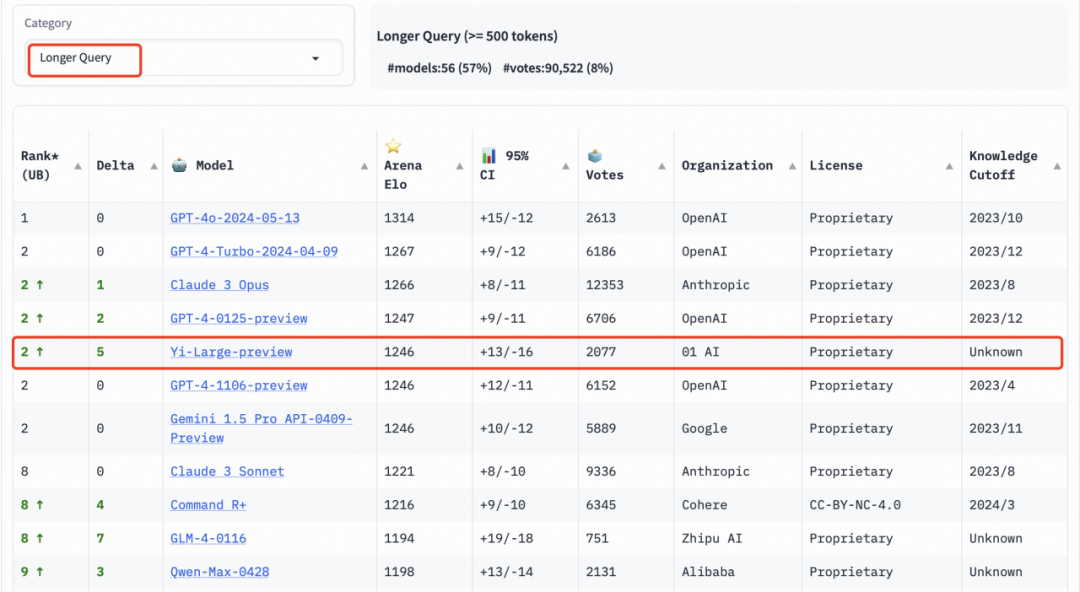

在分类别的排行榜中,Yi-Large 同样表现亮眼。编程能力、长提问及最新推出的 “艰难提示词” 的三个评测是 LMSYS 所给出的针对性榜单,以专业性与高难度著称,可称作大模型“最烧脑”的公开盲测。

在编程能力(Coding)排行榜上,Yi-Large 的 Elo 分数超过 Anthropic 当家旗舰模型 Claude 3 Opus,仅低于 GPT-4o,与 GPT-4-Turbo、GPT-4 并列第二。

长提问(Longer Query)榜单上,Yi-Large 同样位列全球第二,与 GPT-4-Turbo、GPT-4、Claude 3 Opus 并列。

艰难提示词(Hard Prompts)则是 LMSYS 为了响应社区要求,于此次新增的排行榜类别。这一类别包含来自 Arena 的用户提交的提示,这些提示则经过专门设计,更加复杂、要求更高且更加严格。LMSYS 认为,这类提示能够测试最新语言模型面临挑战性任务时的性能。在这一榜单上,Yi-Large 处理艰难提示的能力也得到印证,与 GPT-4-Turbo、GPT-4、Claude 3 Opus 并列第二。

李开复:中美大模型差距缩至半年

在当前大模型步入商业应用的浪潮中,模型的实际性能亟需通过具体应用场景的严格考验,以证明其真正的价值和潜力。过去那种仅要求表面光鲜的“作秀式”评测方式已不再具有实际意义。为了促进整个大模型行业的健康发展,整个行业必须追求一种更为客观、公正且权威的评估体系。

在这样的背景下,一个如 Chatbot Arena 这样能够提供真实用户反馈、采用盲测机制以避免操纵结果、并且能够持续更新评分体系的评测平台,显得尤为重要。它不仅能够为模型提供公正的评估,还能够通过大规模的用户参与,确保评测结果的真实性和权威性。

零一万物 CEO 李开复博士表示,很欣慰刚官宣一周的 Yi-Large 千亿模型登上全球金字塔,世界总榜表现仅次于 OpenAI、 Google、Anthropic 3 家公司,中文分榜和 GPT-4o 并列全球第一。一年前,零一万物刚刚成立,而此时Google、OpenAI 已经投身大模型行业 7 年。“一年后,我们仅仅落后它们约6个月——在这次 LMSYS 全球盲测中超过了所有半年前提交的模型。”

他说,大模型进入第二年,中国正在急起直追,零一万物用了不到硅谷巨头 1/10 的 GPU 算力做模型训练,模型尺寸也不到其 1/10,经过公开盲测进击世界大模型阵列,紧追 OpenAI 顶尖水平。“零一万物团队的勤奋、节俭、努力和人才密度,样样不可或缺。我们的计划是从最小到最大的模型都能够做到中国最好。”李开复表示,一方面,根据 scaling law,越大尺寸的模型约有可能达到 AGI;另一方面,小一些的模型也有各种应用机会。因此,零一万物的打法是“一个都不放过”,并且在每一个潜在尺寸上力争做到性能最高、推理成本最低。

LMSYS Chatbot Arena 盲测竞技场公开投票地址:

https://arena.lmsys.org/

LMSYS Chatbot Leaderboard 评测排行(滚动更新):

https://chat.lmsys.org/?leaderboard

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

3935

3935

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?