来源:AIGC深一度

来源:AIGC深一度

在人工智能领域,一个根本性问题长期困扰着研究者:Transformer架构与人类大脑的工作机制究竟有何关联? 尽管Transformer在语言任务上表现出色,但其张量运算与大脑的神经元网络结构看似毫无相似之处。

2025年9月,来自Pathway公司的研究团队(Adrian Kosowski, Przemysław Uznański, Jan Chorowski等)在预印本平台arXiv上发表了一篇重磅论文,提出了名为Dragon Hatchling (BDH) 的新型架构,首次在数学上建立了Transformer与大脑模型的桥梁。

01 技术背景:两大系统的根本矛盾

当前主流语言模型面临三大核心挑战:

时间泛化困境:Transformer在超过训练长度的推理任务中表现急剧下降(Shojaee et al., 2025)

结构解释缺失:模型参数与大脑神经元(约860亿个)和突触(超100万亿个)的动态对应关系不明

可预测性危机:长期自主运行的AI系统存在“回形针工厂”式风险(Bostrom, 2014)

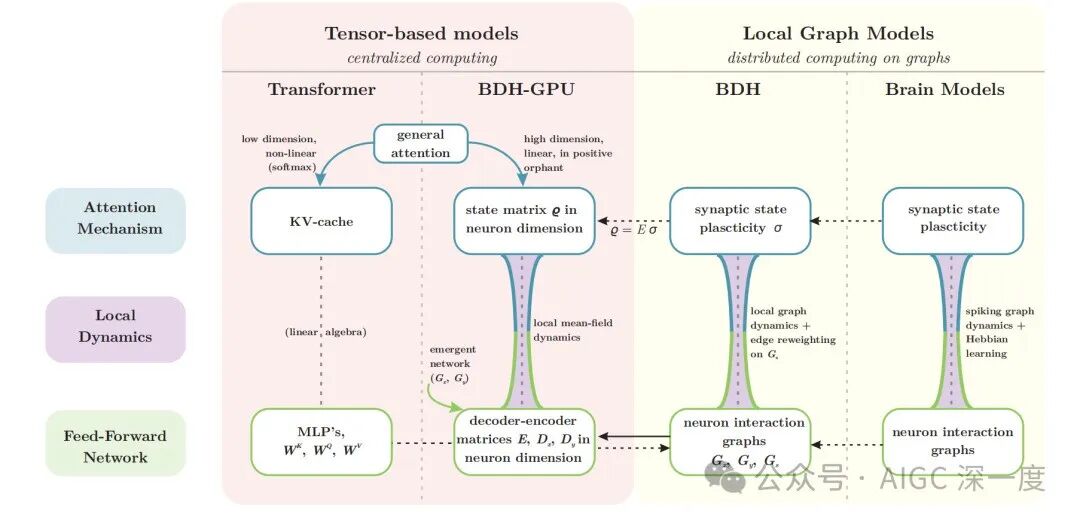

论文指出关键矛盾:Transformer基于集中式张量计算,而大脑是分布式图网络系统。传统方法通过RASP等框架分析Transformer表达能力(Zhou et al., 2024),但无法解释其微观动力学机制。

02 破局者:BDH的三重设计哲学

BDH架构的核心创新在于融合逻辑推理与生物学习机制:

基础框架:局部图动力学

神经元网络:n个神经元通过m条突触连接(n ≪ m ≪ n²)

状态表示:突触权重σ(t)动态变化,参数矩阵G固定

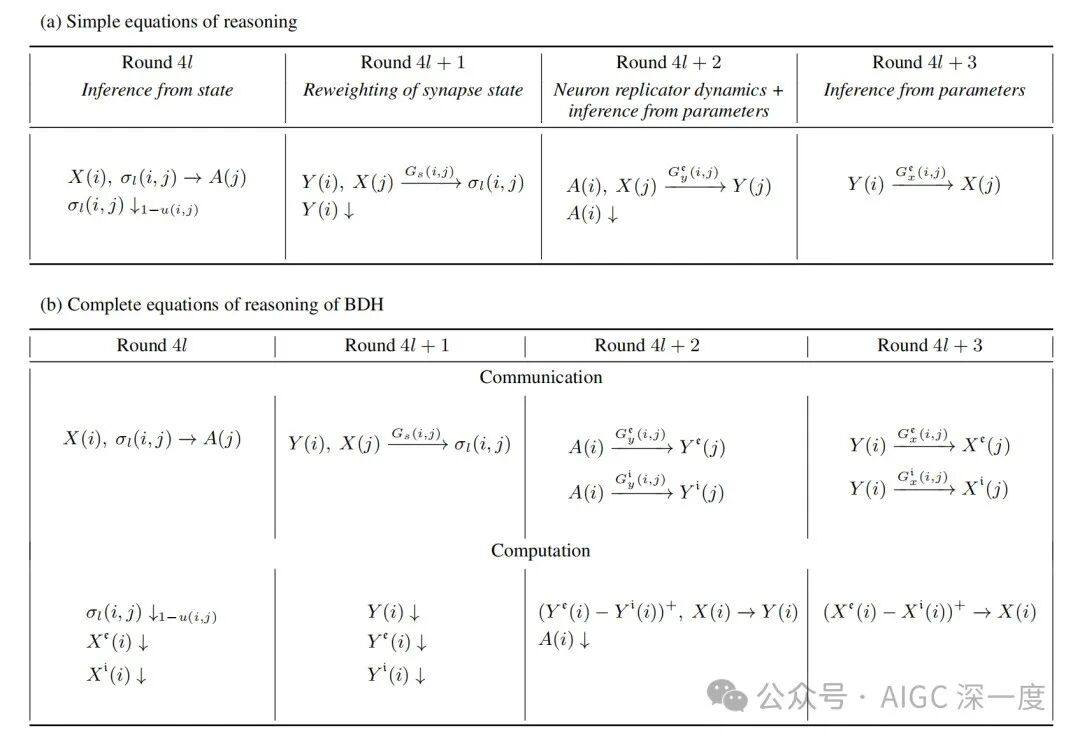

通信机制:同步调度器执行四阶段内核运算(K1-K4)

推理机制:Modus Ponens + Hebbian学习

系统遵循两条核心规则:

逻辑推理:

突触强化:

当神经元i激活并触发神经元j时,其连接权重增强Y(i)X(j)。这种设计使参数与状态规模达到1:1比例,突破传统RNN的O(n)状态限制。

生物实现:双电路模型

BDH包含两个关键电路:

兴奋电路:处理信号传播

抑制电路:通过积分发放阈值控制激活

记忆机制:完全依赖突触可塑性(Hebbian学习)

03 GPU革命:BDH-GPU的张量实现

为解决图网络的计算效率问题,团队提出BDH-GPU变体:

核心创新

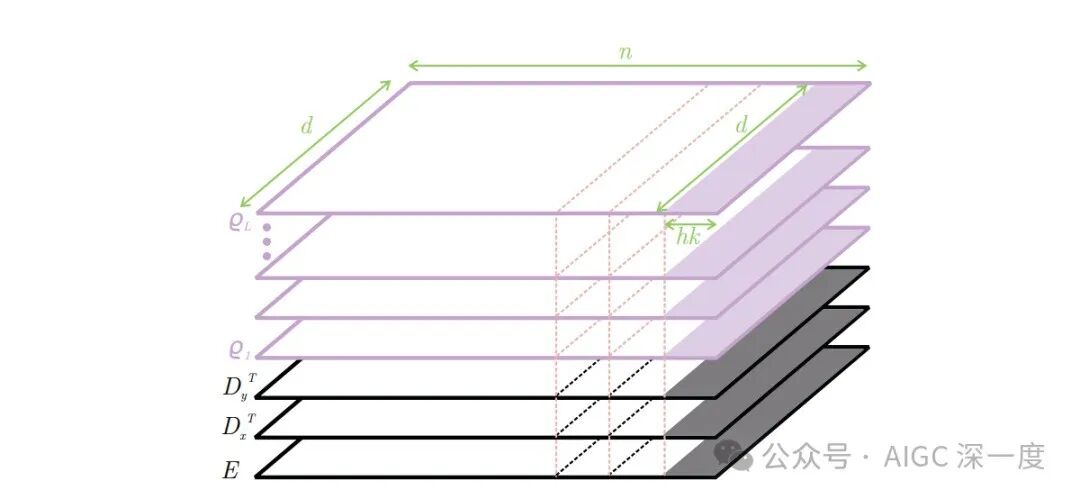

维度设计:神经元维度n(约10⁶),特征维度d(256)

参数量:(3+o(1))nd

状态空间: (公式8)

双模块结构

ReLU-lowrank前馈网络:产生高维稀疏激活

线性注意力机制:在神经元维度n操作

关键突破

稀疏激活:y向量稀疏度约5%

单义性:单个突触对应特定概念

模块化:自发涌现高Newman模块度网络

04 实验验证:性能与可解释性双赢

团队在10M-1B参数规模下进行严格测试:

**性能对比

可解释性发现

突触定位:特定概念激活同一突触(图6.3)

稀疏模式:激活强度反映任务复杂度

网络涌现:参数矩阵直接可读图结构

极限扩展

模型拼接:两个BDH模型直接组合形成更大模型

无BPTT训练:突破传统反向传播限制

05 未来意义:迈向“热力学极限”理论

BDH架构为AI发展开辟新方向:

理论统一:首次建立Transformer-大脑的数学对应

可预测AI:为“热力学极限”行为提供理论基础

类脑计算:揭示人类语言处理的可能机制

正如论文结语所述:“BDH为推理模型的热力学极限理论打开大门,最终目标是实现时间泛化的概率近似正确(PAC)界限”。

论文信息:

标题:The Dragon Hatchling: The Missing Link Between the Transformer and Models of the Brain

机构:Pathway, Palo Alto, USA

链接:https://pathway.com/research/bdh

代码:https://github.com/pathwaycom/bdh

这项研究不仅解决了AI领域的根本性问题,更为构建可解释、可预测的下一代人工智能系统奠定了基础。

阅读最新前沿科技趋势报告,请访问欧米伽研究所的“未来知识库”

https://wx.zsxq.com/group/454854145828

未来知识库是“欧米伽未来研究所”建立的在线知识库平台,收藏的资料范围包括人工智能、脑科学、互联网、超级智能,数智大脑、能源、军事、经济、人类风险等等领域的前沿进展与未来趋势。目前拥有超过8000篇重要资料。每周更新不少于100篇世界范围最新研究资料。欢迎扫描二维码或访问https://wx.zsxq.com/group/454854145828 进入。

1015

1015

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?