一、贝叶斯简介

简介:贝叶斯分类器是一类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类器。而朴素贝叶斯分类器是贝叶斯分类器中最简单,也是最常见的一种分类方法。并且,朴素贝叶斯算法仍然是流行的十大挖掘算法之一,该算法是有监督的学习算法,解决的是分类问题。该算法的优点在于简单易懂、学习效率高、在某些领域的分类问题中能够与决策树、神经网络相媲美。但由于该算法以自变量之间的独立(条件特征独立)性和连续变量的正态性假设为前提,就会导致算法精度在某种程度上受影响。

基础:以下是掌握贝叶斯分类器必须要掌握的知识。

先验概率:是指根据以往经验和分析得到的概率。

例:如果我们对西瓜的色泽、根蒂和纹理等特征一无所知,按照常理来说,西瓜是好瓜的概率是60%。那么这个概率P(好瓜)就被称为先验概率。

后验概率:事情已经发生,要求这件事情发生的原因是由某个因素引起的可能性的大小。

例:假如我们了解到判断西瓜是否好瓜的一个指标是纹理。一般来说,纹理清晰的西瓜是好瓜的概率大一些,大概是75%。如果把纹理清晰当作一种结果,然后去推测好瓜的概率,那么这个概率P(好瓜|纹理清晰)就被称为后验概率。后验概率类似于条件概率。

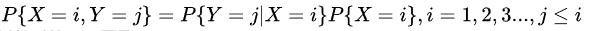

**联合概率:设二维离散型随机变量(X,Y)所有可能取得值为,记则称 为随机变量X和Y的联合概率。**计算如下:

例:在买西瓜的案例中,P(好瓜,纹理清晰)称为联合分布,它表示纹理清晰且是好瓜的概率。关于它的联合概率,满足以下乘法等式:

其中,P(好瓜|纹理清晰)就是后验概率,表示在“纹理清晰”的条件下,是“好瓜”的概率。P(纹理清晰|好瓜)表示在“好瓜”的情况下,是“纹理清晰”的概率。

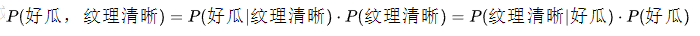

全概率:如果事件组

B

1

B1

B1,

B

2

B2

B2满足:

全概率公式的意义在于:当直接计算

P

(

A

)

P(A)

P(A)较为困难时,而

的计算较为简单时,可以利用全概率公式进行计算P(A)。

例:上面联合概率概念买西瓜的例子中,我们要计算

P

(

好

瓜

,

纹

理

清

晰

)

P(好瓜,纹理清晰)

P(好瓜,纹理清晰)联合概率时,需要知道

P

(

纹

理

清

晰

)

P(纹理清晰)

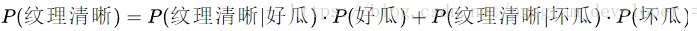

P(纹理清晰)的概率。那么,如何计算纹理清晰的概率呢?实际上可以分为两种情况:一种是好瓜状态下纹理清晰的概率,另一类是坏瓜状态下纹理清晰的概率。纹理清晰的概率就是这两种情况之和。因此,我们可以推导出全概率公式:

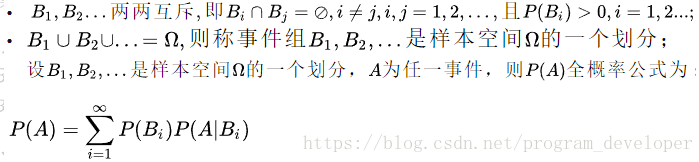

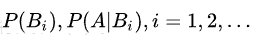

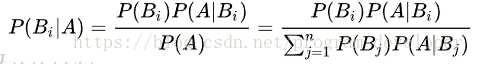

**贝叶斯定理:**贝叶斯公式是建立在条件概率的基础上寻找事件发生的原因(即大事件A已经发生的条件下,分割中的小事件

B

i

B_i

Bi的概率),设

B

1

,

B

2

,

…

B_1,B_2,…

B1,B2,…是样本空间Ω的一个划分,则对任一事件A(P(A)>0),有贝叶斯定理:

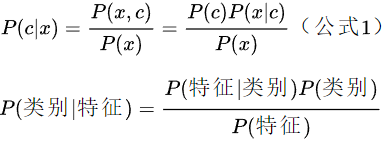

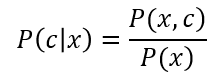

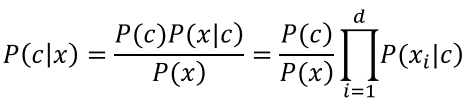

对于每个特征x,我们想要知道样本在这个特性x下属于哪个类别,即求后验概率P(c|x)最大的类标记。这样基于贝叶斯公式,可以得到:

二、贝叶斯决策论

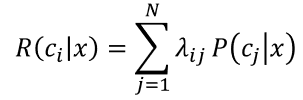

贝叶斯决策论(Bayesian decision theory)是概率框架下实施决策的基本方法,以多分类任务为例来解释其基本原理。

假设有N种可能的类别标记,即

y

=

{

c

1

,

c

2

,

…

,

c

N

}

y=\{c_1,c_2,…,c_N\}

y={c1,c2,…,cN},

λ

i

j

λ_{ij}

λij是将一个真实标记为

c

j

c_j

cj的样本误分类为

c

i

c_i

ci所产生的损失。基于后验概率

P

(

c

i

∣

x

)

P(c_i |x)

P(ci∣x)可获得将样本

x

x

x分类为

c

i

c_i

ci所产生的期望损失,即在样本x上的“条件风险” 。

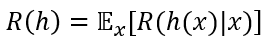

我们的任务是寻找一个判定准则h:

χ

→

y

χ→y

χ→y以最小化总体风险。

显然,对每个样本

x

x

x,若h能最小化条件风险

R

(

h

(

x

)

∣

x

)

R(h(x) | x)

R(h(x)∣x),则总体风险

R

(

h

)

R(h)

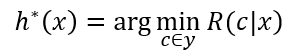

R(h)也将被最小化.贝叶斯判定准则(Bayes decision rule):为最小化总体风险,只需在每个样本上选择那个能使条件风险

R

(

c

∣

x

)

R(c | x)

R(c∣x)最小的类别标记,即

h

∗

h^*

h∗ 称为贝叶斯最优分类器,

R

(

h

∗

)

R(h^*)

R(h∗)称为贝叶斯风险。 $1-R(h^*)反映了分类器所能达到的最好性能,即通过机器学习所能产生的模型精度的理论上限.

具体来说,若目标是最小化分类错误率,则误判损失

λ

i

j

λ_{ij}

λij可写为:

即对每个样本

x

x

x,选择能使后验概率

P

(

c

∣

x

)

P(c | x)

P(c∣x)最大的类别标记。

获得后验概率 P ( c ∣ x ) P(c|x) P(c∣x),在现实任务中通常难以直接获得.所要实现的是基于有限的训练样本集尽可能准确地估计出后验概率 P ( c │ x ) P(c│x) P(c│x).

有两种策略:

直接建模

P

(

c

∣

x

)

P(c|x)

P(c∣x)来预测

c

c

c,“判别式模型”;

对联合概率分布

P

(

x

,

c

)

P(x,c)

P(x,c)建模,然后再由此获得P(c|x),“生成式模型”。

Fisher判别式、支持向量机等,都可归入判别式模型的范畴.

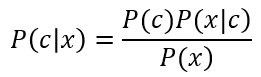

对生成式模型:

基于贝叶斯定理, P(c| x)可写为:

$P(c)$:是类“先验”概率;

$P(x│c)$:是样本x相对于类标记c的类条件概率,或称为“似然”;

$P(x)$:是用于归一化的“证据”子.

证据因子 P ( x ) P(x) P(x)与类标记无关,因此估计 P ( c ∣ x ) P(c|x) P(c∣x)的问题就转化为如何基于训练数据D来估计先验 P ( c ) P(c) P(c)和似然 P ( x ∣ c ) P(x|c) P(x∣c).。 P ( c ) P(c) P(c)可通过各类样本出现的频率来进行估计。

对类条件概率 P ( x ∣ c ) P(x|c) P(x∣c)来说,直接根据样本出现的频率来估计将会遇到严重的困难。很多样本取值在训练集中根本没有出现,“未被观测到”与“出现概率为零”通常是不同的。

三、极大似然估计

估计类条件概率的一种常用策略是先假定其具有某种确定的概率分布形式,再基于训练样本对概率分布的参数进行估计。

假设 P ( x ∣ c ) P(x|c) P(x∣c)具有确定的形式并且被参数向量 θ c θ_c θc唯一确定,则我们的任务就是利用训练集 D D D估计参数 θ c θ_c θc.我们将P(x|c)记为 P ( x ∣ θ c ) P(x|θ_c) P(x∣θc)。

参数估计 两个学派:

频率主义学派认为参数虽然未知,但却是客观存在的固定值,可通过优化似然函数等准则来确定参数值;

经典的方法:极大似然估计

贝叶斯学派则认为参数是未观察到的随机变量, 可假定参数服从一个先验分布,然后基于观测到的数据来计算参数的后验分布.

D

c

D_c

Dc表示训练集

D

D

D中第

c

c

c类样本组成的集合,假设这些样本是独立同分布的,则参数

θ

c

θ_c

θc对于数据集

D

c

D_c

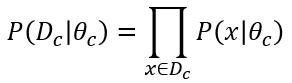

Dc的似然是:

同时发生,因此连乘

对 θ c θ_c θc进行极大似然估计,就是去寻找能最大化似然 P ( D c ∣ θ c ) P(D_c | θ_c) P(Dc∣θc)的参数值 θ c ^ \hat{\theta _c} θc^.直观上看,极大似然估计是试图在 θ c θ_c θc所有可能的取值中,找到一个能使数据出现的“可能性”最大的值。

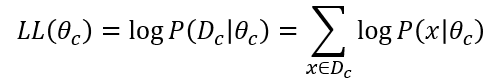

对数似然

连乘转换为连加,更好处理

此时参数

θ

c

θ_c

θc的极大似然估计

θ

c

^

\hat{\theta _c}

θc^为

后面是求偏导等于0,求方程组

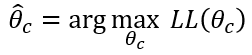

例题解析

例1, 假设概率密度函数

p

(

x

│

c

)

N

(

μ

c

,

σ

c

2

)

p(x │ c) ~ N(μ_c,σ_c^2 )

p(x│c) N(μc,σc2),求参数

μ

c

μ_c

μc和

σ

c

2

σ_c^2

σc2的极大似然估计:

一维正态的情况,设

θ

1

=

μ

,

θ

2

=

σ

2

\theta _{1}=\mu ,\theta _{2}=\sigma ^2

θ1=μ,θ2=σ2 则:

则有:

可见,正态分布中的协方差阵Σ的最大似然估计量等于N个矩阵的算术平均值。

这种参数化的方法相对简单,但估计结果的准确性严重依赖于所假设的概率分布形式是否符合潜在的真实数据分布.

四、朴素贝叶斯分类器

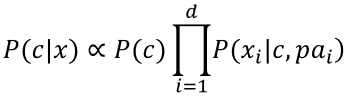

基于贝叶斯公式来估计后验概率 P ( c ∣ x ) P(c|x) P(c∣x)的主要困难:类条件概率 P ( x ∣ c ) P(x|c) P(x∣c)是所有属性上的联合概率,难以从有限的训练样本直接估计而得。

朴素贝叶斯分类器采用了“属性条件独立性假设”: 假设所有属性相互独立.

基于属性条件独立性假设,贝叶斯公式可重写为:

其中

d

d

d为属性数目,

x

i

x_i

xi为

x

x

x在第

i

i

i个属性上的取值.

这就是朴素贝叶斯分类器的表达式.

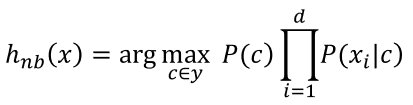

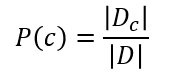

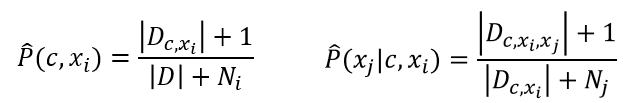

朴素贝叶斯分类器的训练过程就是基于训练集 D D D来估计类先验概率 P ( c ) P(c) P(c),并为每个属性估计条件概率 P ( x i ∣ c ) P(x_i |c) P(xi∣c).

类先验概率:

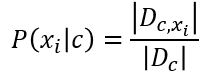

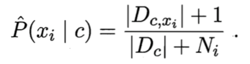

对离散属性而言,则条件概率

P

(

x

i

∣

c

)

P(x_i |c)

P(xi∣c)可估计为:

第

c

c

c类第

i

i

i个属性上取值为

x

i

x_i

xi的样本

*比如*:在下边西瓜分类的例题中, c c c表示好瓜或坏瓜, x i x_i xi表示属性, D c D_c Dc表示某一类的数量,如果用 c 1 c_1 c1表示好瓜,则 D c 1 D_{c1} Dc1表示好瓜的数量,在下表中可以数出来, D c 1 = 8 D_{c1}=8 Dc1=8,同理,用 x 1 x_1 x1表示青绿色,则 D c , x 1 D_{c,x_1} Dc,x1表示既是好瓜,又是青绿色的瓜的数目,显然, D c , x 1 = 3 D_{c,x_1}=3 Dc,x1=3。所以,条件概率好瓜的情况下是青绿色的瓜的概率是 P ( 青 绿 色 ∣ 好 瓜 ) = 3 / 8 = 0.375 P(青绿色 |好瓜)=3/8=0.375 P(青绿色∣好瓜)=3/8=0.375

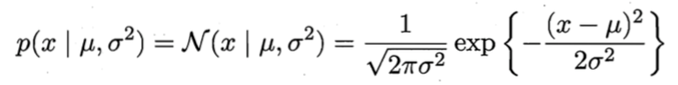

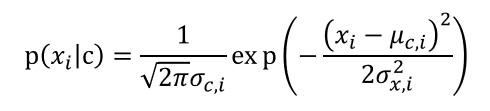

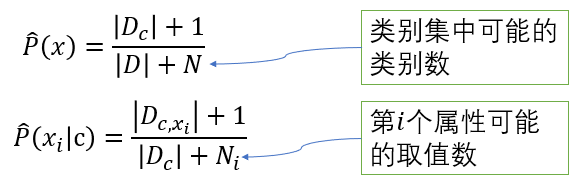

对连续属性可考虑概率密度函数,假定

p

(

x

i

∣

c

)

∼

N

(

μ

c

,

i

,

σ

c

,

i

2

)

p(x_i | c) \sim N(μ_{c,i},σ_{c,i}^2)

p(xi∣c)∼N(μc,i,σc,i2),其中

μ

c

,

i

μ_{c,i}

μc,i和

σ

c

,

i

2

σ_{c,i}^2

σc,i2分别是第

c

c

c类样本在第

i

i

i个属性上取值的均值和方差,则有:

如,下面例题中的密度,含糖量是属于连续属性。生活中,还有身高,体重等长度、重量是连续属性。而离散属性如例题中的色泽,根蒂等属性,每个属性的种类有限,属于离散型的。

例题解析

下面我们用西瓜数据集3.0训练一个朴素贝叶斯分类器,进行分类:

首先估计类先验概率

P

(

c

)

P(c)

P(c),然后,为每个属性估计条件概率

P

(

x

i

∣

c

)

P(x_i | c)

P(xi∣c) 。

于是,有:

由于

0.038

>

6.80

×

1

0

−

5

0.038>6.80×10^{-5}

0.038>6.80×10−5,因此,朴素贝叶斯分类器将测试样本“测1”判别为“好瓜”。

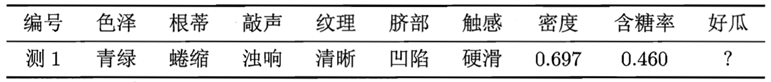

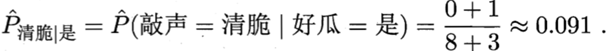

需注意,若某个属性值在训练集中没有与某个类同时出现过,对一个“敲声=清脆”的测试例,

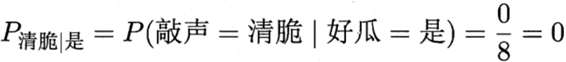

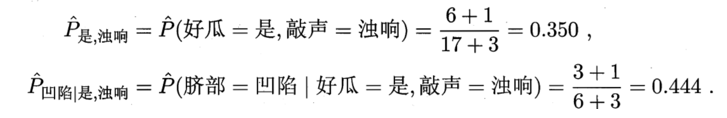

为了避免,通常要进行“平滑”,拉普拉斯修正:

例如,在本节的例子中,类先验概率可估计为 :

类似地,

P

青

绿

∣

是

P_{青绿|是}

P青绿∣是 和

P

青

绿

∣

否

P_{青绿|否}

P青绿∣否 可估计为:

同时,上文提到地概率

P

青

脆

∣

是

P_{青脆|是}

P青脆∣是 可估计为:

显然,拉普拉斯修正避免了因训练集样本不充分而导致概率估值为零的问题,并且在训练集变大时,修正过程所引入的先验的影响也会逐渐变得可忽略,使得估值渐趋向于实际概率值.

朴素贝叶斯分类器有多种使用方式:

1.可将朴素贝叶斯分类器涉及的所有概率估值事先计算好存储起来,这样在进行预测时只需“查表”即可进行判别;

2.“懒惰学习”(lazy learning)方式;在现有估值基础上,先不预先计算,

3.数据增加是,仅对新增样本的属性值所涉及的概率估值进行计数修正即可实现增量学习.

五、半朴素贝叶斯分类器

朴素贝叶斯分类器采用了属性条件独立性假设,但在现实任务中这个假设往往很难成立.

进行一定程度的放松,称为“半朴素贝叶斯分类器”。适当考虑一部分属性间的相互依赖信息。

独依赖估计(One-Dependent Estimator,简称ODE)是半朴素贝叶斯分类器最常用的一种策略.顾名思议,所谓“独依赖”就是假设每个属性在:类别之外最多仅依赖于一个其他属性,即

其中

p

a

i

pa_i

pai为属性

x

i

x_i

xi所依赖的属性,称为

x

i

x_i

xi的父属性.此时,对每个属性

x

i

x_i

xi,若父属性

p

a

i

pa_i

pai已知,则可采用类似下面的公式来估计概率值

P

(

x

i

│

c

,

p

a

i

)

P(x_{i│c},pa_i )

P(xi│c,pai).

于是,问题的关键就转化为如何确定每个属性的父属性,不同的做法产生不同的独依赖分类器。

最直接的做法是假设所有属性都依赖于同-一个属性,称为“超父”(super-parent),由此形成了 SPODE(Super-Parent ODE)方法.

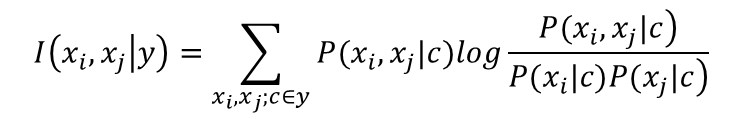

TAN (Tree Augmented naive Bayes)则是在最大带权生成树算法的基础上,通过以下步骤将属性间依赖关系约简为如图7.1©所示的树形结构:

(1)计算任意两个属性之间的条件互信息:

(2) 以属性为结点构建完全图,任意两个结点之间边的权重设为

I

(

x

i

,

x

j

∣

y

)

I(x_i,x_j |y)

I(xi,xj∣y);

(3)构建此完全图的最大带权生成树,挑选根变量,将边置为有向;

(4)加入类别结点y,增加从y到每个属性的有向边.

条件互信息 I ( x i , x j ∣ y ) I(x_i,x_j |y) I(xi,xj∣y)刻画了属性 x i x_i xi和 x j x_j xj在已知类别情况下的相关性,通过最大生成树算法,TAN实际上仅保留了强相关属性之间的依赖性.

与SPODE通过模型选择确定超父属性不同,AODE尝试将每个属性作为超父来构建SPODE,然后将那些具有足够训练数据支撑的SPODE集成起来作为最终结果,即:

例如:

与朴素贝叶斯分类器类似,AODE的训练过程也是“计数”,即,在训练数据集上对符合条件的样本进行计数的过程、与朴素贝叶斯分类器相似,AODE无需模型选择,既能通过预计算节省预测时间,也能采取懒惰学习方式在预测时再进行计数,并且易于实现增量学习.

2733

2733

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?