CNN 真的需要下采样(上采样)吗?

最新推荐文章于 2024-05-22 08:34:26 发布

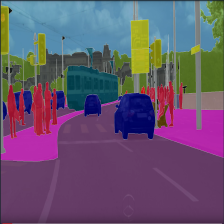

本文探讨了卷积神经网络(CNN)中下采样和上采样的必要性。实验结果显示,使用空洞卷积和大卷积核可以替代下采样,且在保持性能的同时减少参数量。通过对比不同结构,如小卷积核的级联、大卷积核和空洞卷积,表明感受野和通道数对CNN性能至关重要。此外,还讨论了稀疏化在减少参数量和保持性能方面的潜力。最后,作者提出了无采样网络在分割和目标检测任务中的应用可能,并对跨层连接进行了思考。

本文探讨了卷积神经网络(CNN)中下采样和上采样的必要性。实验结果显示,使用空洞卷积和大卷积核可以替代下采样,且在保持性能的同时减少参数量。通过对比不同结构,如小卷积核的级联、大卷积核和空洞卷积,表明感受野和通道数对CNN性能至关重要。此外,还讨论了稀疏化在减少参数量和保持性能方面的潜力。最后,作者提出了无采样网络在分割和目标检测任务中的应用可能,并对跨层连接进行了思考。

订阅专栏 解锁全文

订阅专栏 解锁全文

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?