针对nlp的问题,对起课程进行翻译:

cs224n-2017-lecture1

1、人类的语言有哪些特点呢?

一个人类语言就是能够特定的组织来表达其意思的系统:

(1)不仅仅是一个环境信号,更多是一个交流信息;(2)用了一种编码方式,并且这种方式,一个小孩都可以能够很快的学习。

所以一种人类语言就是一个离散的、符号、具有分类的信号系统

(1)rocket = 火箭图片; violin = 提亲图片

(2)表达信号具有非常少的例外对于表达信号(“I loooove it.” “Whoomppaaa”)

(3)我们这种信号更加稳定

(4)符号不仅仅是一个逻辑的发明或者经典的AI

那么符号的类别可以分为以下几种:声音、手势、图片。

然而大脑的编码似乎是连续激活模式,符号是通过连续的声音或者视频传递的。我们将会探究一个连续的编码模式,大量的词汇以及单词符号的编码为机器学习构造得到一个问题---数据稀疏??????

比如很多词汇,但是一句话却只有几个单词,怎么表达这个句子的意思。

2、什么是深度学习

2、什么是深度学习

深度学习是机器学习的一个子集

大部分的机器学习表现好的原因是由于人做了大量的人为表示和输入特征。

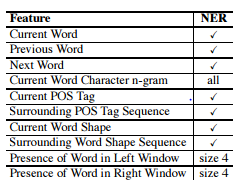

例如:命名实体识别就需要寻找类似于字符位置或者组织命名(organization names)

例如传统的机器学习就用到了如表格的第一列就是特征 包含current word、 previous

例如传统的机器学习就用到了如表格的第一列就是特征 包含current word、 previous

word、 next word、current word character n-gram/ current pos tag/ surrounding pos tag sequence/

什么是深度学习

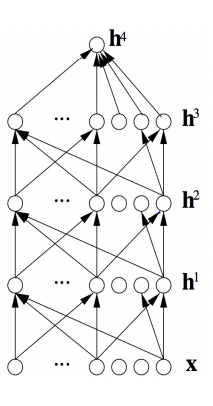

(1)尝试自动的学习好的特征以及表示,称之为表示学习

(2)尝试学习多个级别的表示和一个做后的输出。

(3)from ‘raw’ 的输入x(例如sound character words)

学习深度学习的原因

(1)手动的设计特征经常不完整并且需要很长的时间去考虑。

(2)学习特征是非常容易适应很快学习的

(3)深度学习是非常灵活,容易普及,可学习的框架对于单词representing 视觉和语言信息

(4)可以学习无监督(from raw text)和监督数据(具有标签(like positive/negative))

(5) 在2010年深度学习已经超过了机器学习技术

(6)大量的训练数据集支撑了deep

(7)计算机资源的提高

(8)新的model algorithms 想法:

1、更好的更加灵活的中间学习表示;

2、有效的端到端联合学习系统

3、有效的学习方法对于利用contexts 和任务之间的转移

deep learning for speech

第一次突破性的结果是在语音识别中对于大数据集,Context-Dependent Pre-trained Deep Neural Networks for Large Vocabulary Speech Recognition Dahl(2010)

deep learing for vision

对于深度学习也是具有突破性的‘’

prerequisites先决条件

proficiency in python (熟练使用)

全程将使用python;多元微分 线性代数;概率论统计学 基础机器学习:

(loss functions ;taking simple derivatives,performing optimization with descent(梯度下降最优算法))

what do we hope to teach

1/ an understanding of and ability to use effective moorden methods for deep learning

理解并且运用深度学习的现在比较有效的方法

(1)covering all the basics,but thereafter with a bias to the key methods used in NLP:

Recurrent network attention, etc. 讲授课程包含了所有基础方法,但是会注重讲解循环网咯,以及attention

(2)some big picture understanding of human languages and the difficulties in understanding and producing them

一些图片理解人类语言和产生理解的困难

(3)an undestanding of and ability to build systems for some of the major problems in NLP:

1/word similarities ,parsing,machine translation entity recognition ,question answering,sentence comprehension

2、3 assignment :17% * 3=51%

3、Midterm Exam: 17%

4、Final Course Project or Assignment 4 (1–3 people): 30% (最后课程项目)

(1)including for final project doing

Why is nlp hard?

(1)Complexity in representing, learing,using lingusitic/situational/world/visual knowleage

单词的表示复杂,学习复杂,语言场景,或者世界以及视觉知识比较复杂。

(2)human languages are ambiguos (unlike other programing )

人类的语言具有歧义

(3)human languages interpretation depend on real world,common sense and contextual knowledge

人类语言翻译依赖于真是的世界 场景和上下文知识

1、the pople baby steps on gays

5. Deep NLP = Deep Learning + NLP

combine ideas and goals of with using representation learing and deep learing methods to solve them

结合用学习表示方法和深度学习方法来解决他们

several big improverments in recent years in NLP with different

(1) level: speech words ,synatx,semantics

(2)parts-of-speech,entiies,parsing

(3)application:machine translation,sentiment analysis,dialogue agents, question answering

几个在nlp中的提高如下:

(1)语音识别文字,语法,语义;(2)实体,解析(3)应用:机器翻译,语义分析,对话系统,智能问答

Word meaning as a neural word vector – visualization

word similarities

Nearest words to frog(青蛙)

1、frogs 2、toad 3、litoria 4、leptodactylidaye 5、

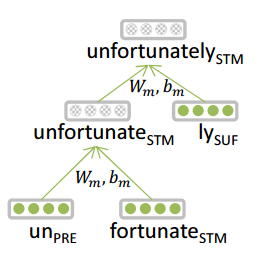

(1)traditional: words are made of morphemes(传统的方法是单词是由元素构成)

prefix (前缀) stem(词干)suffix(后缀)

un interest ed

(2)DL:

1、every morepheme is a vector (每一个元素就表示为向量)

2、a neural network combines two vectors into one vector

神经网络能够把两个向量结合为一个向量

3、luong et al. 2013

NLP Tools: Parsing for sentence structure

Neural networks can accurately determine the structure of sentences,supporting interpretation(神经网络能精确地决定句子结构,能够解释)

从上面可以看出可以把句子的单词,词性以及句法结构综合信息进行表示。

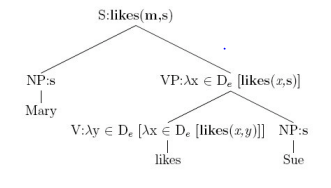

Representations of NLP Levels: Semantics

1、Traditional:lambda calculus

(1)Carefully engineered functions(非常仔细的特征工程)

(2)take as input specific other functions(把输入指定其他函数)

(3)没有相似(similarity)的概念或者没有模糊的语言,也就是不够接近语义

DL:

(1)、每一个单词,每一个短语和每一个逻辑表达式都是向量

(2)、神经网络把两个向量结合为一个向量

(3)、

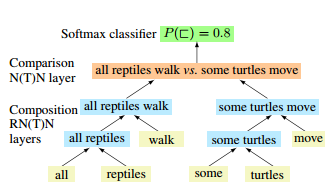

NLP Applications: Sentiment Analysis

(1)传统:有一个情绪字典结合bag-of-words 表示以及手工否定特征;

(2)一些深度模型

Question Answering

(1)传统的大部分的人工特征来获取单词和其他知识,例如正则表达式

(2)a deep learing architecture can be used ,事实上采用向量存储

Dialogue agents / Response Generation

(1)一个简单比较成功的是google邮件的自动回复功能

(2)一个非常厉害并且一般的语言模型就是Recurrent Neural

这是第一个开场的ppt翻译

下一章

cs224n-2017-notes1

755

755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?