本系列文章仅为个人学习邱锡鹏老师《神经网络与深度学习》和李沐老师《动手学深度学习》的学习笔记,不做任何商业传播用途!若发现有雷同,不是巧合。

目录

课程内容:

-

深度学习:特点——①是一类机器学习问题,从输入到输出的信息传递路径比较长,指从有限样例中通过算法总结出一般性的规律,并可以应用到新的未知数据上。是机器学习中的一类函数,形式通常为多层神经网络。②采用的模型一般比较复杂,指样本的原始输入到输出目标之间的数据流经过多个线性或非线性的组件(component)→主要解决贡献度分配问题。

-

贡献度分配问题/信用分配问题/功劳分配问题(Credit Assignment Problem, CAP):在复杂系统中,每个组件或其参数对最终决策的贡献或影响是多少。从某种意义上而言,深度学习可以看作一种强化学习。

The credit assignment problem (CAP) is a fundamental challenge in reinforcement learning. It arises when an agent receives a reward for a particular action, but the agent must determine which of its previous actions led to the reward.

In reinforcement learning, an agent applies a set of actions in an environment to maximize the overall reward. The agent updates its policy based on feedback received from the environment. It typically includes a scalar reward indicating the quality of the agent’s actions.

The credit assignment problem refers to the problem of measuring the influence and impact of an action taken by an agent on future rewards. The core aim is to guide the agents to take corrective actions which can maximize the reward.

However, in many cases, the reward signal from the environment doesn’t provide direct information about which specific actions the agent should continue or avoid. This can make it difficult for the agent to build an effective policy.

Additionally, there’re situations where the agent takes a sequence of actions, and the reward signal is only received at the end of the sequence. In these cases, the agent must determine which of its previous actions positively contributed to the final reward.

👉CAP是强化学习中的一类问题,是计算智能体采取一个动作后对未来奖励造成的影响的问题。核心目标是指导智能体采取纠正的措施,从而使获得的奖励最大化。

-

-

(人工)神经网络(Artificial Neural Network,):一种以(人工)神经元为基本单元的模型,由人工神经元和神经元之间的连接构成,后来才被用于机器学习模型,可以比较容易地解决CAP。可以看作信息从输入到输出的信息处理系统。如果把神经网络看作由一组参数控制的复杂函数,神经网络的参数可以通过机器学习的方式来从数据中学习,复杂的神经网络学习可以看作是一种深度的机器学习,即深度学习。【神经网络可以用于深度学习问题,深度学习也可以用深度信念网络,即概率图模型】

大多数神经网络的核心原则:

- 交替使用线性处理单元和非线性处理单元,通常被称为”层“

- 使用链式法则(即反向传播)更新网络参数

两类特殊的神经元:①接受外部信息;②输出信息。

- 博弈曾被认为是人工智能最后的壁垒

- 深度学习作为表征学习的一种,自动找出每一集表示数据的合适方式

- 深度学习是端到端的训练,也就是并不是将单独调试的部分拼凑起来促成一个系统,而是将整个系统组件好之后一起训练。

1.1 人工智能

一、定义及研究领域

智能=智力(智能的基础)+能力(获取和运用知识求解的能力)

人工智能(Artificial Intelligence,AI)就是让机器具有人类的智力,一般认为智能(或特指人类智能)是知识和智力的总和。——计算机控制+智能行为≠类脑智能

图灵测试:一个人在不接触对方的情况下,通过一种特殊的方式和对方进行一系列的问答。如果在相当长时间内,他无法根据这些问题判断对方是人还是计算机,那么就可以认为这个计算机是智能的。

💡 研究领域:

机器感知(计算机视觉、语音信息处理) 学习(模式识别、机器学习、强化学习) 语言(自然语言处理) 记忆(知识表示) 决策(规划、数据挖掘)

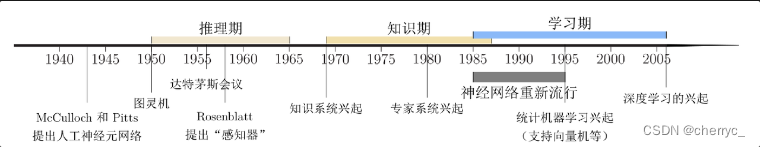

二、发展历史

1.专家系统=知识库+推理机,是一类具有专门知识和经验的计算机智能程序系统。2.机器学习的主要目的是设计和分析一些学习算法,让计算机可以从数据/经验中自动分析并获得规律,之后利用学习到的规律对未知数据进行预测,从而完成特定任务,提高开发效率。

人工智能的主要流派:

(1) 符号主义(Symbolism),又称逻辑主义、心理学派或计算机学派,是指通过分析人类智能的功能,然后用计算机来实现这些功能的一类方法。符号主义有两个基本假设:a)信息可以用符号来表示;b)符号可以通过显式的规则(比如逻辑运算)来操作。人类的认知过程可以看作符号操作过程。在人工智能的推理期和知识期,符号主义的方法比较盛行,并取得了大量的成果。➡可解释性

(2) 连接主义(Connectionism),又称仿生学派或生理学派,是认知科学领域中的一类信息处理的方法和理论。在认知科学领域,人类的认知过程可以看作一种信息处理过程。连接主义认为人类的认知过程是由大量简单神经元构成的神经网络中的信息处理过程,而不是符号运算。因此,连接主义模型的主要结构是由大量简单的信息处理单元组成的互联网络,具有非线性、分布式、并行化、局部性计算以及自适应性等特性。➡神经网络

(3) 行为主义,智能是可以通过不断与环境交互实现的。➡强化学习

目前有研究如何融合符号主义和连接主义,建立一种高效并且可解释的模型。

1.2 机器学习

机器学习(Machine Learning,ML)是指从有限的观测数据中学习(或“猜测”)出具有一般性的规律,并利用这些规律对未知数据进行预测的方法。

传统的机器学习主要关注如何学习一个预测模型.一般需要首先将数据表示为一组特征(Feature),特征的表示形式可以是连续的数值、离散的符号或其他形式.然后将这些特征输入到预测模型,并输出预测结果.这类机器学习可以看作浅层学习(Shallow Learning).浅层学习的一个重要特点是不涉及特征学习,其特征主要靠人工经验或特征转换方法来抽取.对于图像这类数据,我们可以很自然地将其表示为一个连续的向量,其中一种方法是直接将一幅图像的所有像素值(灰度值/RGB值)组成一个连续向量。

机器学习的一般步骤:

- 数据预处理:对原始数据进行初步数据清理、加工,构建数据集

- 特征提取:例如图像边缘、尺度不变特征变换特征,文本分类去除停用词等

- 特征变换:对数据进一步加工,例如升维和降维

- 预测:核心部分,学习一个函数并预测

💡 浅层学习:相对于深度学习的一个概念,当前多数分类、回归等学习方法为浅层结构算法,其局限性在于有限样本和计算单元情况下对复杂函数的表示能力有限,针对复杂分类问题其泛化能力受到一定制约。

深度学习:可通过学习一种深层非线性网络结构,实现复杂函数逼近,表征输入数据分布式表示,并展现了强大的从少数样本集中学习数据集本质特征的能力。(多层的好处是可以用较少的参数表示复杂的函数)

1.3 表示学习

- 表示(Representation):将输入信息转换为有效的特征

- 表示学习(Representation Learning):算法可以自动学习出有效的特征,并提高最终机器学习模型的性能

- 语义鸿沟:表示学习需要解决的关键问题,即输入数据的底层特征【例如图片的像素】和高层语义信息【抽象的】之间的不一致性和差异性

- 需要学到好的高层语义表示,通常需要从底层特征开始,经过多步非线性转换才能得到。深层结构可以增加特征的重用性,从而指数级地增加表示能力

局部&分布式表示

- 局部表示/离散表示/符号表示:通常可以表示为one-hot向量形式,假设共有$|\mathcal{V}|$种颜色,可以用一个$|\mathcal{V}|$维向量表示一种颜色,第i种颜色的第i维值为1

- 很好的解释性

- 稀疏的二值向量,用于线性模型时计算效率高

- 位数很高,不能扩展

- 不同颜色的相似度都是0

- 分布式表示/分散式表示:例如RGB值表示颜色

- 表示能力强,向量维度一般比较低

- 可以表示为低维的稠密向量

嵌入:可以使用神经网络将高维的局部表示空间映射到一个非常低维的分布式表示空间

,即将一个度量空间中的一些对象映射到另一个低维的度量空间中,尽可能保持不同对象之间的拓扑关系。例如将一个

维的颜色向量映射为一个RGB向量。

💡 one-hot向量:有且只有一个元素为1,其余元素都是0的向量,是数字电路中的一种状态编码。

1.4 深度学习

深度学习是机器学习的一个子问题,主要目的是从数据中自动学习有效的特征表示。”深度“指的是原始数据进行非线性转换的次数。

端到端学习

传统机器学习需要将一个任务人为地分割成很多子模块,每个模块分开学习。缺点:①每个模块需要单独优化,优化目标和任务总体目标不能保持一致;②错误传播:前一步的错误会对后续的模型造成很大影响。

端到端学习/训练:在学习过程中不进行分模块或分阶段训练,直接优化任务的总体目标。一般不需要明确地给出不同模块或阶段的功能,中间过程不需要人为干预。

1.5 人工神经网络

由多个节点(神经元)互相连接而成,不同节点的连接被赋予了不同的权重,每个权重代表了一个节点对另一个节点的影响大小。每个节点代表一种特定的函数,来自其他节点的信息经过相应的权重综合计算,输入到一个激活函数中并得到一个新的活性值(兴奋或抑制)。

- 网络容量:神经网络塑造复杂函数的能力,和可以被存储在网络中的信息的复杂度以及数量相关。

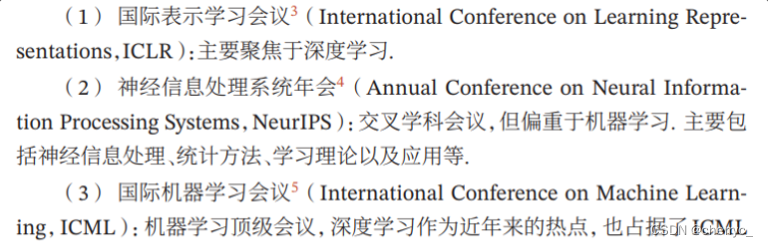

可参考会议:

202

202

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?