平均条件互信息

这个内容知道一下就行了:

这是关于 j 的一个方程。

平均互信息

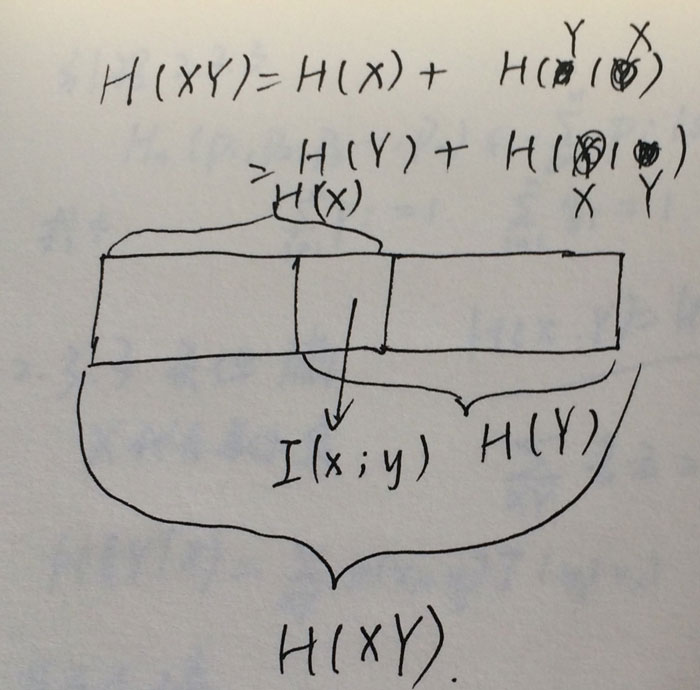

在我的文章关于熵的一个小证明里面,有这么一张图:

中间的类似交集的地方就是平均互信息。

计算方式:

它有一个极值性:

就是说它比 H(X) 和 H(Y) 都小。

无记忆

无记忆就是独立的意思

拓展信源

一组信息源

S={0,1}

,对它进行2次拓展,生成了一个新的集合:

{00,01,10,11}

,即类似取两个元素全排列;拓展信源有一个性质:

其中 N 表示N次拓展。

平稳信源

与时间起点无关,可平移。

信息量定义的一些梳理

P36 2.9 如有6行8列的棋型方格,若有2个质点

平均自信息就是所谓的“熵”,问题一要求

A

落入任一个格的平均自信息;落入格子

现在我们有48个格子,落入每个格子都有一定的信息量,也有对应的概率,所以平均自信息就是一个数学期望的计算:

这就是我们之前定义好的信息熵(H(A)),第一题的要求是求出信息熵。

第二题:若已知

A

已入,求

首先要明确一点,这是一个条件自信息,记成 I(B|A) ,概率是 p(B|A) ,用上题的方法求出平均条件自信量即可。这是一个条件熵H(B|A).

第三题:若 A,B 是可辨的,求 A,B 同时落入的平均自信息量。

这是要求联合熵 H(A,B) , 参照以前的公式即可。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?