💌 所属专栏:【大数据学习笔记(华为云)】

😀 作 者:我是夜阑的狗🐶

🚀 个人简介:一个正在努力学技术的码仔,专注基础和实战分享 ,欢迎咨询!

💖 欢迎大家:这里是CSDN,我总结知识的地方,喜欢的话请三连,有问题请私信 😘 😘 😘

您的点赞、关注、收藏、评论,是对我最大的激励和支持!!!🤩 🤩 🤩

文章目录

- 前言

- 一、HDFS编程实践

- 二、内容和要求以及代码实现

- Step 1.向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,由用户指定是追加到原有文件末尾还是覆盖原有的文件;

- Step 2.从HDFS中下载指定文件,如果本地文件与要下载的文件名称相同,则自动对下载的文件重命名;

- Step 3.将HDFS中指定文件的内容输出到终端中;

- Step 4.显示HDFS中指定的文件的读写权限、大小、创建时间、路径等信息;

- Step 5.给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息;

- Step 6.提供一个HDFS内的文件的路径,对该文件进行创建和删除操作。如果文件所在目录不存在,则自动创建目录;

- Step 7.提供一个HDFS的目录的路径,对该目录进行创建和删除操作。创建目录时,如果目录文件所在目录不存在则自动创建相应目录;删除目录时,由用户指定当该目录不为空时是否还删除该目录;

- Step 8.删除HDFS中指定的文件;

- Step 9.删除HDFS中指定的目录,由用户指定目录中如果存在文件时是否删除目录;

- Step 10.在HDFS中,将文件从源路径移动到目的路径。

- 总结

前言

大家好,又见面了,我是夜阑的狗,本文是专栏【大数据学习笔记(华为云)】专栏的第2篇文章,主要讲解是华为云HDFS编程实践。

专栏地址:【大数据学习笔记(华为云)】, 此专栏是我是夜阑的狗对HDFS编程实践,希望能够加深自己的印象,以及帮助到其他的小伙伴😉😉。

如果文章有什么需要改进的地方还请大佬不吝赐教👏👏。

一、HDFS编程实践

1.实验目的

1、理解HDFS在Hadoop体系结构中的角色;

2、熟练使用HDFS操作常用的Shell命令;

3、熟悉HDFS操作常用的Java API。

2.实验平台

1、操作系统:Linux

2、Hadoop版本:3.0.0或以上版本

3、JDK版本:1.6或以上版本

4、Java IDE:Eclipse

二、内容和要求以及代码实现

编程实现以下指定功能,并利用Hadoop提供的Shell命令完成相同任务:

Step 1.向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,由用户指定是追加到原有文件末尾还是覆盖原有的文件;

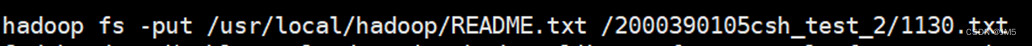

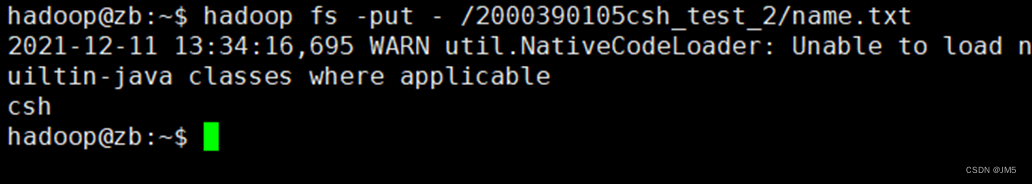

Hadoop:

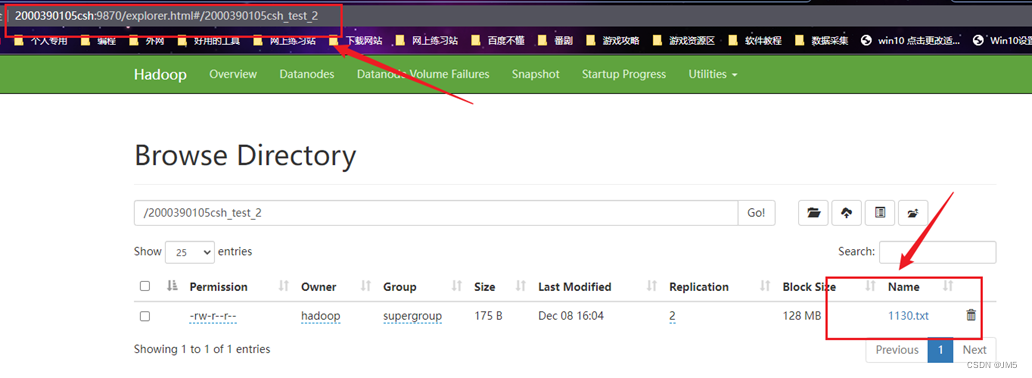

运行结果:

Java:

Tools.java

/**

* 拷贝文件到HDFS

*

* @param local

* @param remote

* @throws IOException

*/

public void copyFile(String local, String remote) throws IOException {

FileSystem fs = FileSystem.get(URI.create(hdfsPath), conf);

fs.copyFromLocalFile(new Path(local), new Path(remote));

logger.info("copy from: " + local + " to " + remote);

fs.close();

}

demo.java进行启动

public static void main(String[] args) throws Exception {

...

Tools tool = new Tools(HDFS, conf);

tool.copyFile("K:\\04a.txt","/2000390105csh_test_2/1131.txt");

...

}

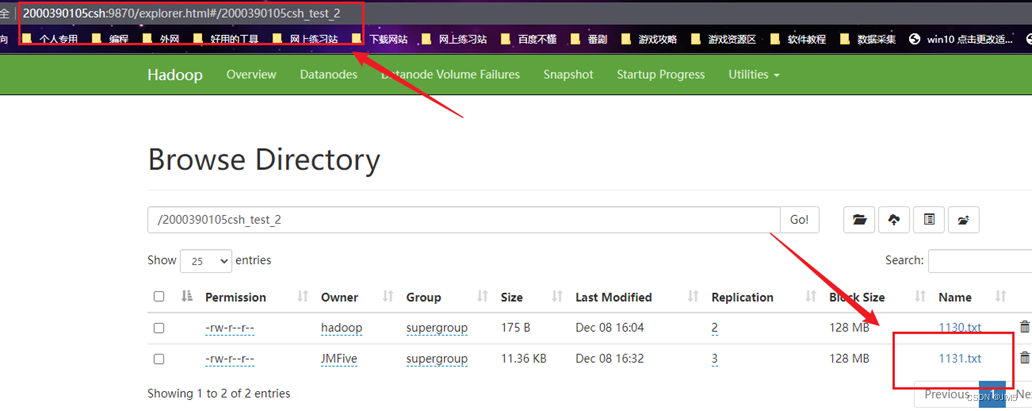

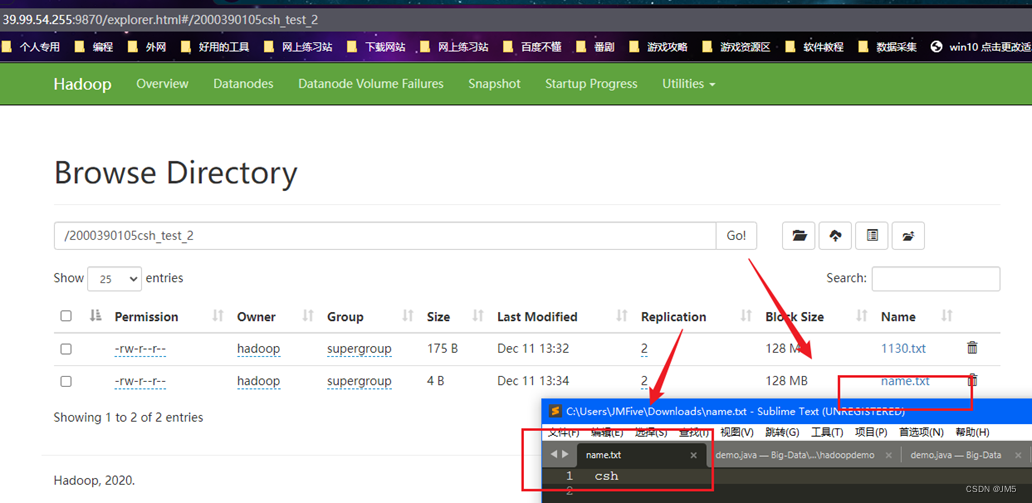

运行结果:

Step 2.从HDFS中下载指定文件,如果本地文件与要下载的文件名称相同,则自动对下载的文件重命名;

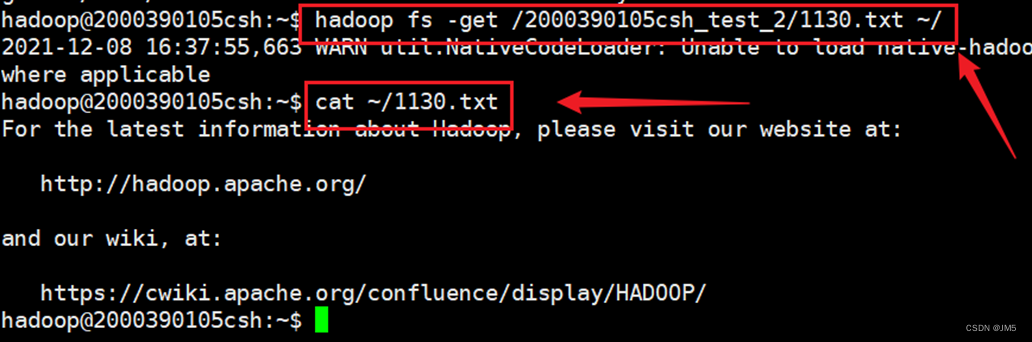

Hadoop:

Java:

Tools.java

/**

* 从HDFS中下载文件到本地中

*

* @param remote

* @param local

* @throws IOException

*/

public void download(String remote, String local) throws IOException {

Path path = new Path(remote);

FileSystem fs = FileSystem.get(URI.create(hdfsPath), conf);

fs.copyToLocalFile(path, new Path(local));

logger.info("download: from" + remote + " to " + local);

fs.close();

}

demo.java进行启动

public static void main(String[] args) throws Exception {

...

Tools tool = new Tools(HDFS, conf);

tool.download("/2000390105csh_test_2/1131.txt","K:\\");

...

}

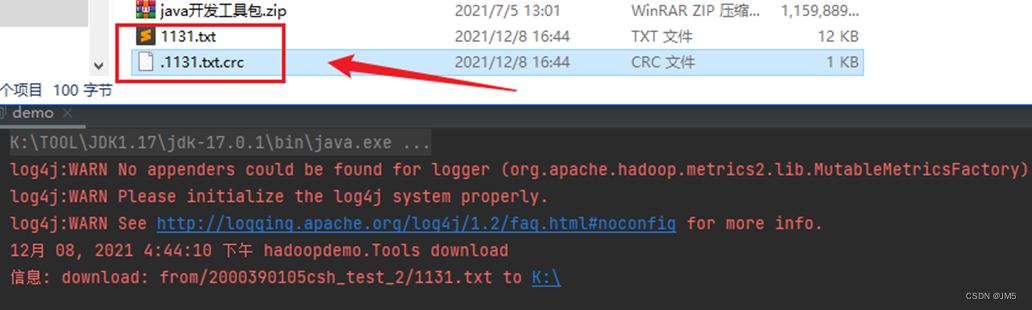

运行结果:

Step 3.将HDFS中指定文件的内容输出到终端中;

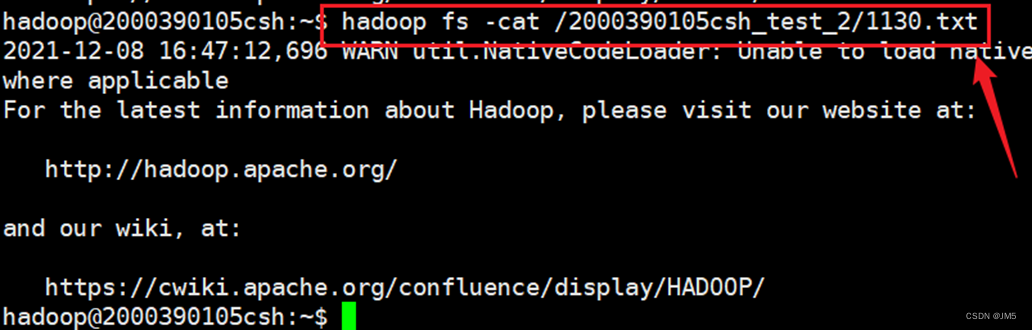

Hadoop:

Java:

Tools.java

/**

* 查看文件中的内容

*

* @param remoteFile

* @return

* @throws IOException

*/

public String cat(String remoteFile) throws IOException {

Path path = new Path(remoteFile);

FileSystem fs = FileSystem.get(URI.create(hdfsPath), conf);

FSDataInputStream fsdis = null;

logger.info("cat: " + remoteFile);

OutputStream baos = new ByteArrayOutputStream();

String str = null;

try {

fsdis = fs.open(path);

IOUtils.copyBytes(fsdis, baos, 4096, false);

str = baos.toString();

} finally {

IOUtils.closeStream(fsdis);

fs.close();

}

System.out.println(str);

return str;

}

//返回给定文件的位置

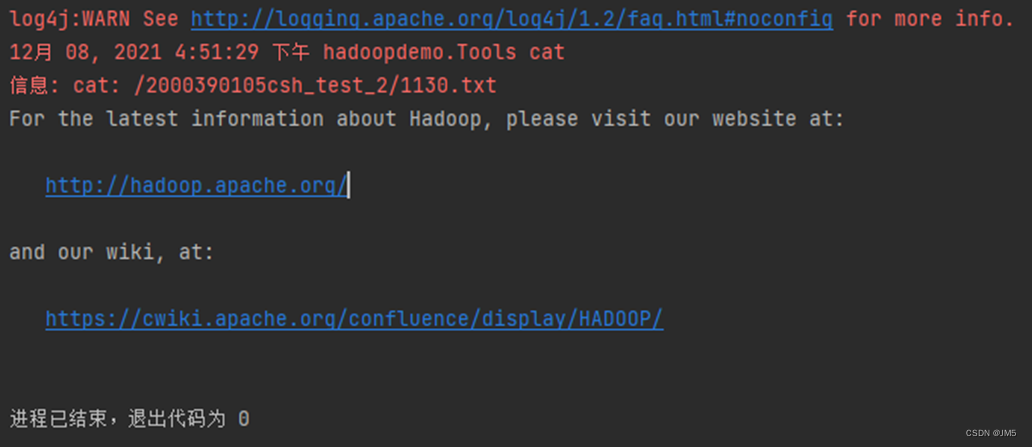

运行结果:

Step 4.显示HDFS中指定的文件的读写权限、大小、创建时间、路径等信息;

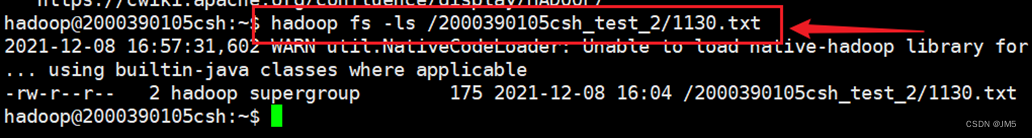

Hadoop:

Java:

Tools.java

/**

* 遍历文件

*

* @param folder

* @throws IOException

*/

public void ls(String folder) throws IOException {

Path path = new Path(folder);

FileSystem fs = FileSystem.get(URI.create(hdfsPath), conf);

FileStatus[] list = fs.listStatus(path);

logger.info("ls: " + folder);

logger.info("==========================================================");

for (FileStatus f : list) {

System.out.printf("name: %s, folder: %s, size: %d\n", f.getPath(),

f.isDir(), f.getLen());

}

logger.info("==========================================================");

fs.close();

}

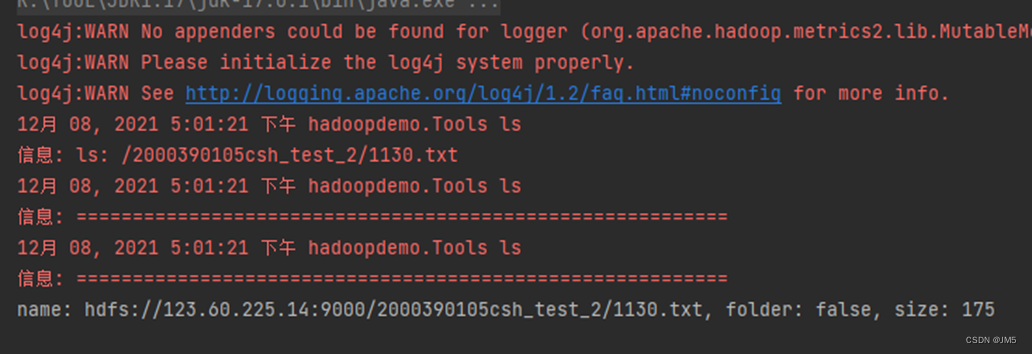

运行结果:

Step 5.给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息;

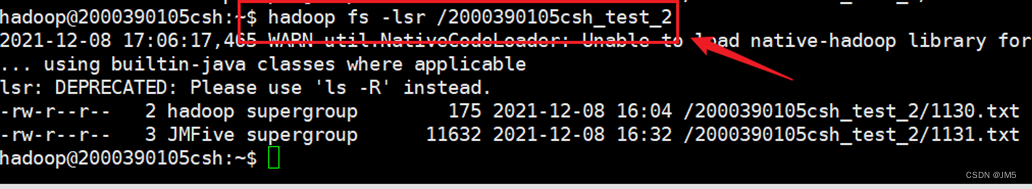

Hadoop:

Step 6.提供一个HDFS内的文件的路径,对该文件进行创建和删除操作。如果文件所在目录不存在,则自动创建目录;

Hadoop:

运行结果:

Step 7.提供一个HDFS的目录的路径,对该目录进行创建和删除操作。创建目录时,如果目录文件所在目录不存在则自动创建相应目录;删除目录时,由用户指定当该目录不为空时是否还删除该目录;

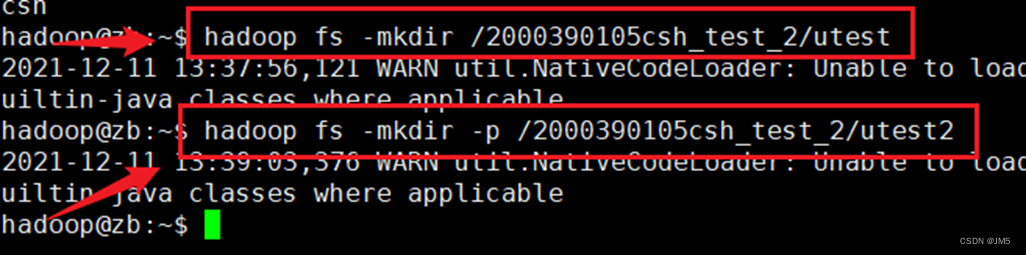

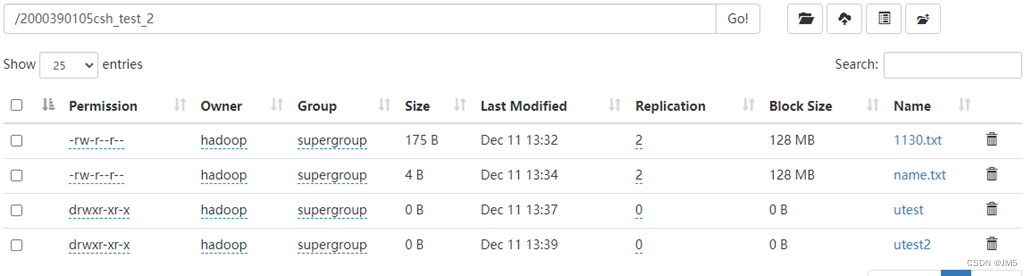

Hadoop:

运行结果:

Step 8.删除HDFS中指定的文件;

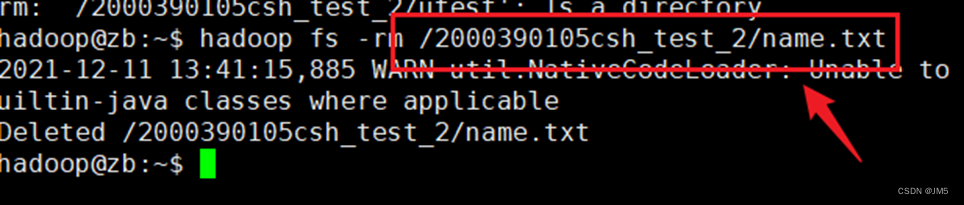

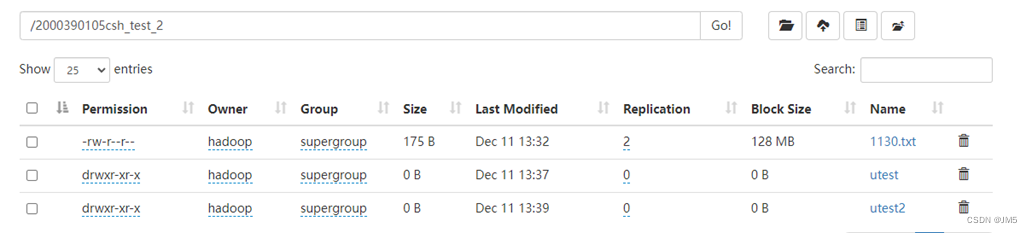

Hadoop:

运行结果:

Step 9.删除HDFS中指定的目录,由用户指定目录中如果存在文件时是否删除目录;

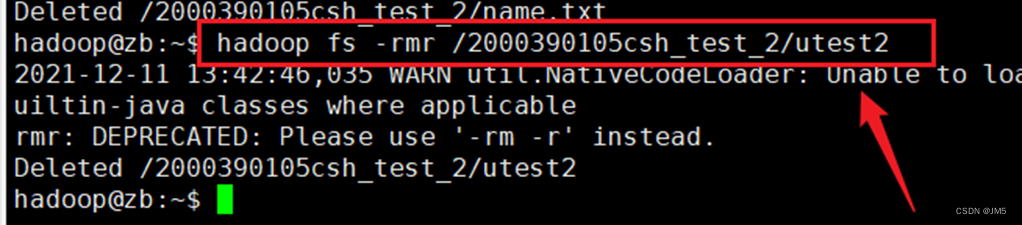

Hadoop:

运行结果:

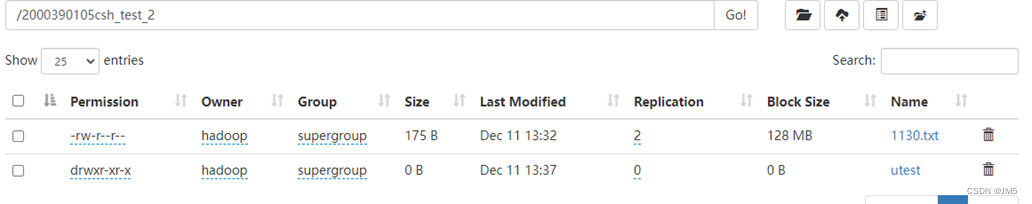

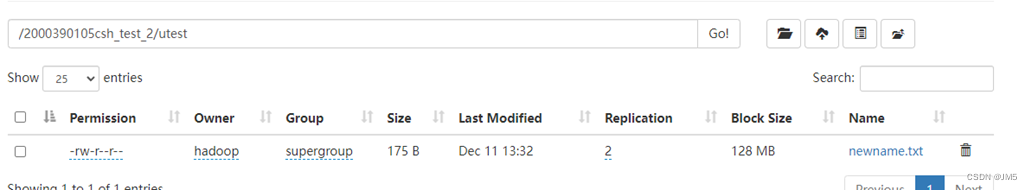

Step 10.在HDFS中,将文件从源路径移动到目的路径。

Hadoop:

运行结果:

总结

通过本次实验基本理解了 HDFS 在 Hadoop 体系结构中的角色;以及使用 HDFS 操作常用的 Shell 命令和 HDFS 操作常用的 Java API;在实验中遇到以下问题及解决方法:

问题1:在 HDFS 的 Web 端下载文件访问失败;

解决方法:在老师的讲解下,知道了要去 win10 里修改 host 文件,修改完之后就可以点击下载了。

以上就是今天要讲的内容,所以就赶紧记录一下。

感谢观看,如果有帮助到你,请给文章点个赞和收藏,让更多的人看到。🌹 🌹 🌹

也欢迎你,关注我。👍 👍 👍

原创不易,还希望各位大佬支持一下,你们的点赞、收藏和留言对我真的很重要!!!💕 💕 💕 最后,本文仍有许多不足之处,欢迎各位认真读完文章的小伙伴们随时私信交流、批评指正!下期再见。🎉

更多专栏订阅:

- 😀 【LeetCode题解(持续更新中)】

- 🌼 【鸿蒙系统】

- 👑 【Python脚本笔记】

- 🚝 【Java Web项目构建过程】

- 💛 【微信小程序开发教程】

- ⚽ 【JavaScript随手笔记】

- 🤩 【大数据学习笔记(华为云)】

- 🦄 【程序错误解决方法(建议收藏)】

- 🚀 【软件安装教程】

订阅更多,你们将会看到更多的优质内容!!

4420

4420

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?