本文综合了网上的文章及本地自行实践踩坑的记录

1.Ollama安装

实测需要有CUDA11及以上版本支持,不然会报错。因此先把显卡驱动安装好。

由于下载Ollama不方便,我把下载好的Windows版本、Linux版本和Linux版本安装脚本修改版本install.sh一起放网盘分享:https://pan.baidu.com/s/1kkr95WOd3fX1sJhAwmPBdQ?pwd=1314

1.1 Windows上部署Ollama

step1:下载Ollama

下载(https://ollama.com/download)并双击运行 Ollama 应用程序。

step2:修改模型下载位置

默认模型下载在C盘,不想占用系统盘的需要修改

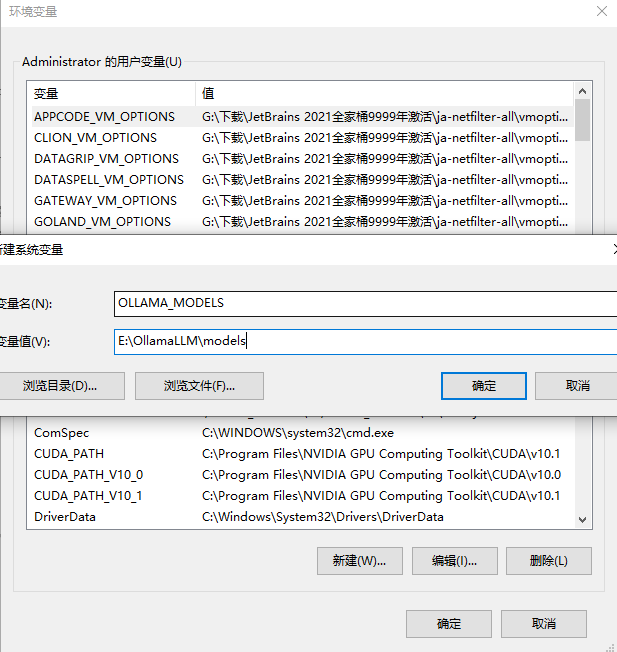

关掉ollama之后,设置环境变量

右键我的电脑-属性-高级系统设置,点击“高级系统设置”

在打开的系统属性界面中点击高级-环境变量

在环境变量界面中点击系统变量中的新建按钮

在跳出来的新建系统变量界面中,变量名设置为:OLLAMA_MODELS,变量值设置为E:\OllamaLLM\models(根据自己想放置的位置),然后点击确定对设置的环境变量进行保存。

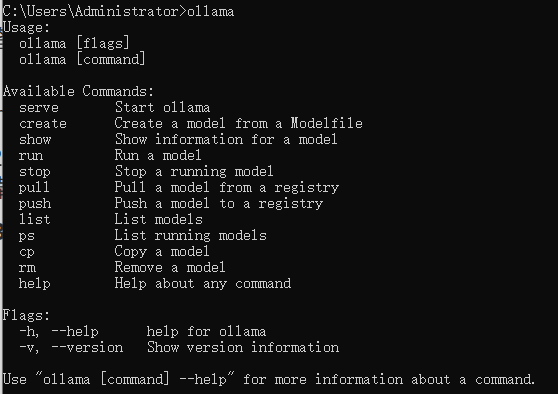

step3:验证安装

在命令行输入 ollama,如果出现以下信息,说明 Ollama 已经成功安装。

1.2 Linux上使用

如果要在Linux上安装Ollama,可以按照如下方式,我以Ubuntu20.04为例

官网给出的是安装命令,这个命令会从github自动下载安装,但基本由于网络原因失败。

curl -fsSL https://ollama.com/install.sh | sh

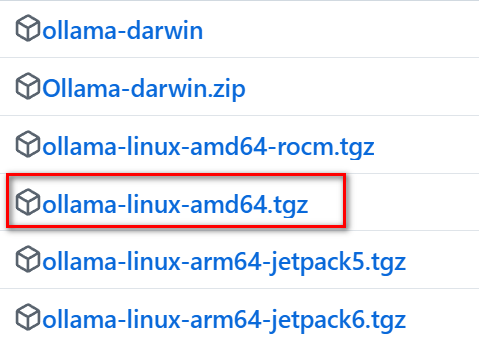

直接访问 ollama github下载最新的版本,目前是0.5.7

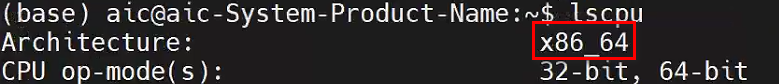

先在Linux上确定自己的CPU架构:

lscpu

下载对应的包:

网上说明是直接解压缩后进行一番设置,这里官方的安装脚本已经写得很好,我们只需要修改原始的安装脚本就可以实现自动安装离线包。

从任意位置下载源码中的离线安装脚本,我这里针对的是最新的0.5.7版本:

-

原始脚本的第69行到88行如下:

for BINDIR in /usr/local/bin /usr/bin /bin; do echo $PATH | grep -q $BINDIR && break || continue done OLLAMA_INSTALL_DIR=$(dirname ${BINDIR}) if [ -d "$OLLAMA_INSTALL_DIR/lib/ollama" ] ; then status "Cleaning up old version at $OLLAMA_INSTALL_DIR/lib/ollama" $SUDO rm -rf "$OLLAMA_INSTALL_DIR/lib/ollama" fi status "Installing ollama to $OLLAMA_INSTALL_DIR" $SUDO install -o0 -g0 -m755 -d $BINDIR $SUDO install -o0 -g0 -m755 -d "$OLLAMA_INSTALL_DIR" status "Downloading Linux ${ARCH} bundle" curl --fail --show-error --location --progress-bar \ "https://ollama.com/download/ollama-linux-${ARCH}.tgz${VER_PARAM}" | \ $SUDO tar -xzf - -C "$OLLAMA_INSTALL_DIR" if [ "$OLLAMA_INSTALL_DIR/bin/ollama" != "$BINDIR/ollama" ] ; then status "Making ollama accessible in the PATH in $BINDIR" $SUDO ln -sf "$OLLAMA_INSTALL_DIR/ollama" "$BINDIR/ollama" fi这里我对其中进行注释,并对需要修改的地方进行了说明:

# 如果存在旧版本的 ollama,清理旧版本 if [ -d "$OLLAMA_INSTALL_DIR/lib/ollama" ] ; then status "Cleaning up old version at $OLLAMA_INSTALL_DIR/lib/ollama" $SUDO rm -rf "$OLLAMA_INSTALL_DIR/lib/ollama" fi # 创建安装目录 status "Installing ollama to $OLLAMA_INSTALL_DIR" $SUDO install -o0 -g0 -m755 -d $BINDIR $SUDO install -o0 -g0 -m755 -d "$OLLAMA_INSTALL_DIR"

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?