我是跟着David Silver 的视频和PPT(链接:http://davidsilver.uk/teaching/)来学习强化学习的,虽然很多人已经写了很多这方面的笔记了,但是我还是觉得应该学一点,记一点,因为我认为写是一个理清思路、加深理解的好方法。希望能坚持学下去,写下去。笔记主要是翻译并记录PPT中的内容,再加上一些个人的理解。

强化学习简介

一、机器学习方法的类型

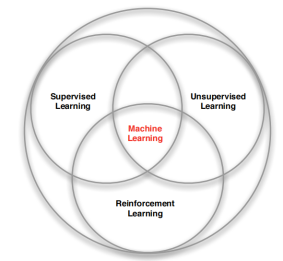

我们知道机器学习可以分为三种:有监督、无监督、强化学习。David对于三者关系的概括如图1。

图1 讲义中对三种机器学习方法关系的说明

二、强化学习的特点

- 是无监督的,只有一个奖励信号

- 反馈具有延迟

- 时序的

- 智能体的行为影响其后续获得的数据

三、应用场景

- 直升机的控制

- 游戏

- 人行机器人的行走

四、强化学习中的要素

(一)奖励(Rewards)

目标:选择动作使得未来的总奖励最大。

(二)环境(Environment)

图2 智能体和环境

智能体:每一次行动后从环境中得到一个观察,得到一个奖励;

环境:感知到一个行为后,给出一个环境的观察和一个奖励。

(三)状态

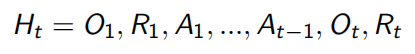

历史:观测、行为、奖励的序列

状态:用于决定下一时刻将要发生的事件的信息

二者的关系:

![]()

而状态又可以分为:

1.环境状态

2.智能体状态:强化学习的算法使用的信息

3.信息状态:包含所有来自历史的有用信息

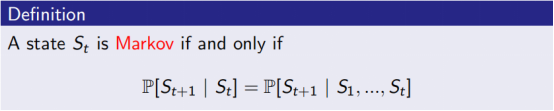

- 有了当前的状态后,将来的状态独立于历史状态了

![]()

- 环境状态是马尔科夫的

- 历史是马尔科夫的

从可见性角度可以分为:全部可见环境和部分可见环境

五、关于智能体

一个智能体可能由以下一个或多个要素组成:

- 策略(policy)

- 价值函数(value function)

- 模型(model)

1688

1688

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?