强化学习笔记-强化学习概述

机器学习分类

作为人工智能的重要分支,机器学习主要分为三大类:监督学习、非监督学习、强化学习。如图:

强化学习与监督学习的异同点

监督学习需要人工给定标记,通过对具有标记的训练样本进行学习,以期正确地对训练集之外的样本标记进行预测。非监督学习无需给定标记,通过对没有标记的训练样本进行学习,以挖掘训练样本中潜在的结构信息。

而强化学习与上述两种学习方法均不同:

第一个区别:强化学习的训练样本(这里指的是智能体与环境交互产生的数据)没有任何标记,仅有一个延迟的回报信号。强化学习通过对训练数据进行学习,以期获得从状态到行动的映射。

第二个区别:监督学习和非监督学习的数据是静止的,不需要与环境进行交互,如分类聚类。而强化学习是一个序贯决策(Sequential Decision Making)的过程,需要不断的与环境进行交互来产生数据,并且产生的数据之间存在高度的相关关系。因此,相对于监督学习与非监督学习,强化学习涉及的对象更多、更复杂,如动作、环境、状态转移概率和回报函数等。

强化学习基本原理

智能体通过与环境不断地交互,借助环境的反馈来调整自己的行为,使得累积回报最大。

强化学习包括智能体和环境两大对象,智能体是算法本身,环境是与智能体交互的外部。智能体通过行为a作用于环境,环境反馈给智能体改变前后的状态s和s‘,以及回报r。如图所示:

强化学习解决的是什么样的问题

强化学习要解决的就是决策类问题,即求取当前状态下最优行为或行为概率。

强化学习分类

(1)有模型方法与无模型方法:根据智能体(agent)在解决强化学习问题时是否建立环境动力学模型划分。其中,在已知模型的环境中学习及求解的方法叫作有模型方法,如动态规划法;使用不依赖环境模型的方法,叫做无模型方法,如蒙特卡罗、时序差分法。

(2)解决强化学习的估计方法分为两种:建立状态值估计、建立策略的估计。可以根据不同的估计方法,将强化学习分为以下三类:

基于值函数(Value Based)的方法:求解时仅估计状态值函数,不去估计策略函数,最优策略在对值函数进行迭代求解时间接得到。如动态规划方法、蒙特卡罗方法、时序差分方法、值函数逼近法。

基于策略(Policy Based)的方法:最优行为或策略直接通过求解策略函数产生,不去求解各状态值的估计函数。所有的策略函数逼近方法都属于基于策略的方法,如蒙特卡罗策略梯度、时序差分策略梯度。

行动者-评论家方法(Actor-Critic,AC):求解方法中既有值函数估计又有策略函数估计。如优势行动者-评论家方法(A2C),异步优势行动者-评论家方法(A3C)

请分别解释随机性策略和确定性策略

确定性策略指的是一个将状态空间映射到动作空间的函数。它本身没有随机性质,所以通常会结合ϵ \epsilonϵ-greey或往动作值中加入高斯噪声的方法来增加策略的随机性。一般都存在于基于值的算法中。

随机性策略是条件为π ( a ∣ s ) \pi(a|s)π(a∣s)情况下,动作a的条件概率分布。它本身带有随机性,获取动作时只需对概率分布进行采样即可。一般存在于基于策略的算法中。

回报、值函数、行为值函数三个指标的定义是什么

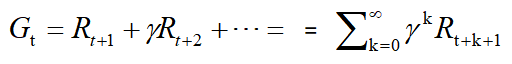

回报Gt为从t时刻开始往后所有的回报的有衰减的总和,也称“收益”或“奖励”。公式如下:

请分别解释以下三对概念:学习与规划、探索与利用、预测与控制

学习与规划:二者是强化学习的两大类方法,分别适用于不同的情境。

学习针对的是环境模型未知的情况,智能体不知道环境如何工作,状态如何转变,以及每一步的回报是多少,仅通过与环境进行交互,采用试错法逐渐改善其策略。

规划针对的是智能体已经知道或近似知道环境如何工作的情况,此时智能体并不直接与环境发生实际的交互,而是利用其拟合的环境模型获得状态转换概率和回报,在此基础上改善其策略。

探索是指智能体在某个状态下试图去尝试一个新的行为,以图挖掘更多的关于环境的信息。利用则是智能体根据已知信息,选取当下最优的行为来最大化回报。智能体在决策时需要平衡探索与利用两个方面。

预测和控制也叫评估与改善,是解决强化学习问题的两个重要的步骤。在解决一个具体的马尔可夫决策问题时,首先需要解决关于预测的问题,即评估当前这个策略有多好,具体做法一般是求解在既定策略下的状态值函数。而后在此基础上解决关于控制的问题,即对当前策略不断优化,直到找到一个足够好的策略能够最大化未来的回报。实际解决强化学习问题时,一般是先预测后控制,循环迭代直至收敛到最优解。

小结

强化学习是机器学习的一种,它通过与环境不断地交互,借助环境的反馈来调整自己的行为,使得累积回报最大。强化学习要解决的就是决策类问题,即求取当前状态下最优行为或行为概率。

强化学习包括智能体和环境两大对象,智能体是算法本身,环境是与智能体交互的外部。智能体通过行为a作用于环境,环境反馈给智能体改变前后的状态s和s‘,以及回报r。根据状态转移概率和回报是否已知,强化学习方法可以分为有模型方法和无模型方法。同时,根据在解决强化学习问题时,是对策略函数还是值函数进行逼近,强化学习方法可以分为基于值函数的方法、基于策略函数的方法以及行动者-评论家方法。

参考书:《强化学习》 邹伟 鬲玲 刘昱杓 著

1536

1536

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?