| 题目 | Pattern-Matching Dynamic Memory Network for Dual-Mode Traffic Prediction |

|---|---|

| 作者 | Wenchao Weng、Mei Wu、Hanyu Jiang、Wanzeng Kong、Xiangjie Kong、Feng Xia 和RGDAN(Neural Networks 2024)、DDGCRN(PR 2024)同作者团队 |

| 论文链接 | https://arxiv.org/abs/2408.07100 |

| 关键词 | 流量预测、记忆网络、注意力转移、交通模式、时间嵌入 |

摘要

近年来,深度学习在交通预测领域越来越受到关注。现有的交通预测模型通常依赖于具有O(N²)复杂度的GCN或注意力机制来动态提取交通节点特征,这些方法效率低下且不够轻量。此外,这些模型通常只利用历史数据进行预测,而没有考虑目标信息对预测的影响。为了解决这些问题,我们提出了一种模式匹配动态记忆网络(PM-DMNet)。PM-DMNet采用了一种新颖的动态记忆网络,以仅O(N)的复杂度捕捉交通模式特征,大大降低了计算开销,同时实现了优异的性能。PM-DMNet还引入了两种预测方法:递归多步预测(RMP)和并行多步预测(PMP),它们利用目标时间特征来辅助预测过程。此外,PMP中集成了一种传输注意力机制,将历史数据特征转换为更好地与预测目标状态对齐的特征,从而更准确地捕捉趋势变化并减少误差。大量实验结果证明了所提模型相对于现有基准模型的优越性。源代码:https://github.com/wengwenchao123/PM-DMNet。

I.引言

随着社会和技术的发展,城市内的车辆数量显著增加,类似共享单车和叫车平台(如Uber和滴滴)等服务也日益流行。这种扩展扩大了政府在城市交通管理中的应用,同时也增加了公共交通的需求。然而,有限的资源和不完善的调度系统导致了交通管理中的挑战和运输需求的不平衡。因此,准确的交通预测在交通管理、城市规划和共享经济等领域变得至关重要。精准的交通预测可以帮助政府更好地分配社会资源,以维持城市交通的正常运行。这也可以帮助公司将共享单车和出租车分配到需求高的地区,避免它们在低需求区域闲置,从而减少能源消耗和乘客等待时间。

近年来,研究人员进行了大量的交通预测研究,以促进智能交通系统的发展。早期的交通预测方法主要采用统计方法进行预测。例如,自回归(AR)、移动平均(MA)和自回归积分移动平均(ARIMA)模型作为最具代表性的经典统计方法,已被广泛应用于交通预测。此外,以支持向量回归(SVR)和卡尔曼滤波器为代表的机器学习技术也被应用于交通预测,以实现更准确的预测并处理更复杂的序列。然而,这些方法要求数据具有平稳性才能有效,这限制了它们捕捉交通状况中复杂的非线性时空相关性的能力。

近年来,深度学习在计算机视觉和自然语言处理等领域的进展促使研究人员探索其在交通预测中的应用,以期获得更好的结果。早期的深度学习预测模型将城市交通视为图像并将其分割为网格。卷积神经网络(CNNs)被用来分析这些网格内的空间相关性,而循环神经网络(RNNs)或CNNs则用于捕捉时间依赖性。然而,交通网络的结构可以看作是一个拓扑图,包含非欧几里得属性。CNNs只能从周围节点提取特征,无法捕捉跨空间的特征。由于图卷积网络(GCNs)在处理非欧几里得结构方面非常有效,它已被广泛应用于交通领域。此外,注意力机制也被引入时空特征建模中。

然而,当前的方法仍然存在以下限制:

-

缺乏有效的交通特征提取:交通数据本质上表现出复杂的时空相关性。为了捕捉这些时空相关性,研究人员采用了GCN来捕捉节点之间的空间关系,取得了显著的成功。如**图1(a)**所示,当前的方法需要评估所有节点对之间的相关性,以动态生成图结构,然后使用GCN提取时空相关性,这导致了O(N²)的计算复杂度。

然而,在实际场景中,交通网络的结构通常表现出稀疏性,这意味着节点通常只与其他节点的子集相关联,大多数节点之间没有相关性。如**图2(a)**所示,节点A、B和C表现出明显的相关性,代表了一种特定的交通模式,而节点D和E则代表了另一种交通模式。计算节点A、B、C与节点D、E之间的相似性是无意义且资源密集的。

最近的研究致力于减少计算复杂度,但每种方法都有其局限性。例如,STWave引入了MS-ESGAT(基于多尺度边的空间图注意力)机制来实现线性复杂度。然而,这种方法高度依赖于预定义的图结构,因此在没有预定义图的情况下不适用。

- 趋势变化预测的不确定性:**图2(b)**展示了两组历史数据及其对应的预测目标,其中红色部分表示历史数据,黄色部分表示预测目标。如图所示,左侧的历史数据及其对应的预测目标保持在一个稳定的趋势通道内。然而,在右侧,虽然历史数据也在稳定的趋势通道内,但对应的预测目标转变为下降趋势通道。这表明,仅依赖历史数据进行预测,很难捕捉到这种趋势变化。尽管当前的研究提出了各种方法来提取时空特征,但它们主要依赖历史数据来模拟交通状况,因此在准确捕捉预测目标的趋势变化方面存在局限性。

为了解决上述问题,本文提出了一种新型的模式匹配动态记忆网络(PM-DMNet)模型来进行交通预测。对于第一个挑战,设计了一个动态记忆网络(DMN)用于从节点中提取模式特征。具体而言,定义了一个可学习的记忆矩阵来学习交通状况中的代表性交通模式。然后将模型输入的交通特征与这些嵌入结合使用,计算出模式注意力矩阵,从而提取与输入数据最相似的交通模式特征。同时,DMN通过结合时间嵌入与记忆嵌入,动态调整每个时间点的代表性交通模式,从而避免交通模式同质化问题。此外,如图1所示,相较于GCN的高计算复杂度O(N²),该方法将计算复杂度降低至O(N),显著提升了计算效率。

为了解决第二个挑战,设计了两种预测方法:递归多步预测(RMP)和并行多步预测(PMP)。RMP采用传统的递归方法,在解码阶段通过递归利用时间特征和提取的隐藏特征来进行预测。而PMP直接使用目标时间点的时间特征和从历史数据中提取的隐藏特征进行预测。为减少历史数据与预测目标之间的差异所引起的误差,在PMP中引入了一种新的传输注意力机制。具体来说,该注意力机制通过整合输入数据、其时间特征及预测目标的时间特征,利用交通数据的固有周期性,将隐藏状态转换为更符合目标时间点条件的状态。这种方法提高了提取的潜在特征对预测目标状态的适应性,从而提升了预测精度。此外,由于PMP不涉及递归过程,因此与RMP相比减少了所需的计算时间,并且还提高了预测性能。

总而言之,本文的贡献总结如下:

-

我们提出了一种新的交通预测模型,名为模式匹配动态记忆网络(PM-DMNet)。该模型可以根据需求在解码阶段实现并行多步预测(PMP)和递归多步预测(RMP)。与RMP相比,PMP避免了循环递归过程,从而提高了计算效率。

-

我们提出了一种新颖的动态记忆网络(DMN)模块,旨在学习与每个节点相关的数据中的内在代表性交通模式。通过采用模式匹配的方法,该模块能够识别并提取与输入数据最相似的交通模式特征,同时有效减少计算开销。

-

我们引入了一种新的传输注意力机制(TAM)。TAM将现有的历史隐藏状态转换为与预测目标特征对齐的潜在状态,从而减少历史数据与预测目标之间的误差。

-

在十个真实数据集上的实验结果证明,我们提出的框架在所有数据集上都显著优于现有的先进方法。

II.相关工作

A. 时空预测

作为时空预测中最具代表性的任务之一,研究人员采用了多种方法来对交通条件中的时空特征进行建模。STGCN利用GCN和预定义矩阵捕捉节点之间的空间关联,并采用门控卷积神经网络来对这些空间依赖性进行建模。DCRNN将扩散卷积与GRU相结合,以建模交通条件中固有的时空关系。MTGNN利用了自适应嵌入生成自适应图结构,捕捉不同节点之间的空间关联。CCRNN引入了一种新的图卷积结构,称为CGC,并采用分层耦合机制,将上层图结构与下层图结构连接起来,以提取时空特征。GMAN利用了三种不同的注意力机制来捕捉交通条件中的时空特征。MPGCN利用GCN通过聚类识别公交站的移动模式,并使用GCN2Flow来预测基于不同移动模式的乘客流量。在MPGCN的基础上,MPGNNFormer设计了一种STGNNFormer,用于提取时间和空间依赖性。尽管这些时空预测模型取得了显著的成功,但它们所使用的GCN和注意力机制通常需要O(N²)或更高的复杂度,从而导致了大量的计算成本。

B. 神经记忆网络

记忆网络引入了一种外部记忆机制,使其能够更好地处理和利用长期信息。记忆网络在自然语言处理和机器翻译领域得到了广泛的应用。MemN2N引入了一种新的端到端记忆网络框架,使其能够在现实环境中得到便捷应用。Kaiser等人提出了具有适应多种零样本场景能力的记忆网络。Mem2seq将多跳注意力机制与记忆网络集成在一起,使其在对话系统中得以部署。MemAE探索了记忆网络在视频异常检测任务中的应用,后续研究验证了该方法的可行性。MTNet尝试将记忆网络应用于多变量时间序列预测,取得了良好的结果。在最近的研究进展中,PM-MemNet提出了新型图卷积记忆网络用于建模给定交通条件中的时空关联。此外,MegaCRN受记忆网络原则的启发,设计了一种元图学习器,以构建动态图,解决时空异质性问题。虽然记忆网络已经应用于交通预测,但它们仍需要与其他特征提取方法(如GCN)相结合才能有效执行。

与之前的时空预测模型不同,PM-DMNet使用动态记忆网络来提取交通模式特征,实现了更高的性能,同时将复杂度降低到O(N),显著降低了计算成本。此外,以往的研究忽略了与预测目标对应的时间特征对目标本身的影响。PM-DMNet充分考虑了这一特性,并设计了两种预测方法来利用这些时间特征,从而取得了成功的结果。

III. 预备知识

A. 时间索引函数

表 1:时间索引转换示例

| 时间 | d(t) | w(t) |

|---|---|---|

| 周一, 00:05 | 0:05:00 | 周一 |

| 周一, 01:00 | 1:00:00 | 周一 |

| 周四, 01:00 | 1:00:00 | 周四 |

考虑到交通条件是以固定的时间间隔收集的,每组交通条件都具有独特的和系统的时间信息。为了有效利用这些时间特征,我们使用了一个时间索引函数来提取与时间相关的信息。令 d(t) 和 w(t) 分别表示日内索引函数和每周索引函数。这些函数将交通条件的时间信息转换为相应的日内和每周时间相关属性。具体示例请参见表1。

B. 交通预测

交通预测的目标是利用历史交通条件来预测未来的交通状况。

我们将时间 t t t 时刻道路网络中 N N N 个节点的交通状况表示为 X t ∈ R N × C X_t \in \mathbb{R}^{N \times C} Xt∈RN×C,其中 C C C 表示交通状况的维度,意味着有 C C C 种类型的交通条件。我们通过模型 f f f 对过去 n n n 个时间步的历史交通条件 X = [ X 1 , X 2 , . . . , X n ] ∈ R n × N × C X = [X_1, X_2, ..., X_n] \in \mathbb{R}^{n \times N \times C} X=[X1,X2,...,Xn]∈Rn×N×C 进行建模,以预测未来 m m m 个时间步的交通状况 Y = [ Y n + 1 , Y n + 2 , . . . , Y n + m ] ∈ R m × N × C Y = [Y_{n+1}, Y_{n+2}, ..., Y_{n+m}] \in \mathbb{R}^{m \times N \times C} Y=[Yn+1,Yn+2,...,Yn+m]∈Rm×N×C,其表达式为:

[ X 1 , X 2 , . . . , X n ] → f [ Y n + 1 , Y n + 2 , . . . , Y n + m ] [X_1, X_2, ..., X_n] \xrightarrow{f} [Y_{n+1}, Y_{n+2}, ..., Y_{n+m}] [X1,X2,...,Xn]f[Yn+1,Yn+2,...,Yn+m]

此外,对应的实际值表示为 Y ^ = [ Y ^ n + 1 , Y ^ n + 2 , . . . , Y ^ n + m ] ∈ R m × N × C \hat{Y} = [\hat{Y}_{n+1}, \hat{Y}_{n+2}, ..., \hat{Y}_{n+m}] \in \mathbb{R}^{m \times N \times C} Y^=[Y^n+1,Y^n+2,...,Y^n+m]∈Rm×N×C。

IV. 模型架构

图3展示了PM-DMNet的整体架构,该架构包括时间嵌入生成器(TE Generator)、动态模式匹配门控循环单元(DPMGRU)、以及传输注意力机制(TAM)。在接下来的章节中,我们将详细说明每个模块。

A. 时间嵌入生成器

交通状况受人们的出行习惯和生活方式影响,表现出明显的时间特征,例如早晚高峰。为了充分利用这些时间特征,我们引入了两个独立的嵌入池 T D ∈ R N d × p T^D \in \mathbb{R}^{N_d \times p} TD∈RNd×p 和 T W ∈ R N w × p T^W \in \mathbb{R}^{N_w \times p} TW∈RNw×p 来学习日内和每周模式的特征。这里, N d N_d Nd 表示一天内的时间槽数量, N w = 7 N_w = 7 Nw=7 表示一周的天数。如下图4所示,根据时间信息 t t t,我们得出了日内索引 d ( t ) d(t) d(t) 和每周索引 w ( t ) w(t) w(t)。

利用

d

(

t

)

d(t)

d(t) 和

w

(

t

)

w(t)

w(t),我们得到了相应时间点的日内时间特征嵌入

T

d

(

t

)

D

T^D_{d(t)}

Td(t)D 和每周时间特征嵌入

T

w

(

t

)

W

T^W_{w(t)}

Tw(t)W。最终,这些

T

d

(

t

)

D

∈

R

p

T^D_{d(t)} \in \mathbb{R}^p

Td(t)D∈Rp 和

T

w

(

t

)

W

∈

R

p

T^W_{w(t)} \in \mathbb{R}^p

Tw(t)W∈Rp 被集成以生成一个组合时间嵌入,可表示为:

T

t

=

T

d

(

t

)

D

⊙

T

w

(

t

)

W

T_t = T^D_{d(t)} \odot T^W_{w(t)}

Tt=Td(t)D⊙Tw(t)W

其中 ⊙ \odot ⊙ 表示Hadamard积。

B. 动态记忆网络

记忆模块包含一个可学习的记忆矩阵 P = [ P 1 , P 2 , . . . , P M ] ∈ R M × p P = [P^1, P^2, ..., P^M] \in \mathbb{R}^{M \times p} P=[P1,P2,...,PM]∈RM×p,其中 P P P 表示一个独特的交通模式。为了动态调整记忆矩阵,从而避免模式单一化并适应时间 t t t 时的当前交通状况,我们将当前时间嵌入 T t T_t Tt 与 P P P 相结合。这个融合过程可以表示为:

P t = P ⊙ T t P_t = P \odot T_t Pt=P⊙Tt

其中 P t ∈ R M × p P_t \in \mathbb{R}^{M \times p} Pt∈RM×p 代表时间 t t t 的记忆网络模块。通过训练, P t P_t Pt 可以学习时间 t t t 时最具代表性的交通模式。通过动态地整合时间嵌入 T t T_t Tt,模型可以调整其记忆 P t P_t Pt,以更好地捕捉随时间变化的交通模式和状况。

如图5所示,我们从交通条件中提取动态信号,可以表示为:

F t i = M L P ( x t i ) F_t^i = MLP(x_t^i) Fti=MLP(xti)

其中 F t i ∈ R p F_t^i \in \mathbb{R}^p Fti∈Rp 表示从节点 i i i 的交通条件 x t i x_t^i xti 中提取的动态信号。它被用于查询与 x t i x_t^i xti 最相似的交通模式记忆矩阵。

然后,通过相似度计算得到

F

t

i

F_t^i

Fti 与记忆矩阵

P

t

P_t

Pt 之间的相似度权重:

w

t

i

=

s

o

f

t

m

a

x

(

F

t

i

P

t

T

)

w_t^i = softmax(F_t^i P_t^T)

wti=softmax(FtiPtT)

其中 w t i ∈ R M w_t^i \in \mathbb{R}^M wti∈RM 表示相似度权重向量。

随后, P t P_t Pt 被线性变换以获得与各种交通模式相对应的模式特征。然后它与相似度权重向量 w t i w_t^i wti 相乘以提取与 x t i x_t^i xti 最相似的模式特征,公式如下:

h t i = w t i P t h_t^i = w_t^i P_t hti=wtiPt

其中 h t ∈ R M × F o u t h_t \in \mathbb{R}^{M \times F_{out}} ht∈RM×Fout 表示记忆矩阵 P t P_t Pt 中的模式特征,而 h t i h_t^i hti 表示提取的交通模式特征。

最后,使用残差连接将 h t i h_t^i hti 和 x t i x_t^i xti 连接起来,以提取隐藏特征:

H t i = ( h t i ∣ ∣ x t i ) Θ H_t^i = (h_t^i || x_t^i) \Theta Hti=(hti∣∣xti)Θ

其中 Θ ∈ R F i n × F o u t \Theta \in \mathbb{R}^{F_{in} \times F_{out}} Θ∈RFin×Fout 表示可学习的参数。所有节点的隐藏状态 H t i H_t^i Hti 被聚合到 H t = ( H t 1 , H t 2 , . . . , H t N ) H_t = (H_t^1, H_t^2, ..., H_t^N) Ht=(Ht1,Ht2,...,HtN) 中,作为动态记忆网络的最终输出。

C. 节点自适应参数学习

为了使每个节点学习其独特的交通模式,增强模型的鲁棒性和有效性,我们使用两个参数矩阵来优化可学习的参数 Θ \Theta Θ。具体来说,我们使用节点嵌入矩阵 E ∈ R N × d E \in \mathbb{R}^{N \times d} E∈RN×d 和权重池 W ∈ R d × F i n × F o u t W \in \mathbb{R}^{d \times F_{in} \times F_{out}} W∈Rd×Fin×Fout 来生成 Θ ∈ R N × F i n × F o u t \Theta \in \mathbb{R}^{N \times F_{in} \times F_{out}} Θ∈RN×Fin×Fout,其表达式为:

H t i = ( h t i ∣ ∣ x t i ) Θ = ( h t i ∣ ∣ x t i ) E ⋅ W H_t^i = (h_t^i || x_t^i) \Theta = (h_t^i || x_t^i) E \cdot W Hti=(hti∣∣xti)Θ=(hti∣∣xti)E⋅W

其中 ⋅ \cdot ⋅ 表示不同维度矩阵的乘法。从单个节点的角度来看, E E E 提供了 d d d 个独立的交通模式,节点通过数据驱动的方式调整 W W W,为每个模式分配适当的权重。这些权重被组合起来以创建节点的独特交通模式。

D. 动态模式匹配门控循环单元

为了捕捉交通条件中固有的时空特征,我们将门控循环单元(GRU)与动态记忆网络相结合,构建了一个同时封装时间动态和空间关联性的框架。

具体来说,我们用动态记忆网络替换了GRU中的MLP层,得到了动态模式匹配门控循环单元(DPMGRU)。数学上,DPMGRU可以表示为:

r t = σ ( ϑ r ∗ G ( x t ∣ ∣ H t − 1 ) ) r_t = \sigma(\vartheta_{r*G}(x_t || H_{t-1})) rt=σ(ϑr∗G(xt∣∣Ht−1))

u t = σ ( ϑ u ∗ G ( x t ∣ ∣ H t − 1 ) ) u_t = \sigma(\vartheta_{u*G}(x_t || H_{t-1})) ut=σ(ϑu∗G(xt∣∣Ht−1))

h t = t a n h ( ϑ h ∗ G ( x t ∣ ∣ u t ⊙ H t − 1 ) ) h_t = tanh(\vartheta_{h*G}(x_t || u_t \odot H_{t-1})) ht=tanh(ϑh∗G(xt∣∣ut⊙Ht−1))

H t = r t ⊙ H t − 1 + ( 1 − r t ) ⊙ h t H_t = r_t \odot H_{t-1} + (1 - r_t) \odot h_t Ht=rt⊙Ht−1+(1−rt)⊙ht

其中 X t X_t Xt 和 H t H_t Ht 分别表示时间步 t t t 时的输入和输出。 σ \sigma σ 表示sigmoid激活函数。 r r r 和 u u u 分别对应重置门和更新门。 ∗ G *G ∗G 表示动态记忆网络模块,而 ϑ r , ϑ u , ϑ h \vartheta_r, \vartheta_u, \vartheta_h ϑr,ϑu,ϑh 是相关记忆网络模块的可学习参数。

E. 传输注意力机制

为了减轻历史数据与预测目标之间的差异导致的错误,我们采用了一种传输注意力机制,将从历史数据中学到的隐藏特征进行转换。具体来说,我们首先将编码器的输出 H n ∈ R N × D H_n \in \mathbb{R}^{N \times D} Hn∈RN×D、历史时间嵌入 T n ∈ R p T_n \in \mathbb{R}^p Tn∈Rp 和未来嵌入 T F = ( T n + 1 , T n + 2 , . . . , T n + m ) ∈ R m × p T_F = (T_{n+1}, T_{n+2}, ..., T_{n+m}) \in \mathbb{R}^{m \times p} TF=(Tn+1,Tn+2,...,Tn+m)∈Rm×p 转换为查询、键和值,表示为:

Q = ∀ ( H n , T F ) W Q , K = ∀ ( H n , T n ) W K , V = ∀ ( H n , T n ) W V Q = \forall(H_n, T_F)W^Q, \quad K = \forall(H_n, T_n)W^K, \quad V = \forall(H_n, T_n)W^V Q=∀(Hn,TF)WQ,K=∀(Hn,Tn)WK,V=∀(Hn,Tn)WV

其中 W Q , W K , W V ∈ R ( D + p ) × d k W^Q, W^K, W^V \in \mathbb{R}^{(D+p) \times d_k} WQ,WK,WV∈R(D+p)×dk 作为可学习参数, V ( ⋅ ) \mathbb{V}(\cdot) V(⋅) 表示广播操作。随后,传输注意力可以表示为:

H T A = a t t e n t i o n ( H , T F , T n ) = s o f t m a x ( Q K T d K V ) H_{TA} = attention(H, T_F, T_n) = softmax\left(\frac{QK^T}{\sqrt{d_K}} V\right) HTA=attention(H,TF,Tn)=softmax(dKQKTV)

最终,通过残差连接实现了 H n H_n Hn 和 H T A ∈ R m × N × D H_{TA} \in \mathbb{R}^{m \times N \times D} HTA∈Rm×N×D 之间的特征融合,以获得解码器的输入:

H o u t = M L P ( ∀ ( H n , H T A ) ) H_{out} = MLP(\forall(H_n, H_{TA})) Hout=MLP(∀(Hn,HTA))

其中 H o u t = ( H n + 1 , H n + 2 , . . . , H n + m ) ∈ R m × N × D H_{out} = (H_{n+1}, H_{n+2}, ..., H_{n+m}) \in \mathbb{R}^{m \times N \times D} Hout=(Hn+1,Hn+2,...,Hn+m)∈Rm×N×D 对应于从时间点 n + 1 n+1 n+1 到 n + m n+m n+m 的预测目标的隐藏特征。通过采用 T N T_N TN 和 T F T_F TF,这些特征经历传输学习,更有效地适应预测目标时间点的状态。

F. 编码器-解码器架构

传统的编码器-解码器架构通常采用递归多步预测(RMP)方法进行预测。然而,递归解码存在固有的局限性,包括:(i)由于递归预测导致的错误积累,以及(ii)递归的顺序性限制了模型的并行计算能力,从而限制了推理速度的提升。研究表明,当适当的技术被应用时,平行多步预测(PMP)方法可以获得与RMP相当或更好的结果。因此,设计了两种变体来实现和研究这些预测方法:

-

PM-DMNet® 如**图6(a)**所示,PM-DMNet®采用经典的递归多步预测(RMP)方法,其中 Y t Y_t Yt 通过单步预测得出。随后,预测的 Y t Y_t Yt 作为输入用于预测 Y t + 1 Y_{t+1} Yt+1,重复此过程,直到获得完整的预测输出。

-

PM-DMNet§ 受研究的启发,PM-DMNet§采用平行多步预测(PMP)方法。如图**6(b)**所示,在解码阶段,编码器的输出 H n H_n Hn 首先通过TAM处理得到 H o u t H_{out} Hout,缓解了历史数据与预测目标之间的差异,使其更接近预测目标的状态。随后, H o u t = ( H n + 1 , H n + 2 , . . . , H n + m ) H_{out} = (H_{n+1}, H_{n+2}, ..., H_{n+m}) Hout=(Hn+1,Hn+2,...,Hn+m) 和 T F = ( T n + 1 , T n + 2 , . . . , T n + m ) T_F = (T_{n+1}, T_{n+2}, ..., T_{n+m}) TF=(Tn+1,Tn+2,...,Tn+m) 被分段并输入到PDMGRU中,以预测相应的目标 Y = ( Y n + 1 , Y n + 2 , . . . , Y n + m ) Y = (Y_{n+1}, Y_{n+2}, ..., Y_{n+m}) Y=(Yn+1,Yn+2,...,Yn+m)。由于不需要递归编译,预测目标 Y Y Y 可以并行预测,避免了递归步骤中预测错误积累的问题。

模型训练和预测的详细内容见算法1。

V. 实验设置

A. 数据集与设置

在本节中,实验使用了十个真实世界的数据集来验证所提出的PM-DMNet的有效性。

所使用的数据集分为四类:

- 自行车需求数据集包括NYC-Bike14、NYC-Bike15和NYC-Bike16;

- 出租车需求数据集包括NYC-Taxi15和NYC-Taxi16;

- 交通流量数据集包括PEMSD4、PEMSD7和PEMSD8;

- 交通速度数据集包括PEMSD7(M)和PEMSD7(L)。

关于数据集的详细信息和训练集划分见表II。

此外,与交通流量和交通速度数据集不同,交通需求数据集具有两个维度:“接客”(Pick-up)和“放客”(Drop-off)。我们设置 n = 12 n = 12 n=12 个历史时间步来预测 m = 12 m = 12 m=12 个未来时间步。

所有实验均在配备NVIDIA GeForce GTX 4090 GPU的服务器上进行。Adam优化器用于模型优化,并采用平均绝对误差(MAE)作为损失函数。模型的超参数设置,包括时间嵌入维度 p p p、节点嵌入维度 d d d、记忆网络矩阵维度 M M M、批次大小和学习率,详见表III。在训练期间,采用了提前停止策略来终止训练并防止过拟合。此外,对PM-DMNet®应用了预定采样策略以增强其鲁棒性。

B. 基线

为了比较性能,以下24个具有官方代码的基线与PM-DMNet进行了比较:

-

传统模型:

- HA:利用历史平均值迭代预测未来。

- ARIMA:将移动平均集成到自回归模型中。

- VAR:一种能够捕捉空间依赖性的统计模型。

-

机器学习模型:

- SVR:使用支持向量机进行预测。

- XGBoost:一种经典且广泛采用的机器学习模型。

-

深度学习模型:

- LSTM:通过迭代进行预测。

- TCN:采用因果卷积和扩展卷积捕捉时间关联。

- STGCN:使用图卷积和一维卷积神经网络分别提取空间和时间关联。

- DCRNN:结合扩散卷积和GRU提取时空关联。

- STG2Seq:从长期和短期角度捕捉时间依赖性。

- GWN:结合门控TCN和自适应图卷积捕捉时空依赖性。

- ASTGCN:对时空卷积进行注意力机制分析以提取动态时空关联。

- LSGCN:使用图卷积网络和一种新的余弦图注意力网络捕捉长期和短期空间依赖性。

- STFGNN:设计了一个时空融合图以捕捉局部时空关联。

- STGODE:利用神经ODE重构GCN,缓解深度GCN中的过度平滑问题。

- GTS:学习多时间序列之间的图结构,并同时使用GNN进行预测。

- ESG:设计了一个进化结构学习器来构建一系列邻接矩阵。

- MVFN:使用图卷积和注意力机制提取局部和全局空间特征,并采用多通道和可分离时间卷积网络提取整体时间特征。

- STWave:使用DWT算法对交通数据进行建模,同时设计了一种新型的局部图注意力网络,以高效地建模动态空间关联。

- MegaCRN:设计了一个元图学习器,以构建动态图,解决时空异质性问题。

C. 评价指标

选择以下三个评价指标来评估模型性能:均方根误差(RMSE)、平均绝对误差(MAE)、平均绝对百分比误差(MAPE)和经验相关系数(CORR)。

M A E = 1 ϕ ∑ i = 1 ϕ ∣ Y i − Y ^ i ∣ MAE = \frac{1}{\phi} \sum_{i=1}^{\phi} |Y_i - \hat{Y}_i| MAE=ϕ1i=1∑ϕ∣Yi−Y^i∣

R M S E = 1 ϕ ∑ i = 1 ϕ ( Y i − Y ^ i ) 2 RMSE = \sqrt{\frac{1}{\phi} \sum_{i=1}^{\phi} (Y_i - \hat{Y}_i)^2} RMSE=ϕ1i=1∑ϕ(Yi−Y^i)2

M A P E = 1 ϕ ∑ i = 1 ϕ ∣ Y i − Y ^ i Y i ∣ MAPE = \frac{1}{\phi} \sum_{i=1}^{\phi}| \frac{Y_i - \hat{Y}_i}{Y_i}| MAPE=ϕ1i=1∑ϕ∣YiYi−Y^i∣

C O R R = 1 N ∑ n = 1 N ∑ i = 1 ϕ ( Y n , i − Y n ‾ ) ( Y ^ n , i − Y ^ n ‾ ) ∑ i = 1 ϕ ( Y n , i − Y n ‾ ) 2 ( Y ^ n , i − Y ^ n ‾ ) 2 CORR = \frac{1}{N} \sum_{n=1}^{N} \frac{\sum_{i=1}^{\phi}(Y_{n,i} - \overline{Y_n})(\hat{Y}_{n,i} - \overline{\hat{Y}_n})}{\sqrt{\sum_{i=1}^{\phi}(Y_{n,i} - \overline{Y_n})^2 (\hat{Y}_{n,i} - \overline{\hat{Y}_n})^2}} CORR=N1n=1∑N∑i=1ϕ(Yn,i−Yn)2(Y^n,i−Y^n)2∑i=1ϕ(Yn,i−Yn)(Y^n,i−Y^n)

其中 ϕ \phi ϕ 表示预测序列的长度, Y n ‾ \overline{Y_n} Yn 和 Y ^ n ‾ \overline{\hat{Y}_n} Y^n 分别表示节点 n n n 处的真实值和预测值的均值。较小的这些指标值表示更高的预测精度和更好的预测性能。

VI. 实验

A. 性能比较

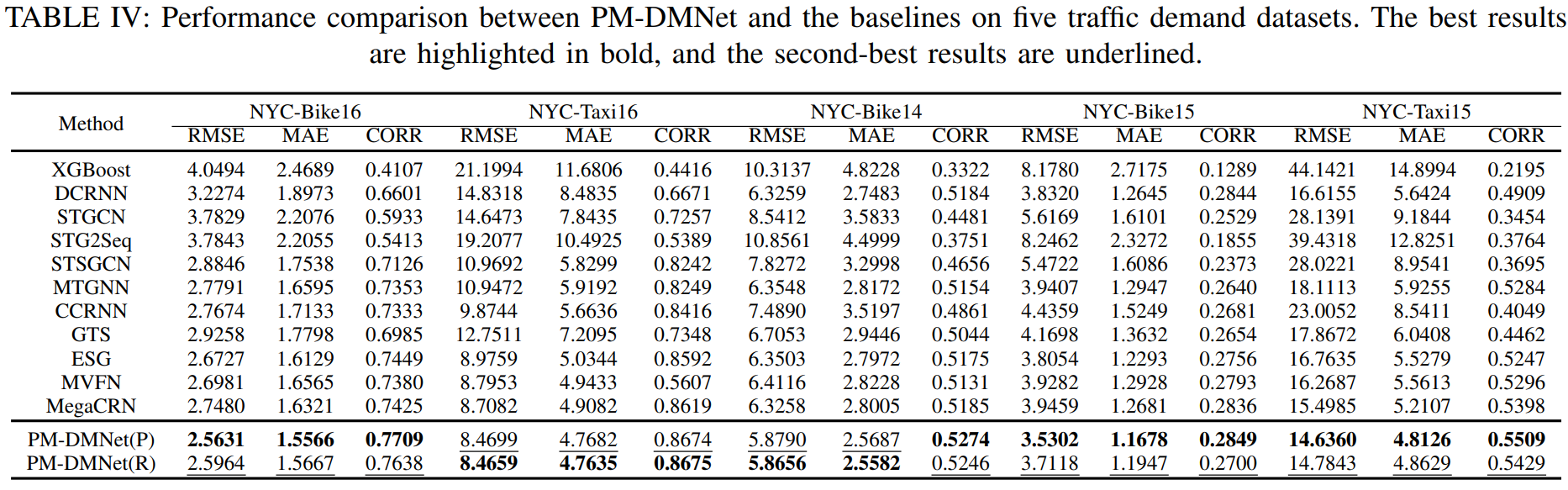

表IV展示了我们模型与基线模型在不同数据集上的表现结果。显然,我们的模型在所有五个数据集上都达到了最佳结果。XGBoost作为一种机器学习模型,未能捕捉到交通条件中的非线性关系,导致其表现较差。DCRNN、STGCN和STG2Seq利用预定义的图结构来捕捉时空关联,从而产生了令人满意的结果。然而,由于这些预定义图结构中的权重固定,无法捕捉动态关联,留下了显著的改进空间。MTGNN和GTS通过自适应地从数据中学习图结构,取得了令人赞赏的进展。然而,这些自适应图依然是静态的,未能捕捉节点之间的动态关系。MegaCRN采用元图学习器构建动态图,以从节点之间提取关联。然而,它未考虑时间信息对交通模式的影响,限制了其表现。PM-DMNet通过利用动态记忆网络来动态提取特征,基于历史数据识别最相似的交通模式,表现出色。

图7展示了PM-DMNet与三个基线模型在不同预测时长上的预测误差。可以看出,除了最初的三个预测时间步外,PM-DMNet在所有时间段内始终实现了比基线模型更低的预测误差。此外,PM-DMNet的误差增长率比基线模型在所有时间段内都要慢。

利用演化图的功能,ESG在短期预测表现上与PM-DMNet相当。然而,随着预测时长的增加,ESG的误差增长率显著高于PM-DMNet,导致整体表现不如PM-DMNet。通过利用与预测目标对应的时间信息,PM-DMNet显著减少了预测不确定性,从而提高了性能。

表V展示了我们的模型与基线模型在交通流量/速度数据集上的表现结果。可以看到,除了PEMSD8数据集上STWave稍微优于PM-DMNet§且与PM-DMNet®相当外,我们的模型在所有数据集上都实现了最佳表现。

图8显示了PM-DMNet和其他两个最佳基线模型在不同预测时长上的预测误差。从图8中可以明显看出,模型之间的误差差距在流量数据集中比在速度数据集中更为明显,表明预测交通速度比预测交通流量更具挑战性。STWave利用DWT算法将交通数据分解为两个独立的低频和高频序列,并分别建模,同时考虑时间信息的影响,结果在交通流量数据集上表现良好。然而,在速度数据集中,由于交通速度和交通流量之间的固有差异,DWT算法难以分解出有用的高频和低频序列,导致STWave的表现与MegaCRN相当。PM-DMNet不依赖于序列分解进行建模,从而避免了无效分解相关的困难,在流量和速度数据集上表现出色。

B. 计算成本

为了比较和展示我们模型的计算效率,我们评估了所选模型的训练时间、推理时间和GPU成本。所有模型的批次大小均设置为32。表VI显示了PM-DMNet相较于基线模型的计算成本。如表VI所示,PM-DMNet§的训练和推理时间显著低于其他基线模型,并且在计算速度和内存使用方面优于PM-DMNet®。尽管ESG的表现强劲,但其高GPU成本和相对较慢的处理速度在部署时带来了挑战。尽管STWave采用了新型图注意力机制来优化建模速度,但其复杂的网络结构仍然需要大量的GPU资源和长时间的训练。MegaCRN在使用简单的自适应图卷积方法提取节点间的空间关联时,通过采用RMP方法,在训练时间和GPU成本上较低。因此,在节点较少的数据集上,MegaCRN的训练时间与使用RMP方法的PM-DMNet§相当。然而,在大规模节点数据集中,GCN的 O ( N 2 ) O(N^2) O(N2) 复杂度仍然需要更高的训练时间和GPU成本。相比之下,PM-DMNet§使用的动态记忆网络的时间复杂度为 O ( N ) O(N) O(N),远低于图卷积网络(GCNs)的 O ( N 2 ) O(N^2) O(N2) 复杂度。因此,在PEMSD7数据集上,PM-DMNet§表现出更快的训练速度和更低的GPU成本,展示了我们模型在计算速度方面的优势。

C. 复杂性分析

GCN中特征聚合的计算复杂度为 O ( N 2 ) O(N^2) O(N2),而注意力机制中矩阵计算和特征聚合的计算复杂度也为 O ( N 2 ) O(N^2) O(N2)。对于DMN,计算相似度权重和特征聚合的计算复杂度为 O ( N M ) O(NM) O(NM),其中 M M M 是一个比 N N N 小得多的常数值。当 M M M 远小于 N N N 时,DMN的时间复杂度可视为 O ( N ) O(N) O(N)。因此,与GCN和注意力机制相比,DMN在时间和内存复杂性方面具有显著优势。

D. 递归多步预测与平行多步预测

在本小节中,比较了PMP和RMP预测方法的表现。表IV和表V展示了PM-DMNet§和PM-DMNet®在交通需求和交通流量/速度数据集上的表现结果。如表IV所示,PM-DMNet§在交通需求预测任务的三个数据集上优于PM-DMNet®,并在两个数据集上与PM-DMNet®表现相当,表明PM-DMNet§在交通需求预测任务上相比PM-DMNet®具有一定优势。图7所示的逐步预测误差进一步证明了这一点。

然而,如表V所示,PM-DMNet®在交通流量/速度任务中表现出相对于PM-DMNet§的优势。图8中显示,PM-DMNet§在与PM-DMNet®相比时的初始时间步中预测误差显著较大,但在后续时间步中两者的误差相近。这一现象可能归因于数据集时间间隔的不同。交通需求数据集以30分钟为间隔采集,导致历史数据与预测目标之间的差异更为显著,从而使PMP方法比RMP方法表现更好。相反,交通流量/速度数据集以5分钟为间隔采集,创建了历史数据与预测目标之间的更多连续性,从而使RMP方法在性能上优于PMP方法。

VII. 消融研究

A. 模型组件的有效性分析

在本节中,为了验证PM-DMNet关键组件的有效性,进行了消融实验。为了研究不同模块的影响,设计了以下变体:

-

W/O Decoder:此变体移除了解码器组件,并使用MLP层直接应用于编码器输出进行预测。由于解码过程被省略,该变体对于PM-DMNet§和PM-DMNet®是相同的。

-

W/O TAM:在此变体中,移除了传输注意力模块(TAM)。取而代之的是,使用编码器输出的 H n H_n Hn 进行预测,替换了传输注意力机制中的 H n + 1 H_{n+1} Hn+1 输出。

-

W/O DMN:此变体用MLP层替代动态记忆网络(DMN)模块进行预测。

-

W/O NAPL:此变体移除了节点自适应参数学习(NAPL)模块,并使用线性层代替。

表VII展示了PM-DMNet§和PM-DMNet®及其变体的性能。从表中可以明显看出,PM-DMNet§和PM-DMNet®优于所有其他变体,证明了每个组件的有效性。

对于W/O Decoder变体,由于在解码阶段省略了模式匹配过程,预测是使用MLP层直接进行的。因此,该变体只能利用历史数据信息,而无法利用预测目标的时间点信息。因此,其性能低于PM-DMNet§和PM-DMNet®。

W/O TAM变体的性能也不如PM-DMNet§。这表明历史数据与预测目标之间的差异导致了性能下降,验证了我们提出的解决方案。这表明,使用适当的并行预测方法可以实现与串行预测相媲美甚至更好的结果。

W/O DMN变体的性能显著低于两个PM-DMNet模型,这凸显了我们使用记忆网络匹配和提取最具代表性的交通模式的方法的可行性。

同样,W/O NAPL变体的性能也低于两个PM-DMNet模型,突显了模型学习每个节点独特交通模式的必要性。

B. GCN和DMN的有效性分析

为了验证GCN和DMN在性能和计算成本上的差异,设计了一个名为DGCNet的变体。此变体使用动态图卷积代替DMN。动态图卷积的公式如下:

E t d = F t ⊙ T t E_t^d = F_t \odot T_t Etd=Ft⊙Tt

A t d = R e L U ( E t d E t d T ) A_t^d = ReLU(E_t^d E_t^{d^T}) Atd=ReLU(EtdEtdT)

H t = ( I N + D − 1 2 A t d D − 1 2 ) X Θ H_t = \left(I_N + D^{-\frac{1}{2}} A_t^d D^{-\frac{1}{2}}\right) X \Theta Ht=(IN+D−21AtdD−21)XΘ

其中 A t d ∈ R N × N A_t^d \in \mathbb{R}^{N \times N} Atd∈RN×N 表示时间点 t t t 的动态图, D D D 是 A t d A_t^d Atd 的度矩阵, I N I_N IN 表示单位矩阵。与PM-DMNet类似,DGCNet也可以根据预测方法分为两种变体:DGCNet§和DGCNet®。

在PEMSD7和PEMSD8数据集上进行了实验,PEMSD7的批次大小为16,PEMSD8的批次大小为64。表VIII展示了GCN和DMN在这两个数据集上的结果。

可以观察到,PM-DMNet优于DGCNet,表明DMN可以在不依赖GCN的情况下实现出色的性能。此外,尽管PM-DMNet的计算指标在较小的PEMSD8数据集上略优于DGCNet,但差异不显著。然而,在较大的PEMSD7数据集中,PM-DMNet的计算指标显著优于DGCNet,证明了DMN在大规模节点场景中 O ( N ) O(N) O(N) 复杂度相较于GCN的 O ( N 2 ) O(N^2) O(N2) 复杂度的优势。

C. 时间嵌入的有效性分析

为了验证日内时间特征和每周时间特征对模型的影响,本小节设计了两个变体:

- use day:在此变体中,动态记忆网络仅使用日内时间特征嵌入进行更新。

- use week:在此变体中,动态记忆网络仅使用每周时间特征嵌入进行更新。

在四个数据集上进行了实验,以观察时间信息对不同类型数据的模型性能的影响。

图9展示了PM-DMNet P 和PM-DMNet R 及其变体的表现。

可以看出,当仅使用一种类型的时间特征嵌入时,模型的性能通常会下降。除NYC-Taxi16数据集外,在该数据集中use week优于use day,在所有其他情况下use day的表现优于use week。这表明,日内信息通常对模型性能的影响大于每周信息。此外,在PEMSD7(M)数据集中,use day的表现与原始模型相当,而use week的表现显著变化。这表明,与其他类型的数据不同,交通速度数据在工作日和周末之间表现出较小的差异,表现出较高的相似性。

VIII. 超参数分析

为了验证超参数对模型性能的影响,使用PEMSD8数据集进行了超参数实验。具体而言,本节研究了时间嵌入维度 p p p、节点自适应模块中节点嵌入矩阵 E E E 的维度 d d d 以及记忆网络矩阵的维度 M M M 的影响。在这些实验中,其他参数保持不变,仅改变所研究的参数。

A. 对 p p p 的敏感性

参数 p p p 设置为 { 5 , 10 , 15 , 20 , 25 , 30 } \{5, 10, 15, 20, 25, 30\} {5,10,15,20,25,30},以评估其对模型性能的敏感性。图10展示了模型在不同 p p p 值下的性能。可以看出,当 p p p 在10到25之间时,模型表现相对稳定。此外,在各种设置中,PM-DMNet®始终表现出比PM-DMNet§更低的错误率。

B. 对 d d d 的敏感性

参数 d d d 设置为 { 2 , 5 , 10 , 20 } \{2, 5, 10, 20\} {2,5,10,20},以评估其对模型性能的敏感性。图11展示了模型在不同 d d d 值下的表现。观察到 d d d 不显著影响模型性能;然而,它极大地影响了训练速度。当 d d d 设置在5到10之间时,模型在保持性能的同时能够快速训练。因此,推荐将 d d d 设置在5到10之间。

C. 对 M M M 的敏感性

参数 M M M 设置为 { 5 , 10 , 15 , 20 } \{5, 10, 15, 20\} {5,10,15,20},以评估其对模型性能的敏感性。图12展示了模型在不同 M M M 值下的表现。观察到当 M M M 在5到20之间时,模型达到了稳定且出色的性能。因此, M M M 设置为10。

IX. 可视化

为了探究节点自适应参数模块是否捕捉到了每个节点的独特交通模式,我们使用T-SNE对在NYC-Taxi16数据集上训练的节点嵌入矩阵 E E E 进行了可视化。

图13展示了节点嵌入 E E E 的可视化结果。从图中可以观察到,某些节点表现出聚类现象,而少数节点则有重叠,表明它们之间的交通模式高度相似。此外,还有一些节点之间距离较远,表明它们的交通模式存在显著差异。

为了进一步验证相邻节点之间交通模式的高度相似性和远距离节点之间交通模式的差异性,我们选择了红框区域内的相邻节点(具体为节点215和节点222)以及蓝框区域内的远距离节点(具体为节点26)进行交通需求数据的可视化。图14(a)和14(b)分别展示了这三个节点的“上车”和“下车”特征的趋势变化。显然,节点215和节点222的趋势非常相似,表明它们之间存在强烈的相关性。同时,节点26的趋势与其他两个节点明显不同,表明它们的交通模式存在显著差异。

上述可视化结果证实,节点自适应参数模块能够有效学习各个节点的交通模式。

X. 结论

本文提出了一种新的交通预测模型,PM-DMNet。PM-DMNet采用了一种新的动态记忆网络模块,该模块学习最具代表性的交通模式并将其存储在记忆网络矩阵中。在预测过程中,模型通过将当前交通模式与记忆网络矩阵进行匹配来提取模式特征。此外,PM-DMNet支持并行和顺序的多步预测方法,以满足不同需求。为了进一步提高并行多步预测的准确性,引入了传输注意力机制,以减轻历史数据与预测目标之间的差异。大量实验验证了PM-DMNet的有效性。在未来的工作中,计划探索从模式中提取特征的其他方法。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?