美颜:https://github.com/Honlan/BeautyGAN,还需要按照md下载模型就可使用

提高精度:https://github.com/TencentARC/GFPGAN,还需要按照md下载一些包就可使用

美颜:

1.使用网络:cycleGAN循环生成对抗网络

2.传统特性:利用生成器网络G生成目标图,并用判别器D判断生成的图像是否为真,它会对生成器所产生的假目标做惩罚并对真目标进行奖励

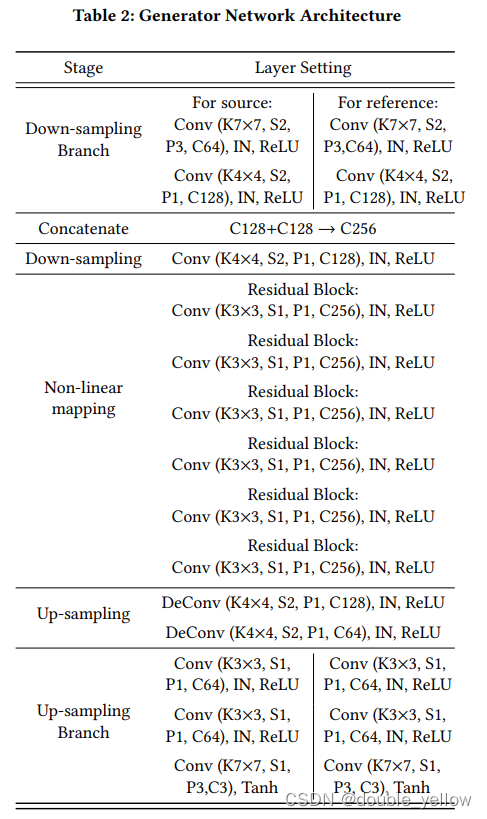

3.生成器:左边的生成模型G,首先素颜图像和参考图像经过不同的两组卷积提取特征,然后concatenate到一起,输入residual block中,接着两组反卷积将输出的feature map上采样,结果是将原来的素颜图像“上妆”,而参考图像“卸妆”。右边的生成模型G与左边结构相同实现复原。

4.判别器:上下两个判别模型D分别判断是否为真实的带妆图像或者素颜图像。

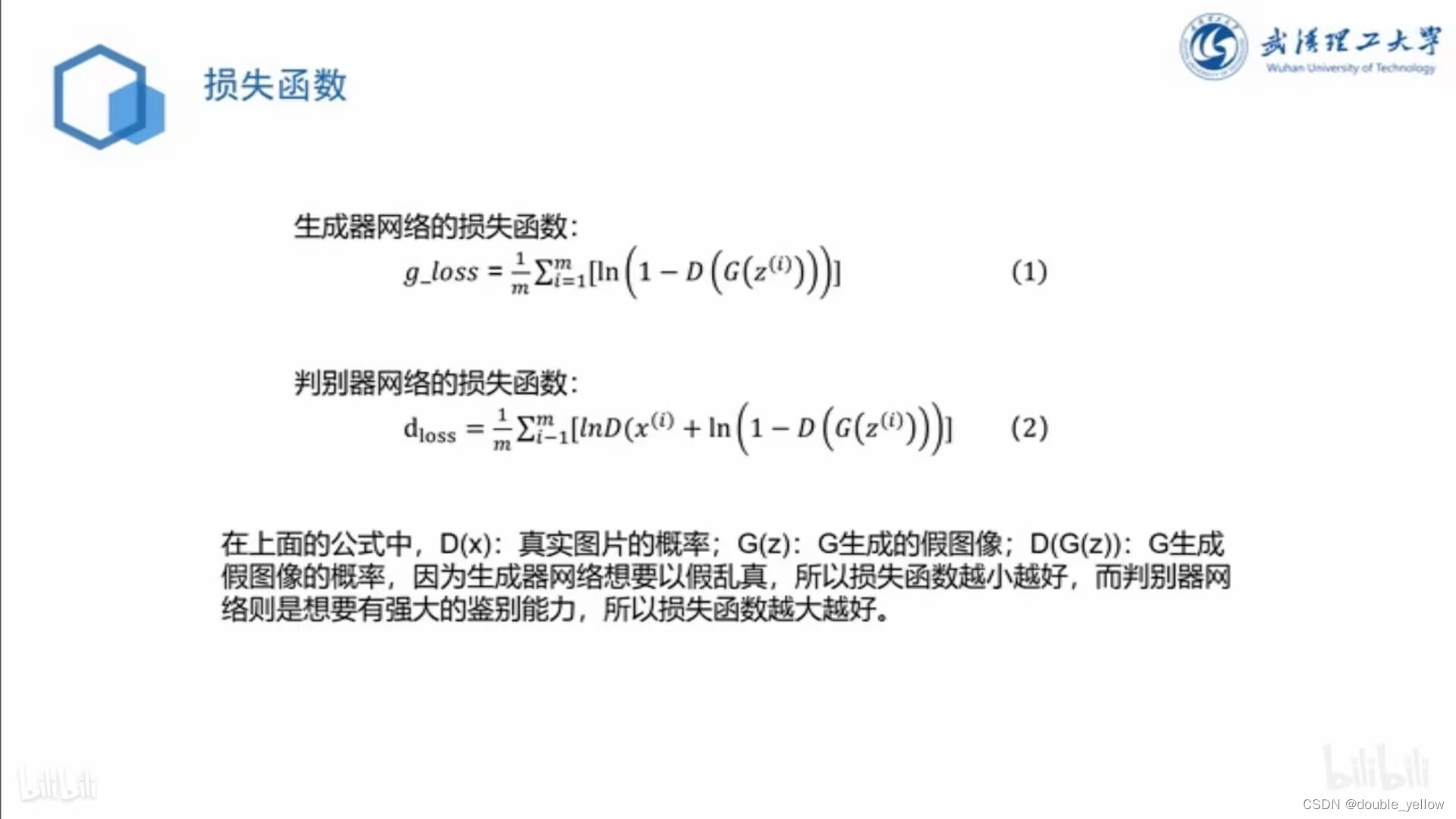

5.损失函数包含:

①GAN的损失函数(也就是两个判别器的损失之和)

生成器网络:分别卷积 + Concatenate(连接)+ 卷积全连接层 + 分别反卷积

判别器:卷积

损失函数:D()好像是判别器的输出

②cycle consistency loss(将生成的结果再次放回生成器,然后与输入图像做像素间的重构损失)

让重构回去的图像和最开始输入的图像要尽可能的一样,也就是经过两个生成器后(经历了一个cycleGAN后)生成的图片与原图片的distance最小

③perceptual loss(将同一人的妆前妆后图一起丢到VGGnet中,然后通过对输出的语义向量做损失从而保证身份的一致性)

用的VGG16,VGG模型学习链接如下:

https://blog.csdn.net/qq_42012782/article/details/123222042

④makeup loss(将面部先做语义分割,分成底妆,口红和眼影,然后对每个区域做颜色损失)

语义分割 + 直方图匹配

语义分割用的是FCN(全卷积神经网络)https://blog.csdn.net/wrk226/article/details/123255122?spm=1001.2014.3001.5502

直方图匹配好像也是上面的方法

6.参考文献:BeautyGAN: Instance-level Facial Makeup Transfer with DeepGenerative Adversarial Network

7.参考博客:

https://blog.csdn.net/qq_30209907/article/details/94023802

https://blog.csdn.net/wrk226/article/details/123256887(这个博客提供的连接里,有论文附件,附件中有G和D的网络结构表)

8.参考github,这里有训练好的可以直接用的模型,但没有训练模型:

https://github.com/Honlan/BeautyGAN

提高精度:

看不懂哇,前面的区域以后再来探索吧

560

560

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?