本文主要内容为论文《A Survey on Transfer Learning》的阅读笔记,内容和图片主要参考 该论文 。其中部分内容引用与博客《迁移学习综述a survey on transfer learning的整理下载》,感谢博主xf__mao的资源贡献。在这里我主要记录下自己觉得重要的内容以及一些相关的想法,希望大家多多留言评论,相互交流~

0. Abstract

许多机器学习和数据挖掘算法中的一个主要假设是,训练和未来(测试)数据必须在相同的特征空间中,并且具有相同的分布。然而,在许多实际应用中,这种假设可能不成立。例如,我们有时在一个感兴趣的域中有一个分类任务,但我们在另一个感兴趣的域中只有足够的训练数据,后者的数据可能在不同的特征空间中,或者遵循不同的数据分布。在这种情况下,如果成功地进行知识迁移,将避免大量昂贵的数据标记工作,从而极大地提高学习的性能。近年来,迁移学习已经成为解决这个问题的一个新的学习框架。这篇综述的重点是分类和回顾目前迁移学习在分类,回归和聚类问题的进展。在这篇综述中,我们讨论了迁移学习与其他相关机器学习技术的关系,如领域适应,多任务学习和样本选择偏差,以及协变量移位。我们还探讨了迁移学习研究中的一些潜在的未来问题。

1. Introduction

机器学习与数据挖掘技术在很多应用上都取得了成功,但是许多算法表现良好是因为它们有一个共同的假设:训练和测试数据必须来自相同的特征空间中,并且具有相同的分布。当分布发生改变时,绝大多数统计模型需要从头开始使用新收集的训练数据进行重建。在真实世界的应用中,重新收集训练数据并且重新训练模型是昂贵的或者不可能的。如果能够减少重新收集训练数据的需要和努力将会是美好的。在这种情况下,任务域之间的知识迁移或迁移学习是可取的。

在迁移学习确实是有益的知识工程中可以找到许多例子。下面分别给了三个例子进行说明,第一个例子是Web文档分类,在原始网站上训练的分类器无法直接应用到新网站上,因为新创建的网站里的数据特征和数据分布可能不同,有可能是一个缺乏标记的训练数据,所以可以采用迁移学习的方法。第二个例子是室内 Wifi 定位,因为采用 WIFI 数据进行训练会产生大量的标注任务,所以使用信号强度随时间、装置或者其他因子及建模,并对不同的时间段或者设备进行迁移学习。第三个例子是评论的情感分析,如果对所有的商品都进行标注(贴标签)的话是一项巨大的任务,所以通过在一部分商品上训练分类模型在迁移到另外一些类别的商品。

本文的主要内容是机器学习和数据挖掘领域中的分类、回归和聚类的迁移学习作了全面的概述。虽然也有大量的工作关于强化学习的迁移学习的论文,但是不是数据挖掘研究的问题。

综述的其余部分安排如下。在接下来的四节中,我们首先给出了一个总体回顾,然后定义一些我们稍后会用到的符号。然后简要回顾了迁移学习的历史,对迁移学习给出了统一的定义,并将迁移学习分为三种不同的设置(如表2和图2所示)。对于每个设置,我们将详细回顾表3中给出的不同方法。之后,在第6节中,我们回顾了关于知识迁移对目标学习产生负面影响的“负迁移”的研究现状。在第7部分中,我们介绍了迁移学习的一些成功应用,并列出了一些已发布的数据集和软件工具包,用于迁移学习研究。最后,我们结束文章,在第8部分中讨论未来工作。

2. OVERVIEW

2.1 A Brief History of Transfer Learning

传统的机器学习方法包括有监督学习、无监督学习和半监督学习,针对不完全数据,有监督和半监督学习还有相应的变形,如处理噪声分类标签问题以及代价敏感学习。然而,这些方法的大多数都假设已标注数据与未标注数据的分布是相同的。与之相反的是,迁移学习允许源空间、任务空间,并且在测试集和训练集中的分布是不同的。接下来举了人进行迁移学习的例子,即人可以智能地使用先前学习的知识来更快更好地解决新的问题。迁移学习最早起源于NIPS-95 上的“Learning to Learn”。

迁移学习兴起于 1995 年,别名有learning to learn, life-long learning, knowledge transfer, inductive transfer, multi-task learning, knowledge consolidation, context sensitive learning, knowledge-based inductive bias, meta learning, and incremental/cumulative learning。与迁移学习密切相关的学习技术是多任务学习框架,这个框架尝试同时学习多个任务,即使它们是不同的。多任务学习的一个典型方法是发现能使每个任务受益的共同(潜在)特征。多任务学习的一个典型方法是发现能使每个任务受益的共同(潜在)特征。

在2005年,XXX赋予了迁移学习新的任务,系统识别和应用以前任务中所学到的知识和技能的能力。在这个定义中,迁移学习的目的是从一个或多个源任务中提取知识,并将知识应用于目标任务。与多任务学习相比,迁移学习最关心的是目标任务,而不是同时学习所有的源任务和目标任务。在迁移学习中,源和目标任务的作用不再对称。

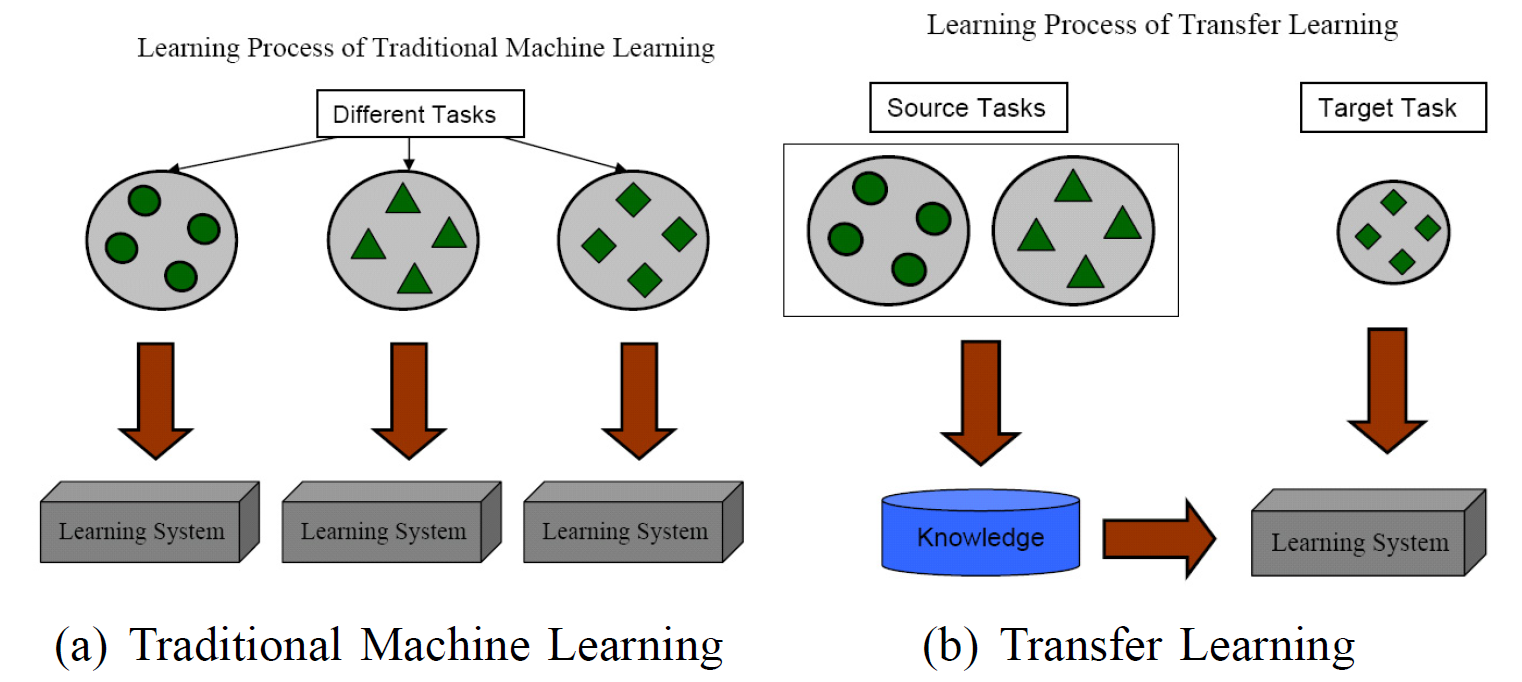

下图是传统机器学习与迁移学习的差别,传统机器学习对于不同的目标任务要进行重新训练,而迁移学习则不用。

2.2 Notations and Definitions

(1)domain. 数据域(domain)由两个部分组成:特征空间 X X XX XX 和边缘概率分布 P ( X ) P(X) P(X) ,这里 X = x 1 , … … , x 2 ∈ X X X={x_1, ……,x_2}\in XX X=x1,……,x2∈XX

举例说明,如果我们的任务是文档分类,把每一个单词看作二值的特征即出现或者不出现,然后 X X XX XX 是所有词向量的空间, x i x_i xi 是与一些文档有关的第 i 个词向量,并且 X 是一个具体的学习样本。总体来看如果两个域是不同的,它们具有不同的特征空间或者不同的边缘概率分布。

(2)task. 给定一个具体的域 D = X X , P ( X ) D={XX, P(X)} D=XX,P(X) ,一个任务(task)由两个部分组成:空间的标签 Y Y YY YY,和一个目的预测函数 f ( . ) f(.) f(.) ,task 用 T = Y Y , f ( . ) T={YY,f(.)} T=YY,f(.) 表示,目标函数不能够被观察,但是i可以通过训练数据被学习到,其中包含变量 x i , y i {x_i, y_i} xi

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2007

2007

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?