前言

这个系列的文章,是《模式识别》(张学工,清华大学出版社)的阅读笔记。由于一些原因,笔记从第四章开始进行整理。子标题的编号没有完全依据原书。

1 关于分类器设计

二分类任务:根据样本求出一个合适分类面,把样本正确的分成两类。

贝叶斯决策要求根据样本进行概率密度函数估计,这在高维和少样本对情况下不易做到,于是我们希望有直接更具样本求分类面的方法。

基于样本设计分类器重点关注三个问题:

(1)判别函数的类型,对于线性分类器,判别函数就是线性判别函数,对应的分类面也是线性的。

(2)分类器设计的目标/准则。即形式化的定义出来判别函数选择什么样的参数是可以的、是最好的。

(3)如何得到最优参数。是用启发式的方法,还是用数学理论去计算。

2线性判别函数

所有二分类的分类器都是基于以下的线性判别函数的:

g

(

x

)

=

w

T

x

+

w

0

g(\mathbf{x})=\mathbf{w}^T\mathbf{x}+w_0

g(x)=wTx+w0

准则也很符合直觉:

g

(

x

)

>

0

,

决

策

、

x

∈

ω

1

g

(

x

)

<

0

,

决

策

、

x

∈

ω

2

g

(

x

)

=

0

,

决

策

、

x

可

以

分

到

任

意

一

类

或

者

拒

绝

\begin{matrix}g(\mathbf{x})>0,决策、\mathbf{x}\in \omega_1 \\g(\mathbf{x})<0,决策、\mathbf{x}\in \omega_2 \\g(\mathbf{x})=0,决策、\mathbf{x}可以分到任意一类或者拒绝 \end{matrix}

g(x)>0,决策、x∈ω1g(x)<0,决策、x∈ω2g(x)=0,决策、x可以分到任意一类或者拒绝

g

(

x

)

=

0

g(\mathbf{x})=0

g(x)=0定义了一个决策面

H

H

H,这是一个以

w

\mathbf{w}

w为法向量的平面。

特征空间、代数距离、几何距离

每个样本点 x \mathbf{x} x都可以表示到一个高维的特征空间里。这个样本点到分类面 H H H的代数距离就是 g ( x ) g(\mathbf{x}) g(x)。这个值的大小是没有什么意义的,因为 w \mathbf{w} w的模是不确定的。真正有意义的是 x \mathbf{x} x到分类面的几何距离 g ( x ) ∥ w ∥ \frac{g(\mathbf{x})}{\left \|\mathbf{w} \right \|} ∥w∥g(x)。

这个的推导如下:设几何距离为

r

r

r,从

x

\mathbf{x}

x出发向

H

H

H引垂线,交

H

H

H于

x

p

\mathbf{x}_p

xp。由于

w

∥

w

∥

\frac{\mathbf{w}}{\left \|\mathbf{w} \right \|}

∥w∥w是

w

\mathbf{w}

w方向的垂直距离,于是有

x

=

x

p

+

r

w

∥

w

∥

\mathbf{x}=\mathbf{x}_p+r\frac{\mathbf{w}}{\left \|\mathbf{w} \right \|}

x=xp+r∥w∥w

带入线性判别函数,得

g

(

x

)

=

w

T

(

x

p

+

r

w

∥

w

∥

)

+

w

0

=

0

+

r

w

T

w

∥

w

∥

g(\mathbf{x})=\mathbf{w}^T(\mathbf{x}_p+r\frac{\mathbf{w}}{\left \|\mathbf{w} \right \|})+w_0=0+r\frac{\mathbf{w}^T\mathbf{w}}{\left \|\mathbf{w} \right \|}

g(x)=wT(xp+r∥w∥w)+w0=0+r∥w∥wTw

所以

r

=

g

(

x

)

∥

w

∥

r=\frac{g(\mathbf{x})}{\left \|\mathbf{w} \right \|}

r=∥w∥g(x)

3几种经典准则

在分类问题中,通常应该保证样本是线性可分的,即同一类的样本点全部分布在分类面一侧。但如果有一些样本标记错误,就会造成线性不可分。

接下来线性不可分和线性可分两种情况给出一些经典的线性分类器设计准则。

| 线性可分 | 线性不可分 |

|---|---|

| Fisher线性判别分析(LDA) | 最小平方误差判别 |

| 单层感知机(perceptron) | / |

| 线性支持向量机(SVM) | 线性支持向量机(SVM) |

4Fisher线性判别分析

分类面的找法:把所有样本投影到一个方向上,然后在一维空间内确定一个分类阈值。过这个阈值点且和投影方向垂直的超平面就是分类面。

这里实际上把找分类面的任务分割成了两个:

(1)找到合适的投影方向(分类面法向)

w

\mathbf{w}

w;

(2)找到分类阈值(阈值权)

w

0

w_0

w0。

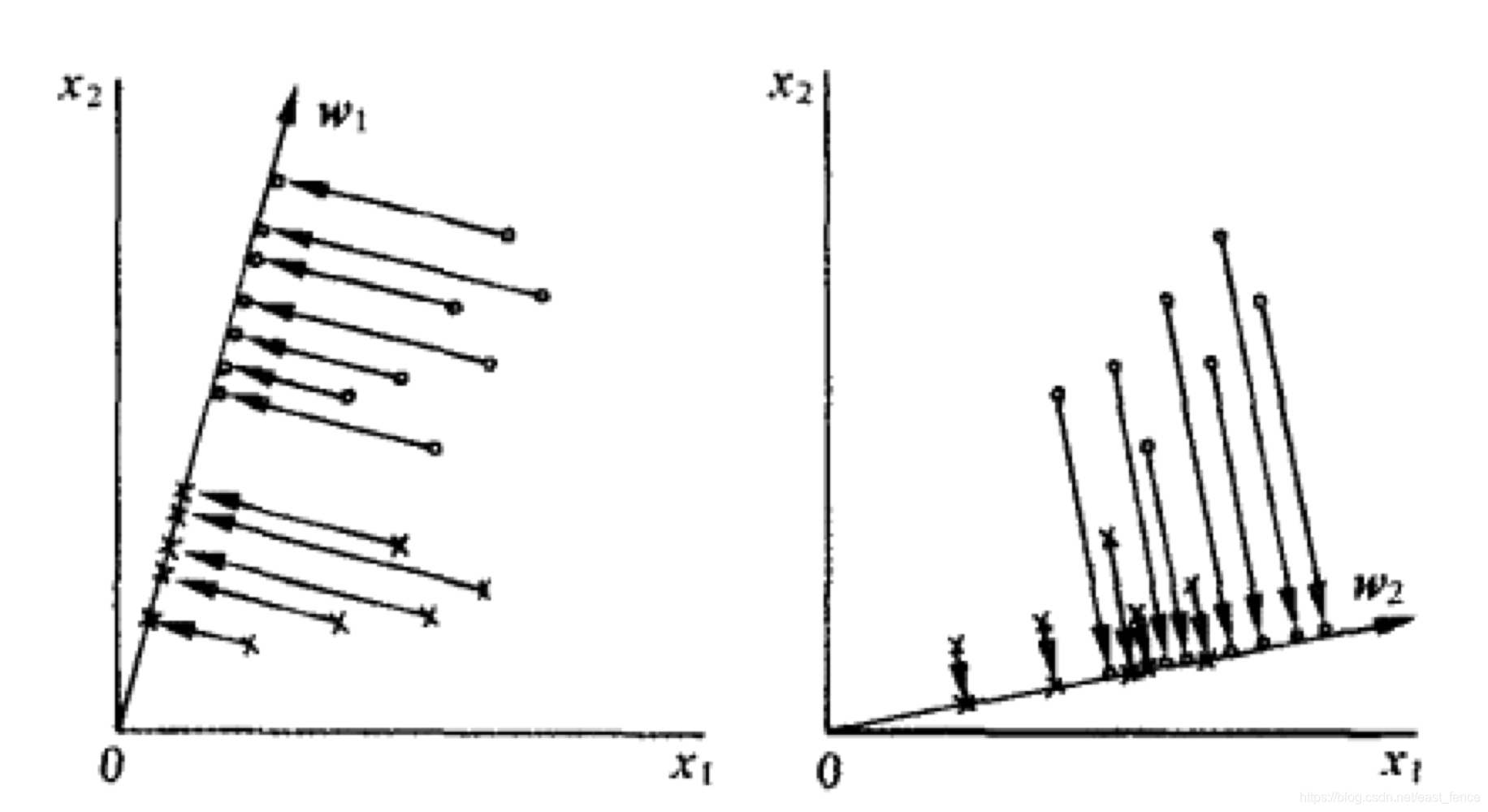

先解决第一个。下面的图中,很容易看出来选择左边的投影方向要优于选择右边的投影方向。即我们希望能让分类结果:类内聚集,类间远离。

这要怎么形式化呢?

在原样本空间内,类均值向量(类中心点)为:

m

i

=

1

N

i

∑

x

j

∈

ω

i

x

j

,

i

=

1

,

2

\mathbf{m}_i=\frac{1}{N_i} \sum_{\mathbf{x}_j\in \omega_i}\mathbf{x}_j,i=1,2

mi=Ni1xj∈ωi∑xj,i=1,2

(未完待续)

1309

1309

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?