网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

最近的很多关于Mobile Network的工作大多数都是基于深度可分离卷积和inverted残差模块:

- HBONet:在每个inverted残差模块中引入下采样操作,用于建模具有代表性的空间信息。

- ShuffleNetV2:在inverted残差模块之前和之后使用通道分割模块和通道shuffle模块。

- MobileNetV3:结合神经网络结构搜索算法,寻找最优激活函数和不同深度的inverted残差块的扩展比。

- MixNet、EfficientNet和ProxylessNAS:也采用不同的搜索策略来搜索深度可分卷积的最优核大小或标量,从而从扩展比、输入分辨率、网络深度和宽度等方面控制网络权值。

- 最近,有学者重新思考了基于深度可分离卷积的方法,专门设计了基于Mobile Network的bottleneck结构,并基于此设计MobileNeXt。

2.2 注意力机制

想必大家都已经知道注意力机制在各种计算机视觉任务中都是有帮助,如图像分类和图像分割。其中最为经典和被熟知的便是SENet,它通过简单地squeeze每个2维特征图,进而有效地构建通道之间的相互依赖关系。

CBAM进一步推进了这一思想,通过大尺度核卷积引入空间信息编码。后来的研究如GENet、GALA、AA、TA,通过采用不同的空间注意力机制或设计高级注意力块,扩展了这一理念。

Non-local/self-attention Network则着重于构建spatial或channel注意力。典型的例子包括NLNet、GCNet、A2Net、SCNet、gsopnet和CCNet,它们都利用Non-local机制来捕获不同类型的空间信息。然而,由于self-attention模块内部计算量大,常被用于大型模型中,不适用于Mobile Network。

与Non-local/self-attention的方法不同,CA方法考虑了一种更有效的方法来捕获位置信息和通道关系,以增强Mobile Network的特征表示。通过将二维全局池操作分解为两个一维编码过程,本文方法比其他具有轻量级属性的注意力方法(如SENet、CBAM和TA)运行得更好。

3 Coordinate Attention

一个coordinate attention块可以被看作是一个计算单元,旨在增强Mobile Network中特征的表达能力。它可以将任何中间特征张量作为输入并通过转换输出了与

张量具有相同size同时具有增强表征的

。为了更加清晰的描述CA注意力,这里先对SE block进行讨论。

3.1 Revisit SE Block

在结构上,SE block可分解为Squeeze和Excitation 2步,分别用于全局信息嵌入和通道关系的自适应Re-weight。

Squeeze

在输入

的条件下,第

通道的squeeze步长可表示为:

式中,

是与第

通道相关的输出。

输入

来自一个固定核大小的卷积层,因此可以看作是局部描述符的集合。Sqeeze操作使模型收集全局信息成为可能。

Excitation

Excitation的目的是完全捕获通道之间的依赖,它可以被表述为:

其中

为通道乘法,

为

激活函数,

为变换函数生成的结果,公式如下:

这里,

和

是2个线性变换,可以通过学习来捕捉每个通道的重要性。

为什么SE Block不好?

SE Block虽然近2年来被广泛使用;然而,它只考虑通过建模通道关系来重新衡量每个通道的重要性,而忽略了位置信息,但是位置信息对于生成空间选择性attention maps是很重要的。因此作者引入了一种新的注意块,它不仅仅考虑了通道间的关系还考虑了特征空间的位置信息。

3.2 Coordinate Attention Block

Coordinate Attention通过精确的位置信息对通道关系和长期依赖性进行编码,具体操作分为Coordinate信息嵌入和Coordinate Attention生成2个步骤。

3.2.1 Coordinate信息嵌入

全局池化方法通常用于通道注意编码空间信息的全局编码,但由于它将全局空间信息压缩到通道描述符中,导致难以保存位置信息。为了促使注意力模块能够捕捉具有精确位置信息的远程空间交互,本文按照以下公式分解了全局池化,转化为一对一维特征编码操作:

具体来说,给定输入

,首先使用尺寸为(H,1)或(1,W)的pooling kernel分别沿着水平坐标和垂直坐标对每个通道进行编码。因此,高度为

的第

通道的输出可以表示为:

同样,宽度为

的第

通道的输出可以写成:

上述2种变换分别沿两个空间方向聚合特征,得到一对方向感知的特征图。这与在通道注意力方法中产生单一的特征向量的SE Block非常不同。这2种转换也允许注意力模块捕捉到沿着一个空间方向的长期依赖关系,并保存沿着另一个空间方向的精确位置信息,这有助于网络更准确地定位感兴趣的目标。

3.2.2 Coordinate Attention生成

通过3.2.1所述,本文方法可以通过上述的变换可以很好的获得全局感受野并编码精确的位置信息。为了利用由此产生的表征,作者提出了第2个转换,称为Coordinate Attention生成。这里作者的设计主要参考了以下3个标准:

- 首先,对于Mobile环境中的应用来说,新的转换应该尽可能地简单;

- 其次,它可以充分利用捕获到的位置信息,使感兴趣的区域能够被准确地捕获;

- 最后,它还应该能够有效地捕捉通道间的关系。

通过信息嵌入中的变换后,该部分将上面的变换进行concatenate操作,然后使用

卷积变换函数

对其进行变换操作:

式中

为沿空间维数的concatenate操作,

为非线性激活函数,

为对空间信息在水平方向和垂直方向进行编码的中间特征映射。这里,

是用来控制SE block大小的缩减率。然后沿着空间维数将

分解为2个单独的张量

和

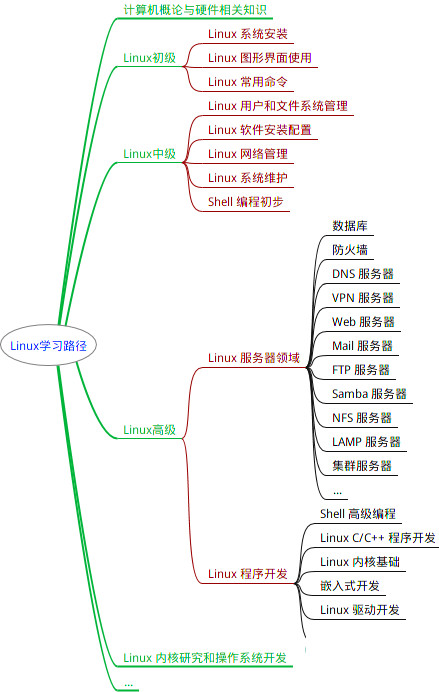

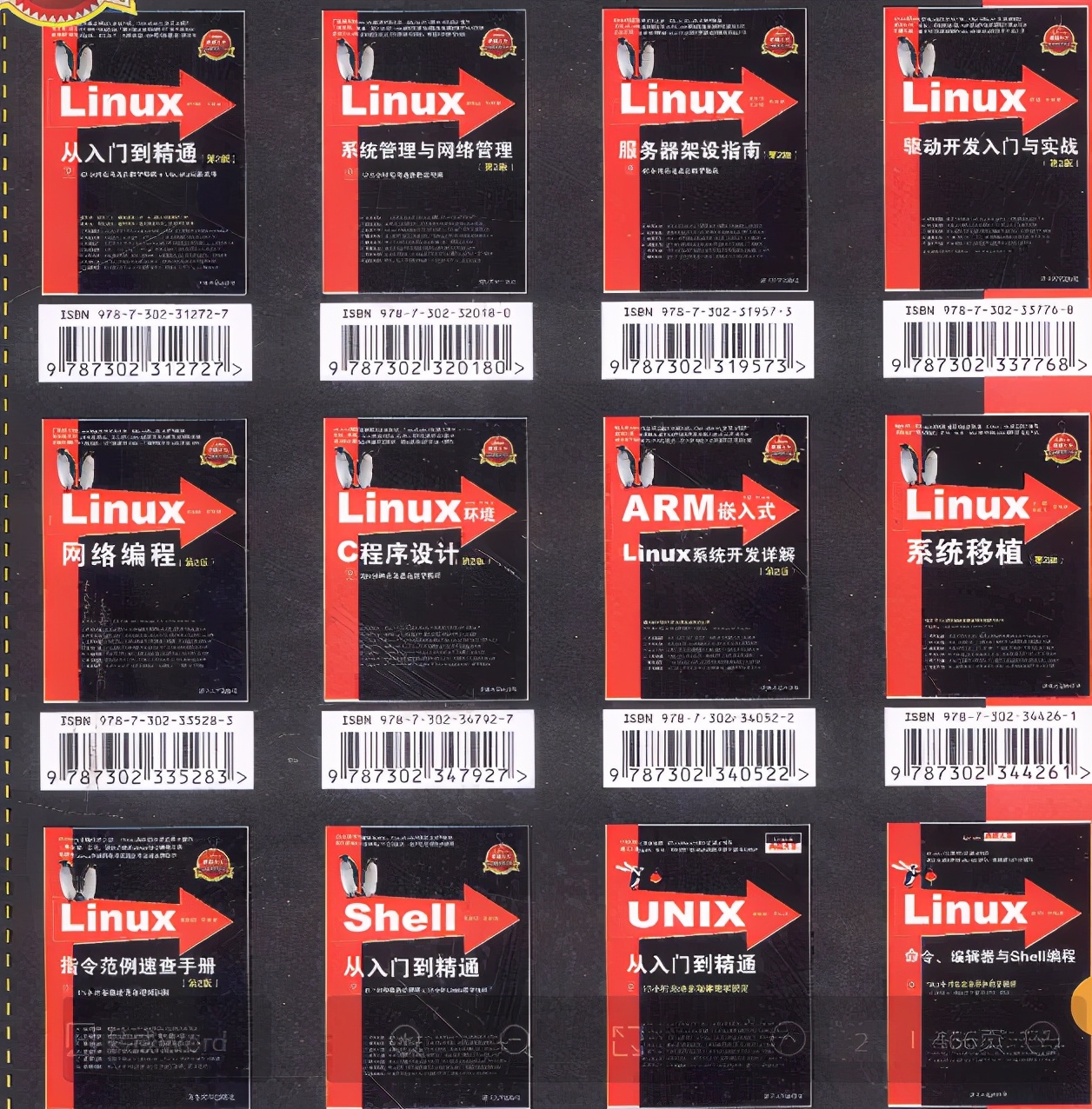

最全的Linux教程,Linux从入门到精通

======================

-

linux从入门到精通(第2版)

-

Linux系统移植

-

Linux驱动开发入门与实战

-

LINUX 系统移植 第2版

-

Linux开源网络全栈详解 从DPDK到OpenFlow

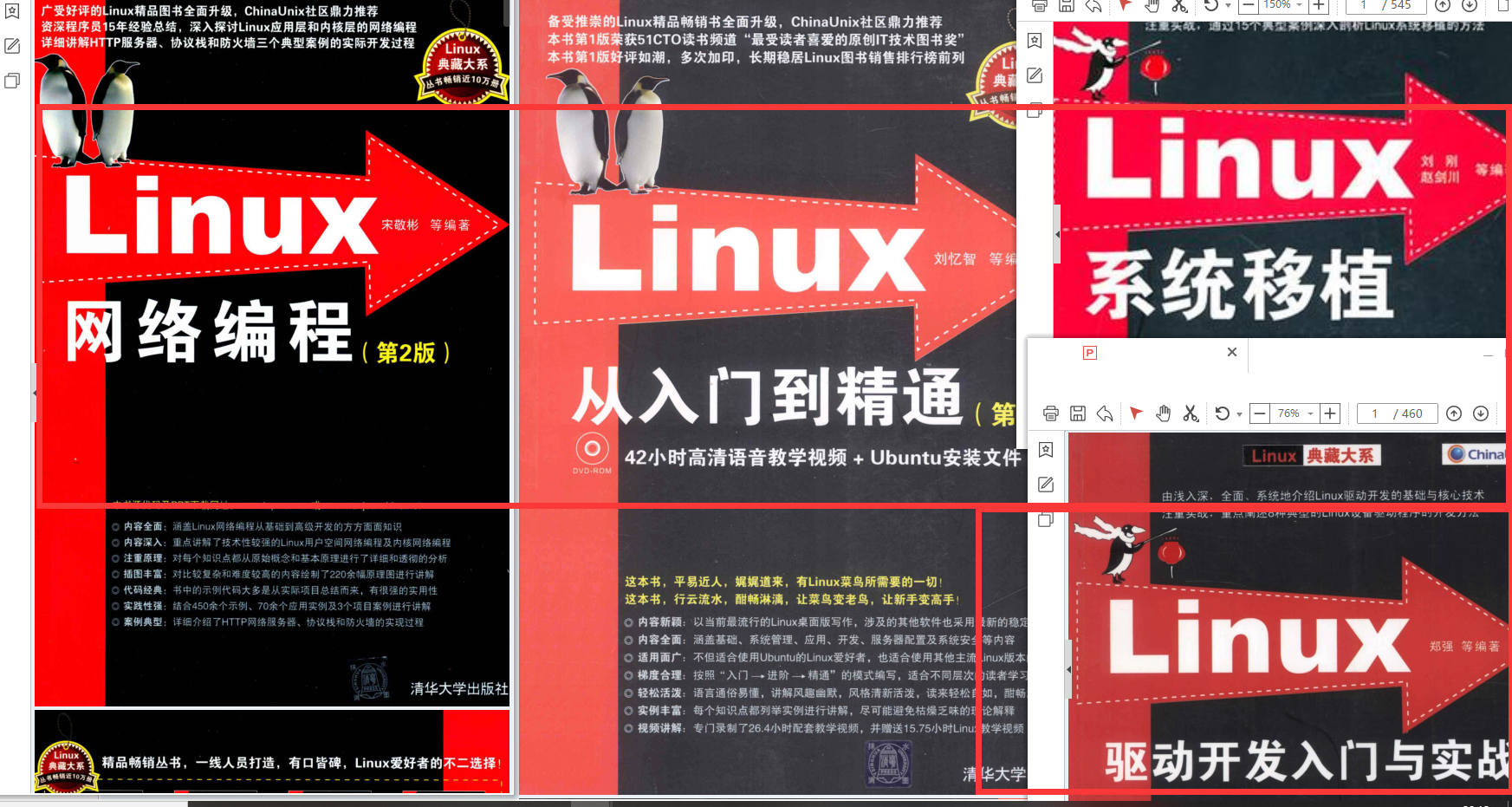

第一份《Linux从入门到精通》466页

====================

内容简介

====

本书是获得了很多读者好评的Linux经典畅销书**《Linux从入门到精通》的第2版**。本书第1版出版后曾经多次印刷,并被51CTO读书频道评为“最受读者喜爱的原创IT技术图书奖”。本书第﹖版以最新的Ubuntu 12.04为版本,循序渐进地向读者介绍了Linux 的基础应用、系统管理、网络应用、娱乐和办公、程序开发、服务器配置、系统安全等。本书附带1张光盘,内容为本书配套多媒体教学视频。另外,本书还为读者提供了大量的Linux学习资料和Ubuntu安装镜像文件,供读者免费下载。

本书适合广大Linux初中级用户、开源软件爱好者和大专院校的学生阅读,同时也非常适合准备从事Linux平台开发的各类人员。

需要《Linux入门到精通》、《linux系统移植》、《Linux驱动开发入门实战》、《Linux开源网络全栈》电子书籍及教程的工程师朋友们劳烦您转发+评论

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

文章探讨了在线学习中知识体系的重要性,强调了系统化的学习资源对于技术深化和提升的作用。特别提到了MobileNetwork及其改进版本在深度学习中的应用,以及注意力机制(如SENet、CA)在计算机视觉任务中的作用。作者鼓励读者加入技术交流社区,共同学习和成长。

文章探讨了在线学习中知识体系的重要性,强调了系统化的学习资源对于技术深化和提升的作用。特别提到了MobileNetwork及其改进版本在深度学习中的应用,以及注意力机制(如SENet、CA)在计算机视觉任务中的作用。作者鼓励读者加入技术交流社区,共同学习和成长。

200

200

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?