来源于机器学习实战中p138,求解线性回归的回归系数w的最优解,涉及到矩阵求导等知识,推导过程中还对矩阵求导的分子、分母布局进行说明,部分参考链接如下:

1.https://en.wikipedia.org/wiki/Matrix_calculus#Denominator-layout_notation(wiki矩阵求导说明)

2.http://f.dataguru.cn/thread-598486-1-1.html(最小二乘估计、岭回归和lasso)

3.http://blog.csdn.net/shouhuxianjian/article/details/46669365(对wiki矩阵求导进行了翻译)

**

背景

**

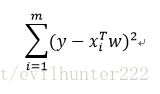

问题的背景是从大量数据中求出回归方程,常用的方法就是找出误差最小的w(存放回归系数的向量)。一般采用的方法是下图即平方误差(这里X是n*p的矩阵,y是n*1的结果向量,w便是p*1的回归系数向量),求和公式是误差项的平方值,我们需要做的就是取求和公式最小值下的w

用矩阵表示还可以写作

下面也就是对上述公式进行求导,令其导数等于0,所得w即为最优回归参数

**

求导过程

**

敲公式太麻烦就放了张手写图

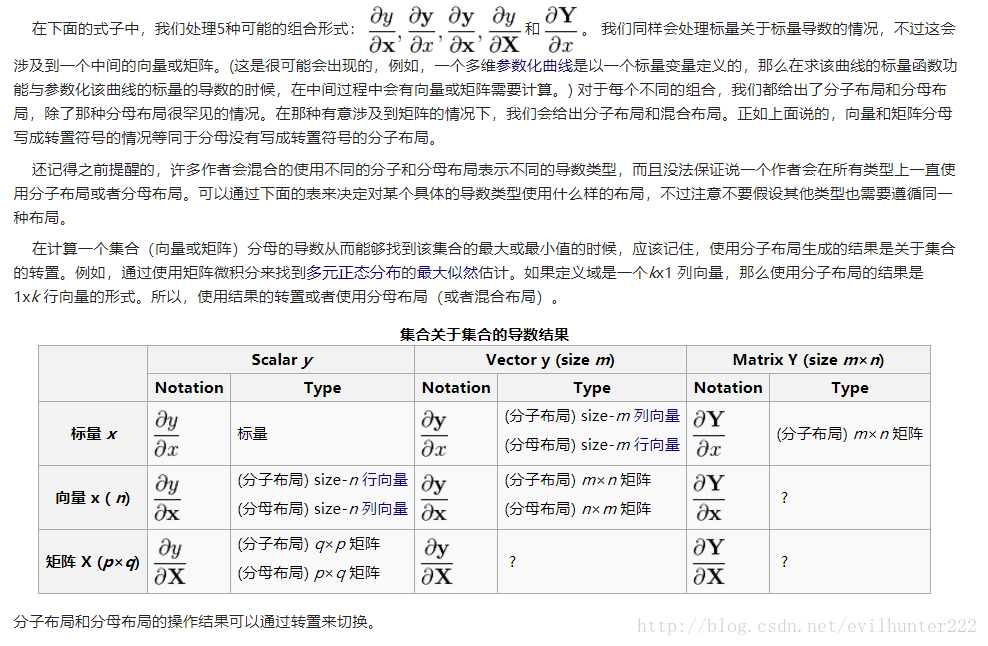

1-4步涉及到了矩阵求导知识和分子布局、分母布局两种不同的规定格式(具体见wiki)

1.先将分子展开成四项,然后就可以对四个部分分别进行求导(累加后求导等于求导后累加)

2.步骤1中的分子为标量(1*n向量与n*1向量),属于表格中第一种情形,即分子为标量分母为向量,因此求导结果为0

3.同样,步骤2,3中对应表格第3行,步骤4对应表格的第11行。但是涉及到不同的布局最后的表现形式也不同,如本次采用的是分母布局(也就是行向量和列向量的表示区别)**

布局约定

**

这里引用第三个连接中对wiki中矩阵求导的翻译

978

978

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?