adstract:提出了新的生成对抗样本的方法(AdvCam),将物理世界的对抗性例子加工和伪装成人类观察者认为合法的风格,具体来说就是AdvCam将大的对抗性扰动转成定制的样式,然后这些样式被隐藏在目标对象或者目标外的背景中

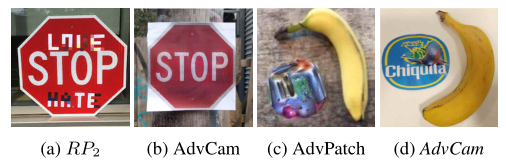

introduction:在图片中加入精心制造的扰动,类似污点,积雪和变色等,就会让DNN检测错误,这种加入的扰动可以伪装成自然的场景下会产生的变化,这个方法也可以生成patch,但是生成的是伪装成产品的patch

( 对抗性攻击可以应用于两种不同的设置:1)数字设置,攻击者可以将输入的数字图像直接输入DNN分类器;以及2)物理世界设置,其中DNN分类器仅接受来自摄像机的输入,并且攻击者只能向摄像机呈现对抗性图像。有三个属性可以用来描述对抗攻击:1)对抗强度,代表愚弄dnn的能力;2)对抗性隐蔽性,即对抗性扰动是否能被人类观察者察觉;和3)伪装灵活性,这是攻击者能够控制对抗性图像外观的程度。)

总之,AdvCamis不是一种扰动限制攻击,因此不会固有地受到现有扰动限制技术通常需要的有限扰动量的影响。

Related Work:

相比digital attacks(加入了小的扰动或者修改语义属性)来说,physical-world attacks就是考虑到digital attacks在现实世界中可能受到相机噪音,自然因素的影响加入的小扰动不能很好发挥作用而提出的方法(采用大的扰动,但是会丧失隐蔽性stealthiness),本文是采用了一种灵活的(可以让攻击者灵活定义攻击区域或风格)伪装机制,有效地隐藏具有自然风格的对抗性例子,既有隐匿性又是在物理世界的攻击,相关工作还提到了风格转移,在CNN训练中提取风格特征后转移,本文就是利用风格转移方法来做对抗样本

Method:

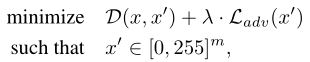

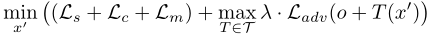

文中找对抗样本的式子为最小化下面这个式子(其中x’是对抗样本,D(x, x’)是一个对抗样本和原始样本的距离矩阵,Ladv(x’)是对抗样本的loss值,其中λ是调整对抗强度的参数)

文中的方法是用风格转移技术来达到伪装的目的,用对抗性攻击技术来达到对抗的强度。

可以灵活选定风格和区域

文中的对抗损失为:L= (Ls+Lc+Lm) +λ· Ladv(其中Ladv是对抗强度Loss,Ls是生成风格Loss,Lc是保存源图像内容的内容Loss,Lm是用于生成局部平滑区域的平滑Loss),其中括号中的三个损失函数一起用于伪装的目的,是为了加强这个模型的鲁棒性

详细解释上式:

1.Ls:

其中Xs是表示风格参考图像,F波浪线是一个特征提取器(例如DNN模型,可以与目标模型不同,文中采用了网络的全部卷积层作为特征提取器),其中的G是F波浪线的Gram matrix(就是一种风格转移的矩阵),即该loss是由对抗性范例x’和样式参考图像x之间的样式度量来定义,在风格转移的同时用了mask来保证只有选定区域是被改变了的

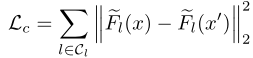

2.Lc:因为做了风格转变之后可能会使原始图像的内容被改变,所以用了这个content loss:

其中Cl表示用于提取内容的层,文中使用特征提取器网络的更深层作为内容层(为了在深层表征空间也与原始图像非常相似),此处要注意,如果攻击的region没有包含特定内容的话(类似于上面第二张图的香蕉的那种攻击)就不用Lc了,但如果region里有语义信息就要用

3.Lm:通过减少相邻像素的变化来达到,公式为:

在文中,作者表示如果目标图像和风格图像的表面都已经是平滑的,平滑度损失在提高隐蔽性方面是有限的。但是仍然建议在物理环境中添加它,平滑项对于提高物理环境中对抗性例子的鲁棒性是有用的。

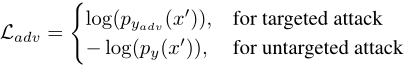

4.Ladv:使用了交叉熵损失,如果是定向攻击就设置成和目标比的loss

–

在现实世界条件下的调整

其中o表示一个随机的背景图片,T表示的是随机的转换(旋转,调整尺寸或者颜色转换)

Experiment:

做了和PGD、AdvPatch、RP2对比:

测试了发现AdvCam的方法的隐匿性和PGD相当,且他不受扰动大小的限制,而AdvPatch就比较不隐匿

Customized examples:通过对特定的地方扰动而使模型误判,文中有对于目标的伪装以及不在目标上的伪装。下图中第一排是on-target,第二排是off-target

做了消融实验,考虑了伪装区域的形状和位置、伪装损失、对抗力度λ和区域大小

1. 伪装区域的形状和位置:通过实验,作者发现无论伪装区域是在目标物体的中心还是远离目标物体的中心,攻击都能以高置信度成功

2. 伪装损失:Ls是必须的,但是Lc和Lm是可选的,因为他们又是只是使图片看起来视觉效果更好一点点

3. 对抗力度和region size:更大的λ和更大的size攻击效果更好

Physical-world Attacks:文中是做了AdvCam、AdvPatch、PGD的物理世界的攻击(选了3个物理世界的场景),把他们攻击后的图片打印下来然后在不同的位置和角度拍照,实验表明AdvCam的攻击更加具有隐匿性和灵活性

Conclusion:

本文提出了AdvCam,结合了神经风格转移和对抗攻击技术,使对抗样本更加隐匿和灵活,但是目前还需要手动选择攻击区域和攻击目标。

本人初学者,如有错误请指出,谢谢!

2518

2518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?