6.挖掘频繁模式、关联和相关性:基本概念和方法

频繁模式(frequent pattern)是频繁地出现在数据集中的模式。

6.1 基本概念

频繁模式挖掘搜索给定数据集中反复出现的联系,旨在发现大型事务或关系数据集中项之间有趣的关联或相关性,其典型例子就是购物篮分析。

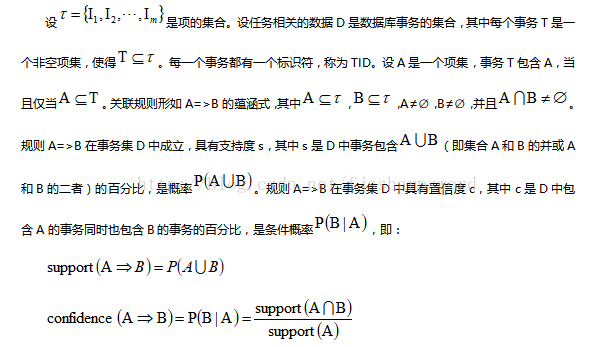

购物篮分析假设全域是商品的集合,每种商品有一个布尔变量,表示该商品是否出现在购物篮中。每个购物篮是一个布尔向量表示,分析布尔向量,可得到反映商品频繁关联或同时购买的购买模式,这些模式可用关联规则(association rule)形式表示。如购买计算机也趋向于同时购买杀毒软件,用如下规则表示:computer=>antivirus_software[support=2%;confidence=60%]。规则的支持度(support)和置信度(confidence)是规则兴趣度的两种度量,分别反映所发现规则的有用性和确定性。如果规则满足最小支持度阈值和最小置信度阈值,则关联规则是有趣的。

同时满足最小支持度阈值(min_sup)和最小置信度阈值(min_conf)的规则称为强规则。

项的集合称为项集,包含k个项的项集称为k项集。项集的出现频度是包含项集的事务数,称为项集的频度、支持度计数或计数。项集支持度也称为相对支持度,而出现频度称为绝对支持度。如果项集I的相对支持度满足预定义的最小支持度阈值(即 I的绝对支持度满足对应的最小支持度计数阈值),则I是频繁项集(frequent itemset)。频繁k项集的集合通常记为Lk。关联规则的挖掘一般两步:

第一:找出所有的频繁项集;第二:由频繁项集产生强关联规则。

从大型数据集中挖掘频繁项集的主要挑战是:产生大量满足最小支持度(min_sup)的阈值的项集。项集X在数据集D中是闭的(closed),如果不存在真超项集Y,使得Y与X在D中具有相同的支持度计数。项集X是数据集D中的闭频繁项集(closed frequent itemset),如果X在D中是闭的和频繁的。项集X是D中的极大频繁项集(maximal frequent itemset)或极大项集(max-itemset),如果X是频繁的,并且不存在超项集Y,使得并且 Y在D中是频繁的。

6.2 频繁项集挖掘方法

Apriori算法是一种发现频繁项集的基本算法,为布尔关联规则挖掘频繁项集的原创性算法。

1)Apriori算法:通过限制候选产生发现频繁项集

先验性质:频繁项集的所有非空子集也一定是频繁的。也称为反单调性(antimonotone),指如果一个集合不能通过测试,则它的所有超集也不能通过相同的测试。

基于先验性质,Apriori算法使用逐层搜索的迭代方法,其中k项集用于探索k+1项集。首先,通过扫描数据库,累计每个项的计数,并收集满足最小支持度的项,找出

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1227

1227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?