Playing with GCD题解

首先先上题目链接:Playing with GCD - 洛谷 | 计算机科学教育新生态 (luogu.com.cn)

附上代码

#include <bits/stdc++.h>

# define debug(a) cout<<(#a)<<" = "<<a<<endl

using namespace std;

int cases;

int lcm(int a,int b){

return a*b/__gcd(a,b);

}

void solve(){

int n;

cin>>n;

int aList[n+1];

int bList[n+1];

for (int i = 1; i <= n; ++i) cin>>aList[i];

bList[0]=aList[1],bList[n]=aList[n];

for (int i = 1; i < n; ++i) {

bList[i]=lcm(aList[i],aList[i+1]);

}

for (int i = 0; i <n ; ++i) {

if(__gcd(bList[i],bList[i+1])!=aList[i+1]){

cout<<"No"<<endl;

return;

}

}

cout<<"Yes"<<endl;

}

int main() {

freopen(R"(E:\sduhw\now\ACM\test.in)", "r", stdin);

freopen(R"(E:\sduhw\now\ACM\test.out)", "w", stdout);

cin>>cases;

for (int i = 0; i < cases; ++i) solve();

return 0;

}

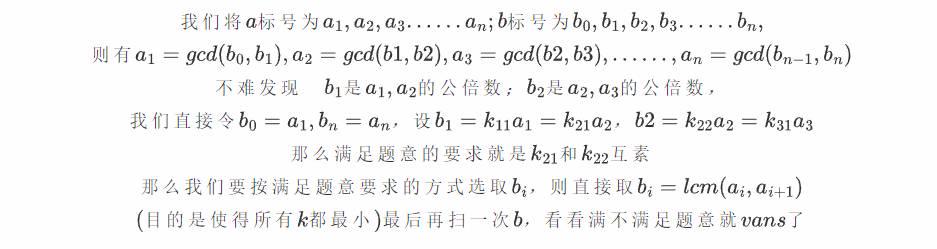

该文提供了一个C++代码解决方案,用于解决关于最大公约数(GCD)和最小公倍数(lcm)的编程问题。代码读取输入,计算数组中相邻元素的lcm,并检查它们的GCD是否符合题目要求。如果所有条件满足,则输出Yes,否则输出No”。

该文提供了一个C++代码解决方案,用于解决关于最大公约数(GCD)和最小公倍数(lcm)的编程问题。代码读取输入,计算数组中相邻元素的lcm,并检查它们的GCD是否符合题目要求。如果所有条件满足,则输出Yes,否则输出No”。

944

944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?