2021李宏毅机器学习笔记--18 Unsupervised Learning -- Neighbor Embedding

摘要

本节是进行非线性降维的一些算法。包括局部线性嵌入LLE、拉普拉斯特征映射和t分布随机邻居嵌入t-SNE,其中t-SNE特别适用于可视化的应用场景。t-SNE其中NE就是Neighbor Embedding的缩写。

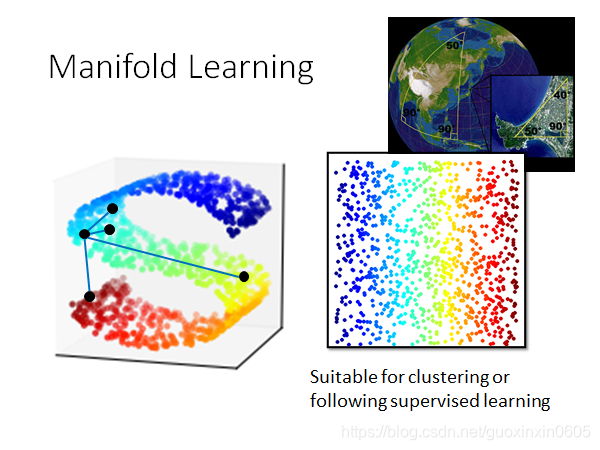

一、Manifold Learning(流形学习)

样本点的分布可能是在高维空间里的一个流形(Manifold),也就是说,样本点其实是分布在低维空间里面,只是被扭曲地塞到了一个高维空间里

常见的例子就是地球,地球的表面就是一个流形(Manifold),它是一个二维的平面,但是被塞到了一个三维空间里

如下图左,在一个高维的S形的空间图形中,如何判断几个点之间的距离。在Manifold中,只有距离很近的点欧氏距离(Euclidean Distance)才会成立,而在下图的S型曲面中,欧氏距离是无法判断两个样本点的相似程度的

而Manifold Learning要做的就是把这个S型曲面降维展开,把塞在高维空间里的低维空间摊平,此时使用欧氏距离就可以描述样本点之间的相似程度。

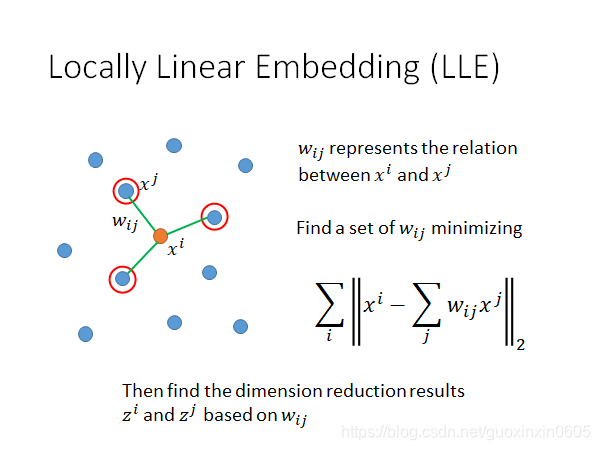

二、Locally Linear Embedding(LLE,局部线性嵌入)

局部线性嵌入,locally linear embedding,简称LLE

假设在原来的空间中,样本点的分布如下所示,我们关注 x i x^i xi和它的邻居 x j x^j xj,用 w i j w_{ij} wij来描述 x i x^i xi和 x j x^j xj的关系

假设每一个样本点 x i x^i xi都是可以用它的neighbor做linear combination组合而成,那 w i j w_{ij} wij就是拿 x j x^j xj去组合 x i x^i xi时的权重weight,因此找点与点的关系 w i j w_{ij} wij这个问题就转换成,找一组使得所有样本点与周围点线性组合的差距能够最小的参数 w i j w_{ij} wij

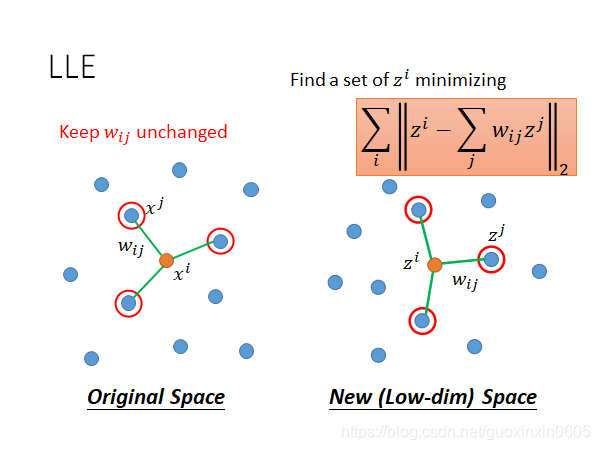

接下来就要做Dimension Reduction,把 x i x^i xi和 x j x^j xj降维到 z i z^i zi和 z j z^j zj,并且保持降维前后两个点之间的关系 w i j w_{ij} wij是不变的。

LLE的具体的步骤如下所示:

1、在原先的高维空间中先找到 x i x^i xi和 x j x^j xj之间的关系 w i j w_{ij} wij以后就把它固定住

2、使 x i x^i xi和 x j x^j xj降维到新的低维空间上的 z i z^i zi和 z j z^j zj

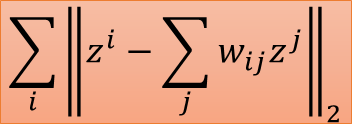

3、 z i z^i zi和 z j z^j zj需要minimize下面的式子:

即在原本的空间里 x i x^i xi可以由周围点通过参数 w i j w_{ij}

本文深入探讨无监督学习中的流形学习,重点关注局部线性嵌入(LLE)和t分布随机邻居嵌入(t-SNE)。LLE保持降维前后点与点的线性关系,而t-SNE利用t分布优化降维后的相似度,尤其适用于数据可视化。通过对比分析,揭示了这两种方法在高维数据降维和可视化中的作用。

本文深入探讨无监督学习中的流形学习,重点关注局部线性嵌入(LLE)和t分布随机邻居嵌入(t-SNE)。LLE保持降维前后点与点的线性关系,而t-SNE利用t分布优化降维后的相似度,尤其适用于数据可视化。通过对比分析,揭示了这两种方法在高维数据降维和可视化中的作用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

245

245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?