推理是 LLM 应用的重要一环,在部署服务环节影响重大,本文将讨论主流的 LLM 的推理优化技术。

一、子图融合(subgraph fusion)

图融合技术即通过将多个 OP(算子)合并成一个 OP(算子),来减少Kernel的调用。因为每一个基本 OP 都会对应一次 GPU kernel 的调用,和多次显存读写,这些都会增加大量额外的开销。

1.1 FasterTransformer by NVIDIA

FasterTransformer(FT) 是一个用于实现基于Transformer的神经网络推理的加速引擎。FT框架是用C++/CUDA编写的,依赖于高度优化的 cuBLAS、cuBLASLt 和 cuSPARSELt 库,与 NVIDIA TensorRT 等其他编译器相比,FT 的特点是它支持以分布式方式推理 Transformer 大模型。

图融合是FT 的一个重要特征,将多层神经网络组合成一个单一的神经网络,将使用一个单一的内核进行计算。 这种技术减少了数据传输并增加了数学密度,从而加速了推理阶段的计算。 例如, multi-head attention 块中的所有操作都可以合并到一个内核中。

除此之外,FT还对部分大模型分别支持:

INT8低精度量化推理- Ampere 架构的 GPU 硬件部分支持稀疏化

- Hopper 架构支持 FP8 推理

- Tensor 并行

- Pipeline 并行

1.2 DeepSpeed Inference by Microsoft

对于 Transformer layer,可分为以下4个主要部分:

- Input Layer-Norm plus Query, Key, and Value GeMMs and their bias adds.

- Transform plus Attention.

- Intermediate FF, Layer-Norm, Bias-add, Residual, and Gaussian Error Linear Unit (GELU).

- Bias-add plus Residual.

如图所示,每一部分可分别进行融合,与未融合相比,以上几个部分的加速比可分别达到 1.5x, 2.9x, 3x, 1.2x 。

除此之外,DeepSpeed Inference 的优化点还有以下几点:

- 多 GPU 的并行优化

- INT8 模型量化

- 推理的 pipeline 方案

更多详细介绍及实践可参考笔者之前的文章:

紫气东来:NLP(十二):DeepSpeed Inference 在 LLM 推理上的优化探究126 赞同 · 5 评论文章编辑

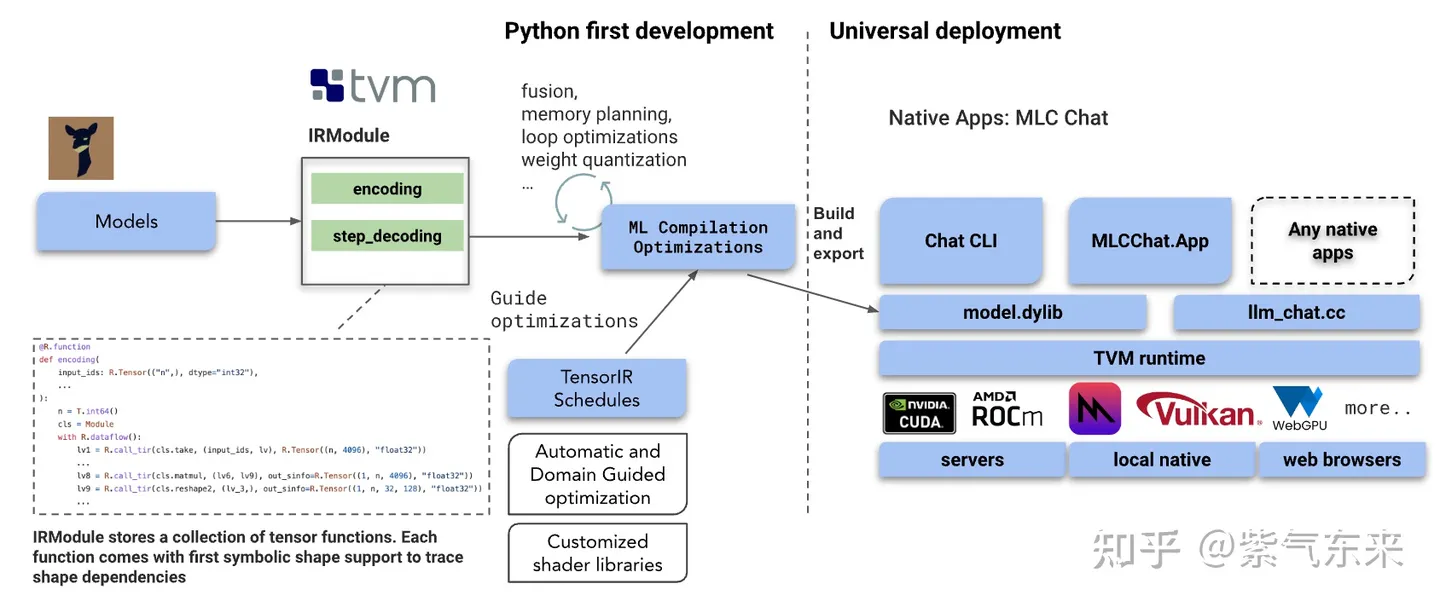

1.3 MLC LLM by TVM

之前介绍的推理方案主要是基于GPU的优化,而 MLC LLM 提供了可应用于移动端(例如 iPhone)、消费级电脑端(例如 Mac)和 Web 浏览器的轻设备解决方案。

MLC LLM 的主要工作流基于 Apache TVM Unity,通过扩展 TVM 后端使模型编译更加透明和高效。其中以编译代码转换、融合、内存规划和库卸载(library offloading)为代表的可组合的 ML 编译优化是其中重要的优化特性。

除此之外,MLC LLM 还具有以下特性:

- Dynamic shape:避免了对最大输入长度进行额外填充的需要,并减少了计算量和内存使用量。

- 量化:MLC LLM 利用低位量化来压缩模型权重,并利用 TVM 的 loop-level TensorIR 为不同的压缩编码方案快速定制代码生成。

- 运行时(Runtime):TVM 编译生成的库能够通过 TVM runtime 在设备的原生环境中运行,TVM runtime 支持 CUDA/Vulkan/Metal 等主流 GPU 驱动以及 C、JavaScript 等语言的绑定。

除了上述3种方案外,其他也支持图融合的方案还包括 NVIDIA TensorRT, Tencent TurboTransformers 等。

二、模型压缩(Model Compression)

模型压缩的基本动机在于当前的模型是冗余的,可以在精度损失很小的情况下实现模型小型化,主要包括3类方法:稀疏(Sparsity)、量化(Quantization)、蒸馏(Distillation)。

2.1 稀疏(Sparsity)

实现稀疏(Sparsity)的一个重要方法是剪枝(Pruning)。剪枝是在保留模型容量的情况下,通过修剪不重要的模型权重或连接来减小模型大小。 它可能需要也可能不需要重新培训。 修剪可以是非结构化的或结构化的。

- 非结构化剪枝允许删除任何权重或连接,因此它不保留原始网络架构。 非结构化剪枝通常不适用于现代硬件,并且不会带来实际的推理加速。

- 结构化剪枝旨在维持某些元素为零的密集矩阵乘法形式。 他们可能需要遵循某些模式限制才能使用硬件内核支持的内容。 当前的主流方法关注结构化剪枝,以实现 Transformer 模型的高稀疏性。

关于剪枝稀疏的基本原理,可参考笔者之前的文章:

紫气东来:NLP(八):大语言模型的稀疏化技术19 赞同 · 1 评论文章编辑

除了上文介绍的稀疏方法外,还有其他的稀疏化方法,包括但不限于:

- SparseGPT:该方法的工作原理是将剪枝问题简化为大规模的稀疏回归实例。它基于新的近似稀疏回归求解器,用于解决分层压缩问题,其效率足以在几个小时内使用单个 GPU 在最大的 GPT 模型(175B 参数)上执行。同时,SparseGPT 准确率足够高,不需要任何微调,剪枝后所损耗的准确率也可以忽略不计。

- LLM-Pruner:遵循经典的“重要性估计-剪枝-微调”的策略,能够在有限资源下完成大语言模型的压缩,结果表明即使剪枝 20% 的参数,压缩后的模型保留了 93.6% 的性能。

- Wanda: 该方法由两个简单但必不可少的组件构成——剪枝度量和剪枝粒度。剪枝度量用来评估权重的重要性,然后按照剪枝粒度进行裁剪。该方法在 65B 的模型上只需要 5.6 秒就可以完成剪枝,同时达到SparseGPT相近的效果。

以上主要实现了稀疏的方法,那么对于稀疏后的模型如何加速呢?NVIDIA Ampere 架构对与结构化稀疏做了专门的稀疏加速单元,下图展示了结构化稀疏的物理表示:

2:4 结构化稀疏表示

下图展示了稀疏单元GEMM计算与标准GEMM计算的区别(详细解释参见https://arxiv.org/pdf/2104.08378.pdf)

Sparse VS Dense GEMM

2.2 量化(Quantization)

常见量化有两种常见方法:

- 训练后量化(Post-Training Quantization,PTQ):模型首先经过训练以达到收敛,然后我们将其权重转换为较低的精度,而无需进行更多训练。 与训练相比,实施起来通常相当便宜。

- 量化感知训练(Quantization-Aware Training,QAT):在预训练或进一步微调期间应用量化。 QAT 能够获得更好的性能,但需要额外的计算资源和对代表性训练数据的访问。

实际上,由于 GPU 内核缺乏对某些类型的矩阵乘法(例如 INT4 x FP16)的支持,理论最优量化策略与硬件内核支持之间的差距,并非以下所有方法都能加速实际推理。

关于量化的基本原理和实现细节,可参考笔者之前的文章:

紫气东来:NLP(十一):大语言模型的模型量化(INT8/INT4)技术64 赞同 · 6 评论文章编辑

许多关于 Transformer 模型量化的研究都有相同的观察结果:简单的低精度(例如 8 bit)训练后量化会导致性能显着下降,这主要是由于动态的 activation 和静态的 weight 量化策略无法保持一致。

为了不损失精度而提高性能,可以考虑WeightOnly量化技术,即只把Weight量化成int8格式,以降低访存压力。到实际Kernel内部再Dequantize回fp16,进行矩阵乘计算。这种方法在BS较小是比较有效(因为此时的瓶颈在IO),BS 较大时(因为此时的瓶颈在计算)效果变差。

2.3 蒸馏(Distillation)

知识蒸馏是一种构建更小、更便宜的模型(“student 模型”)的直接方法,通过从预先训练的昂贵模型中转移技能来加速推理(“ teacher 模型”)融入 student。 除了与 teacher 匹配的输出空间以构建适当的学习目标之外,对于如何构建 student 架构没有太多限制。

知识蒸馏基本框架

给定数据集,训练 student 模型通过蒸馏损失来模仿 teacher 的输出。 通常神经网络有一个softmax层; 例如,LLM 输出 token 的概率分布。 将 softmax 之前的 logits 层表示为 �� 和 �� , 分别表示 teacher 和 student 模型。 蒸馏损失最小化两个 softmax 输出之间的差异(温度 � )。 当标签 � 已知,可以将其与student 的 logits 之间计算交叉熵,最后将两个损失相加,如下:

�KD=�distll (softmax(��,�),softmax(��,�))+��CE(�,��)

在 Transformer 中一个典型案例是DistilBERT,模型参数减少 40%,速度提升71%。在大模型时代,蒸馏可以与量化、剪枝或稀疏化技术相结合,其中 teacher 模型是原始的全精度密集模型,而 student 模型则经过量化、剪枝或修剪以具有更高的稀疏级别,以实现模型的小型化。

三、并行化(Parallelism)

当前的推理的并行化技术主要体现在3个维度上,即 3D Parallelism:

- Data Parallelism(DP)

- Tensor Parallelism(TP)

- Pipeline Parallelism(PP)

3D Parallelism 的3个维度

3.1 数据并行 (Data Parallelism, DP)

在推理中,DP 主要是增加设备数来增加系统整体 Throughput,其中最经典的即DeepSpeed的Zero系列

3.2 张量并行(Tensor Parallelism, TP)

在推理中,TP 主要是横向增加设备数通过并行计算来减少 latency,其实现原理及细节可参考笔者之前的文章

紫气东来:NLP(六):GPT 的张量并行化(tensor parallelism)方案23 赞同 · 2 评论文章编辑

当前主流的推理框架都支持 TP 的方式,包括但不限于:

3.3 流水线并行(Pipeline Parallelism, PP)

在推理中,PP 主要是纵向增加设备数通过并行计算来支持更大模型,同时提高设备利用率。

通常来说,PP 需要与 TP 结合以支持更大模型,并实现最佳效果

四、Transformer 结构优化

该类方法主要通过优化 Transformer 的结构以实现推理性能的提升。

4.1 FlashAttention

该部分的实现细节可参考笔者之前的文章,在此不予赘述

紫气东来:NLP(十七):从 FlashAttention 到 PagedAttention, 如何进一步优化 Attention 性能390 赞同 · 22 评论文章编辑

在原基础上做了改进,使其在算法、并行化和工作分区等方面都有了显著改进,对大模型的适用性也更强。在A100 上性能数据如下:

4.2 PagedAttention

同上

4.3 FLAT Attention

FLAT-Attention 与 FlashAttention 采取不同的路线来解决同一问题。 提出的解决方案有所不同,但关键思想是相同的(tiling 和 scheudling)。下面主要讨论二者不同之处:

4.3.1 Tiling 策略比较

FlashAttention 使用块平铺和权重固定。 FLAT-Attention 使用行平铺(行粒度)和输出固定。

4.3.2 Scheduling 策略(数据流)比较

FlashAttention 的 Scheduling 过程

FLAT-Attention 的 Scheduling 过程

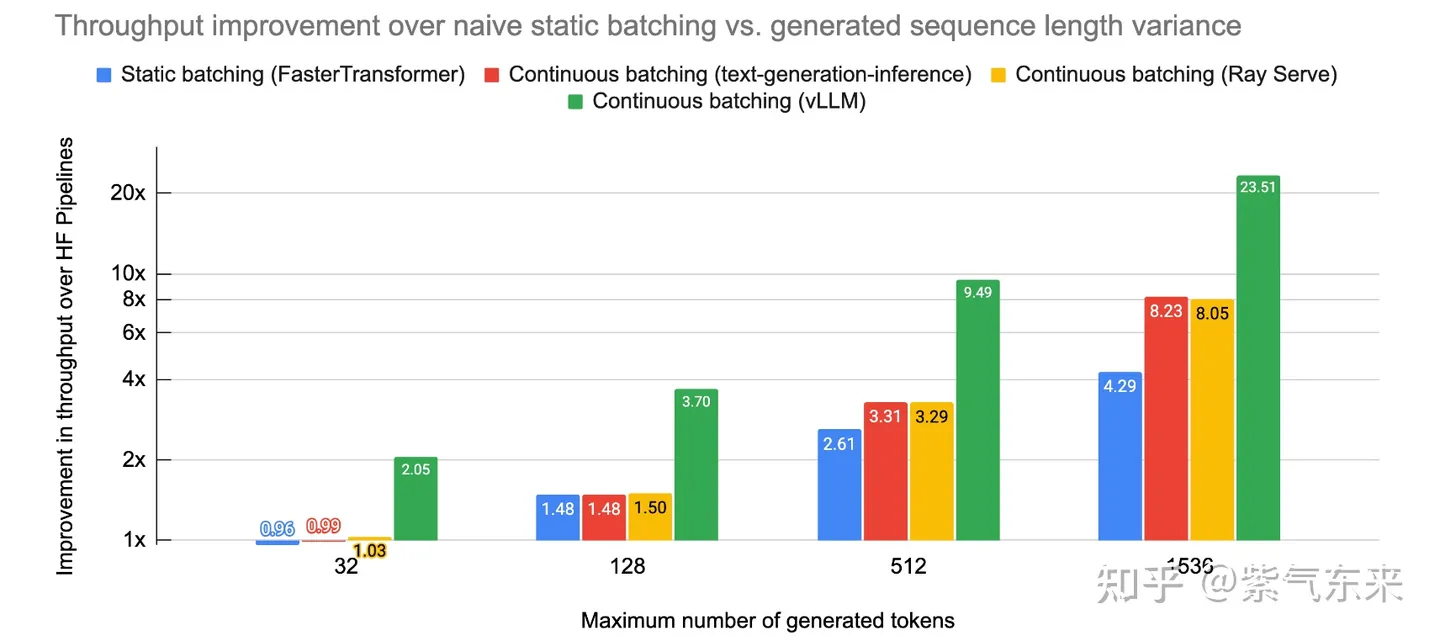

五、动态批处理(Dynamic Batch, Continuous batch)

该类方法主要是针对多 Batch 的场景,通过对 Batch 的时序优化,以达到去除 padding、提高吞吐和设备利用率。传统的 Batch 处理方法是静态的,因为Batch size 的大小在推理完成之前保持不变。

如下图所示,使用静态 Batch 完成四个序列。 在第一次迭代(左)中,每个序列从prompt(黄色)生成一个token(蓝色)。 经过几次迭代(右)后,每个完成的序列都有不同的大小,因为每个序列在不同的迭代中发出其序列结束标记(红色)。 可见序列 3 在两次迭代后就已经结束,但仍然需要等待 Batch 中的最后一个序列完成生成(在本例中,序列 2 在六次迭代后)才能统一输出,这意味着 GPU 未被充分利用。

下面我们来研究 Dynamic Batch 是如何优化这一过程的。

5.1 ORCA

Orca 不是等到 Batch 中的所有序列完成生成,而是实现 iteration 级调度,其中Batch size由每次迭代确定。 结果是,一旦 Batch 中的序列完成生成,就可以在其位置插入新序列,从而比静态 Batch 产生更高的 GPU 利用率。

下图展示了使用 Dynamic Batch 完成七个序列的过程。 左侧显示单次迭代后的批次,右侧显示多次迭代后的 Batch 。 一旦序列发出序列结束标记,就在其位置插入一个新序列(即序列 S5、S6 和 S7)。 这样可以实现更高的 GPU 利用率,因为 GPU 不会等待所有序列完成才开始新的序列。

结果显示在延时不变的情况下,其相对于FasterTransformer 可获得 36.9 倍的吞吐提升。

5.2 FastServe

ORCA 使用first-come-first-served (FCFS) 处理推理作业, 计划任务持续运行直至完成。 由于 GPU 内存容量有限以及推理对延时敏感,无法通过任意数量的传入函数来增加处理,由此可能会导致队列阻塞。

FastServe 使用 preemptive scheduling,通过新颖的跳跃连接 Multi-Level Feedback Queue 程序来最小化延时。 基于 LLM 推理的长度无法确定,调度程序利用输入长度信息来分配适当的初始值每个到达作业要加入的队列。 较高优先级队列跳过加入的队列以减少降级。 设计高效的GPU内存管理机制主动下载和上传 GPU 内存和主机内存之间的中间状态,以进行 LLM 推理。

实验表明,该方法比ORCA有明显的性能提升

5.3 vLLM

vLLM 的核心是 PagedAttention,其灵感来自传统操作系统概念,例如分页和虚拟内存。 它们通过在固定大小的“页面”或块中分配内存,允许 KV 缓存变得不连续。 然后可以重写 attention 机制以对块对齐的输入进行操作,从而允许在非连续的内存范围上执行 attention 。

这意味着 cache 分配可以 just-in-time,而不是 ahead-of-time:当启动一个新的生成任务时,框架不需要分配大小为 Maximum_context_length 的连续 cache。 每次迭代,调度程序都可以决定特定生成任务是否需要更多空间,并动态分配,而不会降低 PagedAttention 的性能。 这并不能保证内存的完美利用(浪费现在限制在 4% 以下,仅在最后一个块中),但它明显改善了当今业界广泛使用的提前分配方案的浪费 。

总而言之,PagedAttention + vLLM 可节省大量内存,因为大多数序列不会消耗整个上下文窗口。 这些内存节省直接转化为更高的 Batch 大小,这意味着更高的吞吐量和更便宜的服务。

实验表明,该方法相比于静态 Batch 与其他动态 Batch 的方法吞吐性能提升明显。

六、硬件升级

以上主要介绍了在算法和模型层面的优化方法,除此之外,升级硬件系统可以进一步提升整体性能,下面将介绍几种可用于(和潜在的)推理加速的硬件产品。

6.1 NVIDIA H100 PCIe

NVIDIA H100 核心架构与 Ampere 相似,数学运算部分布置在144组CUDA上,最高可拥有18432个FP32(单精度)、9216个FP64(双精度)CUDA核心,辅以576个第四代Tensor核心。H100核心采用台积电的N4工艺制造,内建800亿个晶体管,核心面积仅有814m㎡。其与A100 主要参数对比如下:

在性能方面,H100 较 A100 也有明显提升,其部分数据如下所示。

6.2 AMD MI300

AMD MI300 处理器集成了24个Zen 4架构CPU核心,以及CDNA 3架构GPU核心,周围还有着8颗HBM3高速缓存,容量高达128GB,总计拥有1460亿个晶体管。与上一代 MI250相比,MI300进行AI运算的速度将提高至8倍,能效方面也将提升5倍。

目前未找到公开的在 LLM 方面的推理性能数据。

6.3 Apple M2 Ultra

M2 Ultra 采用第二代 5 纳米工艺制造,并使用 Apple 突破性的 UltraFusion 技术连接两个 M2 Max 芯片的芯片,使性能提高一倍。 M2 Ultra 由 1340 亿个晶体管组成,比 M1 Ultra 多了 200 亿个。 其统一内存架构支持突破性的192GB内存容量,比M1 Ultra多出50%,并具有800GB/s的内存带宽,是M2 Max的两倍。 M2 Ultra 配备更强大的 CPU(比 M1 Ultra 快 20%)、更大的 GPU(快 30%)以及神经引擎(快 40%)。

目前未找到公开的在 LLM 方面的推理性能数据。

6.4 Graphcore IPU

Graphcore C600 IPU处理器PCIe卡是针对机器学习推理应用的高性能加速卡。每个IPU具有1472个处理核心,能够并行运行8832个独立程序线程。每个IPU都有900MB的片上SRAM存储。用户可以在单个机箱中直接连接多达8块卡,通过高带宽的IPU-Links进行桥接。在训练和推理自然语言处理 (NLP) 模型(如 BERT 和 GPT、图神经网络 (GNN)、目标检测、语音等)时表现出色的结果。

目前未找到公开的在 LLM 方面的推理性能数据。

6.5 Biren BR100

BR100是由壁仞科技发布自主研发的首款通用GPU芯片,其16位浮点算力达到1000T以上、8位定点算力达到2000T以上,单芯片峰值算力达到PFlops(1PFlops等于1000万亿次浮点指令/秒)级别。其与 H100 的参数对比如下所示:

目前未找到公开的在 LLM 方面的推理性能数据。

参考资料

[1] Large Transformer Model Inference Optimization

[2] Efficient Inference on a Single GPU

[4] https://www.coreweave.com/blog/serving-inference-for-llms-nvidia-triton-inference-server-eleuther-ai

[6] LLM-Pruner: On the Structural Pruning of Large Language Models

[7] https://jonathan-hui.medium.com/ai-chips-a100-gpu-with-nvidia-ampere-architecture-3034ed685e6e

[8] arxiv.org/pdf/2302.14017.pdf

[10] https://arxiv.org/pdf/2104.08378.pdf

[11] Introduction to Weight Quantization | Towards Data Science

[12] Accelerating Large Language Models via Low-Bit Quantization | NVIDIA On-Demand

417

417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?