概述

这篇论文的研究背景是在资源有限的用户设备上执行大型语言模型(LLM)的量化推理。 过去的方法针对LLM提出了一系列基于量化的方法,但在推理的内存需求方面仍然存在问题。这篇论文提出了一种新的自动生成代码的方法,通过优化硬件特性和特定方法的精度约束,实现了高性能和高准确性的推理。 本文提出的研究方法基于目标架构和性能模型,使用自动生成的代码来支持在CPU上进行LLM的量化推理。 通过在LLaMA模型上进行CPU推理的实验结果表明,这种方法能够在性能和准确性方面取得非常好的效果,与现有的最佳开源解决方案相比有着更好的表现。

重要问题探讨

1. 提到文中作者介绍了一种新的自动代码生成方法,该方法支持在 off-the-shelf CPUs 上对 LLMs 进行量化生成推断。这种方法是如何结合目标架构和性能模型来实现高性能和高准确性的? 答:该文章提到作者的方法通过结合目标架构和性能模型来支持高性能和高准确性。目标架构指的是所使用的 CPU 架构,性能模型包括硬件特性和方法特定的准确性约束。通过考虑目标架构和性能模型,作者能够在 off-the-shelf CPUs 上实现对 LLMs 的量化生成推断,并且在 CPU 上对 LLaMA 模型进行推断时,其性能和准确性均优于现有的最佳开源解决方案。

2. 文中提到,个性化生成型 LLM 推断的关键挑战是内存。请问为什么在执行个性化生成型 LLM 推断时,内存是一个主要的瓶颈和开销? 答:个性化生成型 LLM 的模型参数数量非常庞大,常常超过消费设备的内存容量。因此,在执行推断时,需要将模型参数从内存传输到计算设备,这会导致高昂的内存传输成本。由于模型参数数量庞大,传输开销会超过设备的带宽,成为内存瓶颈。

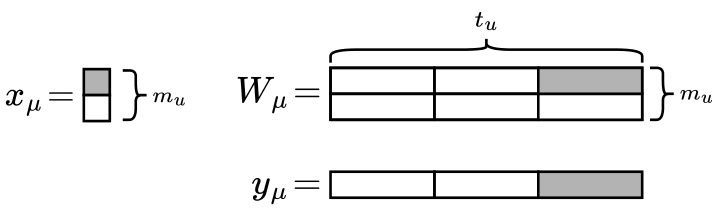

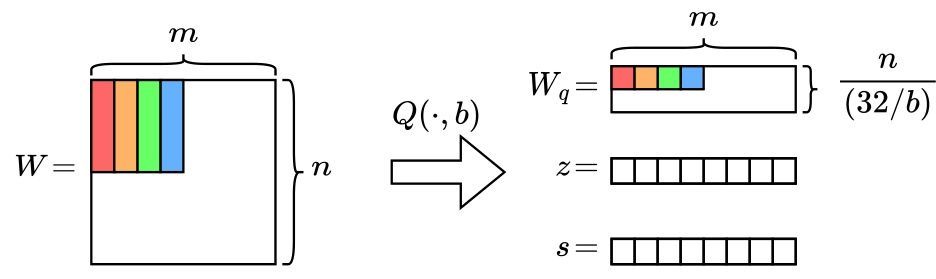

3. 文中提到,近期提出了一系列针对 LLM 的量化方法,旨在减小对准确性的影响。请问目前最佳的 LLM 量化方法是什么?其如何在保持高准确性的同时实现量化到更低比特位数的权重? 答:目前最佳的 LLM 量化方法是 GPTQ。GPTQ 方法可以将权重量化为 4 位,并通过将 64 个权重组合为一个块,并使用共享的尺度和零点来实现准确性的损失最小化。此外,还可以使用简单的最近舍入(RTN)量化技术,通过使用 4 位权重保持准确性。

4. 文中提到,在现有的学术提案中,有一些方法支持压缩的数值格式,并能够准确快速地在用户设备上执行 LLM。请问这些压缩的数值格式在系统支持上面临什么样的挑战? 答:压缩的数值格式在系统支持上面临着挑战。在执行 LLM 时,需要对这些压缩的数值格式进行高效处理,以实现准确且快速的推断。这需要对压缩数值格式进行有效的解压缩和处理,并在计算设备上进行优化,以支持高效的操作。

5. 文中提及了一个可供参考的初步实现。请问这个初步实现的功能如何?是否可靠和易于使用? 答:文中提供了一个初步实现的代码,可以在 https://github.com/IST-DASLab/QIGen 上获取。然而,由于文章未提供详细的信息,无法确定其功能的具体细节、可靠性和易用性。读者可以访问该链接获取更多信息,以评估该初步实现的实际效果和可行性。

GitHub链接:https://github.com/IST-DASLab/QIGen)

论文链接:https://arxiv.org/abs/2307.03738.pdf

3093

3093

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?