分享一下我老师大神的人工智能教程!零基础,通俗易懂!http://blog.csdn.net/jiangjunshow

也欢迎大家转载本篇文章。分享知识,造福人民,实现我们中华民族伟大复兴!

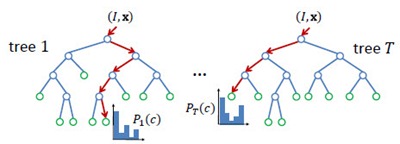

Random Forest(s),随机森林,又叫Random Trees[2][3],是一种由多棵决策树组合而成的联合预测模型,天然可以作为快速且有效的多类分类模型。如下图所示,RF中的每一棵决策树由众多split和node组成:split通过输入的test取值指引输出的走向(左或右);node为叶节点,决定单棵决策树的最终输出,在分类问题中为类属的概率分布或最大概率类属,在回归问题中为函数取值。整个RT的输出由众多决策树共同决定,argmax或者avg。

Node Test

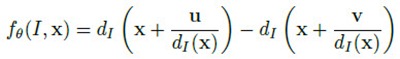

node test通常很简单,但很多简单的拧在一起就变得无比强大,联合预测模型就是这样的东西。node test是因应用而异的。比如[1]的应用是基于深度图的人体部位识别,使用的node test是基于像素x的深度比较测试:

简单的说,就是比较像素x在u和v位移上的像素点的深度差是否大于某一阈值。u和v位移除以x深度值是为了让深度差与x本身的深度无关,与人体离相机的距离无关。这种node test乍一看是没有意义的,事实上也是没多少意义的,单个test的分类结果可能也只是比随机分类好那么一丁点。但就像Haar特征这种极弱的特征一样,起作用的关键在于后续的Boosting或Bagging——有效的联合可以联合的力量。

Training

RF属于Bagging类模型,因此大体训练过程和Bagging类似,关键在于样本的随机选取避免模型的overfitting问题。RF中的每棵决策树是分开训练的,彼此之间并无关联。对于每棵决策树,训练之前形成一个样本子集,在这个子集中有些样本可能出现多次,而另一些可能一次都没出现。接下去,就是循序决策树训练算法的,针对这个样本子集的单棵决策树训练。

单棵决策树的生成大致遵循以下过程:

1)随机生成样本子集;

2)分裂当前节点为左右节点,比较所有可选分裂,选取最优者;

3)重复2)直至达到最大节点深度,或当前节点分类精度达到要求。

这一过程是贪婪的。

当然对于不同的应用场合,训练过程中,会有细节上的差别,比如样本子集的生成过程、以及最优分割的定义。

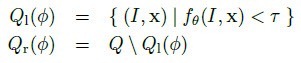

在[1]中,决策树的真实样本其实是图片中的像素x,变量值则是上文提到的node test。但是,对于一张固定大小的图片而言可取的像素x是可数大量的,可取的位移(u,v)和深度差阈值几乎是不可数无限的。因此,[1]在训练单棵决策树前,要做的样本子集随机其实涉及到像素x集合的随机生成、位移(u,v)和深度差阈值组合的随机生成,最后还有训练深度图集合本身的随机生成。

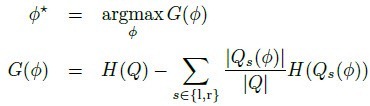

最优分裂通常定义为使信息增量最大的分类,如[1]中的定义:

H指熵,通过分裂子集的部位标签分布计算。

Reference:

[1] J. Shotton, A. Fitzgibbon, M. Cook, T. Sharp, M. Finocchio, R. Moore, A. Kipman, and A. Blake. Real-Time Human Pose Recognition in Parts from a Single Depth Image . In CVPR 2011.

[2] L. Breiman. Random forests . Mach. Learning, 45(1):5–32, 2001.

[3] T. Hastie, R. Tibshirani, J. H. Friedman. The Elements of Statistical Learning . ISBN-13 978-0387952840, 2003, Springer.

[4] V. Lepetit, P. Lagger, and P. Fua. Randomized trees for real-time keypoint recognition . In Proc. CVPR, pages 2:775–781, 2005.

在OpenCV1.0\ml\include\ml.h文件中,定义了机器学习的多种模型和算法的结构文件,现将有关决策树和随机森林的定义罗列如下:

结构体struct:

CvPair32s32f;

CvDTreeSplit;

CvDTreeNode;

CvDTreeParams;

CvDTreeTrainData;

CvRTParams;

类class:

CvDTree: public CvStatModel

CvForestTree: public CvDTree

CvRTrees: public CvStatModel

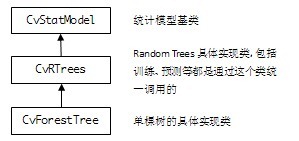

OpenCV2.3中Random Trees(R.T.)的继承结构:

API:

| CvRTParams | 定义R.T.训练用参数,CvDTreeParams的扩展子类,但并不用到CvDTreeParams(单一决策树)所需的所有参数。比如说,R.T.通常不需要剪枝,因此剪枝参数就不被用到。 max_depth 单棵树所可能达到的最大深度 min_sample_count 树节点持续分裂的最小样本数量,也就是说,小于这个数节点就不持续分裂,变成叶子了 regression_accuracy 回归树的终止条件,如果所有节点的精度都达到要求就停止 use_surrogates 是否使用代理分裂。通常都是false,在有缺损数据或计算变量重要性的场合为true,比如,变量是色彩,而图片中有一部分区域因为光照是全黑的 max_categories 将所有可能取值聚类到有限类,以保证计算速度。树会以次优分裂(suboptimal split)的形式生长。只对2种取值以上的树有意义 priors 优先级设置,设定某些你尤其关心的类或值,使训练过程更关注它们的分类或回归精度。通常不设置 calc_var_importance 设置是否需要获取变量的重要值,一般设置true nactive_vars 树的每个节点随机选择变量的数量,根据这些变量寻找最佳分裂。如果设置0值,则自动取变量总和的平方根 max_num_of_trees_in_the_forest R.T.中可能存在的树的最大数量 forest_accuracy 准确率(作为终止条件) termcrit_type 终止条件设置 — CV_TERMCRIT_ITER 以树的数目为终止条件,max_num_of_trees_in_the_forest生效 – CV_TERMCRIT_EPS 以准确率为终止条件,forest_accuracy生效 — CV_TERMCRIT_ITER | CV_TERMCRIT_EPS 两者同时作为终止条件 |

| CvRTrees::train | 训练R.T. return bool 训练是否成功 train_data 训练数据:样本(一个样本由固定数量的多个变量定义),以Mat的形式存储,以列或行排列,必须是CV_32FC1格式 tflag trainData的排列结构 — CV_ROW_SAMPLE 行排列 — CV_COL_SAMPLE 列排列 responses 训练数据:样本的值(输出),以一维Mat的形式存储,对应trainData,必须是CV_32FC1或CV_32SC1格式。对于分类问题,responses是类标签;对于回归问题,responses是需要逼近的函数取值 var_idx 定义感兴趣的变量,变量中的某些,传null表示全部 sample_idx 定义感兴趣的样本,样本中的某些,传null表示全部 var_type 定义responses的类型 — CV_VAR_CATEGORICAL 分类标签 — CV_VAR_ORDERED(CV_VAR_NUMERICAL)数值,用于回归问题 missing_mask 定义缺失数据,和train_data一样大的8位Mat params CvRTParams定义的训练参数 |

| CvRTrees::train | 训练R.T.(简短版的train函数) return bool 训练是否成功 data 训练数据:CvMLData格式,可从外部.csv格式的文件读入,内部以Mat形式存储,也是类似的value / responses / missing mask。 params CvRTParams定义的训练参数 |

| CvRTrees:predict | 对一组输入样本进行预测(分类或回归) return double 预测结果 sample 输入样本,格式同CvRTrees::train的train_data missing_mask 定义缺失数据 |

Example:

- #include <cv.h>

- #include <stdio.h>

- #include <highgui.h>

- #include <ml.h>

- #include <map>

- void print_result(float train_err, float test_err,

- const CvMat* _var_imp)

- {

- printf( "train error %f\n", train_err );

- printf( "test error %f\n\n", test_err );

- if (_var_imp)

- {

- cv::Mat var_imp(_var_imp), sorted_idx;

- cv::sortIdx(var_imp, sorted_idx, CV_SORT_EVERY_ROW +

- CV_SORT_DESCENDING);

- printf( "variable importance:\n" );

- int i, n = (int)var_imp.total();

- int type = var_imp.type();

- CV_Assert(type == CV_32F || type == CV_64F);

- for( i = 0; i < n; i++)

- {

- int k = sorted_idx.at<int>(i);

- printf( "%d\t%f\n", k, type == CV_32F ?

- var_imp.at<float>(k) :

- var_imp.at<double>(k));

- }

- }

- printf("\n");

- }

- int main()

- {

- const char* filename = "data.xml";

- int response_idx = 0;

- CvMLData data;

- data.read_csv( filename ); // read data

- data.set_response_idx( response_idx ); // set response index

- data.change_var_type( response_idx,

- CV_VAR_CATEGORICAL ); // set response type

- // split train and test data

- CvTrainTestSplit spl( 0.5f );

- data.set_train_test_split( &spl );

- data.set_miss_ch("?"); // set missing value

- CvRTrees rtrees;

- rtrees.train( &data, CvRTParams( 10, 2, 0, false,

- 16, 0, true, 0, 100, 0, CV_TERMCRIT_ITER ));

- print_result( rtrees.calc_error( &data, CV_TRAIN_ERROR),

- rtrees.calc_error( &data, CV_TEST_ERROR ),

- rtrees.get_var_importance() );

- return 0;

- }

References:

[1] OpenCV 2.3 Online Documentation: http://opencv.itseez.com/modules/ml/doc/random_trees.html

[2] Random Forests, Leo Breiman and Adele Cutler: http://www.stat.berkeley.edu/users/breiman/RandomForests/cc_home.htm

[3] T. Hastie, R. Tibshirani, J. H. Friedman. The Elements of Statistical Learning. ISBN-13 978-0387952840, 2003, Springer.

源码细节:

● 训练函数

const CvMat* _responses, const CvMat* _var_idx,

const CvMat* _sample_idx, const CvMat* _var_type,

const CvMat* _missing_mask, CvRTParams params )

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?