曾经推出过PyTorch实现的LSTM时间序列预测,并开源了其源码。细心的童鞋可能发现了,我之前使用的LSTM是生成式模型,而不是使用判别式进行预测。换言之,就是将序列本身作为输入,下一时刻作为输出,模型表达的是序列的联合概率分布。有兴趣的可以将其改写为判别模型。

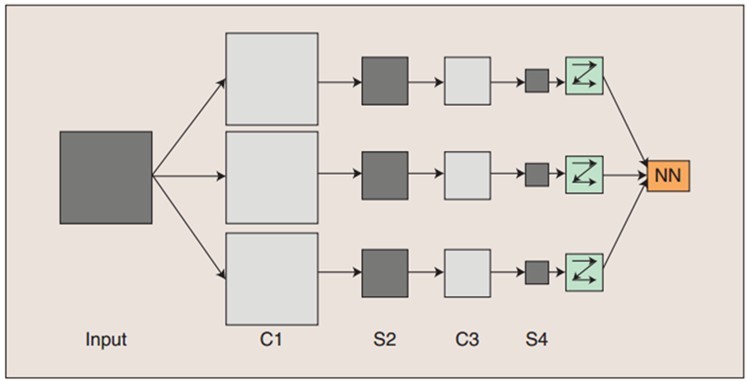

此处将使用卷积神经网络(CNN)用于时间序列预测。区别于图像处理(二维卷积如图所示)模型如下:

C1表示卷积操作1

S2表示max-pooling

C3表示卷积操作2

S4表示max-pooling

最后再接一层全连接层输出

CNN用于序列预测时使用的是一维卷积,也就是我们熟悉的离散序列的卷积和,具体公式可以表示为:

a={a0,a1,a2,…,am},L(a)=m+1

b={b0,b1,b2,…,bk},L(b)=k+1

用a*b表示a与b卷积后得到的一

本文介绍如何使用PyTorch构建一维卷积神经网络(CNN)进行时间序列预测。不同于传统的图像处理中应用的二维卷积,这里的CNN采用一维卷积来处理序列数据。通过卷积、池化等操作,模型能够捕获序列中的特征并进行预测。文中提供了包含两层卷积和两次最大池化的CNN模型结构,并提到了源码的开放情况。

本文介绍如何使用PyTorch构建一维卷积神经网络(CNN)进行时间序列预测。不同于传统的图像处理中应用的二维卷积,这里的CNN采用一维卷积来处理序列数据。通过卷积、池化等操作,模型能够捕获序列中的特征并进行预测。文中提供了包含两层卷积和两次最大池化的CNN模型结构,并提到了源码的开放情况。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5040

5040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?