PS.该贴为记录矩阵分解的一点学习笔记。以后会慢慢优化。

目前该帖子有点凌乱,但是逻辑基本上没有遗漏。

至于公式原理我个人也还在熟悉当中.........

目录

1 矩阵分解简介

协同过滤算法的特点就是完全没有利用到物品本身或者是用户自身的属性, 仅仅利用了用户与物品的交互信息就可以实现推荐,是一个可解释性很强, 非常直观的模型, 但是也存在一些问题, 第一个就是处理稀疏矩阵的能力比较弱, 所以为了使得协同过滤更好处理稀疏矩阵问题,增强泛化能力, 从协同过滤中衍生出矩阵分解模型(Matrix Factorization,MF)或者叫隐语义模型, 两者差不多说的一个意思, 就是在协同过滤共现矩阵的基础上, 使用更稠密的隐向量表示用户和物品,挖掘用户和物品的隐含兴趣和隐含特征, 在一定程度上弥补协同过滤处理稀疏矩阵能力不足的问题。

2 隐语义模型

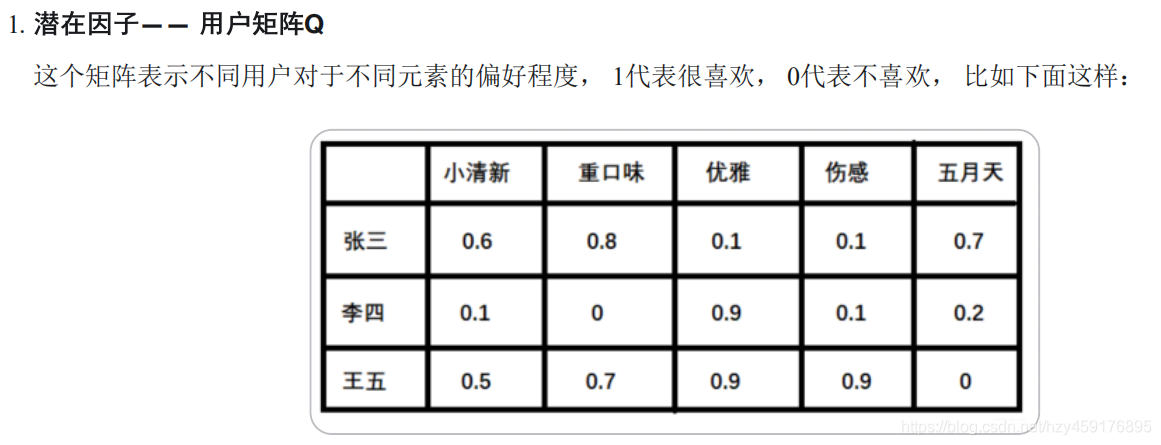

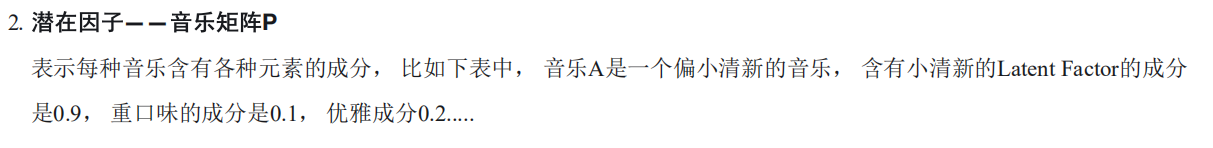

隐语义模型最早在文本领域被提出,用于找到文本的隐含语义。在2006年, 被用于推荐中, 它的核心思想是通过隐含特征(latent factor)联系用户兴趣和物品(item), 基于用户的行为找出潜在的主题和分类, 然后对item进行自动聚类,划分到不同类别/主题(用户的兴趣)。这么说可能有点抽象,所以下面拿项亮老师《推荐系统实践》里面的那个例子看一下:

如果我们知道了用户A和用户B两个用户在豆瓣的读书列表, 从他们的阅读列表可以看出,用户A的兴趣涉及侦探小

说、科普图书以及一些计算机技术书, 而用户B的兴趣比较集中在数学和机器学习方面。 那么如何给A和B推荐图书呢?

先说说协同过滤算法, 这样好对比不同:

1. 对于UserCF,首先需要找到和他们看了同样书的其他用户(兴趣相似的用户),然后给他们推荐那些用户喜欢的其他书。

2. 对于ItemCF,需要给他们推荐和他们已经看的书相似的书,比如作者B看了很多关于数据挖掘的书,可以给他推荐机器学习或者模式识别方面的书。

而如果是隐语义模型的话, 它会先通过一些角度把用户兴趣和这些书归一下类, 当来了用户之后, 首先得到他的兴趣分类, 然后从这个分类中挑选他可能喜欢的书籍。这里就看到了隐语义模型和协同过滤的不同, 这里说的角度其实就是这个隐含特征, 比如书籍的话它的内容, 作者, 年份, 主题等都可以算隐含特征,如果这个例子还不是很清晰的话, 那么下面再举个更为具体的例子, 看看是如何通过隐含特征来划分开用户兴趣和物品的。

上面例子中的小清晰, 重口味, 优雅这些就可以看做是隐含特征, 而通过这个隐含特征就可以把用户的兴趣和音乐的进行一个分类, 其实就是找到了每个用户每个音乐的一个隐向量表达形式(embedding的原理其实也是这样, 那里是找到每个词的隐向量表达), 这个隐向量就可以反映出用户的兴趣和物品的风格,并能将相似的物品推荐给相似的用户等。 有没有感觉到是把协同过滤算法进行了一种延伸, 把用户的相似性和物品的相似性通过了一个叫做隐向量的方式进行表达。

这种矩阵非常的稀疏,如果直接基于用户相似性或者物品相似性去填充这个矩阵是不太容易的, 并且很容易出现长尾问题, 所以矩阵分解就可以比较容易的解决这个问题。矩阵分解模型其实就是在想办法基于这个评分矩阵去找到上面例子中的那两个矩阵, 也就是用户兴趣和物品的隐向量表达, 然后就把这个评分矩阵分解成Q和P两个矩阵乘积的形式, 这时候就可以基于这两个矩阵去预测某个用户对某个物品的评分了。 然后基于这个评分去进行推荐。这就是矩阵分解算法的原理。

3 矩阵分解算法原理

4 矩阵分解的求解和basic SVD

(1)传统特征值分解

(2)basic SVD

有了目标函数,就可以使用梯度下降法进行优化更新了!!!!!(具体不再赘述,或者以后再加上求导的公式)

5 python实现

class SVD():

def __init__(self, rating_data, F=5, alpha=0.1, lmbda=0.1, max_iter=100):

self.F = F # 这个表示隐向量的维度

self.P = dict() # 用户矩阵P 大小是[users_num, F]

self.Q = dict() # 物品矩阵Q 大小是[item_nums, F]

self.bu = dict() # 用户偏差系数

self.bi = dict() # 物品偏差系数

self.mu = 0.0 # 全局偏差系数

self.alpha = alpha # 学习率

self.lmbda = lmbda # 正则项系数

self.max_iter = max_iter # 最大迭代次数

self.rating_data = rating_data # 评分矩阵

# 初始化矩阵P和Q, 方法很多, 一般用随机数填充, 但随机数大小有讲究, 根据经验, 随机数需要和1/sqrt(F)成正比

cnt = 0 # 统计总的打分数, 初始化mu用

for user, items in self.rating_data.items():

self.P[user] = [random.random() / math.sqrt(self.F) for x in range(0, F)]

self.bu[user] = 0

cnt += len(items)

for item, rating in items.items():

if item not in self.Q:

self.Q[item] = [random.random() / math.sqrt(self.F) for x in range(0, F)]

self.bi[item] = 0

self.mu /= cnt

# 有了矩阵之后, 就可以进行训练, 这里使用随机梯度下降的方式训练参数P和Q

def train(self):

for step in range(self.max_iter):

for user, items in self.rating_data.items():

for item, rui in items.items():

rhat_ui = self.predict(user, item) # 得到预测评分

# 计算误差

e_ui = rui - rhat_ui

self.bu[user] += self.alpha * (e_ui - self.lmbda * self.bu[user])

self.bi[item] += self.alpha * (e_ui - self.lmbda * self.bi[item])

# 随机梯度下降更新梯度

for k in range(0, self.F):

self.P[user][k] += self.alpha * (e_ui*self.Q[item][k] - self.lmbda * self.P[user][k])

self.Q[item][k] += self.alpha * (e_ui*self.P[user][k] - self.lmbda * self.Q[item][k])

self.alpha *= 0.1 # 每次迭代步长要逐步缩小

# 预测user对item的评分, 这里没有使用向量的形式

def predict(self, user, item):

return sum(self.P[user][f] * self.Q[item][f] for f in range(0, self.F)) + self.bu[user] + self.bi[item] + self.mu# 定义数据集, 也就是那个表格, 注意这里我们采用字典存放数据, 因为实际情况中数据是非常稀疏的, 很少有情况

是现在这样

def loadData():

rating_data={1: {'A': 5, 'B': 3, 'C': 4, 'D': 4},

2: {'A': 3, 'B': 1, 'C': 2, 'D': 3, 'E': 3},

3: {'A': 4, 'B': 3, 'C': 4, 'D': 3, 'E': 5},

4: {'A': 3, 'B': 3, 'C': 1, 'D': 5, 'E': 4},

5: {'A': 1, 'B': 5, 'C': 5, 'D': 2, 'E': 1}

}

return rating_data

# 接下来就是训练和预测

rating_data = loadData()

basicsvd = SVD(rating_data, F=10)

basicsvd.train()

for item in ['E']:

print(item, basicsvd.predict(1, item))

## 结果:

E 3.252210242858994

本文介绍了矩阵分解在推荐系统中的应用,重点讲解了其解决稀疏矩阵问题的优势,并通过实例展示了矩阵分解的具体实现过程。

本文介绍了矩阵分解在推荐系统中的应用,重点讲解了其解决稀疏矩阵问题的优势,并通过实例展示了矩阵分解的具体实现过程。

1389

1389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?