文章目录

1. GBDT 概述

GBDT(梯度提升树)也是集成学习Boosting家族的成员,但是却和传统的Adaboost有很大的不同。回顾下Adaboost,我们是利用前一轮迭代弱学习器的误差率来更新训练集的权重,这样一轮轮的迭代下去。GBDT也是迭代,使用了前向分布算法,但是弱学习器限定了只能使用CART回归树模型,同时迭代思路和Adaboost也有所不同。

GBDT的迭代是针对当前模型的负梯度来进行拟合,比如当前模型与真实值差为5,下一个弱学习器用4去拟合差值5,还剩下1,下下个弱学习器又用0.5去拟合差值1,还剩0.5,使值误差越来越小。

2. GBDT 负梯度拟合

设学习器为

F

F

F,损失函数为

L

(

y

,

F

)

L(y,F)

L(y,F),则根据梯度下降有:

F

i

=

F

i

−

1

−

d

L

(

y

,

F

)

d

F

F_i = F_{i-1}- \frac{dL(y,F)}{dF}

Fi=Fi−1−dFdL(y,F)GBDT采用的是加法模型,即

F

i

=

F

i

−

1

+

T

F_i = F_{i-1} + T

Fi=Fi−1+T所以得到拟合的目标即是负梯度

T

=

−

d

L

(

y

,

F

)

d

F

T=-\frac{dL(y,F)}{dF}

T=−dFdL(y,F)

3. GBDT 损失函数

3.1 分类算法

- 指数损失函数

L ( y , f ( x ) ) = e x p ( − y f ( x ) ) L(y, f(x)) = exp(-yf(x)) L(y,f(x))=exp(−yf(x)) - 二分类对数损失

L ( y , f ( x ) ) = l o g ( 1 + e x p ( − y f ( x ) ) ) L(y, f(x)) = log(1+ exp(-yf(x))) L(y,f(x))=log(1+exp(−yf(x))) - 多分类对数损失,设类别数为

K

K

K,

L ( y , f ( x ) ) = − ∑ k = 1 K y k l o g p k ( x ) L(y, f(x)) = - \sum\limits_{k=1}^{K}y_klog\;p_k(x) L(y,f(x))=−k=1∑Kyklogpk(x)

3.2 回归算法

- 均方差

L ( y , f ( x ) ) = ( y − f ( x ) ) 2 L(y, f(x)) =(y-f(x))^2 L(y,f(x))=(y−f(x))2 - 绝对损失

L ( y , f ( x ) ) = ∣ y − f ( x ) ∣ L(y, f(x)) =|y-f(x)| L(y,f(x))=∣y−f(x)∣负梯度为

s i g n ( y i − f ( x i ) ) sign(y_i-f(x_i)) sign(yi−f(xi)) - Huber损失,它是均方差和绝对损失的折中产物,对于远离中心的异常点,采用绝对损失,而中心附近的点采用均方差。这个界限一般用分位数点度量。损失函数如下:

L ( y , f ( x ) ) = { 1 2 ( y − f ( x ) ) 2 ∣ y − f ( x ) ∣ ≤ δ δ ( ∣ y − f ( x ) ∣ − δ 2 ) ∣ y − f ( x ) ∣ > δ L(y, f(x))= \begin{cases} \frac{1}{2}(y-f(x))^2& {|y-f(x)| \leq \delta}\\ \delta(|y-f(x)| - \frac{\delta}{2})& {|y-f(x)| > \delta} \end{cases} L(y,f(x))={21(y−f(x))2δ(∣y−f(x)∣−2δ)∣y−f(x)∣≤δ∣y−f(x)∣>δ

负梯度为:

r ( y i , f ( x i ) ) = { y i − f ( x i ) ∣ y i − f ( x i ) ∣ ≤ δ δ s i g n ( y i − f ( x i ) ) ∣ y i − f ( x i ) ∣ > δ r(y_i, f(x_i))= \begin{cases} y_i-f(x_i)& {|y_i-f(x_i)| \leq \delta}\\ \delta sign(y_i-f(x_i))& {|y_i-f(x_i)| > \delta} \end{cases} r(yi,f(xi))={yi−f(xi)δsign(yi−f(xi))∣yi−f(xi)∣≤δ∣yi−f(xi)∣>δ - 分位数损失。它对应的是分位数回归的损失函数,表达式为

L ( y , f ( x ) ) = ∑ y ≥ f ( x ) θ ∣ y − f ( x ) ∣ + ∑ y < f ( x ) ( 1 − θ ) ∣ y − f ( x ) ∣ L(y, f(x)) =\sum\limits_{y \geq f(x)}\theta|y - f(x)| + \sum\limits_{y < f(x)}(1-\theta)|y - f(x)| L(y,f(x))=y≥f(x)∑θ∣y−f(x)∣+y<f(x)∑(1−θ)∣y−f(x)∣

负梯度为

r ( y i , f ( x i ) ) = { θ y i ≥ f ( x i ) θ − 1 y i < f ( x i ) r(y_i, f(x_i))= \begin{cases} \theta& { y_i \geq f(x_i)}\\ \theta - 1 & {y_i < f(x_i) } \end{cases} r(yi,f(xi))={θθ−1yi≥f(xi)yi<f(xi)

对于Huber损失和分位数损失,主要用于减少异常点对损失函数的影响。

4. GBDT 回归算法

输入是训练集样本

T

=

{

(

x

,

y

1

)

,

(

x

2

,

y

2

)

,

.

.

.

(

x

m

,

y

m

)

}

T=\{(x_,y_1),(x_2,y_2), ...(x_m,y_m)\}

T={(x,y1),(x2,y2),...(xm,ym)},最大迭代次数

T

T

T, 损失函数

L

L

L。

输出是强学习器

f

(

x

)

f(x)

f(x)。

(1) 初始化弱学习器

f

0

(

x

)

=

a

r

g

m

i

n

⏟

c

∑

i

=

1

m

L

(

y

i

,

c

)

f_0(x) = \underbrace{arg\; min}_{c}\sum\limits_{i=1}^{m}L(y_i, c)

f0(x)=c

argmini=1∑mL(yi,c)(2) 对迭代轮数

t

=

1

,

2

,

⋯

,

T

t=1,2,\cdots,T

t=1,2,⋯,T 有:

(a) 对样本

i

=

1

,

2

,

⋯

,

m

i=1,2,\cdots,m

i=1,2,⋯,m,计算负梯度

r

t

i

=

−

[

∂

L

(

y

i

,

f

(

x

i

)

)

)

∂

f

(

x

i

)

]

f

(

x

)

=

f

t

−

1

(

x

)

r_{ti} = -\bigg[\frac{\partial L(y_i, f(x_i)))}{\partial f(x_i)}\bigg]_{f(x) = f_{t-1}\;\; (x)}

rti=−[∂f(xi)∂L(yi,f(xi)))]f(x)=ft−1(x)

(b) 利用

(

x

i

,

r

t

i

)

(

i

=

1

,

2

,

⋯

,

m

)

(x_i,r_{ti})\;\; (i=1,2,\cdots,m)

(xi,rti)(i=1,2,⋯,m), 拟合一棵CART回归树,得到第

t

t

t 棵回归树,其对应的叶子节点区域为

R

t

j

,

j

=

1

,

2

,

.

.

.

,

J

R_{tj}, j =1,2,..., J

Rtj,j=1,2,...,J,其中

J

J

J 为回归树

t

t

t 的叶子节点的个数。

(c) 对叶子区域

j

=

1

,

2

,

⋯

,

J

j =1,2,\cdots,J

j=1,2,⋯,J ,计算最佳拟合值

c

t

j

=

a

r

g

m

i

n

⏟

c

∑

x

i

∈

R

t

j

L

(

y

i

,

f

t

−

1

(

x

i

)

+

c

)

c_{tj} = \underbrace{arg\; min}_{c}\sum\limits_{x_i \in R_{tj}} L(y_i,f_{t-1}(x_i) +c)

ctj=c

argminxi∈Rtj∑L(yi,ft−1(xi)+c) (d) 更新强学习器

f

t

(

x

)

=

f

t

−

1

(

x

)

+

∑

j

=

1

J

c

t

j

I

(

x

∈

R

t

j

)

f_{t}(x) = f_{t-1}(x) + \sum\limits_{j=1}^{J}c_{tj}I(x \in R_{tj})

ft(x)=ft−1(x)+j=1∑JctjI(x∈Rtj)(3) 构建最终学习器为:

f

(

x

)

=

f

T

(

x

)

=

f

0

(

x

)

+

∑

t

=

1

T

∑

j

=

1

J

c

t

j

I

(

x

∈

R

t

j

)

f(x) = f_T(x) =f_0(x) + \sum\limits_{t=1}^{T}\sum\limits_{j=1}^{J}c_{tj}I(x \in R_{tj})

f(x)=fT(x)=f0(x)+t=1∑Tj=1∑JctjI(x∈Rtj)

5. GBDT 二分类算法

对于二元GBDT,如果用类似于逻辑回归的对数似然损失函数,则损失函数为:

L

(

y

,

f

(

x

)

)

=

l

o

g

(

1

+

e

x

p

(

−

y

f

(

x

)

)

)

L(y, f(x)) = log(1+ exp(-yf(x)))

L(y,f(x))=log(1+exp(−yf(x)))其中

y

∈

{

−

1

,

+

1

}

y \in\{-1, +1\}

y∈{−1,+1},则此时的负梯度误差为

r

t

i

=

−

[

∂

L

(

y

,

f

(

x

i

)

)

)

∂

f

(

x

i

)

]

f

(

x

)

=

f

t

−

1

(

x

)

=

y

i

(

1

+

e

x

p

(

y

i

f

(

x

i

)

)

)

r_{ti} = -\bigg[\frac{\partial L(y, f(x_i)))}{\partial f(x_i)}\bigg]_{f(x) = f_{t-1}\;\; (x)} = \frac{y_i}{(1+exp(y_if(x_i)))}

rti=−[∂f(xi)∂L(y,f(xi)))]f(x)=ft−1(x)=(1+exp(yif(xi)))yi对于生成的决策树,我们各个叶子节点的最佳负梯度拟合值为

c

t

j

=

a

r

g

m

i

n

⏟

c

∑

x

i

∈

R

t

j

l

o

g

(

1

+

e

x

p

(

−

y

i

(

f

t

−

1

(

x

i

)

+

c

)

)

)

c_{tj} = \underbrace{arg\; min}_{c}\sum\limits_{x_i \in R_{tj}} log(1+exp(-y_i(f_{t-1}(x_i) +c)))

ctj=c

argminxi∈Rtj∑log(1+exp(−yi(ft−1(xi)+c)))由于上式比较难优化,我们一般使用近似值代替

c

t

j

=

∑

x

i

∈

R

t

j

r

t

i

∑

x

i

∈

R

t

j

∣

r

t

i

∣

(

1

−

∣

r

t

i

∣

)

c_{tj} =\frac{ \sum\limits_{x_i \in R_{tj}}r_{ti}}{ \sum\limits_{x_i \in R_{tj}}|r_{ti}|(1-|r_{ti}|)}

ctj=xi∈Rtj∑∣rti∣(1−∣rti∣)xi∈Rtj∑rti除了负梯度计算和叶子节点的最佳负梯度拟合的线性搜索,二元GBDT分类和GBDT回归算法过程相同。

6. GBDT 多分类算法

假设类别数为K,则此时我们的对数似然损失函数为:

L

(

y

,

f

(

x

)

)

=

−

∑

k

=

1

K

y

k

l

o

g

p

k

(

x

)

L(y, f(x)) = - \sum\limits_{k=1}^{K}y_klog\;p_k(x)

L(y,f(x))=−k=1∑Kyklogpk(x)其中如果样本输出类别为

k

k

k,则

y

k

=

1

y_k=1

yk=1。第

k

k

k 类的概率

p

k

(

x

)

p_k(x)

pk(x) 的表达式为:

p

k

(

x

)

=

e

x

p

(

f

k

(

x

)

)

∑

l

=

1

K

e

x

p

(

f

l

(

x

)

)

p_k(x) = \frac{exp(f_k(x)) }{\sum\limits_{l=1}^{K} exp(f_l(x))}

pk(x)=l=1∑Kexp(fl(x))exp(fk(x))集合上两式,我们可以计算出第

t

t

t 轮的第 $ i$ 个样本对应类别

l

l

l 的负梯度误差为

r

t

i

l

=

−

[

∂

L

(

y

i

,

f

(

x

i

)

)

)

∂

f

(

x

i

)

]

f

k

(

x

)

=

f

l

,

t

−

1

(

x

)

=

y

i

l

−

p

l

,

t

−

1

(

x

i

)

r_{til} = -\bigg[\frac{\partial L(y_i, f(x_i)))}{\partial f(x_i)}\bigg]_{f_k(x) = f_{l, t-1}\;\; (x)} = y_{il} - p_{l, t-1}(x_i)

rtil=−[∂f(xi)∂L(yi,f(xi)))]fk(x)=fl,t−1(x)=yil−pl,t−1(xi)对于生成的决策树,我们各个叶子节点的最佳负梯度拟合值为

c

t

j

l

=

a

r

g

m

i

n

⏟

c

j

l

∑

i

=

0

m

∑

k

=

1

K

L

(

y

k

,

f

t

−

1

,

l

(

x

)

+

∑

j

=

0

J

c

j

l

I

(

x

i

∈

R

t

j

l

)

)

c_{tjl} = \underbrace{arg\; min}_{c_{jl}}\sum\limits_{i=0}^{m}\sum\limits_{k=1}^{K} L(y_k, f_{t-1, l}(x) + \sum\limits_{j=0}^{J}c_{jl} I(x_i \in R_{tjl}))

ctjl=cjl

argmini=0∑mk=1∑KL(yk,ft−1,l(x)+j=0∑JcjlI(xi∈Rtjl))由于上式比较难优化,我们一般使用近似值代替

c

t

j

l

=

K

−

1

K

∑

x

i

∈

R

t

j

l

r

t

i

l

∑

x

i

∈

R

t

i

l

∣

r

t

i

l

∣

(

1

−

∣

r

t

i

l

∣

)

c_{tjl} = \frac{K-1}{K} \; \frac{\sum\limits_{x_i \in R_{tjl}}r_{til}}{\sum\limits_{x_i \in R_{til}}|r_{til}|(1-|r_{til}|)}

ctjl=KK−1xi∈Rtil∑∣rtil∣(1−∣rtil∣)xi∈Rtjl∑rtil除了负梯度计算和叶子节点的最佳负梯度拟合的线性搜索,多元GBDT分类和二元GBDT分类以及GBDT回归算法过程相同。

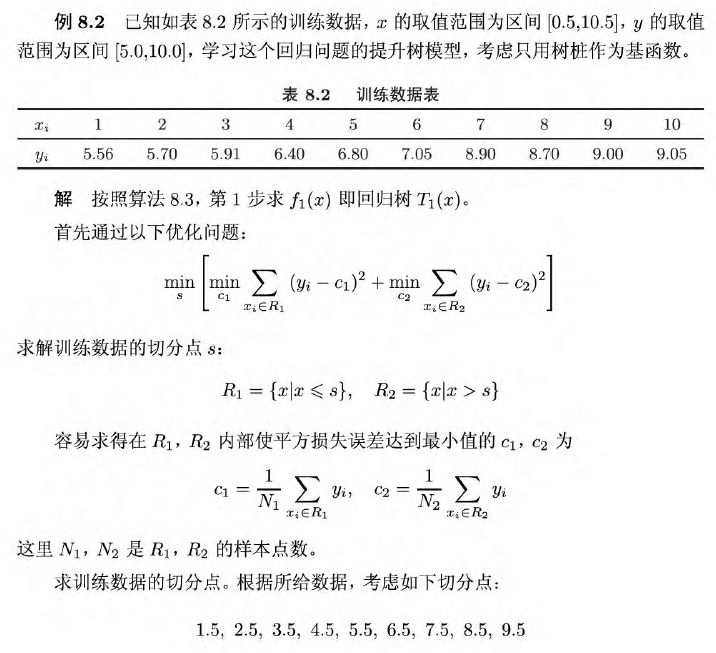

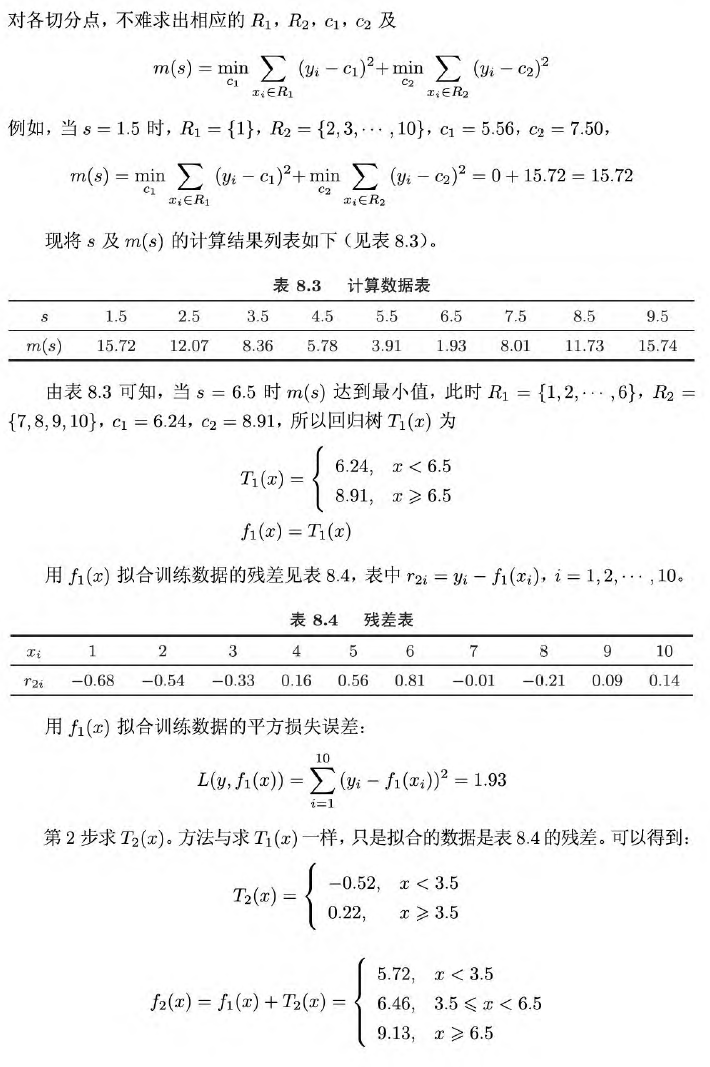

7. 提升树示例

这里放一个提升树的回归示例,梯度提升树与其相似,只不过需要计算负梯度。

参考文章

[1] https://www.cnblogs.com/pinard/p/6140514.html

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?