转自http://blog.csdn.net/u012328159/article/details/51036272

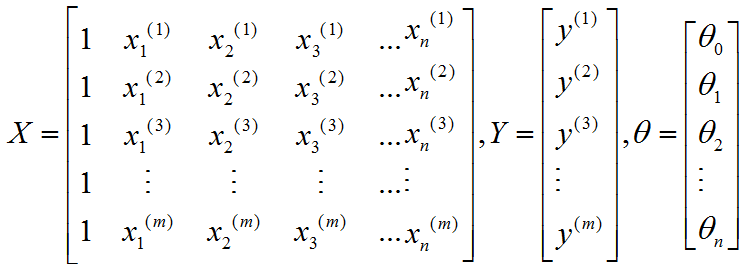

前几篇博客介绍了一些梯度下降的实用技巧,特征缩放(详见http://blog.csdn.net/u012328159/article/details/51030366)和学习率(详见http://blog.csdn.net/u012328159/article/details/51030961)。在线性回归中,为了求得参数θ的最优值,一般采用梯度下降和本文将要介绍的正规方程(normal equation)。相比较梯度下降采用多次迭代逼近的方式,normal equation采用矩阵运算可以直接求解出参数θ。先介绍下什么是normal equation,假设一个数据集X有m个样本,n个特征。则假设函数为: ,数据集X的特征向量表示为:

表示第i个训练样本,

表示第i个训练样本的第j个特征。之所以在X中加了第一列全为1,是为了让

若希望假设函数能够拟合Y,则。又因为

,所以可以通过矩阵运算求出参数θ.

熟悉线性代数的同学应该知道怎么求出参数θ,但是前提是矩阵X存在逆矩阵。但只有方阵才有可能存在逆矩阵(不熟悉定理的同学建议去补补线性代数),因此可以通过左乘

使等式变成

,因此

,有同学可能会有疑问

不一定存在啊,确实是,但是

极少不存在,后面会介绍

不存在的处理方法,先别着急。现在你只需要明白为什么

就可以了,并且记住。

介绍完normal equation求解参数,我们已经知道了两种求解参数的方法,normal equation和梯度下降,现在来对比下这两种方法的优缺点以及什么场景选择什么方法。具体见下表吧:

回到上面说的不一定存在,这种情况是极少存在的。如果

不可逆了,一般要考虑一下两者情况:

(1) 移除冗余特征,一些特征存在线性依赖。

(2) 特征太多时,要删除一些特征。例如(m小于n时),对于小样本数据使用正则化。

正规方程 Normal Equation

最新推荐文章于 2023-05-21 21:21:07 发布

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?