在上节课最终得到了vc-bound

其中growth function有上限关系

引入VC-dimension的概念,作为最大的non-breakpoint。以下写为dvc

则显然在该处应该有最大的N令mH(N)=2^N。即N<=dvc,mH(N)=2^N;k>dvc,mH(k)<2^N。可用的hypothsisi应该有一个有限的dvc

其中k为最小break point。当k存在时,显然右边是收敛的,因此有一个可用的假设集(H)。

由上述式子,为了得到一个足够小的|Ein-Eout|,我们需要一个足够大的N,这样就有一个比较好的数据集。

最后通过一个比较好的算法得出一个足够小的Ein,就有一个比较好的A。通过以上三者,最终可以得到一个小的Eout,从而得到一个泛用型比较好的结果作为g。

以下展示了在PLA算法中,以上几个部分的相互关系以及它们最终如何得到Eout->0的

接下来以percetpron为例子引入自由度的概念。

当前已知1D percetron dvc=2(1D perceptron实际上为pos/neg rays)

2D percetron dvc=3

尝试证明d-D percetron dvc=d+1

首先证明dvc>=d+1

dvc>=d+1,只需要证明在N=d+1的时候,有一组DATA能够被相应的H完全分开(shatter),即被这样的H判定时能够出现所有可能的结果

这时候举出的例子为以下:

由于sign(Xw)=y。由于X((d+1)*(d+1)大小的方阵)显然可逆,那么对于任意的结果y我们只要令w=X^(-1)*y,都可以得到相应的y

因此显然对这样的一组data和使用中的N-D percetpron模型,是可以shatter的,因此dvc>=d+1

接下来证明dvc<=d+1

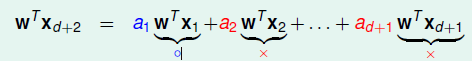

在N=d+2时,由于行比列多,显然这一组data是线性相关的,也就是说

的结果是与其他data的结果是有关系的,也就是当其data的结果确定以后,d+2个data仅能有一种结果,是无法shatter的,因此dvc<=d+1

由以上,对于perceptron模型,dvc=d+1

由此可以引入自由度的概念。模型hypothesis之所以能够shatter并得到一个比较接近0的Ein,是因为我们可以选择参数组w。在实际中,vc-dimension的大小与我们的假设中的参数组的大小是接近的。

另一方面,dvc有点类似于假设集大小M。将前面的M的性质类比一下,我们有

将vc-bound的不等式进行变换,我们可以得到vc-dimension对|Ein-Eout|的影响的数学上关系如下

然后就是一些关于dvc和样本数量的关系,这里不列,仅简单说明。

在理论上N约为10000dvc,实际上N约为10dvc就可以了。

以上能够成立是因为在之前的推理过程中我们使用的多个上界(霍夫丁不等式,growth fucntion,union bound等)都考虑了最坏情况,将不等式中的上界提高了很多。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?