文章目录

计算机视觉最新论文网站:https://paperswithcode.com/sota

1、Python&Pytorch相关知识:

PyTorch之前向传播函数forward

pytorch super 的用法

python中__call__: Callable、forward: Callable[…, Any] 讲解

torch.flatten()方法

【pytorch】named_parameters()和parameters()

nn.init.kaiming_normal_

a = ['a','b','c','d','e','f','g','h','g','k','l','m']

b = a[:] # 列表切片,表示把列表a[]的值全部正序复制到列表b[]中

print(b) # ['a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'g', 'k', 'l', 'm']

# b = a[n:m]表示列表切片,复制列表a[n]到a[m-1]的内容到新的列表对象b[]

# 当n缺省时,默认为0,即a[:m]

# 当m缺省时,默认到最后,即a[n:]

b1 = a[1:4]

print(b1) # ['b', 'c', 'd']

b2 = a[:3]

print(b2) # ['a', 'b', 'c']

b3 = a[1:]

print(b3) # ['b', 'c', 'd', 'e', 'f', 'g', 'h', 'g', 'k', 'l', 'm']

# b = a[i:j:s]这种格式呢,i,j与上面的一样,但s表示步进,缺省为1,s可以取任何数字.

# 所以a[i:j:1]相当于a[i:j]

b4 = a[1:5:2]

print(b4) # ['b', 'd']

b5 = a[:5:-1] # 从末尾倒数取值

print(b5) # ['m', 'l', 'k', 'g', 'h', 'g']

b6 = a[5::-2]

print(b6) # 从a[n]处倒数取值

b7 = a[::-1] # 到这取值

print(b7) # ['m', 'l', 'k', 'g', 'h', 'g', 'f', 'e', 'd', 'c', 'b', 'a']

slice函数使用

import numpy as np

m = np.zeros((3, 3)).astype('int64')

m[slice(-1, None),:]=1

print(m)

‘’‘输出

[[0 0 0]

[0 0 0]

[1 1 1]]

‘’‘

import numpy as np

m = np.zeros((3, 3)).astype('int64')

m[slice(0, -1),slice(0,-1)]=1

print(m)

‘’‘输出

[[1 1 0]

[1 1 0]

[0 0 0]]

‘’‘

torch.view()改变矩阵size

import torch

# torch.ones()生成全为1矩阵

# torch.zeros()生成零矩阵

a = torch.arange(6).view(2, 3) #创建随机矩阵

print(a)

b = a.view(-1, 2) # 当某一维是-1时,会自动计算它的大小

print(b)

’‘’输出:

tensor([[0, 1, 2],

[3, 4, 5]])

tensor([[0, 1],

[2, 3],

[4, 5]])

‘’‘

查看tensor所有数据,不带省略号

torch.set_printoptions(profile="full")

numpy.set_printoptions(threshold=np.inf)

带f的python的表达式

return_layers = {f'layer{k}': str(v) for v, k in enumerate(returned_layers)}

#以f开头表示在字符串内支持大括号内的python 表达式

named_children( )、named_modules( )

named_children( )、named_modules( )

name for name, _ in model.named_children()

# 查找model.named_children()中的name赋值给前面的name

item、OrderedDict、学习率优化器

python面向对象–item方法

OrderedDict in Python

降低学习率torch.optim.lr_scheduler.ReduceLROnPlateau类参数讲解

2、DL相关基础知识

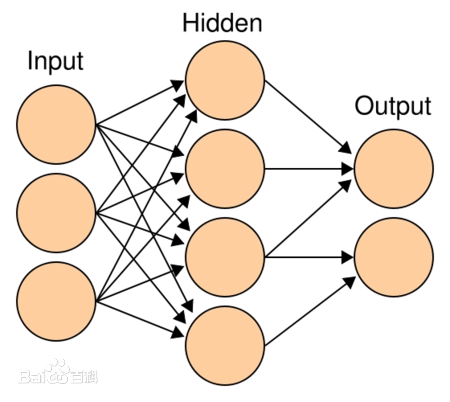

网络分类:CNN(卷积神经网络)、RNN(循环神经网络)、Transformer

一文搞懂RNN循环神经网络

Vision Transformer 超详细解读 (原理分析+代码解读) (一)

卷积神经网络(CNN):卷积层(Convolution)、非线性激活层(ReLU)、池化层(pooling)

cnn卷积神经网络应用(卷积神经网络和神经网络)

机器学习评价指标

nn.BCELoss()、nn.BCEWithLogitsLoss()的理解与用法

池化层的反向传播

反向传播

正则化:为了避免过拟合

使得w权重参数不过大,维持

双边误差校验偏导数,如果误差在10的-3次方~10的-5次方,就可能存在Bug

优化器算法Optimizer详解(BGD、SGD、MBGD、Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam)

PyTorch------nn.ReLU(inplace = True)详解

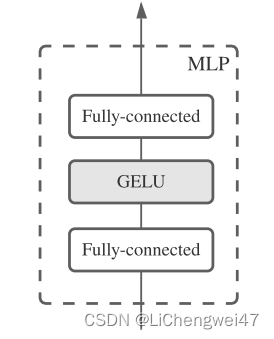

MLP多层感知器

conv2d函数的原理、计算过程

CNN 模型所需的计算力flops是什么?怎么计算?

3、经典论文阅读:

fcn相关

fcn论文及代码解析

convtranspose2d

resnet相关:

pytorch官方实现的resnet

知乎手敲的resnet

resnet官方代码讲解1

resnet官方代码讲解2

resnet官方代码讲解3

RCNN系列:

边框回归(Bounding Box Regression)详解

How does the bounding box regressor work in Fast R-CNN?

github上的复现

知乎Faster-RCNN讲解1

知乎Faster-RCNN讲解2

HRNet:

github源码解析

Vision Transformer:

论文全称:An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

Vision Transformer 超详细解读 (原理分析+代码解读) (一)

DaViT:双注意力Vision Transformer

https://zhuanlan.zhihu.com/p/500202422

Swin transformer

CV+Transformer之Swin Transformer 源码解读

Swin Transformer Attention机制的详细推导

Swin-Transformer网络结构详解

bilibili——使用pytorch搭建Swin-Transformer

bilibili——swin-transformer:相对位置编码的原理和代码

4、MMSegmentation做分割

MMSegmentation训练自己的分割数据集

MMSegmentation官方文档

【语义分割】用mmsegmentation训练自己的分割数据集

MMsegmentation教程1:学习配置文件

5、半监督目标检测

6、MMdetection讲解、COCO数据集制作

MMdetection-教程5:自定义运行设置

【mmdetection实践】(四)datasets和model的构建过程

COCO数据集制作过程

7、其他:

linux 终端命令关闭 pycharm

MMsegmentation语义分割开发文档

timm语义分割开发文档

c++部署相关:

Ubuntu下C++调用pytorch训练好模型–利用libtorch

C++(libTorch)调用pytroch预训练模型

使用libtorch读取预训练权重,完成语义分割

LibTorch & Win] 各版本 LibTorch 下载

C++部署Pytorch(Libtorch)出现问题、错误汇总

局部最优解示意图:

resnet图解【忘记转自哪篇博客了~_^】:

3518

3518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?