教程是本人学习吴恩达老师DeepLearing系列课程中整理的最为详细的学习笔记。学习视频主要来自B站[双语字幕]吴恩达深度学习deeplearning.ai_哔哩哔哩_bilibili?,以及DeepLearning官方网站Deep Learning by deeplearning.ai | Coursera。该系列课程总共有180多个,我会将学习笔记陆续分享出来,为有兴趣深度学习的同仁提供便利。再次由衷感谢吴恩达老师的精彩讲解和无私奉献!

特别说明:图片来源于吴恩达老师视频截图。

在上一个视频中,你看到的是logistic回归的模型。为了训练logistic回归模型的参数w以及b,需要定义一个成本函数。我们来看一下,用logistic回归来训练的成本函数。

回忆一下,这![]() 是上一张幻灯片的函数,所以你的输出

是上一张幻灯片的函数,所以你的输出 ![]() ,这里定义为sigmoid(z)。为了让模型通过学习来调整参数,要给一个含有m个样本的训练集

,这里定义为sigmoid(z)。为了让模型通过学习来调整参数,要给一个含有m个样本的训练集![]() ,很自然的,你想通过在训练集找到参数w和b来得到你的输出,对训练集中的预测值,将它写成

,很自然的,你想通过在训练集找到参数w和b来得到你的输出,对训练集中的预测值,将它写成![]() ,我们希望它会接近于在训练集中的

,我们希望它会接近于在训练集中的![]() 值。为了让上面的方程更详细一些,需要说明上面这里定义的

值。为了让上面的方程更详细一些,需要说明上面这里定义的![]() 是对一个训练样本x来说的,对于每个训练样本使用这些带有圆括号的上标方便引用说明以及区分样本。你的训练样本(i)对应的预测值是

是对一个训练样本x来说的,对于每个训练样本使用这些带有圆括号的上标方便引用说明以及区分样本。你的训练样本(i)对应的预测值是![]() ,是用训练样本通过sigmoid函数作用到

,是用训练样本通过sigmoid函数作用到![]() 得到的

得到的![]() 。你也可以将

。你也可以将![]() 定义成这样

定义成这样![]()

![]() 。在这门课里,我们将使用这个符号约定,就是这个上标

。在这门课里,我们将使用这个符号约定,就是这个上标![]() 来指明数据样本

来指明数据样本 ,表示x或者y或者y和第i个训练样本有关,这就是上标

,表示x或者y或者y和第i个训练样本有关,这就是上标 ![]() 的含义。

的含义。

现在我们来看看损失函数或者叫误差函数,它们可以用来衡量算法的运行情况。你可以定义损失为![]()

![]() 和y的差的平方,或者它们差的平方的

和y的差的平方,或者它们差的平方的![]()

![]() 。结果表明你可以这样做,但通常在logistic回归中,大家都不这么做。因为当你学习这些参数的时候,你会发现之后讨论的优化问题,会变成非凸的

。结果表明你可以这样做,但通常在logistic回归中,大家都不这么做。因为当你学习这些参数的时候,你会发现之后讨论的优化问题,会变成非凸的 ,最后会得到很多个局部最优解。梯度下降法,可能找不到全局最优值,如果你不理解这几句话,别担心,我们会在后面的视频中讲到它。这个的直观理解就是我们通过定义这个损失函数L

,最后会得到很多个局部最优解。梯度下降法,可能找不到全局最优值,如果你不理解这几句话,别担心,我们会在后面的视频中讲到它。这个的直观理解就是我们通过定义这个损失函数L 来衡量你的预测值

来衡量你的预测值![]() 和y的实际值有多接近。误差平方

和y的实际值有多接近。误差平方![]() ,看起来似乎是一个合理的选择,但用这个的话,梯度下降法就不太好用。在逻辑回归中,我们会定义一个不同的损失函数,它起着与误差平方相似的作用,这些会给我们一个凸的优化问题

,看起来似乎是一个合理的选择,但用这个的话,梯度下降法就不太好用。在逻辑回归中,我们会定义一个不同的损失函数,它起着与误差平方相似的作用,这些会给我们一个凸的优化问题 ,在后面的视频中我们会看到它很容易去做优化。

,在后面的视频中我们会看到它很容易去做优化。

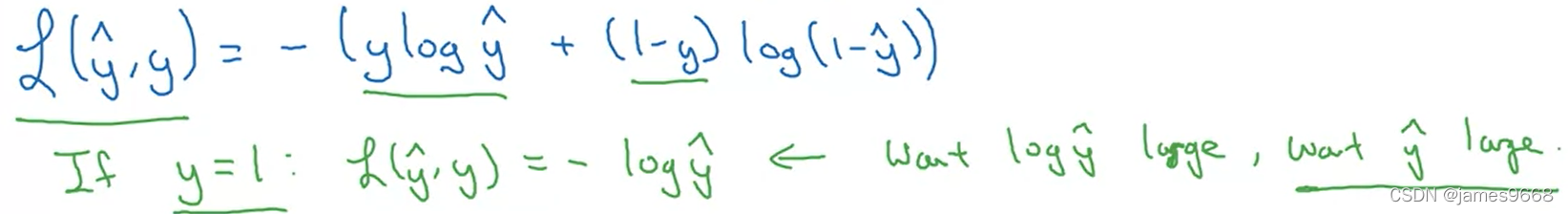

在逻辑回归中,我们用的会是这里写的损失函数![]()

。直观地看看为何这个损失函数能起作用?记得如果我们使用误差平方

。直观地看看为何这个损失函数能起作用?记得如果我们使用误差平方 越小越好,对于这个logistic回归的损失函数

越小越好,对于这个logistic回归的损失函数 ,同样的我们也想让它尽可能地小。为了更好理解为什么它能够起作用,让我们来看两个例子。

,同样的我们也想让它尽可能地小。为了更好理解为什么它能够起作用,让我们来看两个例子。

第一个例子,我们说y=1时, 第二项为

第二项为![]() 为0, 所以损失函数就只有第一项了,就是

为0, 所以损失函数就只有第一项了,就是![]() ,这第一项

,这第一项 带个负号,你想让

带个负号,你想让![]() 尽可能小,这意味着想让

尽可能小,这意味着想让![]() 够大,尽可能的大,这就意味着你想要

够大,尽可能的大,这就意味着你想要![]() 够大,但是因为

够大,但是因为 ![]() 是sigmoid函数得出的,永远不会比1大,所以(当y=1时),你要让

是sigmoid函数得出的,永远不会比1大,所以(当y=1时),你要让![]() 尽可能接近1。另一种情况就是如果y=0,

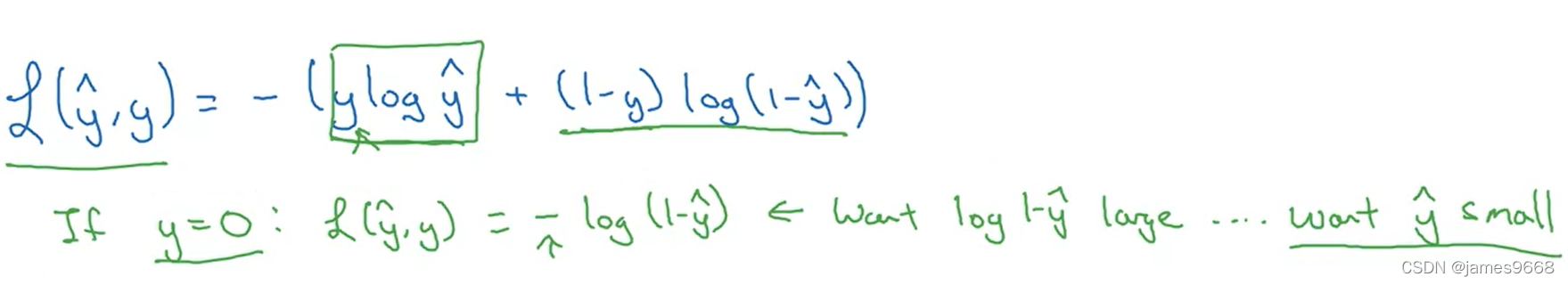

尽可能接近1。另一种情况就是如果y=0, 损失函数的第一项为0,然后第二项就是这个损失函数,此时损失函数变为

损失函数的第一项为0,然后第二项就是这个损失函数,此时损失函数变为![]() ,在学习过程中,想让损失函数小一些,也就意味着你想让

,在学习过程中,想让损失函数小一些,也就意味着你想让![]() 够大,也就是损失函数要让

够大,也就是损失函数要让![]() 尽可能小,因为这里

尽可能小,因为这里 有个负号,通过这一系列推理你可以得出损失函数需要让

有个负号,通过这一系列推理你可以得出损失函数需要让![]() 尽可能小,再次因为

尽可能小,再次因为![]() 只能介于0到1之间,这就是说,当y=0时,损失函数会让

只能介于0到1之间,这就是说,当y=0时,损失函数会让 ![]() 尽可能地接近0。有很多函数都能达到这个效果:如果y=1,我们尽可能让

尽可能地接近0。有很多函数都能达到这个效果:如果y=1,我们尽可能让 ![]() 很大;如果y=0,尽可能让

很大;如果y=0,尽可能让![]() 足够小。绿色字体这里

足够小。绿色字体这里 稍微解释了为什么用这个作为损失函数,后面我们会提供选修视频给出更正式的这样做的原因,解释为什么在logistic回归中,要用这个形式的损失函数。

稍微解释了为什么用这个作为损失函数,后面我们会提供选修视频给出更正式的这样做的原因,解释为什么在logistic回归中,要用这个形式的损失函数。

最后说一下,损失函数是在单个训练样本中定义的,它衡量了在单个训练样本上的表现。下面我们要定义一个成本函数(Cost function),它衡量的是在全体训练样本上的表现。这个成本函数J![]() 根据之前得到的两个参数w和b,

根据之前得到的两个参数w和b,

,即所有训练样本的损失函数和的平均值。而

,即所有训练样本的损失函数和的平均值。而![]() 是一组特定的参数w和b通过logistic回归算法得出的预测输出值。所以把这个展开得到:

是一组特定的参数w和b通过logistic回归算法得出的预测输出值。所以把这个展开得到: ![]()

![]() 。

。

术语这样来用,损失函数只适用于单个训练样本;而这个成本函数是基于参数的所有样本的总成本。所以在训练logistic回归模型时,我们要找到合适的参数w和b,让这里的成本函数J尽可能地小。

你刚刚看到了logistic回归算法的过程,以及训练样本的损失函数,还有和参数相关的总体成本函数。结果表明logistic回归可以被看作是一个非常小的神经网络。在下一个视频中,我们将会学到直观地去理解神经网络能做什么。继续看下一段视频,看看如何将logistic回归视为一个非常小的神经网络。

1245

1245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?