目标:

实现图像中多个物体的分割,多个物体的标注方式为0,1,2,3,,,,,0表示背景,1表示一种物体,2表示另一种物体,假设我们现在的分割任务里面有5个目标需要,如肺叶分割,5个肺叶的标注方式为:0表示背景,1表示右上叶,2表示右中叶,3表示右下叶,4表示左上页,5表示左下叶。

前提:

首先我们拿到的标注应该是单通道的,如大小为96*96*64*1,但在网络模型设计中输出通道数应该是分割类别数,即网络模型最后的输出大小为96*96*64*6(这里最后一维6指背景+5个目标),这样在训练的时候网络输出和标注之间大小不匹配,不能进行损失值计算,所以需要将原来单通道的标注图像变成6个通道,这就需要用到One-hot编码,在每个通道上(即将每一类进行二值化)。

正文:

One-hot编码:

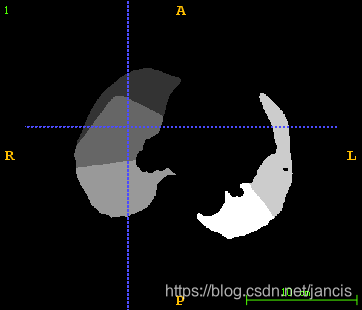

以上是肺叶的标注图像,可以看到背景像素值是0,其余叶标注值分别为1,2,3,4,5,以矩阵表示大概为(二维图像举例,并不是这个图的真正矩阵):

[00000000 01211110 01222330 01123340 01223440 01233550 02234450 02334550]

经过One-hot编码后变成6个通道:

[11111111 10000001 10000001 10000001 10000001 10000001 10000001 10000001]

[00000000 01011110 01000000 01100000 01000000 01000000 00000000 00000000]

[00000000 00100000 00111000 00010000 00110000 00100000 01100000 010000

本文探讨了医学影像中多个目标的分割方法,详细解释了如何使用One-hot编码将单通道标注转换为多通道形式,以便于网络模型训练。同时,介绍了多label分割的Dice损失函数计算及预测结果的可视化过程。

本文探讨了医学影像中多个目标的分割方法,详细解释了如何使用One-hot编码将单通道标注转换为多通道形式,以便于网络模型训练。同时,介绍了多label分割的Dice损失函数计算及预测结果的可视化过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

236

236

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?