梯度下降法描述

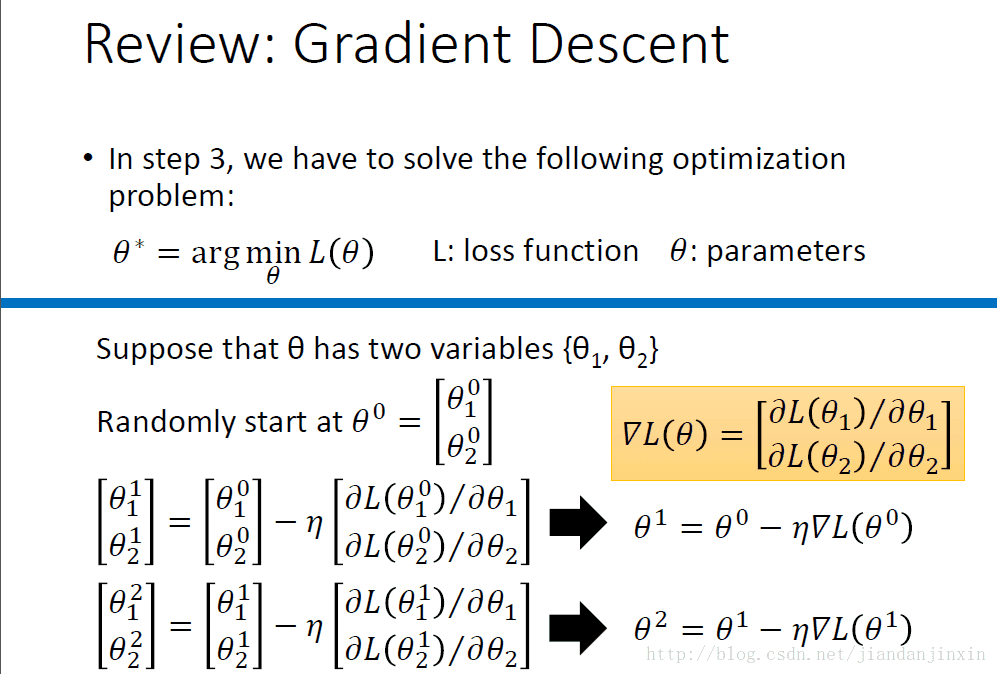

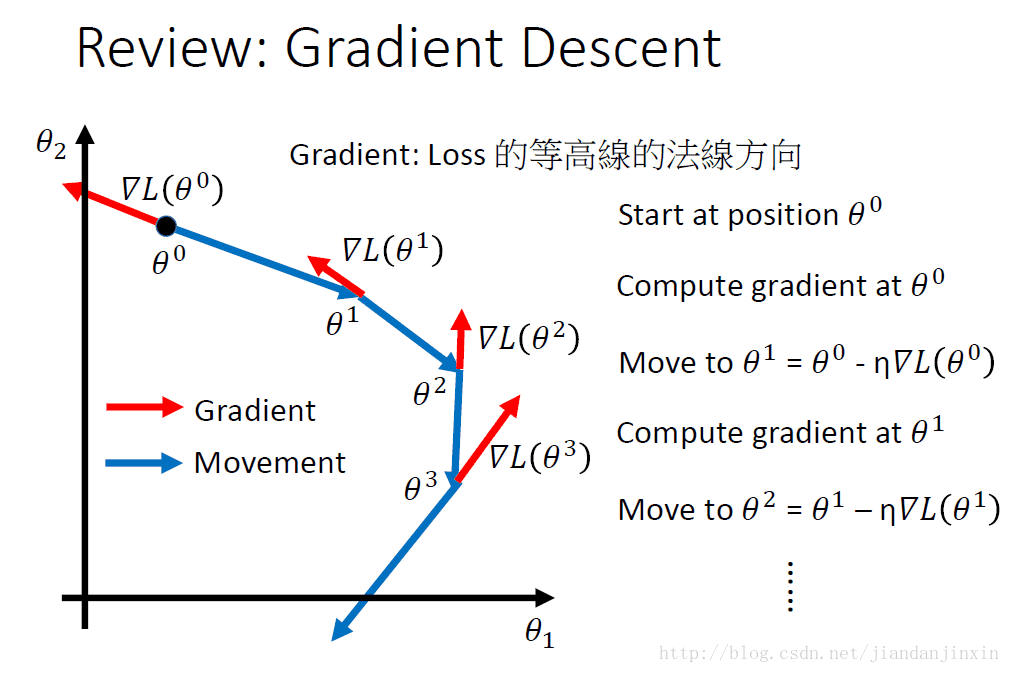

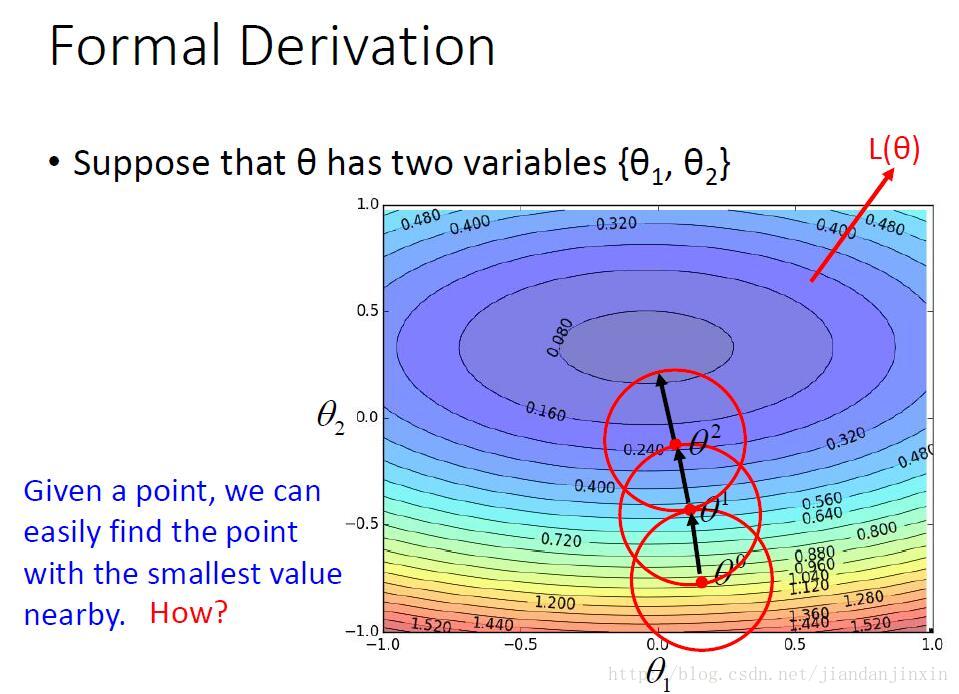

梯度下降法是为了找到最优的目标函数,寻找的过程就是沿着损失函数下降的方向来确定参数变化的方向。参数更新的过程就是一个不断迭代的过程,每次更新参数学到的函数都会使得误差损失越来越小,也就是说学习到的参数函数越来越逼近最优函数。

参数的更新是按照损失函数的等高线的方向进行的。

梯度下降是一阶导数,梯度下降是用平面来逼近局部。

牛顿法是二阶导数,牛顿法是用曲面逼近局部。

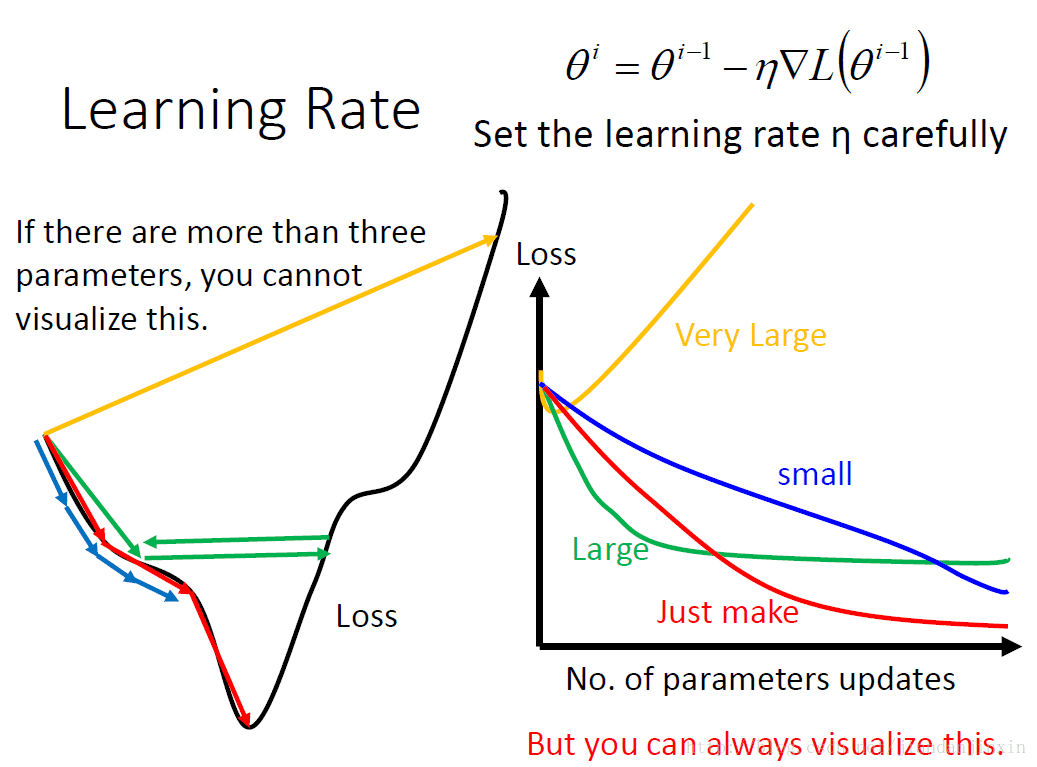

梯度下降法调整学习速率

可视化:参数更新的变化与损失的变化情况。蓝色线表示的是学习率太小,导致损失下降太慢。绿色线表示的是学习速率变大,损失很快就变小,但是后面有卡住了,损失不在变化。黄色线表示的是学习速率太大,直接导致损失爆炸。红色的线是理想的学习速率。

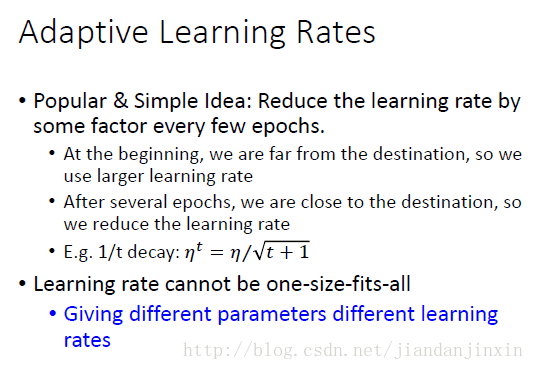

一般情况,在刚开始的时候,可以设置比较大的学习速率,这样可以快速接近最优的函数。经过几epochs后,我们会接近最优的函数,这时可以降低学习速率,来确定最终的参数。

不同的参数不同的学习速率。

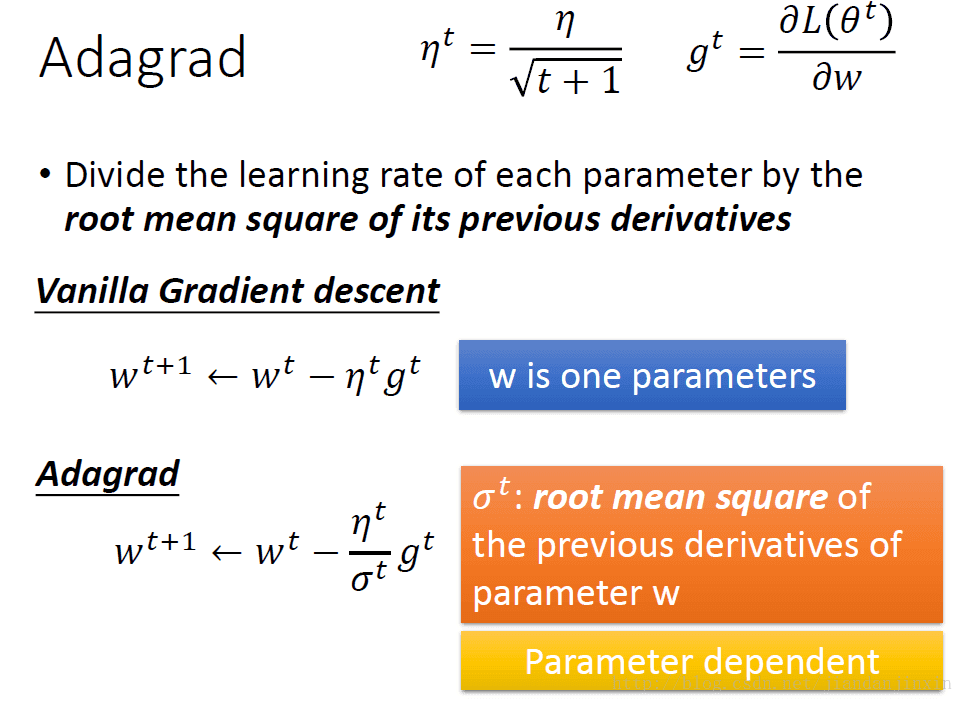

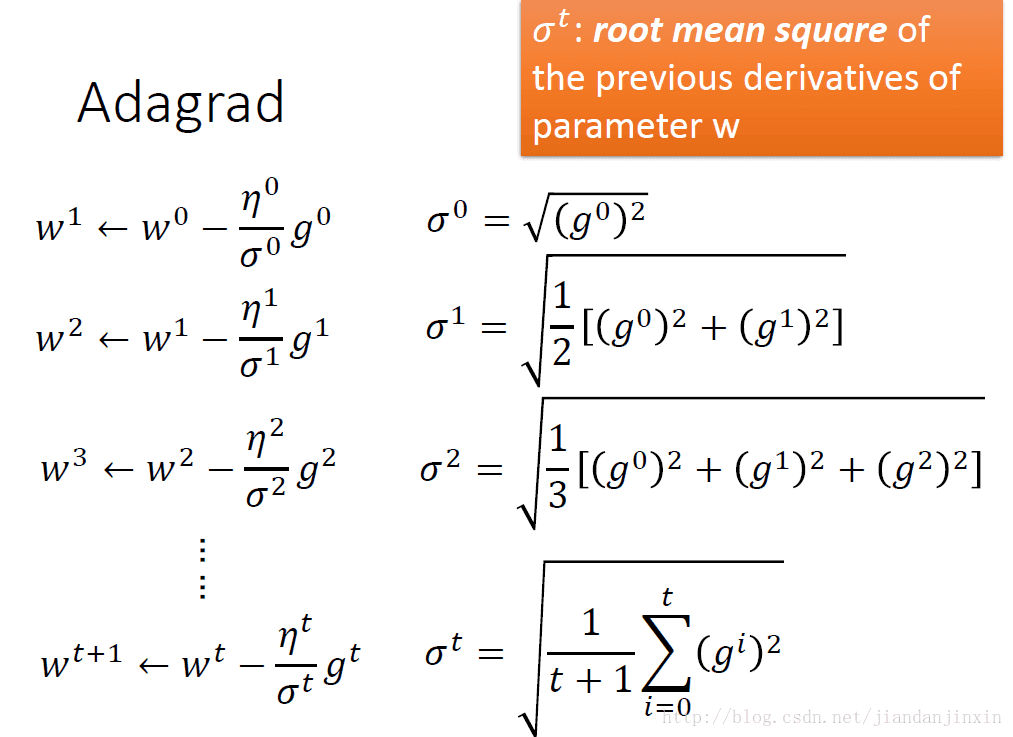

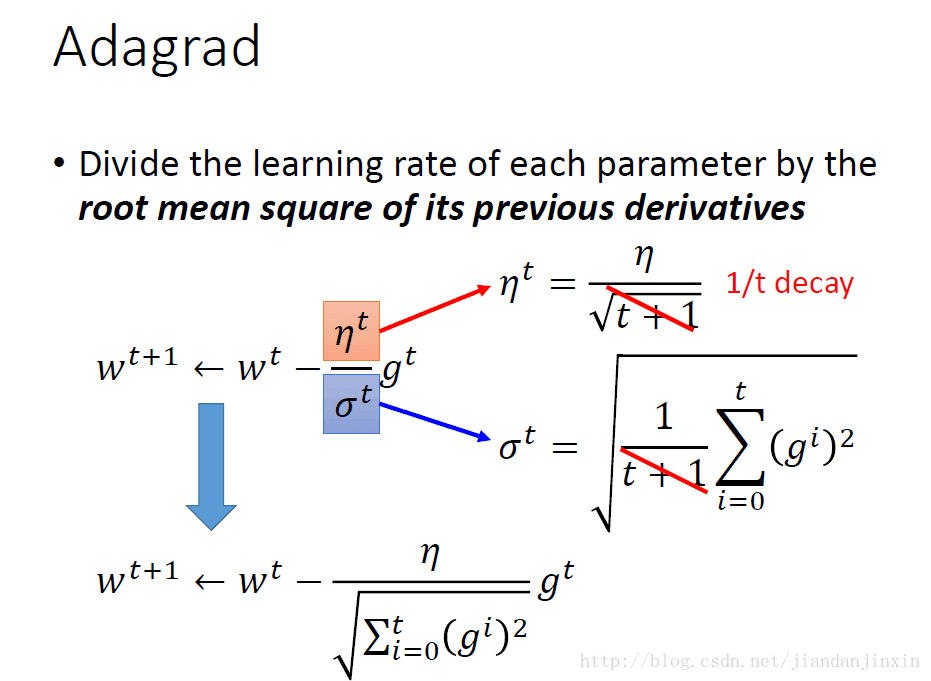

梯度下降法Adagrad调整学习速率

本文详细探讨了梯度下降法在寻找最优目标函数中的应用,包括参数更新过程、学习率的调整策略,如Adagrad、RMSProp和Momentum。通过可视化展示了不同学习率对损失函数的影响,强调了正确调整学习率的重要性,同时讨论了局部极值、鞍点问题及其在深度学习中的挑战。

本文详细探讨了梯度下降法在寻找最优目标函数中的应用,包括参数更新过程、学习率的调整策略,如Adagrad、RMSProp和Momentum。通过可视化展示了不同学习率对损失函数的影响,强调了正确调整学习率的重要性,同时讨论了局部极值、鞍点问题及其在深度学习中的挑战。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

7494

7494

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?