文章目录

安装PyCharm,配置好python开发环境

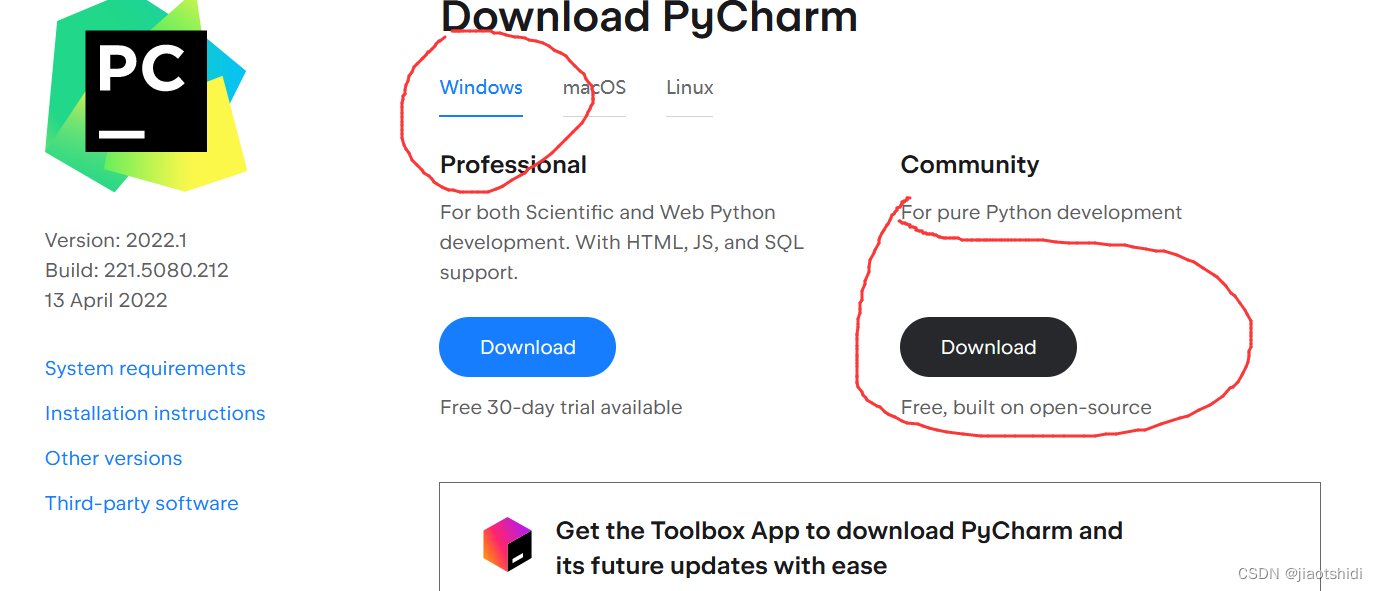

PyCharm下载 进入之后选择社区版下载。

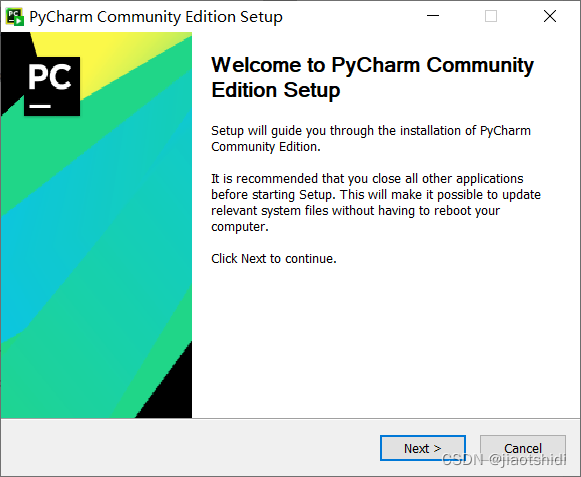

进入安装界面

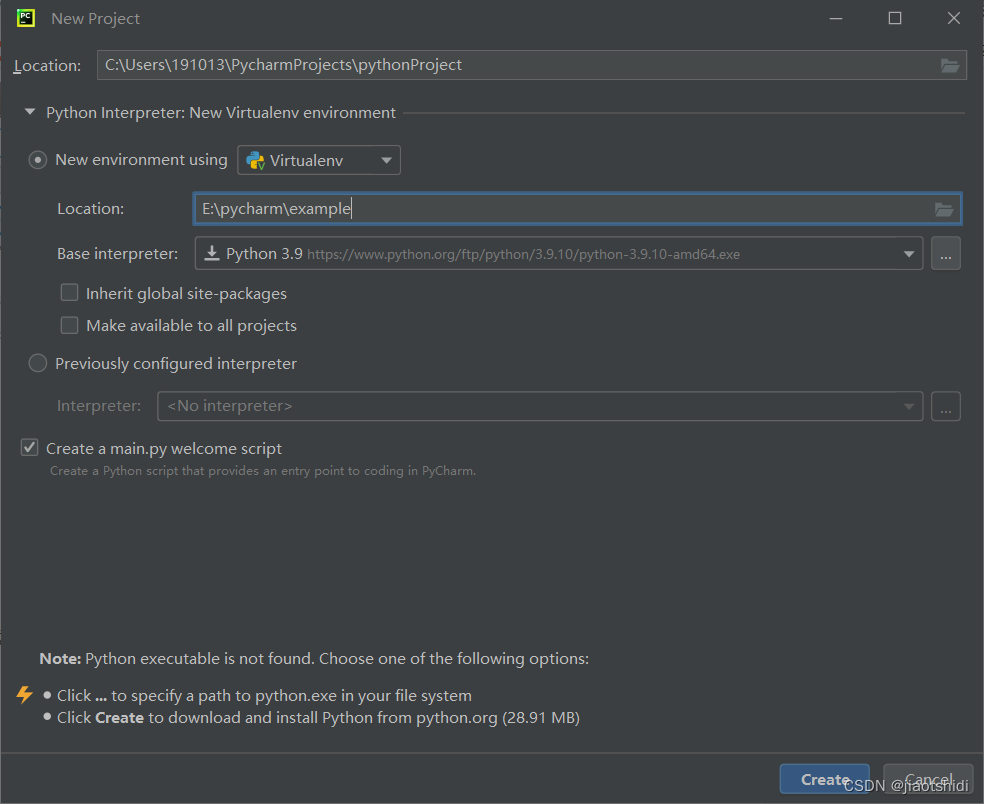

选择安装路径,尽量不要下载c盘

创建快捷方式,更新环境变量都勾选上

之后就等待安装就行了。

如果之前没有下载有Python解释器的话,可以趁安装的间隙去下载一个。不确定自己有没有安装过python的同学,可以打开cmd,输入一下python,如果显示版本,就表示你已经安装过了。

可以尝试运行一下

可以尝试运行一下

安装Pytorch

安装过程主要参考了这篇文章

Pytorch安装流程

安装pytorch文章中多次提到根据自己计算机能力来安装相对应的版本,这里提供了cuda版本获得,和计算机能力对应版本匹配的博客

如何查看windows的CUDA版本

pytorch版本对计算能力的要求

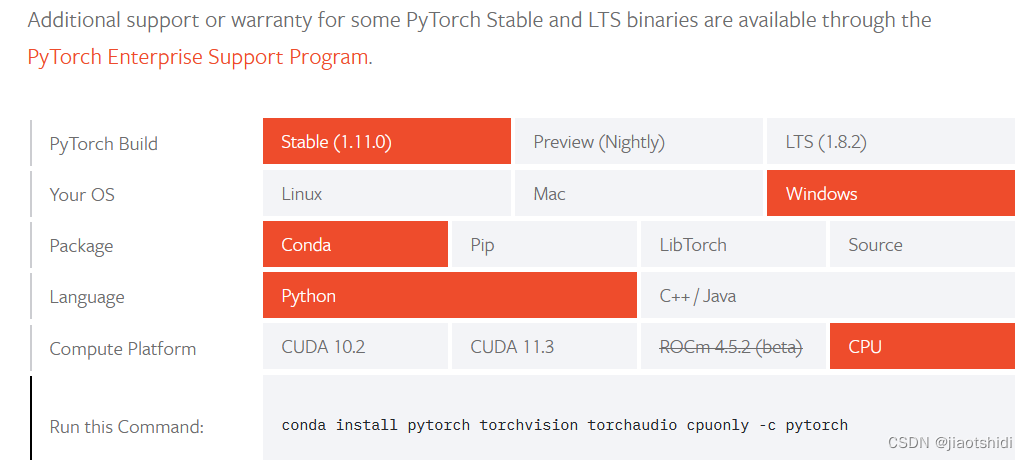

实际上我还是选择下载了cpu版本。大家可以根据要求自取

另外官网的下载包中有的镜像不能下载,如果后续下载麻烦的话,可以直接选择更换资源镜像源。通过这个可以配置清华的镜像源,下载速度也是非常的快。

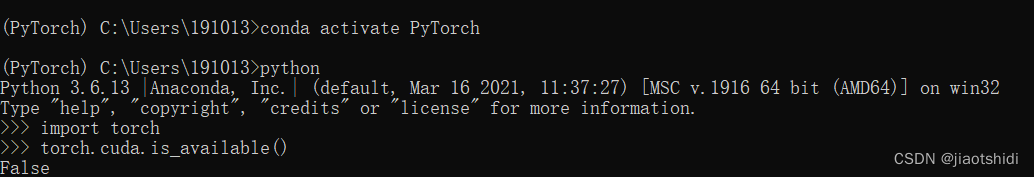

检验自己有没有下载完成的方法,就是可以多执行几次

检验自己有没有下载完成的方法,就是可以多执行几次

conda install pytorch torchvision torchaudio cpuonly -c pytorch

选择的版本不同,执行的命令也不同。不在显示有下载的东西的话就没有问题了

因为选择的是cpu,所以torch.cuda.is_availble的返回值永远是fasle,还因为这个纠结了一下午,尝试了很多网上的方法,最后才明白原因

使用Pytorch实现反向传播

实现原理

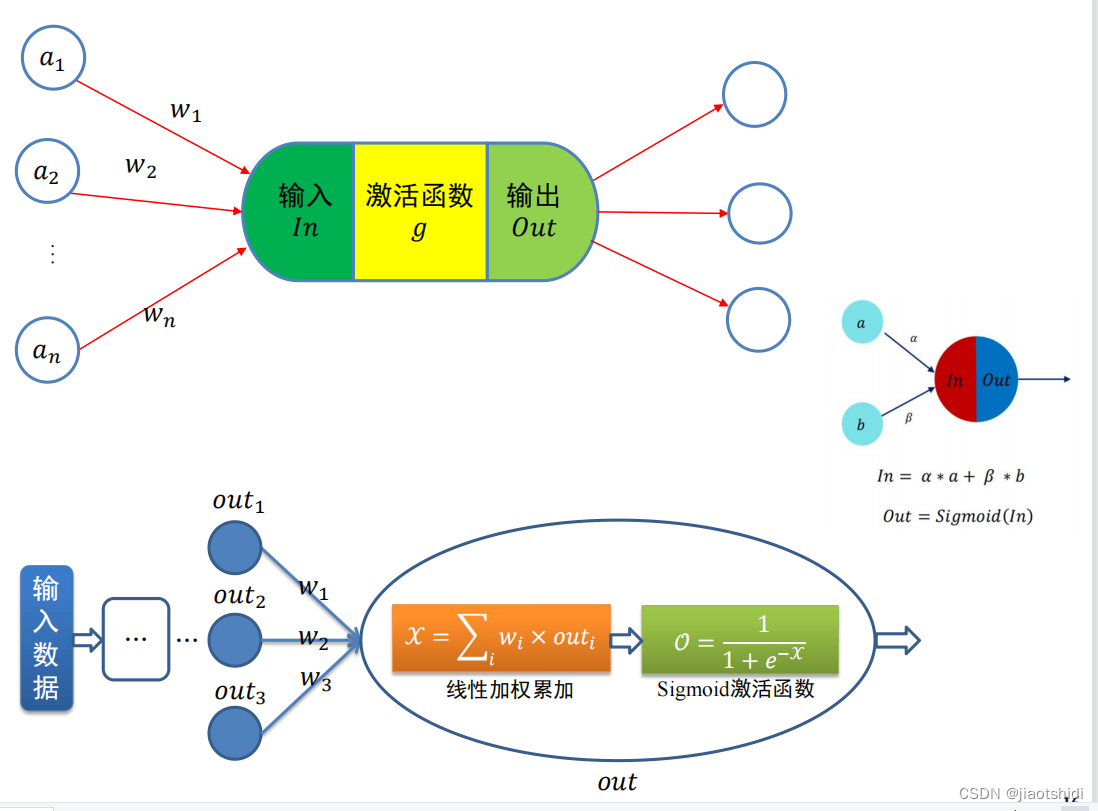

基本原理图

输入层过隐藏层到达输出层,中间通过激活函数引入非线性,强化学习能力

输入层过隐藏层到达输出层,中间通过激活函数引入非线性,强化学习能力

激活函数

为什么需要激活函数: 数据分布绝大多数是非线性的, 一般神经网络的计算是线性的, 引入激活函数,在神经网络中引入非线性,强化网络的学习能力。

这里采用的sigmod函数作为激活函数,

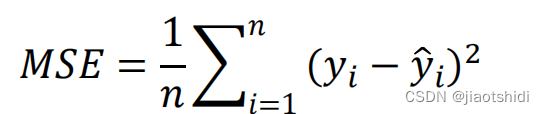

损失函数

计算模型预测值与真实值之间的误差,是我们计算误差,进而优化参数的根据。

常用损失函数有:

均方误差损失函数

在这里使用的是均方误差损失函数

还有交叉熵损失函数

还有最重要的为什么反向传播可以实现损失函数的不断下降

代码实现

import torch

import matplotlib.pyplot as plt

x_data = [1.0,2.0,3.0]

y_data = [2.0,4.0,6.0]

w = torch.Tensor([3.0]) #初始化权重

w.requires_grad = True #说明w需要计算梯度

# 注意其中w是tensor,在实际运算中开始进行数乘。

def forward(x):

return w*x

# 损失函数的求解,构建计算图,并不是乘法或者乘方运算

def loss(x,y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("Predict before training",4,forward(4).item()) ## 打印学习之前的值,.item表示输出张量的值

learning_rate = 0.01

epoch_list = []

loss_list =[]

#训练

for epoch in range(100):

for x,y in zip(x_data,y_data):

l=loss(x,y)

l.backward() #向后传播

print('\tgrad',x,y,w.grad.item()) # 将梯度存到w之中,随后释放计算图,w.grad.item():取出数值

w.data = w.data - learning_rate*w.grad.data # 张量中的grad也是张量,所以取张量中的data,不去建立计算图

w.grad.data.zero_() # 释放data

print("process:",epoch,l.item())

epoch_list.append(epoch)

loss_list.append(l.item())

print('Predict after training', 4, forward(4).item())

#绘制可视化

plt.plot(epoch_list,loss_list)

plt.xlabel("epoch")

plt.ylabel("Loss")

plt.show()

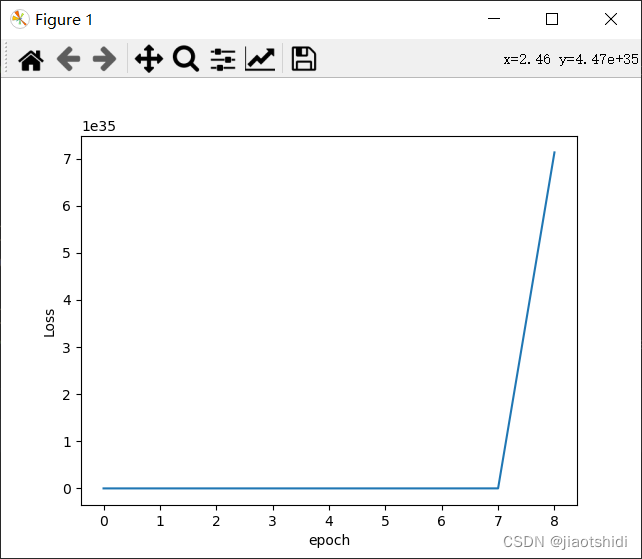

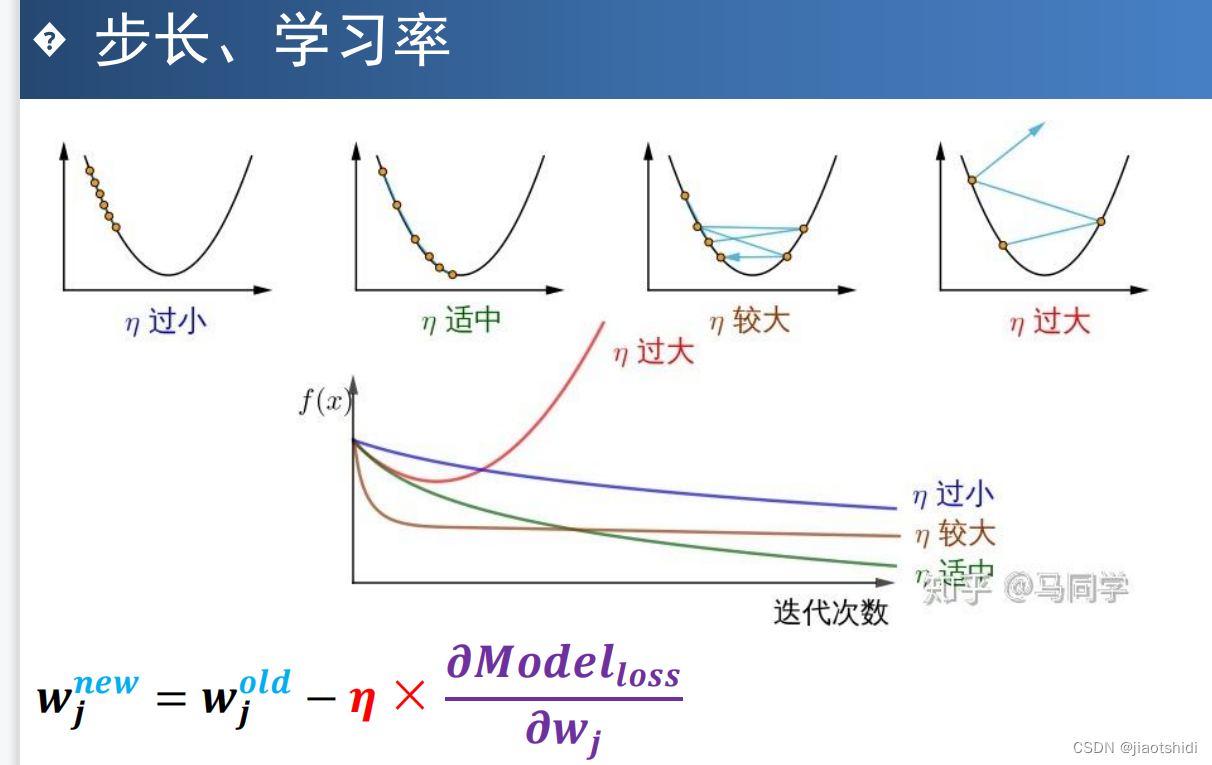

这里是学习效率是0.01的时候进行100次反向传播的过程

当学习效率是0.05的时候

当效率是1的时候

这里可以看到学习率对误差的反向传递影响是挺大的,显然当学习率是1的时候已经过大了。

当然,不同的x_data和y_data在相同的学习率之下一般会呈现不同的结果。

参考

PyCharm下载

Pytorch安装流程

如何查看windows的CUDA版本

pytorch版本对计算能力的要求

损失函数、梯度下降法与反向传播算法

Pytorch深度学习(三):反向传播

另外还参考引用了魏勇刚老师的课件,不再这里展示。

2746

2746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?