研究问题

论文从第一性原理出发推导了GNN和SCM之间的理论联系,并基于GNN定义了一种新的神经因果模型类

背景知识

- 变分推断

假设X为观察到的变量,Z为隐藏变量,变分推断的目标即后验分布p(Z|X)。首先需要提出一族关于隐藏变量的近似概率分布Q,从这一族分布中找到一个与真实的后验分布的KL Divergence最小的分布,即

q ∗ ( Z ) = arg min q ∈ Q K L ( q ( Z ) ∥ p ( Z ∣ X ) ) q^{*}(Z)=\arg \min _{q \in \mathcal{Q}} \mathrm{KL}(q(\mathbf{Z}) \| p(\mathbf{Z} \mid \mathbf{X})) q∗(Z)=argminq∈QKL(q(Z)∥p(Z∣X))

根据贝叶斯准则, p ( Z ∣ X ) = p ( X , Z ) p ( X ) p(\mathbf{Z}|\mathbf{X}) = \frac{p(\mathbf{X}, \mathbf{Z})}{p(\mathbf{X})} p(Z∣X)=p(X)p(X,Z),边缘化隐藏变量后可得 p ( X ) = ∫ p ( X , Z ) d Z p(\mathbf{X})=\int p(\mathbf{X}, \mathbf{Z}) d \mathbf{Z} p(X)=∫p(X,Z)dZ

上式满足如下关系,等式右边即为ELBO(第一项是个期望项,它促使模型将它的隐藏变量集中于可以解释观察量的配置上,第二项是隐藏变量变分分布与先验分布的KL divergence的相反数,它促使变分分布接近于先验分布,所以变分模型的目标函数是似然率与先验分布的一种平衡):

log p ( X ) − KL ( q ( Z ) ∥ p ( Z ∣ X ) ) = E q [ log p ( X ∣ Z ) ] − KL ( q ( Z ) ∥ p ( Z ) ) \begin{array}{r}\log p(\mathbf{X})-\operatorname{KL}(q(\mathbf{Z}) \| p(\mathbf{Z} \mid \mathbf{X}))= \mathbb{E}_{q}[\log p(\mathbf{X} \mid \mathbf{Z})]-\operatorname{KL}(q(\mathbf{Z}) \| p(\mathbf{Z}))\end{array} logp(X)−KL(q(Z)∥p(Z∣X))=Eq[logp(X∣Z)]−KL(q(Z)∥p(Z))

使用变分自编码器模型参数化 p ϕ ( X ∣ Z ) p_{\boldsymbol{\phi}}(\mathbf{X}\mid \mathbf{Z}) pϕ(X∣Z)和 q ( Z ) : = q θ ( Z ∣ X ) q(\mathbf{Z}):=q_{\boldsymbol{\theta}}(\mathbf{Z} \mid \mathbf{X}) q(Z):=qθ(Z∣X)

通过使用重要采样的技巧,可得 p ( X ) ≈ 1 n ∑ i = 1 n p ϕ ( X ∣ z i ) p ( z i ) q θ ( z i ∣ X ) p(\mathbf{X}) \approx \frac{1}{n} \sum_{i=1}^{n} \frac{p_{\boldsymbol{\phi}}\left(\mathbf{X} \mid \mathbf{z}_{i}\right) p\left(\mathbf{z}_{i}\right)}{q_{\boldsymbol{\theta}}\left(\mathbf{z}_{i} \mid \mathbf{X}\right)} p(X)≈n1∑i=1nqθ(zi∣X)pϕ(X∣zi)p(zi)

- 图神经网络

一个GNN层将 f ( D , A G ) f\left(\mathbf{D}, \mathbf{A}_{G}\right) f(D,AG)将变量 { d i } i = 1 n D ∈ R d × n \left\{\mathbf{d}_{i}\right\}_{i=1}^{n} \mathbf{D} \in R^{d \times n} {di}i=1nD∈Rd×n和邻接矩阵 A G ∈ [ 0 , 1 ] d × d \mathbf{A}_{G} \in[0,1]^{d \times d} AG∈[0,1]d×d作为输入,其更新图表示的过程可以定义为 h i = ϕ ( d i , ⨁ j ∈ N i G ψ ( d i , d j ) ) \mathbf{h}_{i}=\phi\left(\mathbf{d}_{i}, \bigoplus_{j \in \mathcal{N}_{i}^{G}} \psi\left(\mathbf{d}_{i}, \mathbf{d}_{j}\right)\right) hi=ϕ(di,⨁j∈NiGψ(di,dj))

- 因果推断

一个结构因果模型SCM可以定义为 C : = ( S , P ( U ) ) \mathfrak{C}:=(\mathbf{S}, P(\mathbf{U})) C:=(S,P(U)),其中 P ( U ) P(\mathbf{U}) P(U)是外生未建模变量的乘积分布,S定义为d组结构方程的集合,结构方程表示如下,

V i : = f i ( pa ( V i ) , U i ) , where i = 1 , … , d V_{i}:=f_{i}\left(\operatorname{pa}\left(V_{i}\right), U_{i}\right), \quad \text { where } i=1, \ldots, d Vi:=fi(pa(Vi),Ui), where i=1,…,d

其中 p a ( V i ) {pa}(V_{i}) pa(Vi)是变量 V i V_{i} Vi在因果图 G ( C ) G(\mathfrak{C}) G(C)上的父节点

C \mathfrak{C} C上的干预 d o ( W ) , W ⊂ V d o(\mathbf{W}), \mathbf{W} \subset \mathbf{V} do(W),W⊂V定义为用新的非参数函数 g W g \mathbf{W} gW替换 W \mathbf{W} W,从而得到新的SCM即 C 2 : = C d o ( W = g W ) \mathfrak{C}_{2}:=\mathfrak{C}^{\mathbf{d} o\left(\mathbf{W}=g_{\mathbf{W}}\right)} C2:=Cdo(W=gW),干预的一个重要属性是局部性,即

p C 1 ( V i ∣ p a ( V i ) ) = p C 2 ( V i ∣ p a ( V i ) ) p^{\mathfrak{C}_{1}}\left(V_{i} \mid \mathrm{pa}\left(V_{i}\right)\right)=p^{\mathfrak{C}_{2}}\left(V_{i} \mid \mathrm{pa}\left(V_{i}\right)\right) pC1(Vi∣pa(Vi))=pC2(Vi∣pa(Vi))

GNN-SCM-NCM间的关系

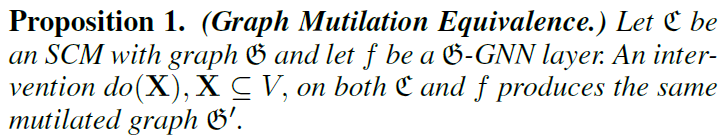

- GNN上的干预

干预 f ( D , A G ∣ d o ( X = x ) ) f\left(\mathbf{D}, \mathbf{A}_{G} \mid d o(\mathbf{X}=\mathbf{x})\right) f(D,AG∣do(X=x))定义为一组修改后的层计算方式

h i = ϕ ( d i , ⨁ j ∈ M i G ψ ( d i , d j ) ) \mathbf{h}_{i}=\phi\left(\mathbf{d}_{i}, \bigoplus_{j \in \mathcal{M}_{i}^{G}} \psi\left(\mathbf{d}_{i}, \mathbf{d}_{j}\right)\right) hi=ϕ(di,⨁j∈MiGψ(di,dj))

和原来图卷积的计算公式相比,这里的改动是对邻居进行了重新定义,其实就是去除了变量在因果图上的父节点

M i G = { j ∣ j ∈ N i G , j ∉ p a i ⟺ i ∈ X } \mathcal{M}_{i}^{G}=\left\{j \mid j \in \mathcal{N}_{i}^{G}, j \notin \mathrm{pa}_{i} \Longleftrightarrow i \in \mathbf{X}\right\} MiG={j∣j∈NiG,j∈/pai⟺i∈X}

如上图所示,对Y进行干预时,就要敲除其在因果图上的父节点的连接

- 任意结构方程都可以用GNN来描述

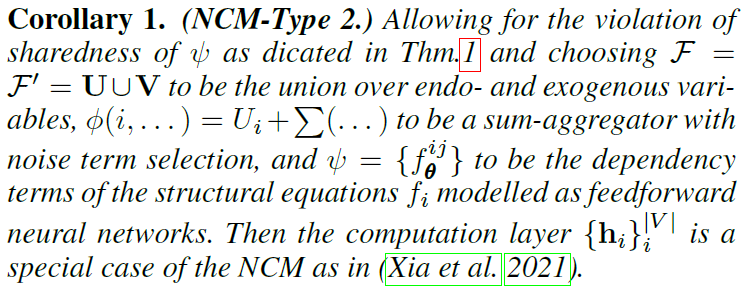

- 上述GNN可以看成是神经因果模型的一种特殊情况

下图是对上面定理的进一步解释,图(a)把结构方程分解成标量相关的方程,与图©相对应,揭示了GNN和SCM的等价性,图(b)显示了两种不同粒度的NCM

基于GNN的因果推理

- 根据SCM构建GNN

这个还是很直白的,就是直接用因果图作为图邻接矩阵。

- 再重复一下干预等价

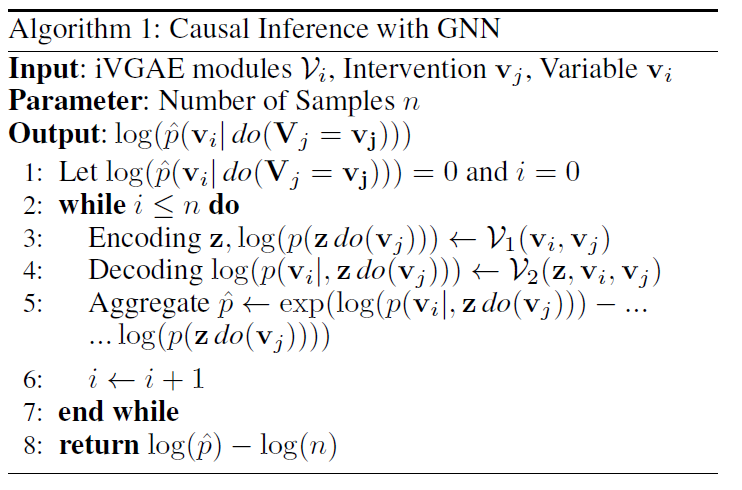

- 变分图自编码器可逼近任意密度分布,并对其进行干预操作

- 结合变分推断和VGAE做因果推理

实验

- 因果效应估计与识别

在模拟数据集上执行干预任务,发现因果效应

- 因果密度估计

该研究探讨了图神经网络(GNN)与结构因果模型(SCM)之间的理论关系,提出了基于GNN的神经因果模型类。利用变分推断,文章展示了如何在GNN中实施干预操作以进行因果推理。实验部分涉及因果效应估计与识别,验证了所提方法的有效性。

该研究探讨了图神经网络(GNN)与结构因果模型(SCM)之间的理论关系,提出了基于GNN的神经因果模型类。利用变分推断,文章展示了如何在GNN中实施干预操作以进行因果推理。实验部分涉及因果效应估计与识别,验证了所提方法的有效性。

9109

9109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?