![[图片]](https://img-blog.csdnimg.cn/895bba330f1946b99dd2f445ff430735.png)

0 Abstract

原本应用在Image领域的MAE可以简单地拓展到video任务做spatiotemporal表征。

- 在几乎没有对时空的归纳偏置的情况下(除了patch和positional embedding),MAE可以学习强表征;

- 时空无关(spacetime-agnostic)的随机掩码表现最好;

- 最优的masking ratio高达90%!这是由于video任务的高冗余特征,并且高ratio可以speedup;

- Masked autoencoding framework可以成为一种统一方法,用最少的领域知识进行表征学习;

- 达到了远高于supervised pre-training的性能。

1 Introduction

统一化模型解决不同领域的问题已经成为大趋势。对于一个新的任务,统一化模型将引入更少的领域知识(即更少的归纳偏置),迫使模型从几乎只从数据中学习有用的知识。

-

少归纳偏置,让模型learned from data:

-

video任务的高冗余性,带来高masking ratio:

-

高效率,高精度

- Reduces encoder time and memory complexity to <1/10;

- Achieve a theoretically 7.7× reduction in computation vs. encoding all tokens;

- 4.1× wall-clock speedup;

- Pre-training MAE increases the accuracy of ViT-Large by absolute 13% vs. training from scratch;

2 Related Work

2.1 Denoising autoencoders (DAE)

DAE是一类统一方法:从被损毁的input中重建signals。

- 成功的Transformer统一方法:

- BERT:using language tokens;

- iGPT:using pixels as tokens;

- ViT:using patch as tokens。

- 重建方法:

-

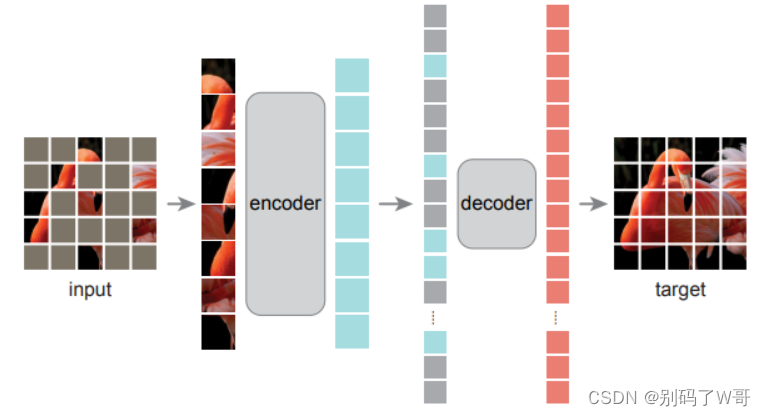

MAE(2021):patch as the reconstruction target;

-

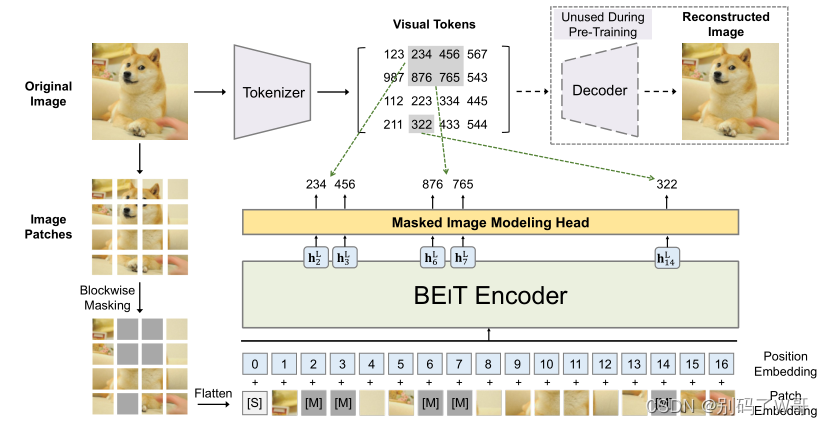

BEiT(2022):pre-trained dVAE (visual tokens) as the reconstruction target;

-

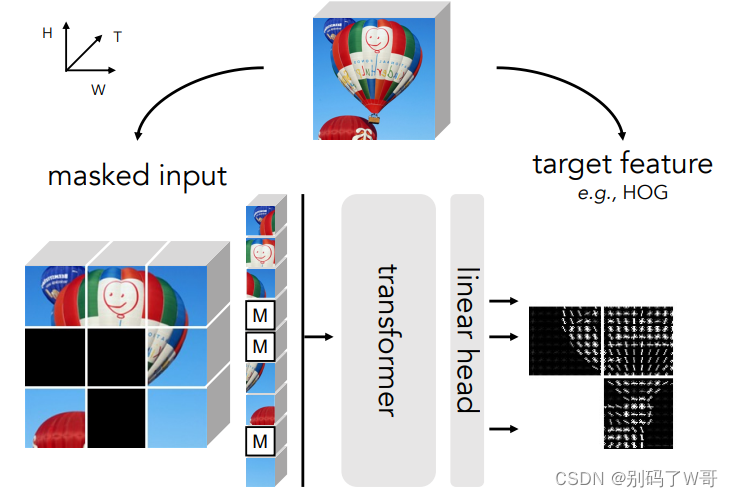

MaskFeat(2023):HoG (方向梯度直方图) as the reconstruction target;

-

2.2 Self-supervised learning on videos

时间维度是视频数据自监督督学习的重点:temporal coherence,future prediction,object motion,temporal ordering,spatiotemporal contrast。

本文方法隐式地实现了temporal coherence(本文方法的时空无关性),主要是使用高masking ratio(假设video有较多的冗余信息)。相比其他方法,本文更简单(重建像素),需要更少的领域知识,且更省计算。

3 Method

3.1 Patch embedding

对图像在时空维度上分割为不重叠的patch并打平,经过linear projection,再加入position embedding。此处强调,patch和pos embeding是唯一具有时空相关性的过程(只需要很少的归纳偏置)。

3.2 Masking

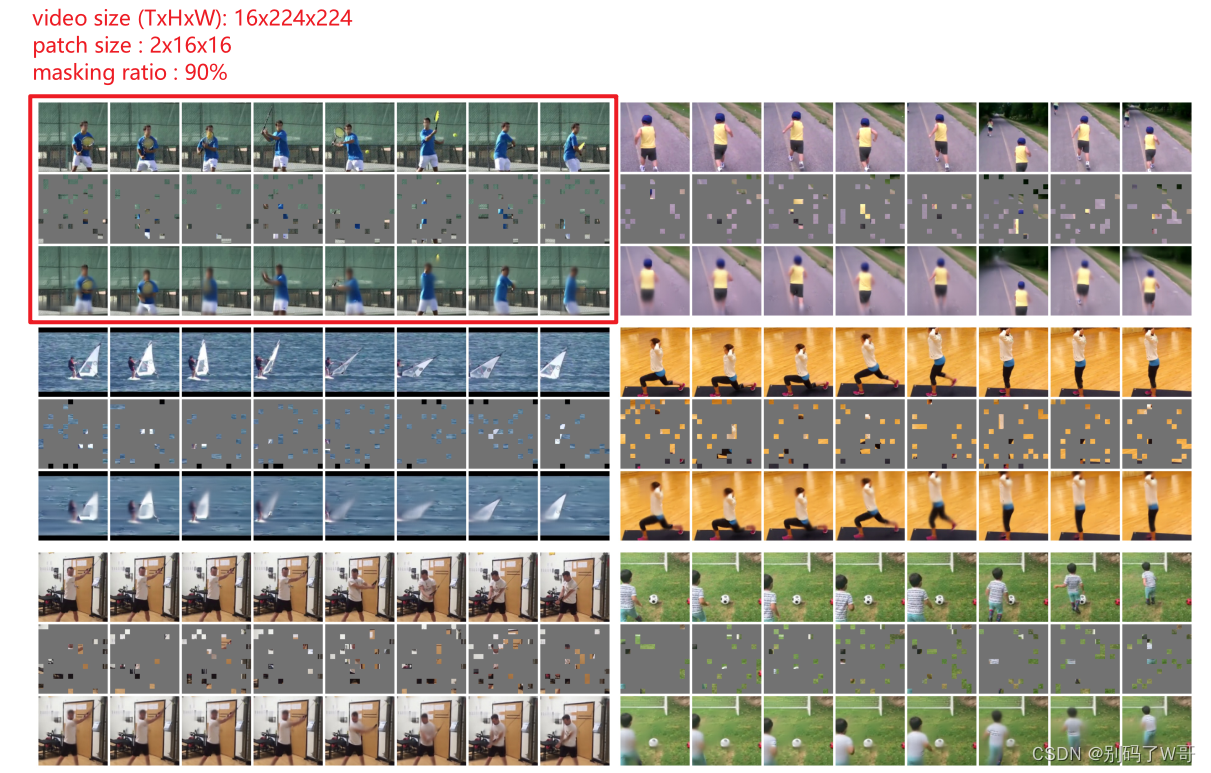

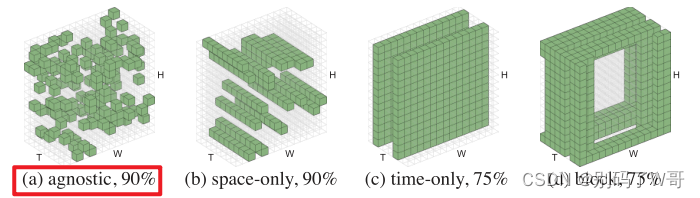

采用随机的spacetime-agnostic sampling,相比其他方式将更为高效,并且90%最佳:

3.3 Autoencoding

- Encoder:vaniila ViT;

- Decoder:更小的vaniila ViT,因为decoder需要处理的token的复杂度小于encode(约1/20);

- Patch prediction:原则上可以简单地预测一个完整的时空patch(t×16×16),但在实践中发现预测patch的单个时间片(16×16)就足够了,这使预测层的大小保持可控;

- Training loss:MSE,在unknown patches上取平均值。

4 Implementation

- Data pre-processing:16帧(224*224,步长为4的随机抽帧),并且经过random resized cropping和random horizontal flipping的数据增强。

- Bottleneck:由于MAE计算极快,数据加载成为新的瓶颈。为此使用repeated sampling:每次加载和解压缩原始视频时,都会从中获取多个(默认为4)样本,这减少了每个样本的数据加载和解压缩时间;

- Architecture:ViT,positional embedding包括空间embedding和时间embedding,并且进行可分离实现(防止embedding的大小在三维空间中变得过大);

5 Experiments

5.1 Performance

- 数据集:Kinetics-400 (K400),采集自油管视频,包含400个人类动作类,每个动作至少400段视频。

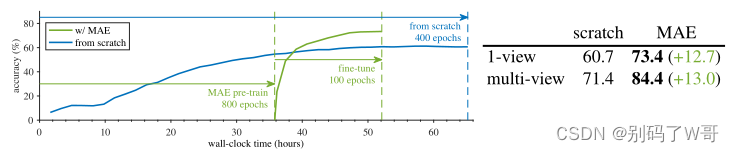

- 通过MAE预训练ViT,相比trainig from scratch在性能与速度上都有较大提升:

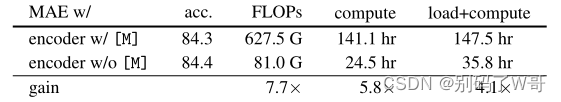

- MAE的预训练非常快是因为encoder只应用于稀疏空间,即不需要加入mask token [M]:

5.2 Ablation experiments

-

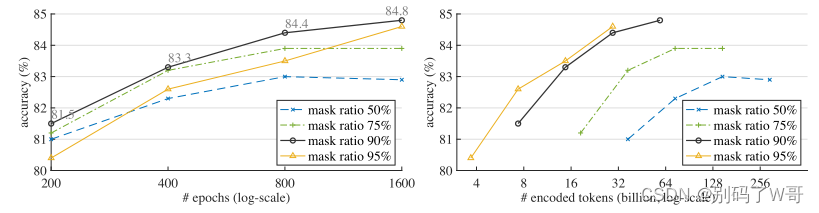

90%的masking ratio表现最好,如果训练够长,95%表现也可圈可点:

-

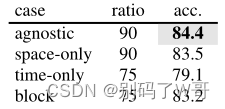

时空无关的随机采样mask表现最好:

-

以经过per-patch normalized的pixel作为重建目标表现最好:

![[图片]](https://img-blog.csdnimg.cn/549158e9da7a4603b1b9b552b1c8a150.png)

-

在[0.5, 1]的范围内进行random cropping的表现最好:

![[图片]](https://img-blog.csdnimg.cn/6f009bb44e3144678bf9096f4e116d5e.png)

-

采用4倍的Repeated sampling策略表现最好:

![[图片]](https://img-blog.csdnimg.cn/91fa267ff7b546cc82575825682d4734.png)

-

Decoder的容量在512 hidden dim以及4 block时表现最好:

![[图片]](https://img-blog.csdnimg.cn/9680bcc93d91494f8298c3287fdbf843.png)

5.3 Influence of Data

-

Transfer learning ablation

![[图片]](https://img-blog.csdnimg.cn/e958e38a0f3d46a8b94d32ea8bd3737f.png)

-

Real-world data

![[图片]](https://img-blog.csdnimg.cn/086cea446b3945fba50d2037c0ea8a68.png)

6 Conclusion

- 用最少的领域知识(归纳偏置)学习强表征是可能的,并证明了视频上的自监督学习可以在一个概念统一的框架中解决;

- masking ratio是一个重要的因素,其最佳值可能取决于数据的特征;

- 在真实世界的未经策划的数据上(例如直接采用ins上的视频)进行预训练能达到很好的效果;

- 本文所探索的数据规模比语言对应的数据要小几个数量级,高维视频数据仍然是主要的挑战。本文的研究能为未来的研究提供初步的指引。

155

155

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?