原文参考http://blog.csdn.net/ariessurfer/article/details/41310525

Logistic回归为概率型非线性回归模型,是研究二分类观察结果与一些影响因素之间关系的一种多变量分析方法。通常的问题是,研究某些因素条件下某个结果是否发生,比如医学中根据病人的一些症状来判断它是否患有某种病。

在讲解Logistic回归理论之前,我们先从LR分类器说起。LR分类器,即Logistic Regression Classifier。在分类情形下,经过学习后的LR分类器是一组权值

这里

解出x之后,按照sigmoid函数的形式求出

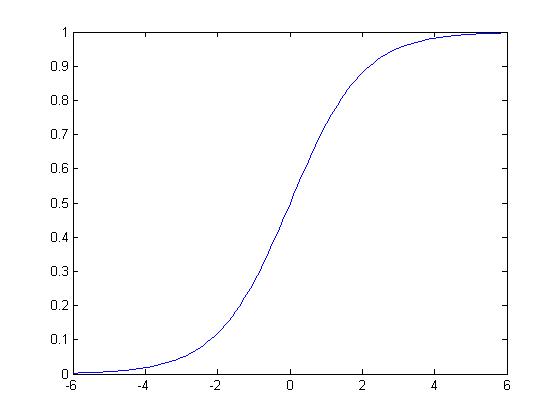

sigmoid函数的图像如图所示

sigmoid函数的定义域为

Logistic回归原理浅谈

最新推荐文章于 2023-03-22 21:18:35 发布

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1626

1626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?