一、前言

上次发的 Midjourney 教程《奶奶看了都会的 Midjourney 入门教程!!》文章受到了很多朋友们的认可和支持,大家讨论很热烈,其中有不少疑问就是 Midjourney 的图片怎么精准的控制,或者是不改变某个物体的情况下更换背景等等,实在是太多问题了。

不过确实,Midjourney 生成的图片很难精准的控制,随机性很高,需要大量的跑图,不过没关系,在社群小伙伴们的强烈建议下,我在这篇文章中为大家分享 SD 的教程。

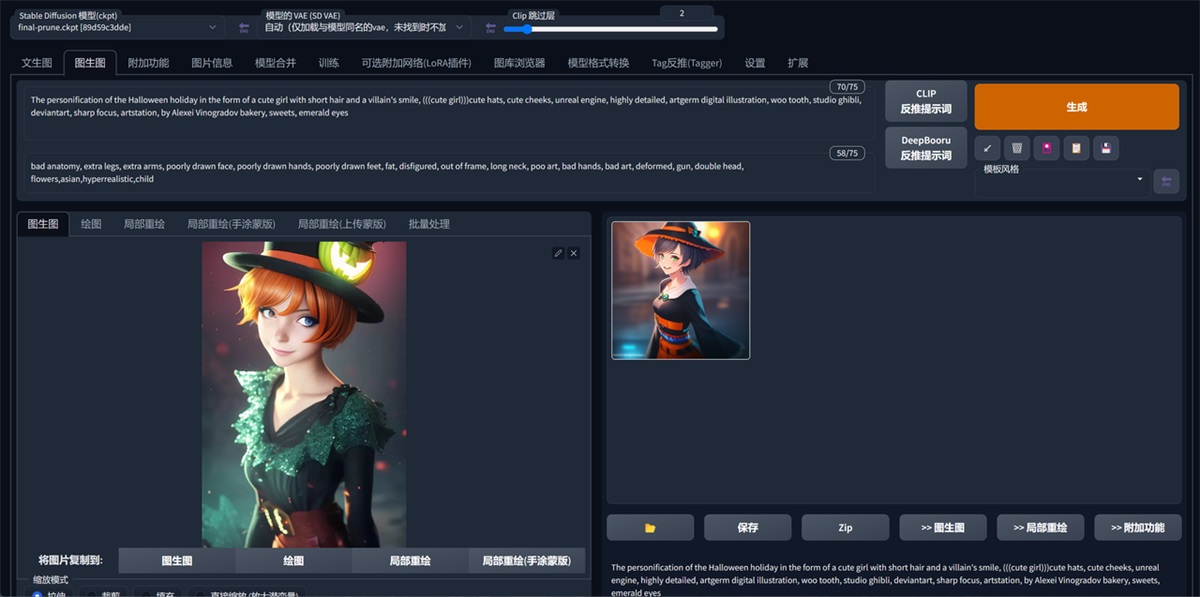

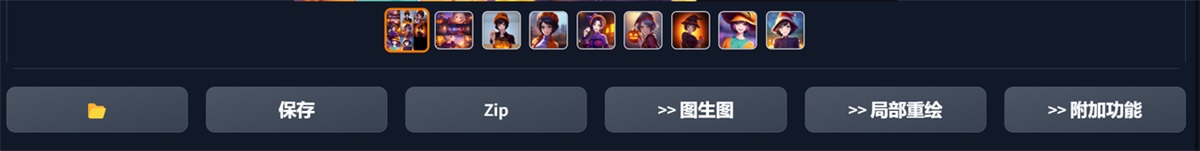

SD 效果图展示:

动漫插画,就说这效果强不强吧…

是不是迫不及待想试一试了呢,那我们开始吧,手把手教学,外婆真的看了都会的教程,开始进入教学!!

二、Stable Diffusion 介绍

Stable Diffusion 是一款基于人工智能技术开发的绘画软件,它可以帮助艺术家和设计师快速创建高品质的数字艺术作品。该软件使用了一种称为 GAN(生成对抗网络)的深度学习模型,该模型可以学习并模仿艺术家的创作风格,从而生成类似的艺术作品。

Stable Diffusion 具有直观的用户界面,可以让用户轻松地调整绘画参数并实时预览结果。用户可以选择不同的画布、画笔和颜色,还可以通过调整图像的风格、纹理和颜色等参数来创建各种不同的艺术作品。

除此之外,Stable Diffusion 还提供了一些高级功能,例如批量处理、自动矫正和自动化调整等,可以帮助用户更加高效地完成大量的绘画任务。

总之,Stable Diffusion 是一款功能强大的 AI 绘画软件,它比现在市面上主流的 AI 绘画软件 Midjourney 更加的强大,可以说 SD 是所有 AI 绘画的鼻祖级存在,同样,更强大代表着它的上手难度及配置要求也更高。那么说到这里,我们就来看看这两款软件的一个对比吧

三、主流 AI 绘画软件的对比

四、Stable Diffusion 电脑配置要求

1. 配置要求:

需要使用 N 卡(NVIDIA 显卡),显卡的显存至少需要 4GB 以上显存才能在本地运行。最低配置需要 4GB 显存,基本配置 6GB 显存,推荐配置 12GB 显存或者以上。

Stable Diffusion Ai 绘画主要是运行显卡,算力越强,出图越快。显存越大,所设置图片的分辨率越高)

“推荐使用 RTX4090 显卡哦” -----来自一个 3080 显卡玩家

还有一点的就是硬盘空间要大,SD 出图主要依赖模型,网上下载的模型资源一般都很大(一个模型在 2G 以上)批量跑图也是很占内存的,这边建议 60GB 以上的硬盘空间。

**2. 网络要求:**大家都懂哈,咱也不说。

**3. 操作系统:**需要是 Win10 或 Win11。

满足以上条件基本上就可以用 SD 跑图啦。

五、Stable Diffusion 安装

SD 的安装我们就不要整的很复杂了,直接用大佬制作的一键安装/启动包就行,我们把时间用在刀刃上。

自己手动安装需要上 Github 下载文件,还要下载 Ptthon 等工具,一般第一次手动安装会出现各种奇怪的报错,总之很复杂,我之前自己安装过,真就花了一上午都还没安装好。所以我不建议也不教大家手动安装了。(如果你要硬上,可以在网上看看别的使用教程)

上黑科技!!!咱直接去使用@秋葉 aaaki 大佬的免费启动器和安装包。

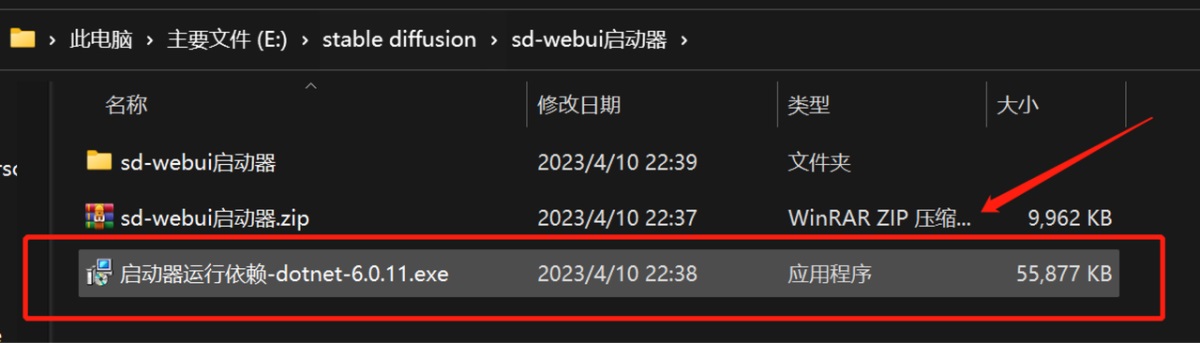

我们下载这两个文件,下载链接在这篇文章顶部:

Stable Diffusion自学必看!6款适合小白的零基础免费入门教程

大家好,这里是和你们一起探索 AI 绘画的花生~ 最近优设为大家推荐了不少有关 Midjourney 的教程和资源,不知道大家有没有用起来?

阅读文章 >

注意:下载的文件一定要放在空间比较大的盘里。

来看下具体操作:

- 安装一下这个“启动器运行依赖”。

- 然后把这两个文件复制一下,我们需要粘贴到“webui:文件夹中

- 粘贴替换目标中的文件。粘贴的位置看我的文件夹路径。

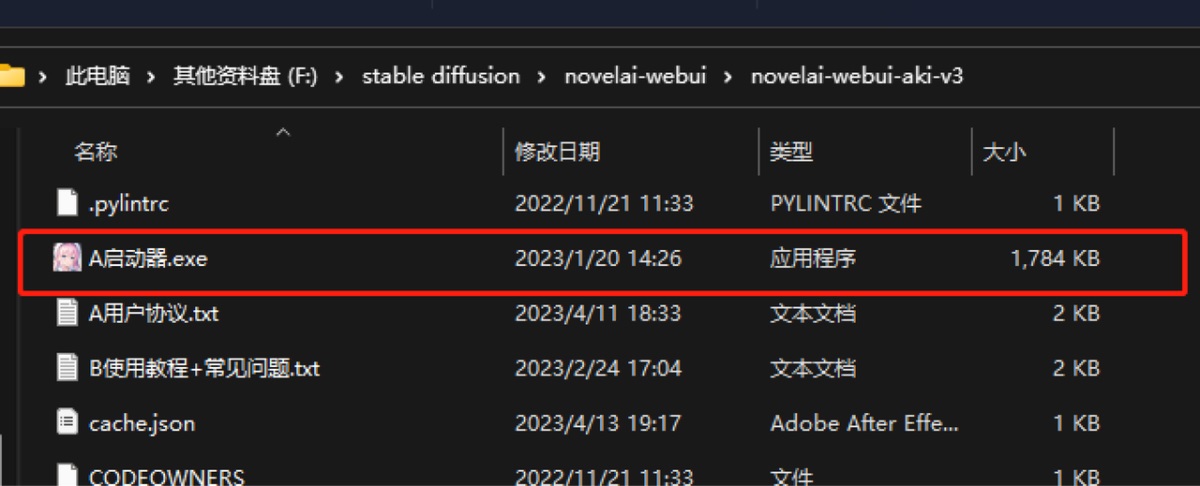

- 这里我重新走一遍打开流程,以防大家退出去了不知道从哪里进。我们打开下载的文件夹,然后进入到“novelai-webui”文件夹

- 打开“novelai-webui-aki-v3”文件夹。

- 然后下拉下拉…找到这个启动器,双击就完事了,这个就是我们刚刚粘贴替换的文件。

- 然后就打开啦,一键启动就好了。

六、Stable Diffusion 基础操作

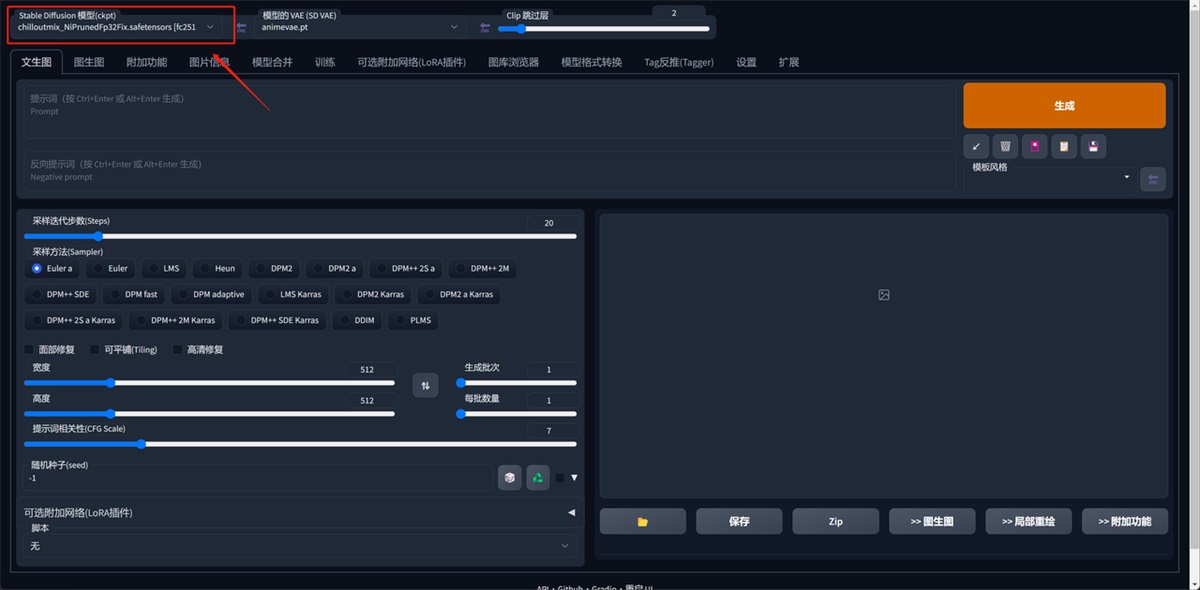

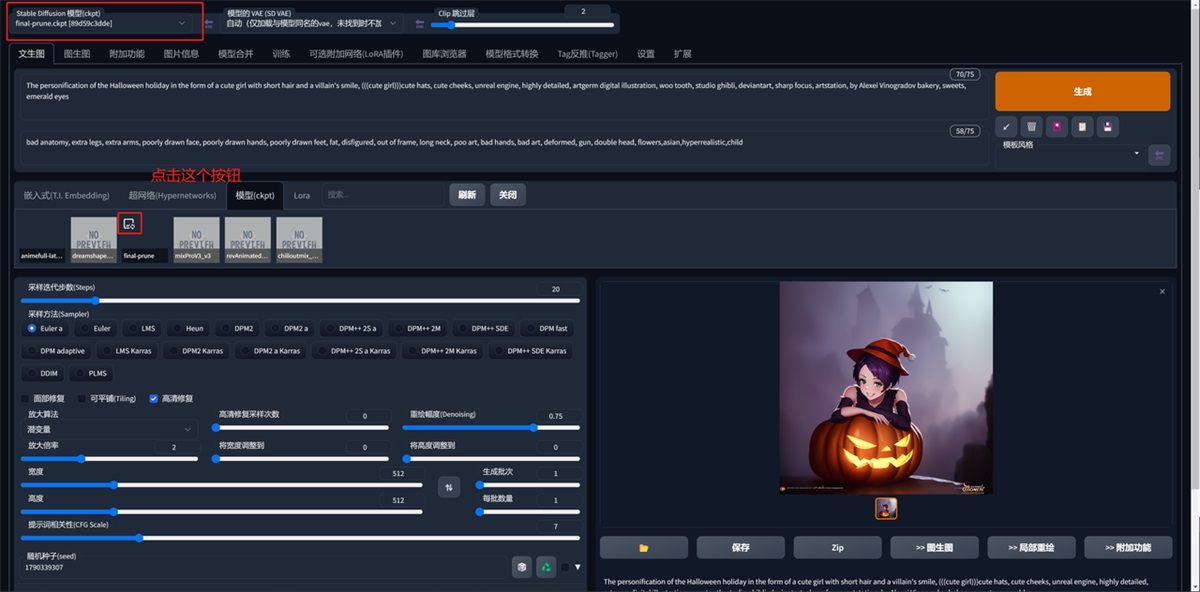

1. 大模型的切换

首先是这个界面左上角,在这里可以切换你所安装的模型。

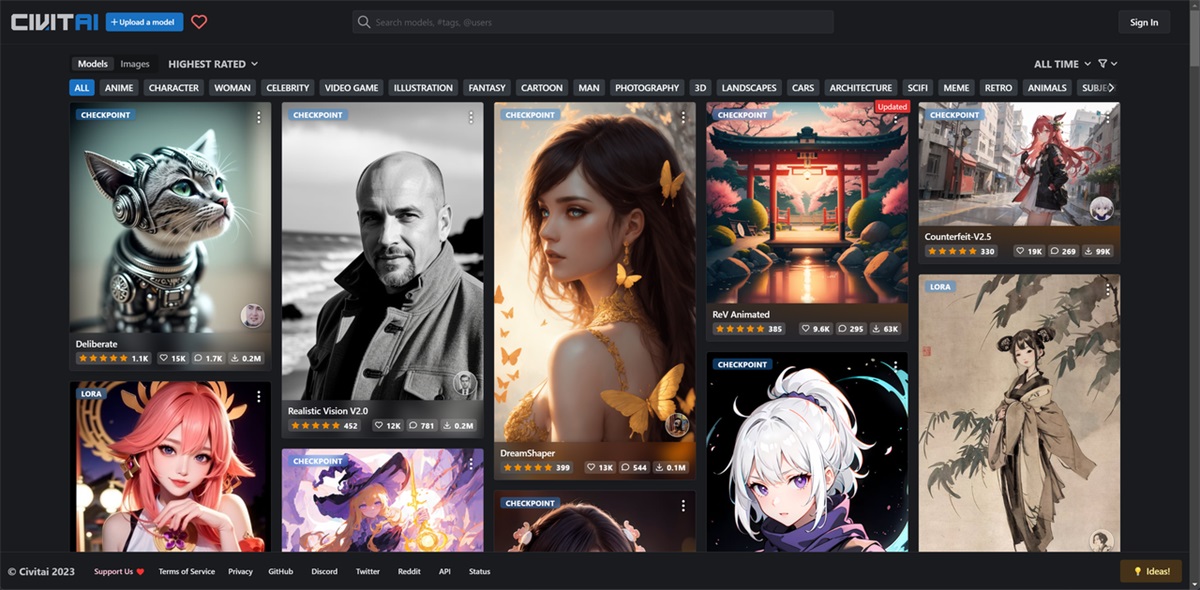

这里我先推荐一下我常用的模型网站:C 站: https://civitai.com/

然后我们在 C 站上下载一些模型:

接下来就是安装了,很简单,把下载的模型放到这个路径文件夹中。然后刷新 web UI 界面(就是 SD 操作界面)

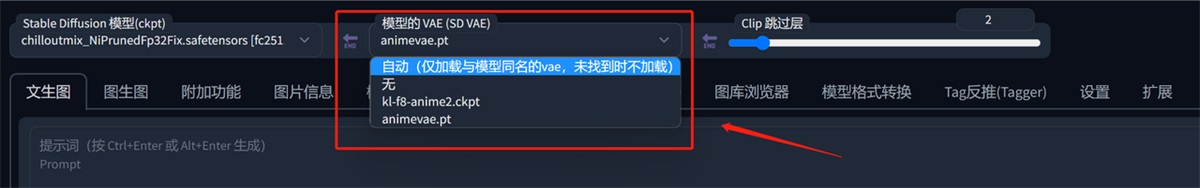

2. 模型的 VAE(Sd 的 VAE)

VAE 的全称是 Variational Auto-Encoder,翻译过来是变分自动编码器,本质上是一种训练模型,Stable Diffusion 里的 VAE 主要是模型作者将训练好的模型“解压”的解码工具。

这里可以切换 VAE。一般情况下我们就选择第一个自动就行了。

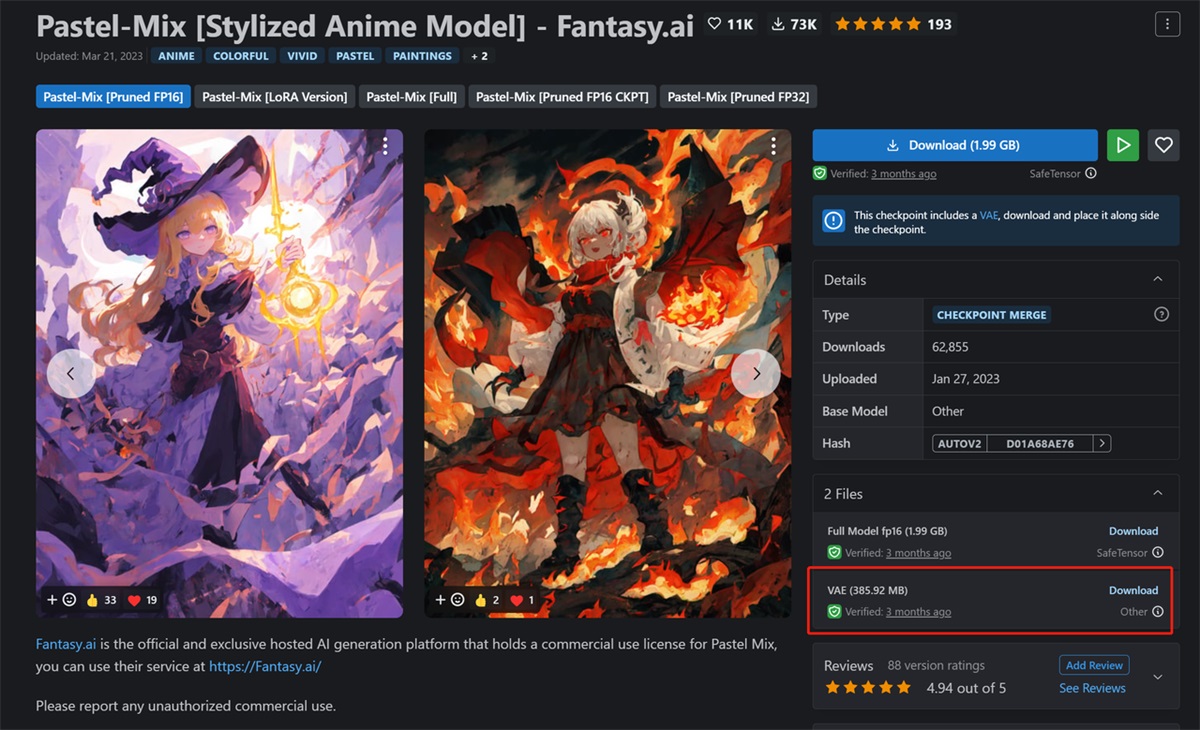

在 C 站下载模型,在下载页面会有文件显示,如图。

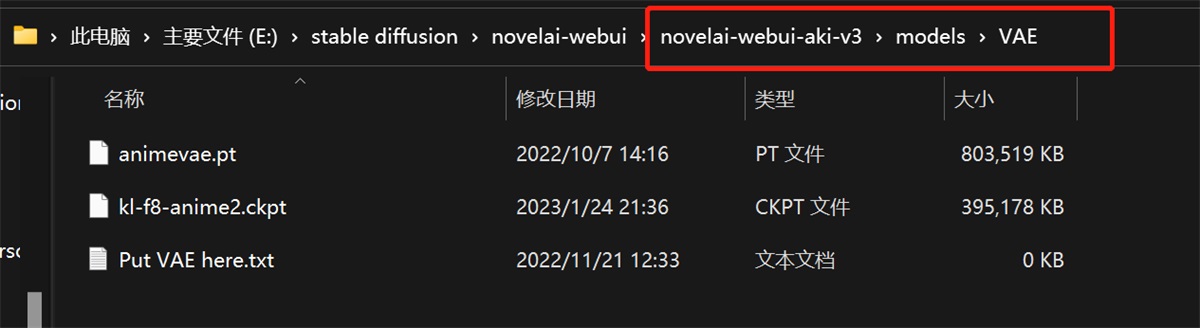

VAE 的安装路径看我这里,把下载的文件复制粘贴,然后把 web UI 界面刷新一下(就是 SD 操作界面)

言川总结:

- 总的来说就是你在 C 站上下载的模型有些内置就有 VAE 的属性(不需要下载 VAE 文件),有些没有内置下载的时候我们就把 VAE 文件下载。(VAE 文件一般大小在几百兆左右)

- VAE 的作用就是没有加载 VAE 的图片是灰灰的,加载之后就是会产生一个润色的效果,色彩更加丰富。

3. 功能选项

这里我挑选几个重要的功能讲解下。

文生图,这里与 Midjourney 不同的是,SD 有一个反向关键词(意思是不要图片出现什么),文生图的关键词格式与 Midjourney 基本一致,不知道的朋友可以去看我的往期文章:

两万字干货!可能是全网最详细的Midjourney基础教程

进阶篇: 一、前言篇 1. AI 绘图是什么?

阅读文章 >

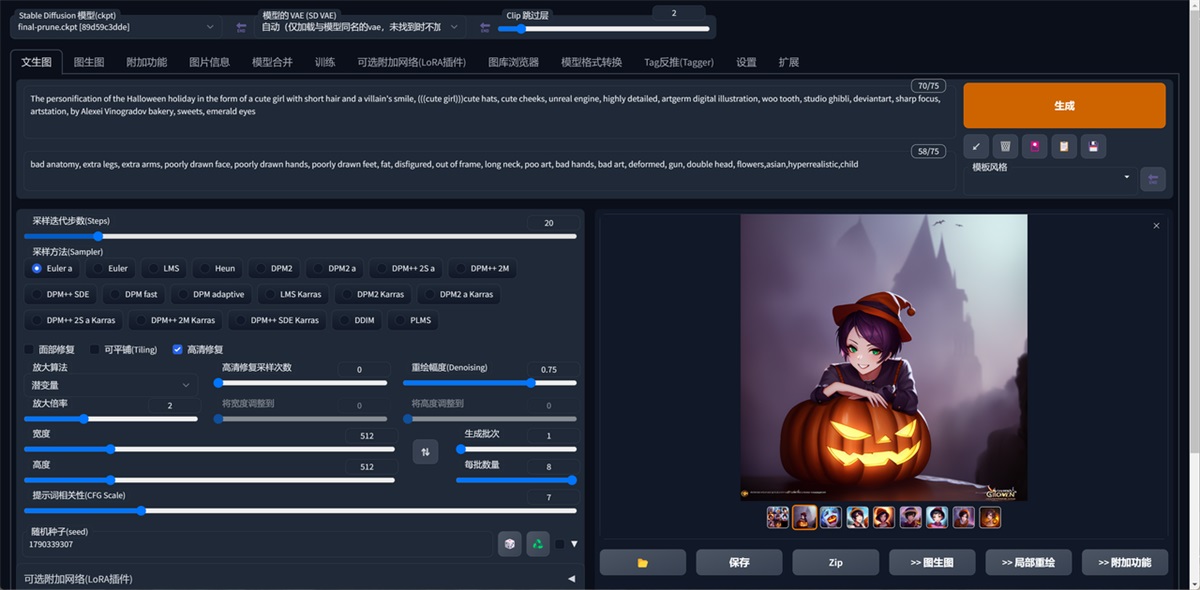

下面这块参数就是设置图片的一些基本参数,分辨率、尺寸等等,具体参数见下文。

图生图,这个也很好理解,放参考图然后输入提示词,与其他 AI 绘画软件一致。

图片信息,意思是你用 SD 画的图,放在这里来,右边会显示这个图片的一些参数,包括关键词。

然后你可以选择右下角的一些功能,比如“文生图”。

模型合并,这个功能很厉害,后面我出一篇关于这个功能的教学,大致就是把多个模型混合起来。

训练,这个就是训练自己的模型,新手用的比较少,后面可用作工作流的部署。(这个才是我推荐的核心哦)

设置,然后就是设置,大家自己去研究下就好了。

扩展,这个就是跟插件扩展相关的了,后面再讲。

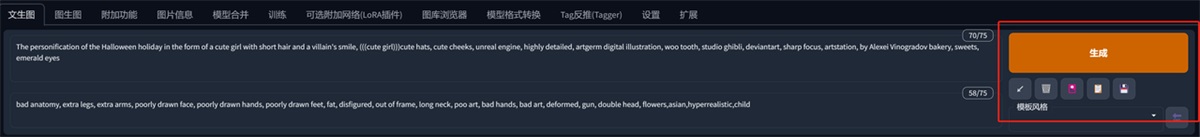

4. 提示词和反向提示词

言川提示:

提示词内输入的东西就是你想要画的东西,反向提示词内输入的就是你不想要画的东西。

提示框内只能输入英文,所有符号都要使用英文半角,词语之间使用半角逗号隔开。

一般来说越靠前的词汇权重就会越高,比如我这张图的提示词:

The personification of the Halloween holiday in the form of a cute girl with short hair and a villain’s smile, (((cute girl)))cute hats, cute cheeks, unreal engine, highly detailed, artgerm digital illustration, woo tooth, studio ghibli, deviantart, sharp focus, artstation, by Alexei Vinogradov bakery, sweets, emerald eyes。

万圣节假期的拟人化形式是一个留着短发和恶棍笑容的可爱女孩,可爱的帽子,可爱的脸颊,虚幻的引擎,高度详细,艺术种子数字插图,woo tooth,吉卜力工作室,deviantart,锐利的焦点,artstation,由 Alexei Vinogradov 面包店,糖果,绿宝石般的眼睛。

第一句关键词词组:万圣节假期的拟人化形式是一个留着短发和恶棍笑容的可爱女孩。那生成的图片主体画面就会是万圣节短发可爱笑容女孩

这里可能有用过 Midjourney 的小伙伴们就有疑问了,(((cute girl)))是什么意思,为啥有这么多括号,我来为大家解答下,这个是权重调节,类似 Midjourney 的 ::

① 最直接的权重调节就是调整词语顺序,越靠前权重越大,越靠后权重越低,上面说过。

② 可以通过下面的语法来对关键词设置权重,一般权重设置在 0.5~2 之间,可以通过选中词汇,按 ctrl+↑↓来快速调节权重,每次调节为0.1,也可以直接输入。

③ 加英文输入的(),一个括号代表这组关键词的权重是 1.1,两个括号是 1.1*1.1 的权重,不要加太多了哈。可以结合第二点固定权重,比如(((cute girl:1.2))),那这个关键词的权重就很高了。

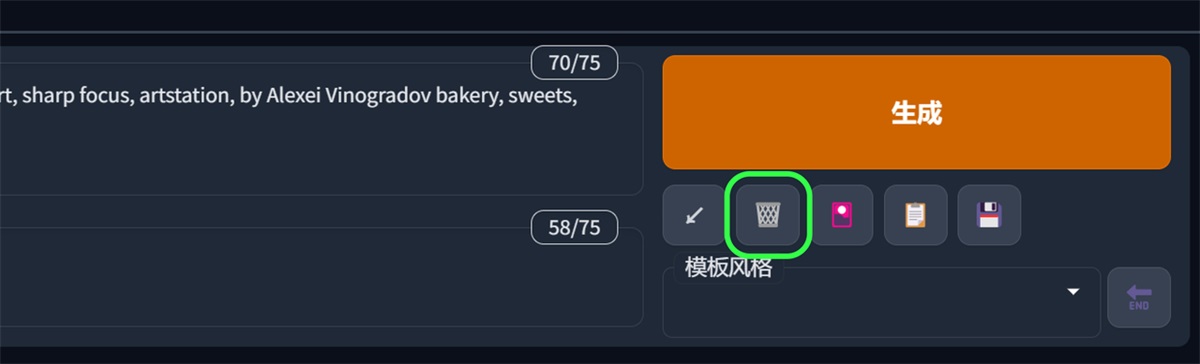

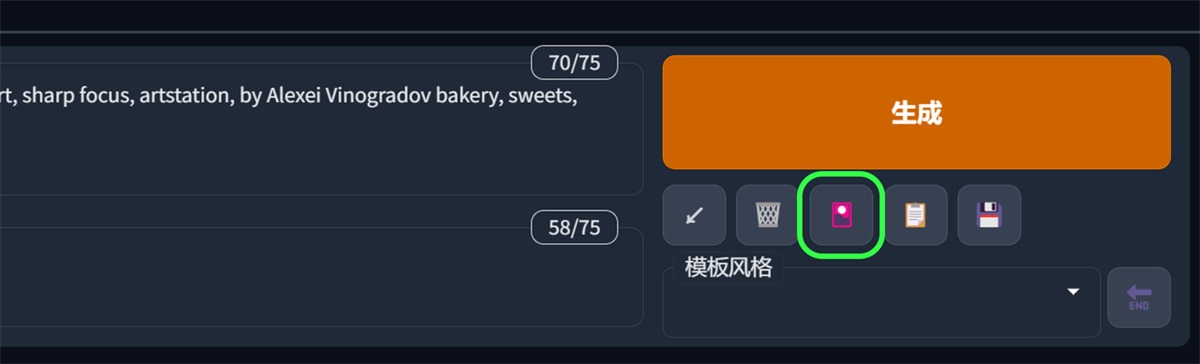

5. 功能按钮

我们来介绍下右边这几个功能,生成就不说了,输入关键词生成就跑图了。

第一按钮的意思是读取你上一张图的所有参数信息(包括关键词),比如你画一张图之后,关掉了软件,再次启动点击这个就会把参数复制进来。

第二个按钮就是删除了,清空关键词;这里可以和第一个按钮结合用哦

第三个按钮就是模型选择管理

这个按钮就是点击就会出现这些功能,你安装的模型和 Lora 都可以在这边调整。

言川小知识:这里可以把你生成的图片添加到模型的封面上,方便你后面看这个模型的效果,看我怎么做:

找到这个模型的名称,然后我这里是跑出来一张图片的,点击这个按钮(lora 一样)

最终效果:

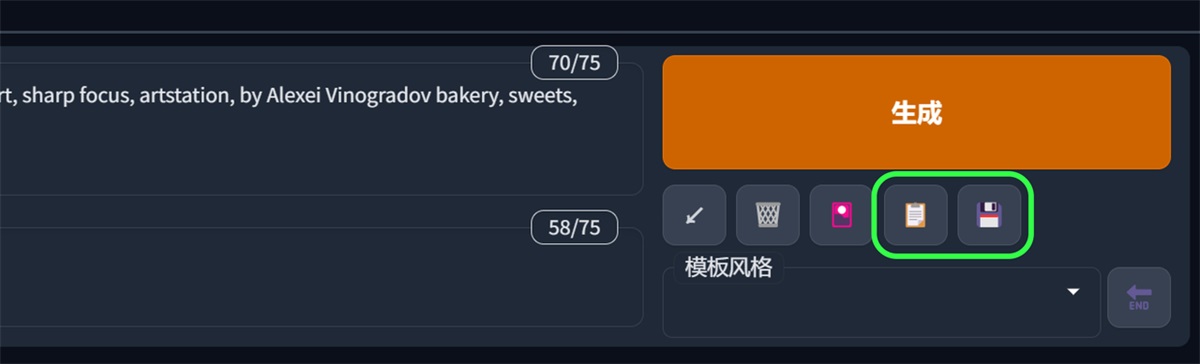

后面两个就是一个提示词模板功能:

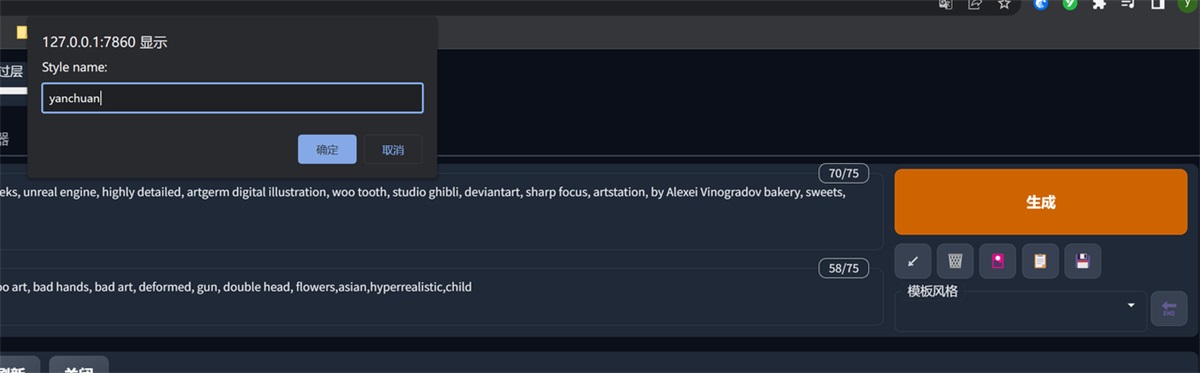

我们可以先点最后一个按钮,把现在的关键词创建一下,取个名字

然后在模板风格这里选中我们刚刚创建的模板(可以多选)

选中之后按一下第四个按钮,我们创建的关键词就被填入进去了,这块收工!

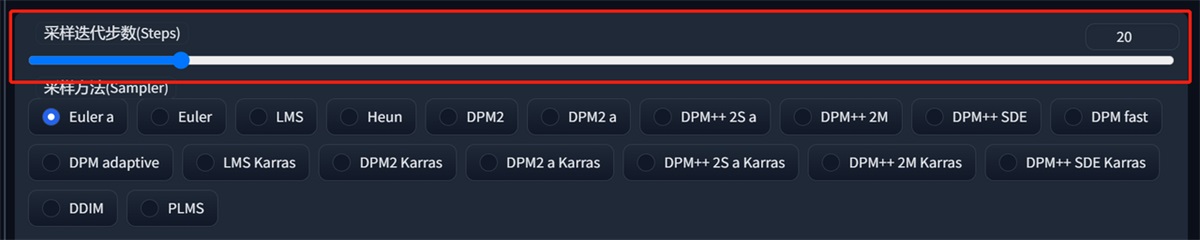

6. 采样步数

一般来说大部分时候采样部署只需要保持在 20~30 之间即可,更低的采样部署可能会导致图片没有计算完全,更高的采样步数的细节收益也并不高,只有非常微弱的证据表明高步数可以小概率修复肢体错误,所以只有想要出一张穷尽细节可能的图的时候才会使用更高的步数。(加大这个会导致出图变慢)

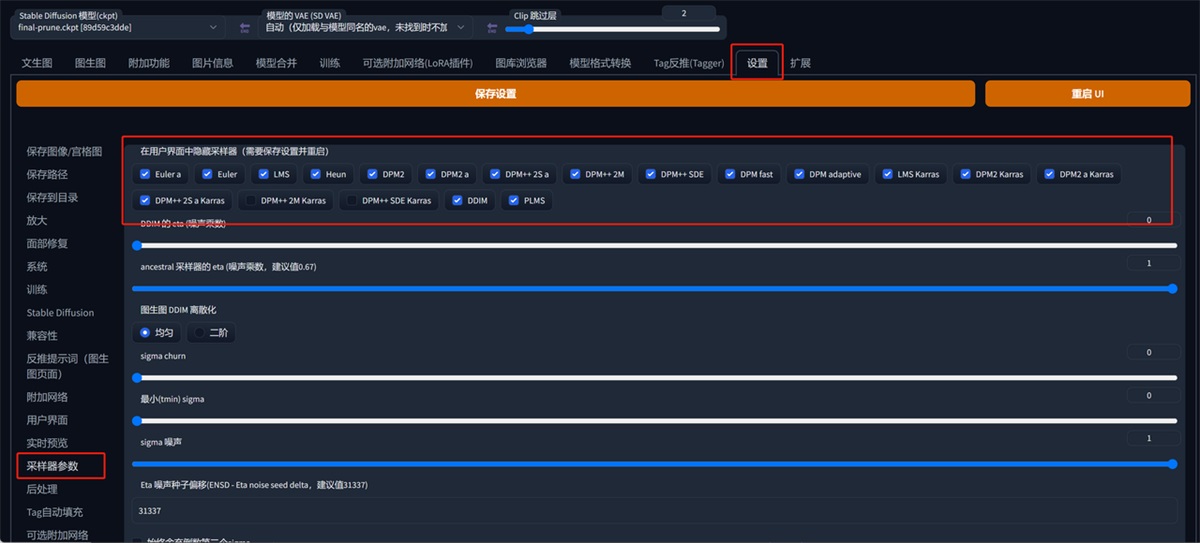

7. 采样方法

Stable diffusion webui 是 Stable diffusion 的 GUI 是将 stable diffusion 实现可视化的图像用户操作界面,它本身还集成了很多其它有用的扩展脚本。

SD 的采样方法有很多,大家有兴趣了解的可以去知乎看看@刘登宇的一篇文章《stable diffusion webui 如何工作以及采样方法的对比》。这里我们只介绍两个种常用的。

这里的采用方式有很多,但是我们常用的就那几个,我们可以去设置里面把不需要用到的关掉,不展示在这个界面中。然后点击右边的重启 UI 就好了。

8. 高清修复和图片尺寸参数

前面两个做个简单的介绍,面部修复对写实的风格有点效果,可平铺就不要用了,生成的图片很奇怪,可以自己试试。

我们说说高清修复,高清修复的意思是把基础生成的图片,按照你选择放大的倍率放大到指定分辨率之后再重新绘制图片,受到你重复幅度调节的数值影响。

宽度、高度就是图片的长宽比,很容易理解,生成批次和数量就是几批,一批几张图,配置好的可以直接拉满,增加效率哦。

提示词相关性:图像与你的提示的匹配程度。增加这个值将导致图像更接近你的提示(根据模型),但它也在一定程度上降低了图像质量。可以用更多的采样步骤来抵消。

默认未选中高清修复是这样的,当前图片的参数。

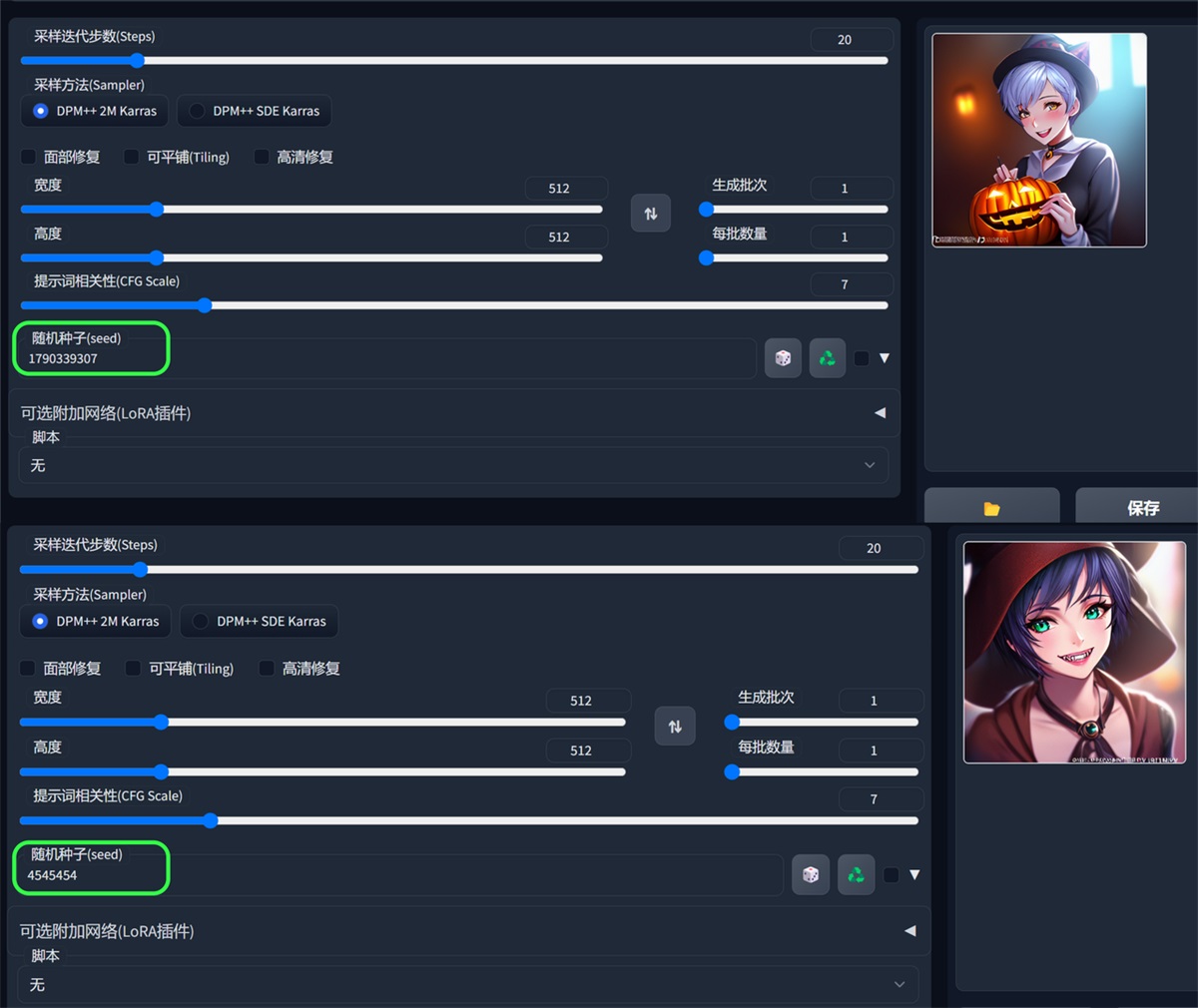

9. 随机种子(seed)

这个功能与 Midjourney 的 Seed 功能一样。

随机数的起点。保持这个值不变,可以多次生成相同(或几乎相同,如果启用了 xformers)的图像。没有什么种子天生就比其他的好,但如果你只是稍微改变你的输入参数,以前产生好结果的种子很可能仍然会产生好结果。

输入不同的种子,生成的图片不一样,seed 值一样,那生成的图片也是一样。

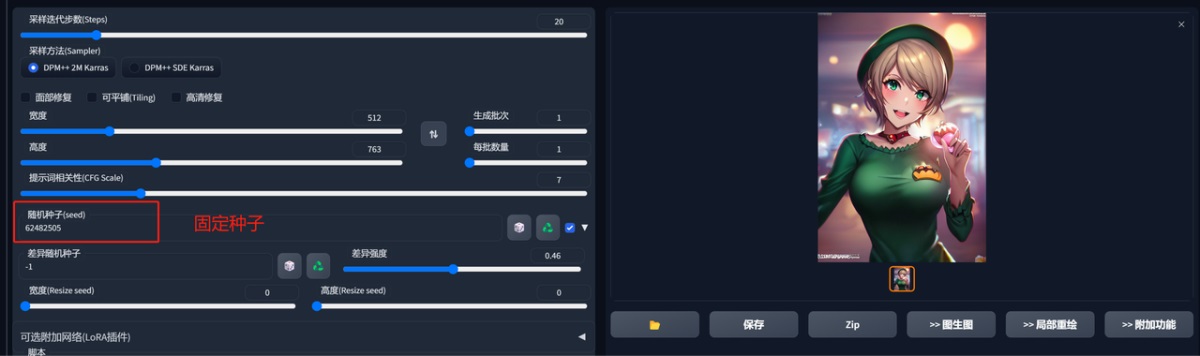

差异随机种子,需要勾选这个按钮:

这个功能是固定一个种子,然后调整差异强度来生成图片,因为是固定的 seed 值,所以生成的图风格都是类似的。

直接看图吧。

这边的几个功能都很简单,大家尝试下就能理解了,那基础操作我们就先讲到这里,大家赶紧玩起来吧!!

七、结语

这篇入门教学就先讲到这里,后续还有插件、部署模型等教程,大家先消化一下这篇文章的内容。

如果觉得对你有帮助,3 连(点赞、收藏、分享)一下吧,大家的支持才是我的动力,祝大家生活愉快

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍代码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入门stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

479

479

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?